초음파센서를 이용한 UKF 기반 로봇의 실내 위치 평가 방법

Copyright © The Korean Society for Precision Engineering

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License (http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

Abstract

This paper proposes a UKF-Based indoor localization method that evaluates the optimal position of a robot by fusing the position information from encoders and the distance information of the obstacle measured by ultrasonic sensors. UKF is a method of evaluating the robot’s position by transforming optimal sigma points extracted using the unscented transform and is advantageous for the localization of a nonlinear system. To solve the problem of the specular reflection effect of ultrasonic sensors, we propose a validation gate that evaluates the reliability of the ranges measured by sonar sensors, that can maximize the quality of the position evaluation. The experimental results showed that the method is stable and convergence of the position error regardless of the size of the initial position error and the length of the sampling time.

Keywords:

Indoor localization, Mobile robot, Unscented kalman filter, Sonar sensor, Validation gate키워드:

실내 위치 평가, 이동로봇, 분산점 칼만 필터, 초음파센서, 유효성 게이트1. 서론

최근 지능로봇이 실생활에 많이 적용되면서 지능로봇 기술에 많은 관심이 증가하고 있다. 지능로봇은 실내 공간에서 주로 이용되는 청소로봇에서부터 최근 중요 이슈 중 하나인 자율주행 자동차까지 다양한 분야에서 이용된다. 이와 같은 지능로봇은 자신의 임무를 수행하기 위하여 주변 환경을 인식하고, 자신의 현재 위치를 평가하여 목표 위치로 이동하는 경로를 계획하는데, 이 과정에서 가장 중요한 것이 위치 평가(Localization)이다.1,2

로봇의 위치 평가는 크게 실내 위치 평가와 실외 위치 평가로 구분된다. 실외 위치 평가는 실내 위치 평가와 달리 주변 환경에 대한 정보를 사전에 제공하기 어려우며, 자유 공간과 장애물의 구별이 뚜렷하지 않아 주변 환경을 이용한 위치 평가에는 부적합하다. 따라서 실외 위치 평가는 주로 GPS로부터 위치를 수신 받아 로봇의 위치를 평가하는데 날씨, 위성 궤도 및 시계 오차의 영향을 많이 받는다.3-6 반면 실내 위치 평가는 날씨 등 주변 환경적 요인의 영향은 받지 않으며, 작업 공간에 대한 환경 정보를 미리 제공할 수 있으므로 이를 이용하여 보다 정밀한 위치 평가가 가능하다.

실내 위치 평가는 적외선, 초음파센서 등 거리를 인식하는 센서, 물체의 형상 인식에 유리한 비전센서 등과 같이 다양한 센서들을 사용한다. 적외선센서는 빛에 예민하게 반응하고, 주변 온도에 영향을 많이 받는다는 단점이 있다.7 비전센서는 이미지를 받아 거리를 계산하는데, 주변 조도의 영향을 많이 받는다.8,9

초음파센서는 물체의 거리 정보 획득이 간단하고 빠르기 때문에 실내 로봇에 많이 이용되는데, 음파가 송신된 후에 물체에 반사되어 돌아오는 음파를 수신하여 물체까지의 거리를 계산한다. 그러나 초음파는 360o 전 방향으로 전달되므로 방향 불확실성이 클뿐만 아니라 거울 효과(Specular Reflection Effect)라는 결정적인 단점이 있다. 즉 송신된 음파가 물체에 반사되는 과정에서 음파의 세기가 약해져 센서로 수신되지 않거나, 음파가 여러 물체에 반복적으로 반사를 거쳐 수신되는 경우에는 허상의 물체를 인식하는 등 거리 정보의 신뢰성이 크게 떨어진다.10

이동로봇의 위치 평가를 위한 기존 방법에는 대표적으로 비선형 모델을 선형화하여 위치 평가를 하는 확장 칼만 필터(Extended Kalman Filter, EKF) 방법,11-13 파티클 필터(Monte Carlo Localization, MCL) 방법,14-16 그리고 분산점 칼만 필터(Unscented Kalman Filter, UKF) 방법들이 있다. UKF는 추측 항법(Dead-Reckoning Method)으로 이전에 평가된 위치의 오차 공분산을 기반으로 분산점(시그마 포인트)을 추출하고, 각 분산점들을 비선형 모델을 통하여 변환한 뒤 가중평균으로 로봇의 위치 및 오차 공분산을 추정하는 방법으로 UT (Unscented Transform) 기반이다.17

UKF는 비선형성이 큰 시스템에 유리하며, 파티클 필터의 특성을 가지고 있다. 그러나 파티클 필터의 경우 계산량이 많아 처리속도가 느리다는 단점이 있지만 UKF는 입자의 개수를 줄여 최적의 분산점을 추출하고, 가중치를 부여하여 평균을 내는 방법을 사용하므로 처리 속도가 비교적 빠르다.

본 논문에서는 UKF 기반으로 초음파센서를 이용한 실내 환경에서 로봇의 위치 평가 방법을 제안한다. 로봇 바퀴에 장착된 주행계의 정보를 이용하여 예측된 로봇의 위치와 초음파센서로부터 수집된 거리 정보를 UKF를 이용하여 융합함으로써 최적의 로봇 위치를 평가한다. 또한 초음파센서의 거울 효과에 의한 거리 정보의 신뢰성 저하 문제를 해결하기 위하여 Validation Gate를 제안하며, 이를 이용하여 측정된 센서 정보의 신뢰성을 평가하여 위치 평가에 유효한 거리 정보만을 선택적으로 이용함으로써 정밀한 위치 평가가 가능함을 실제 실험을 통하여 입증한다.

2. 본론

2.1 시스템 모델 및 측정 모델

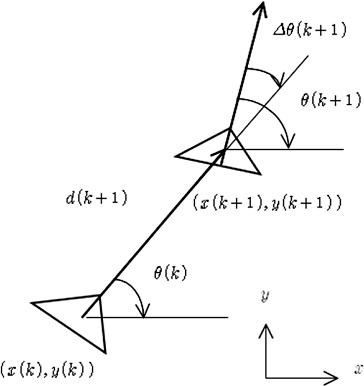

시간 k + 1에서 로봇의 위치 X(k + 1)은 Fig. 1과 같이 이전위치 X(k)와 제어입력 u(k + 1)을 이용하여 다음 식(1)과 같이 계산한다.

| (1) |

여기서 f(X(k), u(k + 1))은 비선형 상태천이함수이고, v(k + 1)은 평균이 0이고, 공분산이 Q(k + 1)인 로봇 이동에 관련된 오차이다. d(k + 1)은 로봇의 이동 거리이며, 로봇의 위치 정보는 로봇 바퀴에 장착된 주행계를 통하여 획득한다. 또한 시간 k + 1에서 초음파 센서의 측정 모델은 식(2)와 같이 정의한다.

| (2) |

여기서 H(X(k + 1))은 위치 X(k + 1)에서의 각 센서로부터 발생하는 거리값으로, 현재 로봇 위치에서 로봇에 장착된 각각의 초음파 센서로부터 측정된 주변 물체까지의 거리값이다. ω(k + 1)은 평균이 0이고, 공분산이 R(k + 1)인 측정에 개입되는 가우시안 잡음이다.

로봇 주행계 정보로부터 구해진 d(k + 1)와 Δθ(k + 1)를 식(1)에 적용하여 로봇의 위치와 공분산을 예측하고, 예측된 위치에서 각 센서의 측정값을 식(2)를 이용하여 구한 다음 이것을 Validation Gate를 이용하여 실제 측정값과 비교하여 유효한 측정값을 선별한다. 이와 같이 선별된 유효한 측정값을 이용하여 칼만 이득을 구한 다음 위치 및 공분산을 갱신하게 된다.

2.2 로봇의 위치 예측

시간 k + 1에서 로봇의 위치를 예측하기 위해서 먼저 시간 k에서의 공분산 행렬 P(k)로부터 다음 식(3)을 만족하는 제곱근 행렬 L을 구한다.18

| (3) |

여기서 n은 상태 벡터의 차원으로서, 본 연구에서 n = 3이고, λ는 다음 식(4)와 같이 정의된다.

| (4) |

여기서 α와 κ는 분산점 크기를 조정하는 매개변수로서, 크기 범위는 0 ≤ α ≤ 1, 0 ≤ κ이다.

다음으로 제곱근 행렬 L과 시간 k에서의 로봇 위치 X(k)를 이용하여 2n + 1개의 시간 k + 1에서의 로봇 위치 예측용 분산점 ℵ(k)를 다음 식(5)와 같이 추출한다.

| (5) |

여기서 Li는 제곱근 행렬 L의 i번째 열을 나타내며 i = 1, 2, …, n이다.

구해진 분산점 ℵi(k)로부터 비선형 상태천이함수를 이용하여 시간 k + 1에서 변환된 분산점 ℵi(k)를 다음 식(6)과 같이 계산한다.

| (6) |

여기서 Δθ(k + 1)는 회전 증분이며, ℵi(k)는 식(5)로 계산된 i번째 분산점으로 다음 식(7)과 같이 표현된다.

| (7) |

시간 k + 1에서의 예측된 로봇의 위치 는 변환된 분산점들의 평균값으로서 다음 식(8)과 같이 구해진다.

| (8) |

여기서 ωi는 로봇의 위치 예측을 위한 가중평균 계산용 가중치로 다음과 같이 계산된다.

| (9) |

이 예측에 따른 오차 공분산 행렬 P(k + 1|k)는 다음 식(10)과 같이 계산한다.

| (10) |

여기서 Q(k + 1)은 d(k + 1)과 Δθ(k + 1)를 반영하여 구해지며, 각 가중치 ωic는 다음 식(11)과 같이 정의된다.

| (11) |

위 식에서 상태벡터 특성이 가우시안일 때 β = 2가 된다.

2.3 측정값 예측

시간 k + 1에서 각 초음파센서의 측정값 예측을 위하여 계산된 공분산 행렬 P(k + 1|k)를 이용하여 다음 식(12)를 만족하는 제곱근 행렬 L0을 먼저 구한다.

| (12) |

여기서 λ는 식(4)와 동일하다.

측정값 예측용 분산점은 X(k + 1|k)및 L0를 이용하여 다음 식 (13)과 같이 구한다.

| (13) |

여기서 i는 1, 2,…, n이며, Lio는 제곱근 행렬 Lo의 i번째 열을 나타낸다.

로봇에 장착된 초음파센서의 개수를 m이라 하고, i번째 분산점 ℵi(k + 1|o)을 로봇의 중심 좌표로 할 때 j번째 센서의 거리값을 예측하는 예측 측정 벡터 rij(k + 1)은 다음 식(14)와 같이 표현된다.

| (14) |

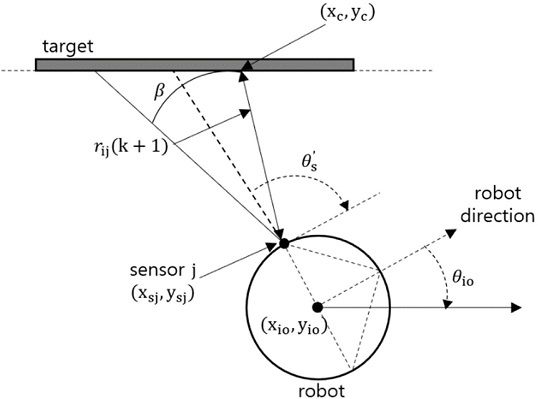

여기서 T는 타겟이고, i(0 ≤ i ≤ 2n)는 분산점의 일련번호, j(1 ≤ j ≤ m)는 센서 번호이다. 센서 j의 예측 거리값은 다음과 같이 구한다. 변환된 2n + 1개 중 i번째 분산점 ℵi(k + 1|o)가 로봇의 중심 좌표라 하면, 이것은 Fig. 2에서 나타낸 바와 같이 다음 식(15)와 같이 표현된다.

| (15) |

또한 로봇 중심 좌표에 대한 센서 j의 상대적 위치 및 방향을[xs', ys', θs']T라 하면 센서 j의 절대 좌표[xsj, ysj, θsj]T는 다음 식 (16)과 같이 구해진다.

| (16) |

즉 센서 j는 [xsj, ysj]T 위치에서 θsj 방향으로 존재하는 물체와 의 거리를 측정하는 것이다. 초음파센서의 유효감지각을 β라 하면 이 각도 내에서 최단 거리의 물체가 측정되므로 Fig. 2에서와 같이 센서로부터 (xc, yc)까지의 거리 rij(k + 1)가 예상 측정거리가 되며, 다음 식(17)과 같이 표현된다.

| (17) |

이와 같이 구해진 2n + 1개의 rij(k + 1)를 다음 식(18)과 같이 가중평균하여 센서 j의 최종 예측 거리값 로 확정한다.

| (18) |

여기서 ω는 식(9)와 같다.

그러나 센서에 따라서 모든 분산점에 대하여 rij(k + 1)이 구해지지 아니하는 경우가 발생한다. 이 경우는 식(18)과 같이 가중평균으로 최종 예측값을 구하면 편향된 결과가 나오므로 그러한 센서의 예측값은 위치 평가에서 제외시킨다.

2.4 측정값 유효성 평가

초음파센서는 유효감지각이 30o 정도로 크기 때문에 방향 정밀도가 떨어지며, 거울 반사 효과, 다중 반사 경로 및 기타 잡음에 의하여 측정 오차가 커질 수 있다. 따라서 측정된 각 센서의 거리값의 유효성을 평가하여 신뢰성이 없는 측정값은 제외시켜야 한다.

먼저 유효한 예측 거리값이 발생한 센서의 개수를 h라 하면, 실제 측정값과 대응되는 예측 관측값의 차이로 구성되는 Innovation Γj(k + 1)을 다음 식(19)와 같이 구한다

| (19) |

여기서 Zj(k + 1)은 실제 각 센서로부터 측정된 거리값이다.

실제 측정값의 유효성 평가는 다음과 같은 Validation Gate를 이용한다.

| (20) |

여기서 γ는 측정값 유효성 범위를 설정하는 설계 변수이며, 는 위치값 예측 공분산으로서 센서 j에 대한 각 분산점의 예측 위치값 rij(k + 1)과 그 평균값 로부터 다음 식 (21)과 같이 정의된다.

| (21) |

위 식(21)에서 Rj(k + 1)은 센서 j의 가우시안 잡음에 대한 공분산이다.

만약 측정값이 식(20)을 만족한다면 유효한 측정값으로 로봇의 위치 및 오차 공분산 갱신에 이용된다. 반면 그렇지 못한 측정값은 위치 갱신에 유효하지 않으므로 제외한다.

2.5 위치 및 공분산 갱신

측정값 유효성 평가에서 Validation Gate를 통과한 측정값 개수를 a라 할 때, 이 a개의 Γj(k + 1)과 Pzz,j(k + 1)을 이용하여 다음과 같이 Γ(k + 1)과 Pzz(k + 1)의 행렬을 구성한다. 먼저 Γ(k + 1)는 다음 식(22)와 같다.

| (22) |

Rzz(k + 1)는 Pzz,j(k + 1)을 대각성분으로 하고, 나머지 요소는 전부 0인 a × a 대각 정방행렬로 구성된다. 즉,

| (23) |

또한 센서 j에 대한 Pxz,j(k + 1)을 다음과 같이 구한다.

| (24) |

이것을 이용하여 다음 식(25)와 같이 Pxz(k + 1) 행렬을 구성한다.

| (25) |

위 식들을 이용하여 위치 및 오차 공분산 갱신을 위한 칼만 이득을 다음 식(26)과 같이 계산한다.

| (26) |

이와 같이 계산된 칼만 이득을 이용하여 다음과 같이 시간 k + 1에서의 위치 및 오차 공분산을 갱신한다.

| (27) |

3. 실험 및 고찰

3.1 실험 장비 및 환경

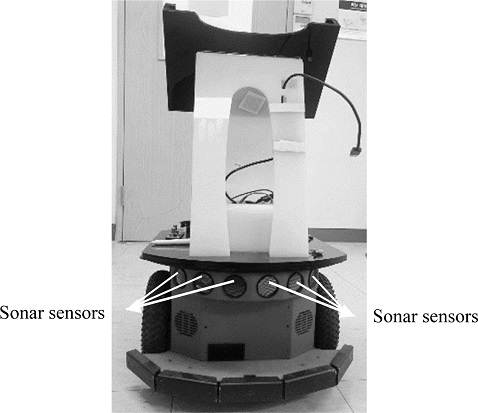

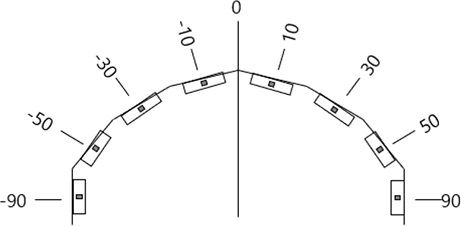

Fig. 3은 실험에 사용된 로봇 플랫폼인 Adept Technology사의 Pioneer-3DX 로봇 모델과 장착된 초음파센서의 사진이다. 초음파센서 배치는 제조사의 설계 사양으로서 Fig. 4와 같이 20에서 40o 간격으로 8개가 장착되어 있으며 그 사양은 Table 1과 같다. 실험은 가로 7, 세로 10 m의 직사각형 공간에서 진행하였다. 실험 환경에는 서랍, 선반 등의 장애물들이 존재하며 각 물체의 위치를 측정하여 실험 환경 정보를 미리 제공하였다.

3.2 실험 결과

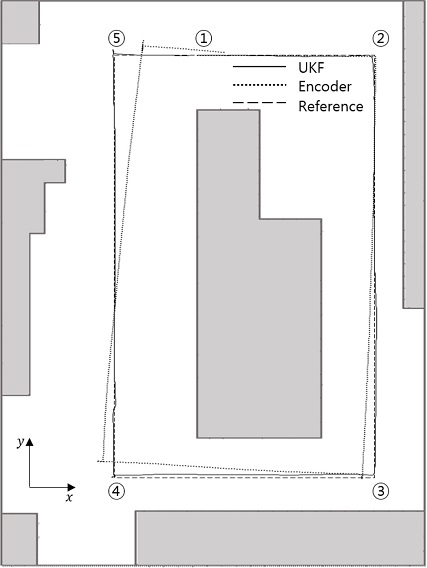

Fig. 5는 실험 환경 및 실험 결과를 나타낸다. Fig. 5에서 실선은 기준 경로, 파선은 UKF 기반 위치 평가 결과, 점선은 주행계의 값으로 계산된 위치를 나타낸다. Fig. 5에서 숫자는 기준 경로를 나타내는데 ①-⑤까지 기준 위치를 정한 후 각 기준 위치를 직선으로 연결하는 방법으로 경로를 설정하였다. 이것은 실제 로봇의 이동 경로는 정확한 측정이 어렵기 때문에 기준 경로를 설정한 다음 그 경로를 따라 주행하게 함으로써 로봇의 이동 경로 정보를 측정하기 위함이다. 로봇은 ①번 위치부터 번호를 순서대로 경유하여 다시 ①번 위치로 돌아오는 경로로 주행하였다. 실험 결과를 살펴보면 주행계의 이동 궤적은 주행 거리가 길어질수록 오차가 크게 증가하는 반면에 UKF 기반 위치 평가 결과는 약간의 오차가 발생하지만, 기준 경로를 잘 추종함을 알 수 있다.

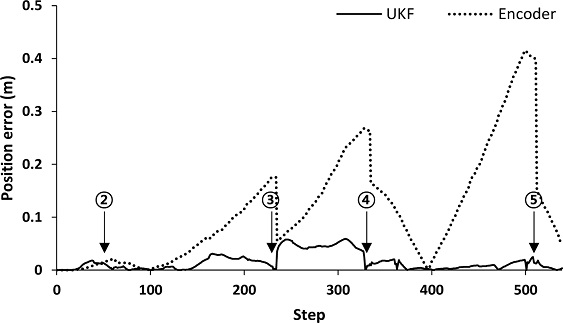

Fig. 6은 위치 오차를 나타내는데, 실선은 UKF의 위치 오차, 점선은 주행계의 위치 오차를 나타내고, ②-⑤는 Fig. 5에 나타낸 각각의 기준 위치를 의미한다.

Table 2는 기준 경로에 대한 위치 오차의 정량적인 특성을 나타내는데, 오차 특성을 분석해보면 주행계 정보만으로 수행된 위치 평가의 오차는 주로 각도 오차에 기인한 것으로서 주기성을 보이며 최대 오차가 0.350 m, 평균이 0.095 m로 대체적으로 큰 오차를 보인다. 반면 UKF 위치 평가는 최대 오차가 0.059 m, 평균 오차가 0.016 m로서 주행계에 의한 위치보다 오차가 훨씬 작음을 알 수 있다.

Table 3은 UKF 위치 평가 결과 x, y 각 위치에 대한 위치 오차를 나타내고 있다. Table 3에서 x방향의 평균 오차는 0.010 m이고, y방향의 평균 오차는 0.027 m로 x방향보다 조금 더 크게 나타냈다. 이것은 초음파센서의 위치가 Fig. 4에 나타낸 바와 같이 전면에 집중 배치되어 있어 ②, ③ 구간과 ④, ⑤ 구간에서는 x방향으로는 초음파센서의 거리 정보 입수 빈도가 높은데 반해, y방향으로는 거리 정보가 극히 적었기 때문으로 사료된다. ③, ④ 구간의 오차가 다른 구간보다 다소 큰 것은 ③ 위치 특성이 초음파센서의 거리 측정에 유리한 모서리 형상이 다른 위치보다 적은 장애물 환경 특성 때문에 회전 시에 오차가 더 크게 발생한 것으로 사료된다.

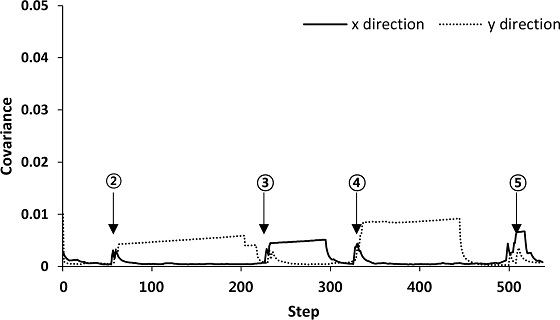

Fig. 7은 주행 단계에 따른 공분산 특성을 나타낸다. Fig. 7을 살펴보면 네 곳에서 갑자기 공분산이 커지는 현상을 확인할 수 있는데, 이것은 기준 경로의 ②-⑤에 해당하는 모서리 부분에서 로봇이 스텝당 50o 정도의 급격한 회전을 하였기 때문이다. Fig. 5에서 보여지듯이 위치 오차는 주로 각도 오차에 기인하고 있기 때문에 급격한 회전은 위치 오차를 크게 증가시키고 이에 따라 위치 평가의 신뢰성과 연관된 공분산 값이 커져 위치 평가의 신뢰성을 떨어뜨린 것이다.

기준 위치 ② 부분에서 공분산 값이 커지지만 이후 x방향의 공분산은 급격히 감소하여 위치 신뢰성이 크게 개선되는 반면, y방향은 그렇지 않은 양상을 보인다. 그 이유는 로봇이 기준 경로 ②, ③ 구간 주행 시에는 x방향의 초음파 거리 정보 빈도는 높은 반면, 초음파센서의 최대감지거리가 5 m 이내로 짧기 때문에 y방향 거리 정보는 ③ 위치에 가까워지기 전까지 거의 없었기 때문이다. ③ 위치에서 회전에 의하여 증가된 공분산 값은그 이후 ② 위치와 반대의 경향을 보인다. 이것 역시 ③, ④ 구간에서는 y방향 거리 정보의 빈도는 높고, x방향의 거리 정보 빈도는 낮기 때문이다. 결과적으로 어떤 경우든 초음파 거리 정보가 입수되면 곧바로 공분산 값이 급격하게 감소하여 위치 평가의 신뢰성이 크게 향상됨을 알 수 있다.

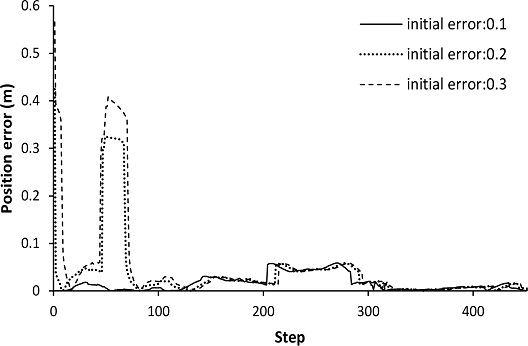

UKF 기반 위치 평가의 초기 오차 크기에 대한 수렴성 및 안정성을 확인하기 위하여 초기 오차값 크기 변화에 따른 위치 오차를 Fig. 8에 나타냈다. Fig. 8에서 초기 오차 0.1은 x와 y방향 위치 오차가 각각 0.1 m, 그리고 각도 오차 0.1 라디안임을 의미한다. 그 결과 초기 오차 크기에 따라 주행 초기에는 서로 다른 오차 특성을 보이나, 주행 스텝이 증가될수록 초기 오차의 크기에 상관없이 거의 유사한 오차 특성을 보임을 확인할 수 있다.

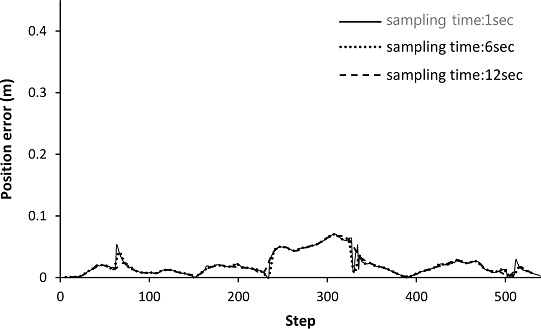

Fig. 9는 샘플링 시간에 대한 성능 확인을 위하여 관측 주기를 1초, 6초, 12초로 변화시키며 그에 따른 위치 오차를 분석한 결과로서 샘플링 시간이 크게 증가함에도 불구하고 오차의 변화는 크지 않음을 알 수 있다. 따라서 제안된 방법은 관측 주기의 변화에도 안정적인 위치 평가가 가능하다고 사료된다.

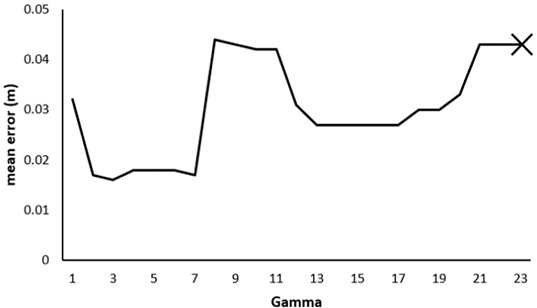

Fig. 10에는 Validation Gate의 γ값에 따른 위치 오차를 나타냈다. 그 결과 γ값이 3일 경우 평균 오차값이 가장 작았으며, γ의 값이 커질수록 오차가 증가하는 양상을 보이다가 24 이상부터는 위치 평가가 불가능하였다. 이것은 Validation Gate를 적용하지 않으면 위치 평가가 불가능하다는 것을 의미한다.

4. 결론

본 논문에서는 초음파센서를 이용한 실내 UKF 기반 위치평가 방법과 초음파센서의 불확실성을 해결하기 위하여 Validation Gate를 이용해 거리 정보의 유효성을 평가함으로써 위치 평가의 정확도를 높이는 방법을 동시에 제안하였다. 실험을 통하여 제안된 방법의 성능을 평가한 결과 위치 평가의 유용성이 확인되었으며, 실내 환경의 위치 평가에 충분히 적용할 수 있을 것으로 사료된다.

Acknowledgments

이 논문은 2021학년도 제주대학교 교원성과지원사업에 의하여 연구되었음.

REFERENCES

- Lim, J. H. and Kim, H. J., “Development of an Autonomous Guide Robot for Campus Tour,” Transactions of the Korean Society of Mechanical Engineers A, Vol. 41, No. 6, pp. 543-551, 2017.

-

Lim, J. H. and Leonard, J. J., “Mobile Robot Relocation from Echolocation Constraints,” IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol. 22, No. 9, pp. 1035-1041, 2000.

[https://doi.org/10.1109/34.877524]

-

Lee, W. S., Cho, I. H., and Lim, J. H., “GPS-Based Human Tracking Methods for Outdoor Robots,” Journal of the Korean Society for Precision Engineering, Vol. 35, No. 4, pp. 413-420, 2018.

[https://doi.org/10.7736/KSPE.2018.35.4.413]

-

Lee, W. S. and Lim, J. H., “Unscented Kalman Filter Based Outdoor Localization of a Mobile Robot,” Journal of the Korean Society for Precision Engineering, Vol. 36, No. 2, pp. 183-190, 2019.

[https://doi.org/10.7736/KSPE.2019.36.2.183]

-

Bikonis, K. and Demkowicz, J., “Data Integration from GPS and Inertial Navigation Systems for Pedestrians in Urban Area,” TransNav: International Journal on Marine Navigation and Safety of Sea Transportation, Vol. 7, No. 3, pp. 401-406, 2013.

[https://doi.org/10.12716/1001.07.03.12]

-

Toledo-Moreo, R., Zamora-Izquierdo, M. A., Ubeda-Minarro, B., and Gómez-Skarmeta, A. F., “High-Integrity IMM-EKF-Based Road Vehicle Navigation with Low-Cost GPS/SBAS/INS,” IEEE Transactions on Intelligent Transportation Systems, Vol. 8, No. 3, pp. 491-511, 2007.

[https://doi.org/10.1109/TITS.2007.902642]

- Kim, J. S., “Infrared Sensor Technology,” Journal of the Korean Ceramic Society, Vol. 8, No. 4, pp. 28-33, 2005.

- Hirai, N. and Mizoguchi, H., “Visual Tracking of Human Back and Shoulder for Person Following Robot,” Proc. of the IEEE/ASME International Conference on Advanced Intelligent Mechatronics, pp. 527-532, 2003.

-

Yoshimi, T., Nishiyama, M., Sonoura, T., Nakamoto, H., Tokura, S., et al., “Development of a Person Following Robot with Vision Based Target Detection,” Proc. of the IEEE/RSJ International Conference on Intelligent Robots and Systems, pp. 5286-5291, 2006.

[https://doi.org/10.1109/IROS.2006.282029]

- Lim, J. H. and Cho, D. W., “Consideration of Multipath Effect in Sonar Map Construction for an Autonomous Mobile Robot,” Proc. of the Conference on Institute of Control, Robotics and System, Vol. 1, No. 1, pp.106-112, 1993.

-

Jetto, L., Longhi, S., and Venturini, G., “Development and Experimental Validation of an Adaptive Extended Kalman Filter for the Localization of Mobile Robots,” IEEE Transactions on Robotics and Automation, Vol. 15, No. 2, pp. 219-229, 1999.

[https://doi.org/10.1109/70.760343]

-

Lim, J. H. and Kang, S. K., “Non-Inertial Sensor-Based Outdoor Localization for Practical Application of Guide Robots,” Journal of the Korean Society for Precision Engineering, Vol. 34, No. 5, pp. 315-321, 2017.

[https://doi.org/10.7736/KSPE.2017.34.5.315]

-

Kim, J. M., Kim, Y. T., and Kim, S. S., “Indoor Localization for Mobile Robot Using Extended Kalman Filter,” Journal of Korean Institute of Intelligent Systems, Vol. 18, No. 5, pp. 706-711, 2008.

[https://doi.org/10.5391/JKIIS.2008.18.5.706]

-

Thrun, S., Fox, D., Burgard, W., and Dellaert, F., “Robust Monte Carlo Localization for Mobile Robots,” Artificial Intelligence, Vol. 128, Nos. 1-2, pp. 99-141, 2001.

[https://doi.org/10.1016/S0004-3702(01)00069-8]

-

Kim, T. G., Ko, N. Y., and Noh, S. W., “Simultaneous Estimation of Landmark Location and Robot Pose Using Particle Filter Method,” Journal of Korean Institute of Intelligent Systems, Vol. 22, No. 3, pp. 353-360, 2012.

[https://doi.org/10.5391/JKIIS.2012.22.3.353]

-

Cho, H. H., Kim, J. M., Do, J. C., and Kim, S. S., “Improvement of Positioning Accuracy of Laser Navigation System Using Particle Filter,” Journal of Korean Institute of Intelligent Systems, Vol. 21, No. 6, pp. 755-760, 2011.

[https://doi.org/10.5391/JKIIS.2011.21.6.755]

-

Xu, Q., Li, X., and Chan, C. Y., “A Cost-Effective Vehicle Localization Solution Using an Interacting Multiple Model-Unscented Kalman Filters (IMM-UKF) Algorithm and Grey Neural Network,” Sensors, Vol. 17, No. 6, pp. 1431, 2017.

[https://doi.org/10.3390/s17061431]

-

Julier, S. J., “The Scaled Unscented Transformation,” Proc. of the American Control Conference, pp. 4555-4559, 2002.

[https://doi.org/10.1109/ACC.2002.1025369]

B.Sc. candidate in the Department of Mechatronics Engineering, Jeju National University. Her research interest is intelligent robot.

E-mail: abc6318@jejunu.ac.kr

Professor in the Department of Mechatronics Engineering, Jeju National University. His research interest is intelligent robot and control.

E-mail: jhlim@ jejunu.ac.kr