딥러닝 기반의 열화상 카메라를 이용한 화점 추적 팬-틸트 시스템 구현

Copyright © The Korean Society for Precision Engineering

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License (http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

Abstract

There have been frequent fatal accidents of firefighters at fire scenes. A firefighting robot can be an alternative to humans at a fire scene to reduce accidents. As a critical function of the firefighting robot, it is mandatory to autonomously detect a fire spot and shoot water. In this research, a deep learning model called YOLOv7 was employed based on thermal images to recognize the shape and temperature information of the fire. Based on the results of the test images, which were not used for learning purposes, a recognition rate of 99% was obtained. To track the recognized fire spot, a 2-DOF pan-tilt actuation system with cameras was developed. By using the developed system, a moving target can be tracked with an error of 5%, and a variable target tracking test by alternately covering two target braziers showed that it takes about 1.5 seconds to track changing targets. Through extinguishment experiments with a water spray mounted on the pan-tilt system, it was observed that the temperature of the brazier dropped from 600 degrees to 13 degrees. Based on the obtained data, the feasibility of a robotic firefighting system using image recognition was confirmed.

Keywords:

Deep learning, YOLO, Thermal camera, Pan-tilt, Autonomous tracking, Firefighting키워드:

딥러닝, 욜로, 열화상 카메라, 팬-틸트, 자율 추적, 소화1. 서론

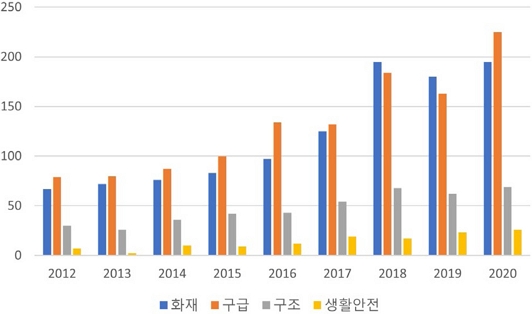

매년 화재현장에서 인명사고가 끊임없이 발생하고 있다. 소방청에서 발표한 연도별 소방 공무원의 부상자 수를 Fig. 1에 그래프로 나타냈다[1]. 자료에 의하면 2012-2016년보다 2017-2020년에 부상자가 약 2배 늘어났고, 2017년 이후로는 화재로 인한 부상자의 수가 가장 많았다. 이를 통해 최근 들어 화재 현장에서의 사고가 더욱 많이 생기고 있고, 특히 화재진압 과정에서 사고가 가장 많이 발생하는 것을 알 수 있다.

한편, 최근 로봇 관련 기술이 발전함에 따라 소방대원 대신 위험한 현장에 투입할 소방로봇이 잇따라 개발되고 있다. Fig. 2에 현재까지 개발된 여러 소방로봇들을 나타냈다. Fig. 2(a)는 미국 로스앤젤레스 소방서의 RS3 소방로봇이다. RS3 소방로봇은 로봇에 부착된 카메라를 통해 사람이 화재현장을 보면서 수동으로 조작하는 방식을 사용한다[2]. 이런 방식은 카메라의 시점으로만 화재현장을 보고 판단해야 하기 때문에 현장을 완벽하게 파악한 뒤 소방할 수 없다는 문제점이 있다. Fig. 2(b)는 휴림로봇의 스마트 소방로봇이다. 이 로봇은 화재 감지 시스템과 연동해 화재 위험을 감지하여 소방하는 방식이다[3]. 이 방식은 화재 감지 시스템이 존재하는 시설에만 사용이 가능하다는 한계가 존재하고, 화재 감지 시스템이 고장 난 경우에는 화재를 감지하기 어렵다는 문제점을 가지고 있다.

이런 문제점들로 인해 최근 카메라와 인공지능을 활용해 영상인식 기술로 화염을 인식하는 연구가 활발하게 진행되고 있다[4-10]. Fig. 3은 RGB 카메라로 촬영한 영상을 딥러닝 모델에 적용해 화염을 인식한 연구 사례이다[11]. 이 연구에서는 불이 일어난 위치인 화점을 정확히 찾지 못하고 불기둥을 쫓거나, 불과 비슷한 형태를 가진 물체와 혼동할 위험이 발견되었다. 이런 경우 불을 인식했어도 소화를 효과적으로 할 수 없는 문제점이 존재한다. 또한, 기존의 연구에서는 영상인식을 바탕으로 제어를 하는 비주얼 서보잉 기술은 개발되지 않았기 때문에 소방로봇에 직접적으로 적용이 불가했다.

본 논문에서는 스스로 불을 인식하고 추적하여 물을 분사하기 위해 YOLOv7이라는 딥러닝 영상인식 모델을 이용하여 화점을 추적하는 팬-틸트 시스템을 구현하고자 한다. 이때 열화상 카메라로 얻은 이미지로 모델을 학습하면 일반 RGB 카메라만 이용했을 때보다 여러 장점이 존재한다. 화염이 연기에 가려지거나 빛이 없는 극한의 환경에서도 열화상 카메라는 적외선 복사열을 인식하기 때문에 화염을 찾을 수 있다. 또한, 불의 형상과 색상을 통한 온도 정보를 종합적으로 고려하기 때문에 화염과 비슷하게 생긴 물체를 오인할 위험이 줄어든다. 다음과 같은 이유로 열화상 카메라를 이용해 인식기를 만들어 화염 인식률의 정확도를 높이고자 하였다.

2. 화점 인식 알고리즘

2.1 YOLOv7

열화상 카메라로 얻은 이미지 정보를 토대로 화점을 인식하고 추적하기 위해서는 실시간으로 화염을 감지할 수 있어야 한다. 본 연구에서는 인식 알고리즘으로 YOLOv7을 사용했다.

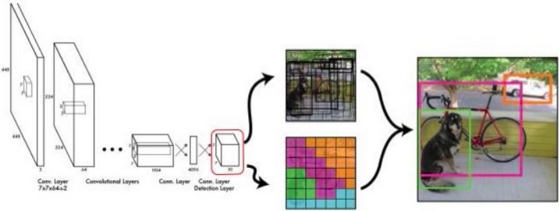

YOLO는 현재 다양한 분야에서 실시간으로 영상인식을 통해 객체를 탐지할 때 사용되고 있는 딥러닝 모델이다. YOLO 이전의 Faster R-CNN과 같은 영상인식 알고리즘들은 이미지에서 객체를 추출하고 클래스를 분류하는 두 과정이 분리되어 있어 비용이 많이 들었다[12]. 이런 문제로 객체 탐지 속도가 느려 실시간 객체 탐지에 사용하기 어려웠다. 하지만 YOLO는 Fig. 4와 같이 네트워크의 최종 출력단에서 위치 찾기와 클래스 분류를 동시에 하여 비용을 줄임으로써 실시간 객체 탐지를 가능하게 만들었다[13]. 2016년에 YOLOv1이 처음 발표되고 2022년 현재를 기준으로 YOLOv7까지 개발되었다.

YOLOv7은 추론 중 추가 계산 비용을 증가시키지 않으면서 객체 탐지 네트워크의 성능을 향상시키는 기법을 적용한 모델이다[14]. 이는 현재까지 존재하는 영상인식 객체 탐지 모델 중에 가장 정확하고 빠른 성능을 보여주고 있다. 본 논문에서는 실시간 객체 탐지에 뛰어난 성능을 보이는 YOLOv7을 이용해 화점을 검출하고 이를 소방 설비에 적용하는 시스템을 제안한다.

2.2 화염 검출기를 통한 중심점 추출

화염 검출기를 만들기 위해 화로대를 이용해 불을 발생시키고 학습에 필요한 데이터 셋을 획득했다. 열화상 카메라로 동영상을 촬영한 뒤 프레임별로 나누어 동영상을 이미지화하여 Fig. 5와 같은 학습용 이미지 데이터 1,461장과 검증용 데이터 364장을 만들었다. 이 이미지 데이터를 YOLOv7를 이용하여 학습시키고 Fig. 6과 같이 화염을 인식하는 검출기를 만들었다.

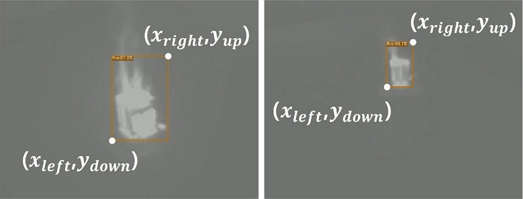

검출기가 화염을 인식한 뒤 이를 추적하기 위해서는 검출기가 생성한 검출박스의 중심점 좌표가 필요하다. 검출기가 검출박스를 생성할 때 사용하는 모서리 점의 x, y좌표를 이용해 검출박스의 중심점 좌표를 계산했다. 이를 계산하는 식은 식(1), 식(2)와 같다. 계산한 중심점의 좌표를 직렬통신으로 팬-틸트 시스템의 모터를 제어하는 MCU (Microcontroller Unit)인 OpenCR 보드로 보낼 수 있도록 했다.

| (1) |

| (2) |

3. 팬-틸트 시스템 구성

3.1 비주얼 서보잉 알고리즘

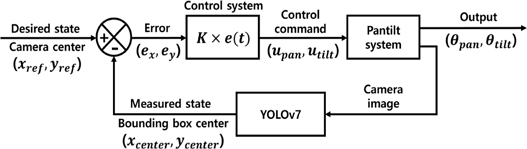

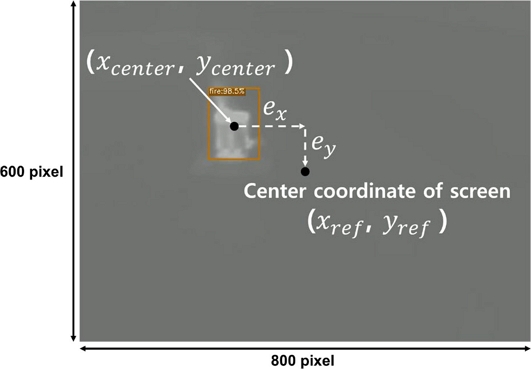

YOLOv7에서 직렬통신을 통해 검출박스의 중심점 좌표를 OpenCR 보드로 보낸 후 Fig. 7과 같은 피드백 제어기법으로 모터를 제어한다[15]. 팬틸트 시스템의 제어 목적은 노즐이 향하는 방향과 화점을 일치시켜 소화하는 것이다. 노즐과 카메라는 일체형으로 설치되어 있기 때문에 카메라의 광축의 방향은 노즐의 방향과 일치한다. 카메라의 광축은 곧 카메라 화면의 중심이기 때문에 화소로 표현된 화면의 중심(xref, yref)과 목표물의 중심(xcenter, ycenter) 사이의 위치 오차를 최소화하여 카메라의 광축과 목표물을 일치시킴으로써 노즐의 방향이 화점을 향할 수 있도록 제어하고자 했다. 위치 오차를 이용해 두 모터를 제어하는 식은 식(3), 식(4)와 같다. 다음과 같은 피드백 제어를 통해 2개의 모터가 (θpan, θtilt)만큼 움직임으로써 검출박스의 중심이 항상 화면의 중앙에 놓이도록 알고리즘을 구성했다.

| (3) |

| (4) |

3.2 팬-틸트 시스템 구성

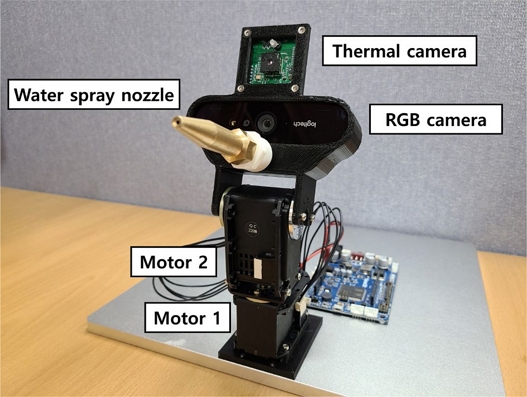

시스템이 목표물인 화점을 추적하기 위해서는 2축으로 움직일 수 있는 팬-틸트 시스템을 구축해야 한다[16]. 모터 2개를 이용해 2축으로 움직일 수 있도록 했고, Fig. 9와 같이 분사 노즐과 일반카메라 그리고 열화상 카메라를 설치할 수 있는 헤드부를 3D 프린터를 이용해 제작했다. 이때 카메라가 얻은 이미지 정보를 바탕으로 모터를 제어하기 때문에 모터의 회전축과 분 사 노즐, 카메라가 동일선상에 위치할 수 있도록 설계해 카메라가 화점을 바라보고 있을 때 노즐도 동일한 곳을 조준할 수 있도록 했다.

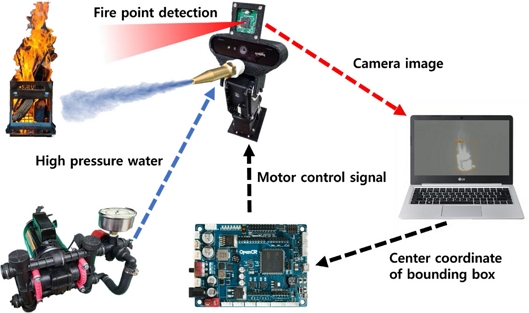

분사 노즐이 화점을 정확하게 조준했다면 물을 직사 해야 불에 도달할 수 있다. 직사 살수를 위해서는 높은 압력의 물이 필요하기 때문에 고압용 펌프를 사용했다. 또한, 이에 맞는 고압용 노즐과 장거리 분사가 가능한 고압용 직사 노즐을 사용하여 분사 시스템을 구성했다. 분사 성능을 테스트해본 결과 최대 5 m까지 직사가 가능한 것을 확인했다. 전체 시스템의 흐름도는 Fig. 10과 같고, 각 시스템을 구성하는 부품의 제원은 Table 1과 같다.

4. 인식 및 추적 소화 실험을 통한 검증

4.1 인식 성능 테스트

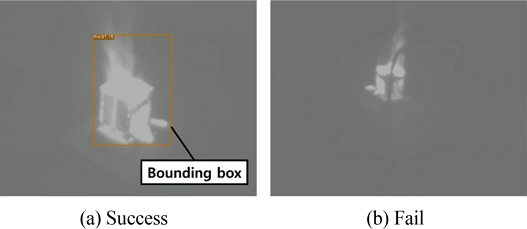

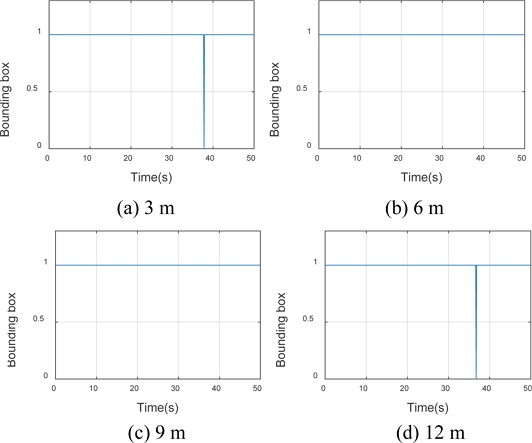

YOLOv7으로 만든 화점 검출기의 화염 인식 성능을 검증하기 위해 테스트 데이터베이스로 인식 성능 테스트를 진행했다. 테스트 데이터는 학습 데이터와 다른 시간, 장소에서 화염을 3 m 간격으로 다양한 각도에서 4차례 촬영하여 테스트의 신뢰도를 높이고자 했다. 실험은 검출기가 화염을 인식해서 검출박스를 생성하는지 여부를 파악하는 방식으로 실험을 진행했다. 인식 테스트 결과 이미지 예시는 Fig. 11과 같다. 대부분 Figs. 11(a)와 같이 인식에 성공했지만, 11(b)처럼 장애물에 가려진 경우 인식에 실패하는 경우가 존재하는 것을 확인했다. 이를 수치화하기 위해 검출기가 화염을 인식해 검출박스가 생성된 경우에는 1, 생성되지 않은 경우에는 0을 반환하도록 하여 MATLAB 프로그램을 이용해 Fig. 12와 같이 그래프로 나타냈다. 초당 10프레임으로 50초씩 총 4개의 동영상으로 테스트하여 도출한 그래프를 분석한 결과 총 2,000프레임 중 단 2프레임에서 인식에 실패해 인식률이 99.9%에 달하는 것을 확인할 수 있었다. 테스트 데이터는 학습 데이터와 다른 장소와 시간에서 취득한 데이터지만 열화상 카메라의 특성상 배경이 달라지거나 빛의 유무에 영향을 적게 받기 때문에 인식률이 높게 나온 것으로 분석했다.

4.2 추적 성능 테스트

이번 장에서는 검출기가 화염을 인식한 다음 팬-틸트 시스템이 화점을 잘 추적하는지 두 가지의 실험을 통해 성능을 검증한다.

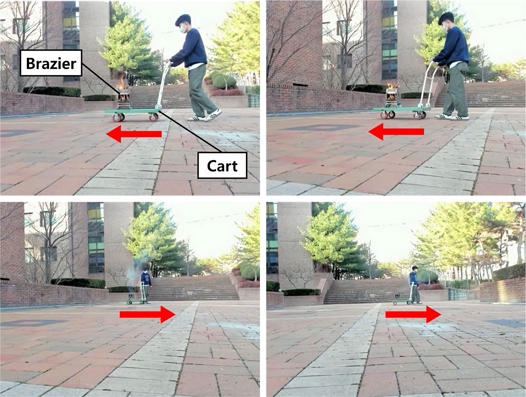

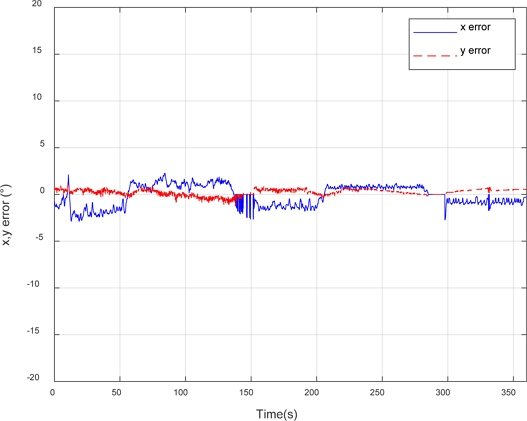

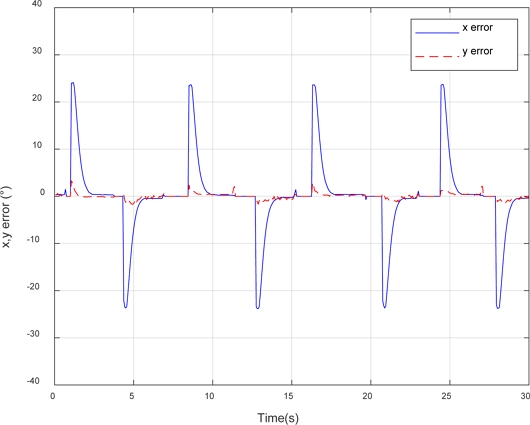

첫 번째 실험은 움직이는 목표물을 팬-틸트 시스템이 지속적으로 추적할 수 있는지 성능을 테스트했다. 대차 위에 화로대를 설치한 뒤 Fig. 13과 같이 좌우 10 m 전후 15 m 범위에서 ‘ㄹ’자 형태로 대차를 움직이면서 실험을 진행했다. 검출박스 중심 좌표와 열화상 카메라 화면 중심 좌표 사이의 오차를 이용해 카메라의 광축과 목표물 간의 사잇각을 계산하여 추적 성능을 평가했으며 이를 Fig. 14와 같이 그래프로 나타냈다. 그래프 분석 결과 x축 최대 오차는 3도로 카메라의 수평 화각인 57도에 비해 오차가 5% 이내로 발생하는 것을 확인했다. y축 최대 오차는 1도로 카메라의 수직 화각인 43도에 비해 오차가 3% 이내로 발생하는 것을 확인했다. 대차를 이용해 화로대를 움직이기 때문에 높이 변화가 거의 없어서 y좌표의 오차가 x좌표 오차보다 적게 발생했다. 이를 통해 팬-틸트 시스템이 움직이는 목표물을 지속적으로 추적하는 것을 확인할 수 있었다.

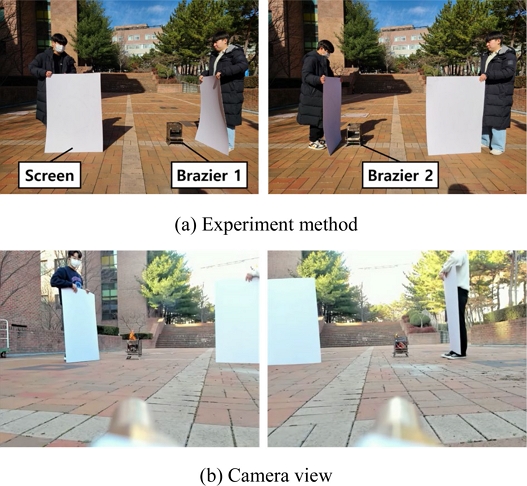

두 번째 실험은 Fig. 15와 같이 두 개의 화로대를 설치하고 가림막을 이용하여 번갈아 가면서 화로대를 노출하여 변화하는 화점을 잘 추적하는지에 관한 성능을 파악하였다. 이번 실험에서도 이전 실험과 동일하게 검출박스의 중심과 화면의 중심좌표 사이의 오차로 목표물과 카메라 광축 간의 사잇각을 계산해 추적 성능을 평가했다. 검출박스의 중심과 화면의 중심의 오차를 그래프로 Fig. 16과 같이 나타냈다. 그래프 분석 결과 목표물이 바뀔 때마다 카메라의 광축과 목표물 간의 사잇각이 24도 정도 차이가 발생하지만 팬-틸트 시스템이 빠르게 움직여 오차가 1.5초 이내에 0도에 가까워지는 것을 확인할 수 있다. 두 개의 추적 성능 실험을 통해 목표물이 움직이거나 바뀌어도 팬-틸트 시스템이 지속적으로 추적 가능한 것을 확인했다.

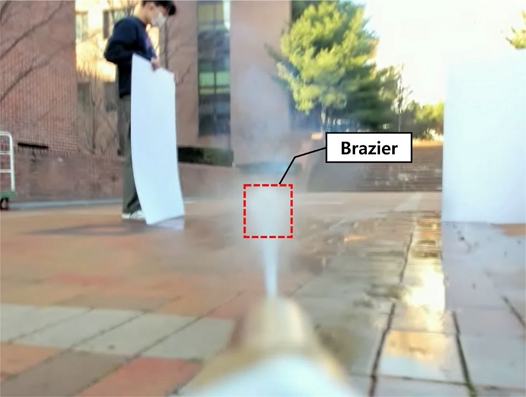

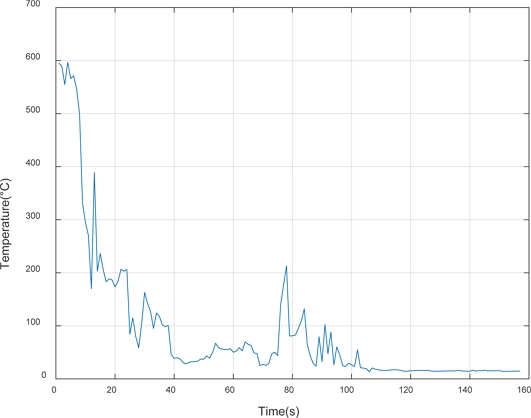

4.3 소화 성능 테스트

추적까지 완료했다면 고압 펌프로 만든 분사 시스템을 이용해 직사 살수로 불을 꺼야 한다. 소화 성능을 검증하기 위해 Fig. 17과 같이 화로대로부터 4 m 떨어진 거리에서 직사 살수를 할 때 화로대의 온도 변화를 측정했다. 비접촉식 적외선 온도계로 살수 직전부터 화로대의 온도가 충분히 낮아질 때까지의 온도 변화를 측정했다. 측정 결과를 Fig. 18과 같이 그래프로 나타냈다. 실험 결과 화로대의 온도가 600도에서 13도로 온도가 충분히 낮아진 것을 확인할 수 있었다. 물줄기에 의해 화로대 안의 다른 장작이 측정 범위에 들어와 종종 그래프 중간에 온도가 올라갔지만, 곧 소화가 모두 완료되었다. 이를 통해 분사 시스템의 직사 살수 방식이 소화가 가능함을 확인했다.

5. 결론

본 논문에서는 화점 자율 추적 시스템을 만들기 위해 YOLOv7이라는 딥러닝 모델을 이용해 화점 검출기를 만들고 이를 바탕으로 화점을 스스로 추적하고 물을 분사하는 팬-틸트 시스템을 구현했다. 화점 인식률을 높이기 위해 열화상 이미지를 사용했고, 피드백 제어를 통해 팬-틸트 시스템을 제어했다. 그리고 직사 살수 방식을 이용하여 소방 효과를 극대화했다. 테스트 데이터로 인식 성능을 확인한 결과 99%의 인식률을 확인했다. 동적 목표물 추적 실험 결과 5% 이내의 오차로 잘 추적하는 것을 확인했다. 또한, 가변 목표물 추적 실험 결과 1.5초 이내로 추적하는 것을 확인했다. 마지막으로 소화 성능 테스트를 통해 분사 시스템의 직사 살수 방식이 화염을 효과적으로 소화시킨 것을 확인했다. 추후에는 두 개 이상의 화염이 동시에 발생하거나 넓게 분포되어 있는 경우와 같이 복잡한 상황을 대비해 이에 대응하는 학습 데이터를 추가하고, 화염의 온도와 크기를 기준으로 소화할 화염의 우선순위를 정하는 추가 연구를 진행할 예정이다.

Acknowledgments

본 연구는 2022년도 과학기술정보통신부 및 정보통신기획평가원에서 지원한 ICT 혁신인재 4.0(1711174110) 사업의 연구결과로 수행되었습니다.

REFERENCES

- National Fire Service Academy, The number of injured firefighter by year. https://www.nfa.go.kr/cherish/news/notice/?boardId=bbs_0000000000000047&mode=view&cntId=288

- Yonhapnews, U.S. firefighting robot was out in force on the LA building fire for the first time. https://www.yna.co.kr/view/AKR20201015028100075

- Moneytoday, Hyulim robot developed AI·IoT fusion smart fire fighting robot. https://news.mt.co.kr/mtview.php?no=2022010709225481172

-

Son, G. Y., Park, J. S., (2021), Implementation of fire detection system based on video analysis with deep learning, Journal of Institute of Control, Robotics and Systems, 25(9), 782-788.

[https://doi.org/10.5302/J.ICROS.2019.19.0125]

-

Kim, Y.-J., Kim, E.-G., (2016), Image based fire detection using convolutional neural network, Journal of the Korea Institute of Information and Communication Engineering, 20(9), 1649-1656.

[https://doi.org/10.6109/jkiice.2016.20.9.1649]

-

Kim, Y., Cho, H., (2020), Detecting location of fire in video stream environment using deep learning, The Transactions of the Korean Institute of Electrical Engineers, 69(3), 474-479.

[https://doi.org/10.5370/KIEE.2020.69.3.474]

-

Wu, H., Hu, Y., Wang, W., Mei, X., Xian, J., (2022), Ship fire detection based on an improved YOLO algorithm with a lightweight convolutional neural network model, Sensors, 22(19), 7420.

[https://doi.org/10.3390/s22197420]

-

Goyal, S., Shagill, M., Kaur, A., Vohra, H., Singh, A., (2020), A yolo based technique for early forest fire detection, International Journal of Innovative Technology and Exploring Engineering, 9(6), 1357-1362.

[https://doi.org/10.35940/ijitee.F4106.049620]

-

Majid, S., Alenezi, F., Masood, S., Ahmad, M., Gündüz, E. S., Polat, K., (2022), Attention based CNN model for fire detection and localization in real-world images, Expert Systems with Applications, 189, 116114.

[https://doi.org/10.1016/j.eswa.2021.116114]

-

Muhammad, K., Ahmad, J., Mehmood, I., Rho, S., Baik, S. W., (2018), Convolutional neural networks based fire detection in surveillance videos, IEEE Access, 6, 18174-18183.

[https://doi.org/10.1109/ACCESS.2018.2812835]

-

Ramasubramanian, S., Muthukumaraswamy, S. A., Sasikala, A., (2020), Fire detection using artificial intelligence for fire-fighting robots, Proceedings of the 2020 International Conference on Intelligent Computing and Control Systems (ICICCS), 180-185.

[https://doi.org/10.1109/ICICCS48265.2020.9121017]

-

Girshick, R., (2015), Fast r-cnn, Proceedings of the IEEE International Conference on Computer Vision, 1440-1448.

[https://doi.org/10.1109/ICCV.2015.169]

-

Redmon, J., Divvala, S., Girshick, R., Farhadi, A., (2016), You only look once: Unified, real-time object detection, Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 779-788.

[https://doi.org/10.1109/CVPR.2016.91]

- Wang, C.-Y., Bochkovskiy, A., Liao, H.-Y. M., (2022), YOLOv7: Trainable bag-of-freebies sets new state-of-the-art for real-time object detectors, arXiv Preprint arXiv:2207.02696, . https://arxiv.org/pdf/2207.02696.pdf

-

Ziegler, J., Nichols, N., (1943), Process lags in automatic control circuits, Transactions of the ASME, 65(5), 433-440.

[https://doi.org/10.1115/1.4018788]

- Kurihara, K., Hoshino, S. i., Yamane, K., Nakamura, Y., (2002), Optical motion capture system with pan-tilt camera tracking and real time data processing, Proceedings of the 2002 IEEE International Conference on Robotics and Automation (Cat. No. 02CH37292), 1241-1248.

M.S. candidate in the Department of Mechanical Engineering, Kumoh National Institute of Technology. His research interest is robotics.

E-mail: guswo1104@naver.com

He is currently pursuing the Ph.D. degree in the Department of Mechanical Engineering, Kumoh National Institute of Technology. His research interest is robotics.

E-mail: qkrgusqls500@gmail.com

Principal Researcher & Director with the Korea Institute of Robots & Convergence. His research interest is robot motion control, disaster robotics, and factory automation

E-mail: mulimkim@kiro.re.kr

Professor in the Department of Mechanical System Engineering, Kumoh National Institute of Technology. His research interests include robotics, mechatronics, and intelligent control and reinforcement learning.

E-mail: bschu@kumoh.ac.kr