유화 분석을 위한 현미경 이미지의 다중 초점 기법 연구

Copyright © The Korean Society for Precision Engineering

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License (http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

Abstract

During digital microscopy of an oil painting surface it is inconvenient to analyze an entire image due to multiple defocused areas. The defocusing is usually caused by the small depth of the lens and the rough surface curve. Thus, these microscopic images in an oil painting have multiple focal points, which indicates multi-focus images. We present a multi-focus fusion synthesizing a focused image from scans based on focal direction and selection of focused places. Based on microscopic characteristics, a common scanned area of the images was defined to unify the lens multiplication. A focus index was applied to each pixel to identify well-focused pixels and generate a mapping image in the focal direction. Subsequently, a median filter was applied to the mapping image and a multifocal image was acquired based on actual pixel values obtained from the mapping image. The proposed method was utilized in analyzing oil painting samples carrying rough surface curves. The multifocal image facilitated the analysis of the oil painting surface and resulted in enhanced quality compared with other methods. The proposed method can be used to generate useful images in scientific and industrial microscopy.

Keywords:

Multi-focus, Image fusion, Microscopy, Digital focus index, Lens depth키워드:

다중 초점, 영상 합성, 현미경 검사, 디지털 초점 지수, 렌즈 심도1. 서론

미국과 유럽 등 서구권에서는 미술품 분석에 첨단 정밀 장비를 활용하고 있으며, 일부 국가에서는 미술품 거래 시 진위 여부를 판별하는 증명이 필요한 경우도 있다[1]. 최근에는 미술품에 대한 가상 자산 시장의 활성화에 따라 미술품의 과학적 분석과 정밀 측정의 중요성이 높아지고 있다[2]. 서구권의 미술품 중에서 유화의 비중은 매우 높은 편이며, 대중적 인지도가 높은 명화들도 과학적인 방법으로 분석한 사례도 많다. 네델란드의 대표적 화가 베르메르의 작품에 X선 회절 분석 기법을 적용하여 성분 분석을 수행하였고, 단면 영상을 획득한 사례가 있다[3]. 노르웨이의 화가 뭉크의 작품을 초분광 이미징 기법으로 분석하여 복원의 기초 자료로 활용한 사례도 있다[4]. 피카소의 작품을 중적외선 분광법으로 분석하여 물감의 분포를 가시화한 사례도 있다[5]. 이와 같이 유화의 경우 분석에는 X선, 적외선 및 가시광 등을 활용한 광학적 비파괴 방식이 선호된다.

유화의 분석 및 진위 감정에서는 현재까지도 현미경 영상을 대부분 활용하고 있다. 주로 유화 작품에서 나온 물감 시편에 다양한 조명을 조사하여 획득한 현미경 영상으로부터 안료의 종류를 판별한다[6]. 또한, 현미경 영상은 작품의 수정 여부, 작가의 특성, 재료의 발명 시기 및 색상의 변화 등의 관찰에도 사용된다[7]. 보다 정확한 관찰을 위하여 자외선, 편광 및 FTIR 등을 사용하기도 하고, 시편을 가열하여 융해 특성을 관찰하기도 한다[8]. 한편, 유화 시편의 현미경 영상에서는 초점에서 벗어난 영역이 다수 관찰되므로, 분석 작업이 다소 불편해지게 된다. 원인으로는 유화 시편의 굴곡 대비 현미경 렌즈의 심도가 작기 때문이다. 따라서, 유화 감정에서는 현미경 영상 전체가 초점이 맞는 기술에 대한 필요성이 제기되어 왔다.

서로 다른 초점이 생성되는 다수의 영상을 하나의 초점 영상으로 합성하는 다중 초점 영상 합성(Multi-focus Image Fusion)은 변환법(Transform), 공간법(Spatial Domain), 연합법 및 인공지능법 등이 제안되었다[9]. 변환법은 웨이블릿(Wavelet) 및 이산 코사인 변환 등 수학적 변환을 이용하여 초점이 형성되는 부분을 선택한다[10,11]. 공간법은 이미지를 분할하고, 각 분할 공간마다 초점 지수를 평가하여 초점 가능성이 높은 부분들로 이미지를 구성하는 방법이다[12]. 연합법은 변환법과 공간법을 같이 적용하는 방법이다[13]. 인공지능법은 심층학습(Deep Learning)을 이용하여 초점이 형성되는 부분을 선택 및 합성하는 방법이다[14,15]. 기존의 방법들은 피사체로부터 멀리 떨어진 2-4장의 이미지를 합성하여 하나의 초점 영상을 합성하는 방법이 대다수이다. 반면에 현미경의 경우 초점 거리 조정에 따라 촬영되는 영역(Field of View, FOV)이 변하고, 렌즈의 심도(Depth of Field, DOF)도 매우 작아 촬영하는 영상의 수도 훨씬 많다. 따라서, 기존의 방법을 그대로 적용하기 어렵고 이미지 수의 증가에 따른 연산량도 고려해야 한다. 본 연구에서는 유화 등의 굴곡있는 표면을 관찰하는 경우 현미경 이미지를 활용하는 다중초점 영상 합성 방법에 대하여 논하고자 한다.

본 연구에서는 다중 초점 영상 합성 방법은 기존 공간법을 기반으로 FOV의 변화와 민감한 DOF의 영향을 고려한 방법을 제안하였다. 연산량을 줄이기 위하여 비교적 연산량이 적은 구배(Gradient) 기반의 변환법을 적용하였다[12,16]. 변환법 적용 시영상을 분할하지 않고, 구배 연산자의 크기를 조정하였다. 그리고, 3D 표면의 연속성을 고려하여 합성된 3차원 구성도(Map)에 저주파 필터링을 적용하였다. 제안 방법은 초점 방향 영상 스캔, 영상 배율 조정, 초점 지수 연산, 최대 초점 지수로 구성도 작성, 저주파 필터링 및 구성도-픽셀 조합에 의한 초점 영상 합성으로 구성되어 있다. 본 연구는 2장에서는 이론, 3장에서는 실험, 4장에서는 결과 및 분석, 그리고 5장 결론으로 구성되어 있다.

2. 이론

2.1 현미경 영상 스캐닝

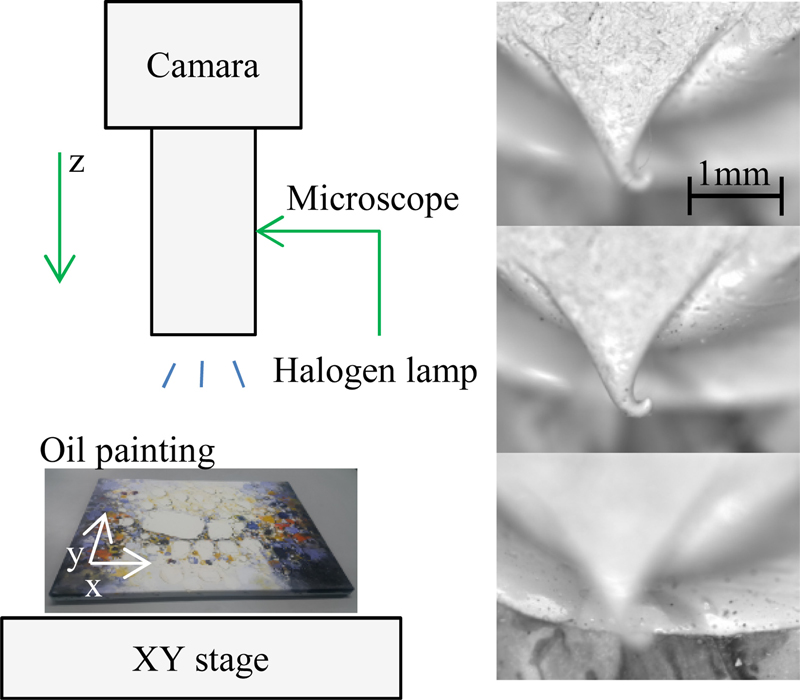

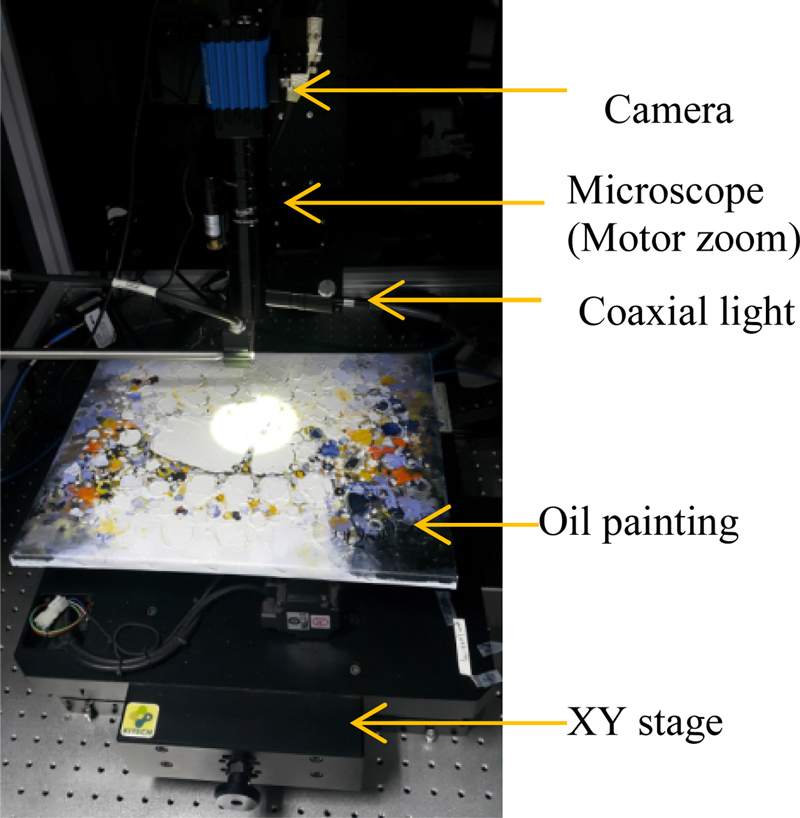

현미경 영상 획득 시스템은 Fig. 1과 같이 카메라, 현미경, 동축 조명 및 XYZ 스테이지로 구성하였다. 유화는 XY 스테이지에 적재하고 현미경 관찰 위치로 이동한다. 조명 광원은 할로겐을 사용하였으며, 발생하는 광량을 카메라 영상의 밝기와 비교하여 적절하게 조정할 수 있다. 광원에서 발생하는 백색광을 광섬유를 이용하여 현미경 측면으로 입력한 후, 전면에 퍼지도록 동축 조명 구조를 적용하였다. 렌즈는 전동 줌(Zoom) 타입으로 관측 영역의 사이즈를 고려하여 PC에서 배율을 조정할 수 있다. Z축 스테이지는 카메라를 유화에 대한 초점 방향으로 이송한다. 스캐닝 시 영상의 일부에서 초점이 형성되기 시작하는 위치까지 초점 방향으로 카메라를 이송한다. 초점이 형성되는 마지막 위치까지 이동하며 일정 간격으로 영상을 촬영하면 Fig. 1의 우측과 같이 여러 장의 원본 영상(I1, ..., In)을 얻을 수 있다. 원본 영상을 관찰하면 유화의 굴곡에 따라 초점이 서로 다르게 형성되고, 관측 영역도 변함을 알 수 있다.

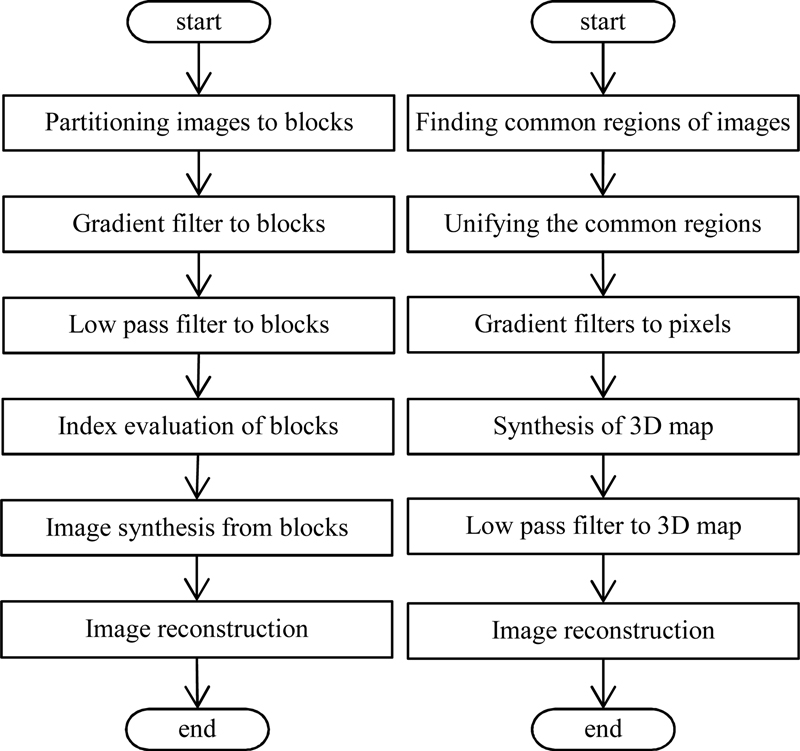

한편, 현미경 스캐닝 영상의 경우 렌즈와 관측 부위의 거리변화로 인하여 FOV가 변하게 되므로, 다중 초점 연산을 위하여 보정을 해야 한다. 획득된 영상들에서 공통된 부분들을 추출하고, 크기를 조정함으로써 광학적인 원인으로 인한 변화를 보정할 수 있다. 그리고, 섬세한 이미지를 얻기 위하여 영상을 분할하지 않고, 각 픽셀에 대하여 구배 연산 필터 사이즈를 조정한다. 일반적인 3차원 표면의 연속성을 가정하여 3차원 구성도에 저주파 필터(Low Pass Filter)를 적용하고, 다중 초점 영상을 획득한다. 기존 변환 기반의 다중 초점 연산과 제안 방법을 Fig. 2에 비교하여 도시하였다.

영상의 초점 지수 F는 여러 방법으로 연산할 수 있으나, 본 연구에서는 다음과 같이 소벨(Sobel) 기반의 Tenenbaum 연산자를 적용하였다[17-19].

| (1) |

| (2) |

(I1 … In)의 원본 영상에서 전체적으로 가장 초점이 잘 맞는 영상 If는 초점 지수 F가 가장 큰 것을 선택한다.

| (3) |

2.2 원본 영상 배율 균일화

스캐닝 시 카메라가 높은 곳에서 낮은 곳으로 이동한다면 원본 영상 중에서 가장 I1먼 이 관측 영역이 가장 넓고, 가장 가까운 In은 가장 좁다. 따라서, 스캐닝 영상에서 공통 영역 Ic는 In을 적절하게 Size 조절을 하여 If내에서 검색하여 If의 부분 영상으로 결정한다. 검색은 α 배율로 Resize된 I’n영상과 If내의 부분 영상의 상관 함수로 구할 수 있다.

| (4) |

| (5) |

공통 영역 Ic는 If의 부분 이미지로, 식(5)에서 구해진 시작점과 배율로 관심영역 ROI를 설정하여 구한다. 그리고, Ic를 스캐닝 이미지에 적용하여 배율과 상관없는 공통 영역에 대한 영상을 추출할 수 있다.

| (6) |

| (7) |

식(6) 및 식(7)에 의하여 각 영상에서 공통 영역 I”z는 I’z에 ROI를 설정하여 구하며, 배율과 관측 영역이 균일화된 영상이다.

2.3 다중 초점 영상 합성

| (8) |

| (9) |

초점 인덱스 연산 시 Sobel 연산자의 크기는 기본적으로 3 × 3이나, 실질적으로는 보다 큰 연산자를 적용하며, 이 경우 각 계수는 제안된 Sobel 연산 이론에 의하여 결정한다. Fig. 3은 Fig. 1의 현미경 영상에 Tenenbaum 연산자 적용 후 얻어진 이미지이다.

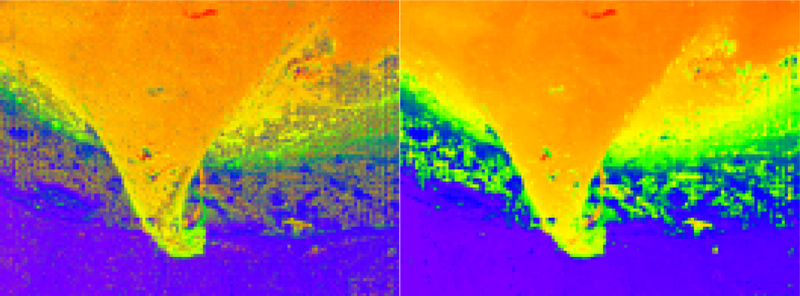

각 (x,y) 픽셀별로 z방향으로 초점 지수를 비교하면 최댓값을 알 수 있다. 최대 초점 지수의 위치를 로 정의하고 (x,y) 픽셀값으로 대응하면, Fig. 4와 같이 3차원 배치도 형태의 높이 영상을 얻을 수 있다.

| (10) |

일반적으로 Fig. 4의 왼쪽 이미지 같이 노이즈 패턴이 자주 관찰되나, 현실적으로 3차원 형상에서 나타날 확률은 낮다. 따라서, 저주파 필터나 중앙값 연산(Median Filter)을 적용하면 오른쪽 이미지같이 노이즈가 감소되는 것을 알 수 있다[20].

| (11) |

여기서 중앙값 연산자 크기는 기본적으로 3 × 3이나, 실질적으로는 보다 연산자의 크기를 확장하여 적용한다.

상기 수식을 으로 좌표화하고, 해당 위치의 I”z영상에서 대응되는 픽셀값을 가져오면 전체적으로 초점이 맞는 영상 Im이 구성된다.

| (12) |

3. 실험

실험 장치는 광대역(UV-Vis-NIR) 카메라, 전동 줌 렌즈, 할로겐 동축 조명, 4축 전동 스테이지로 구성되어 있으며 암실에 설치하였다. 실험 장치는 제어 컴퓨터(PC)로 연결하여 각 구성품들이 연동하여 동작할 수 있도록 제어 소프트웨어를 제작하였다. 유화는 XY 스테이지 상에 장착하여 카메라로 관찰하고자하는 영역으로 이동한다. 카메라는 Z스테이지에 고정되어 있으며, 이미지 센서 전면에 현미경을 부착하였다. 현미경은 전동으로 구동되는 줌 타입으로 제어 컴퓨터(PC)에서 배율을 조정할 수 있다. 실험에서 사용한 배율과 심도는 각각 2.16X 및 0.25 mm이다. 할로겐 램프에서 발생한 빛은 광섬유를 통과하여 현미경 측면으로 투입되어 카메라와 동축으로 조사되었다. 장비를 구동하는 소프트웨어는 C++ 기반의 Visual Studio로 제작하였다. 다중 초점 영상 합성 알고리즘은 오픈 소스인 OpenCV를 활용하여 C++ 기반으로 개발하였다. Fig. 5는 스캐닝 시스템을 보여주고 있으며, 사양은 Table 1과 같다.

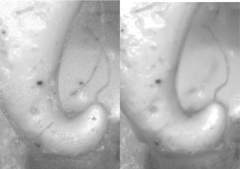

다중 초점 영상 합성 방법을 테스트하기 위하여 Fig. 6과 같이 유화 샘플에서 굴곡이 심한 부분 2곳을 선택하였다. 좌측은 물감이 화산 형상으로 형성되어 있고, 끝 부분에 물감이 예리하게 떨어져 있어서 3차원 측정이 어려운 형상을 보여주고 있다. 우측은 물감이 벌레 모양으로 길게 형성되어 있으며, 복잡한 형상으로 요철이 형성되어 있다. 이러한 두 가지 형상에 대하여 스캐닝하고 이미지를 2.1절 및 2.2절과 같이 보정한 후, 기존 방법과 제안 방법을 적용해 보았다.

일반적으로 영상 평가하는 방법은 첨두 신호대 잡음비(PSNR), 평균 절대 오차(MAE) 및 구조적 유사도(SSIM) 등 원본 영상과 비교하여 지수를 산출한다[21,22]. 그러나, 본 연구에서는 기준이 되는 원본 영상이 존재하지 않으므로, 영상 자체에서 산출할 수 있는 지수를 선택하였다. 영상 품질 평가 관련 연구에서 초점 지수와 영상 품질을 공유하여 측정할 수 있는 지수를 적용하였다[23,24]. 다음 수식과 같이 분산(Variance) 및 엔트로피(Entropy)를 영상 품질 평가에 적용하였다[25,26]. 엔트로피의 경우 이미지 히스토그램의 상대 분포값을 정규화하여 입력으로 사용한다.

| (13) |

| (14) |

4. 결과 및 고찰

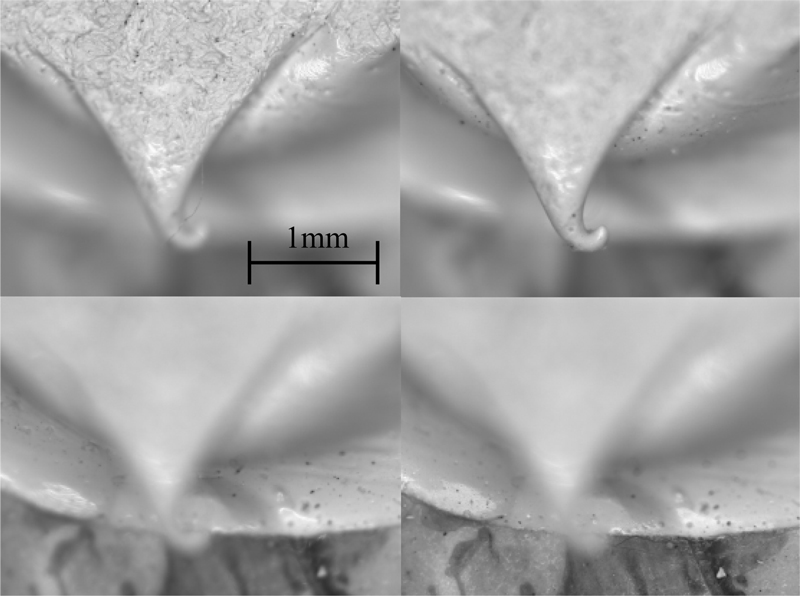

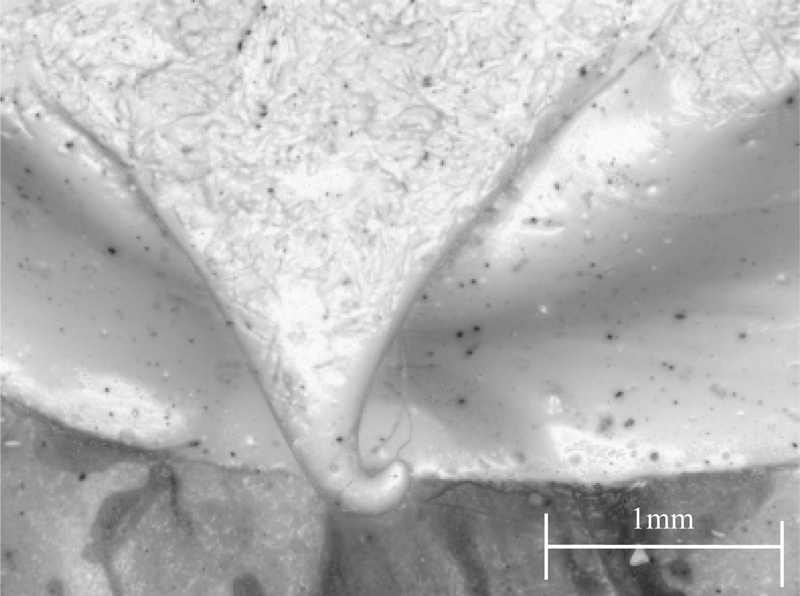

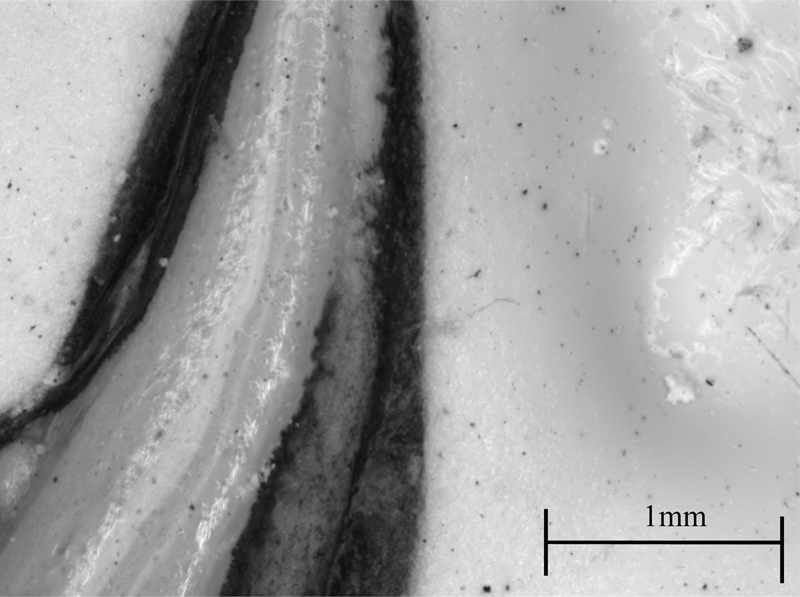

Fig. 6의 좌측 형상을 z방향으로 스캔하여 105개의 영상을 획득하였다. 물감이 늘어나 떨어지는 부분이며, 상하 단차가 있어서 중간에 절벽이 형성되어 있다. 3차원 구성도를 얻기 위하여 각 픽셀에 적용한 Sobel 연산자 크기는 3 × 3였다. 3차원 구성도를 매끈하게 다듬을 중앙값 필터 크기는 6 × 6을 적용하였다. Fig. 7은 현미경에서 얻어진 영상들의 일부인데, 초점은 일부에서 형성되고, 초점이 맞지 않는 영역의 비중이 높음을 알 수 있다. 획득한 영상들에 제안 방법을 적용한 3차원 구성도는 Fig. 8과 같다. 중간을 가로지르는 벨트 모양의 노이즈 패턴을 제외하면 전체적은 형태는 실제 형상과 유사하다. 3차원 구성도를 기반으로 다중 초점 영상을 합성한 결과는 Fig. 9와 같다. Fig. 8의 3차원 구성도에서 관찰되는 노이즈 패턴에도 불구하고 선명한 영상이 얻어졌다. Fig. 6 좌측 이미지와 비교하면 영상이 일치함을 알 수 있다. Fig. 7에서 보면 심한 초점 이탈이 발생하는 부분들이 각 영상 별로 높은 비중으로 발생하였다. 그러나, 합성된 영상에서는 모두 초점이 형성되어 있다. 또한, 물감이 떨어지는 끝 부분은 예리하긴 하지만 합성된 영상에서 부드럽게 관찰되었고, 끝 부분에 달려있는 섬유질 형상도 선명하게 보여주고 있다.

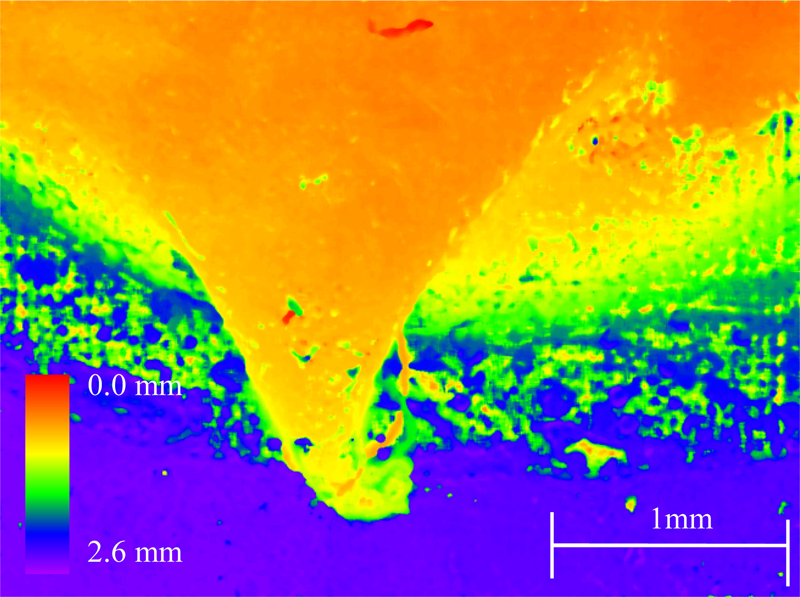

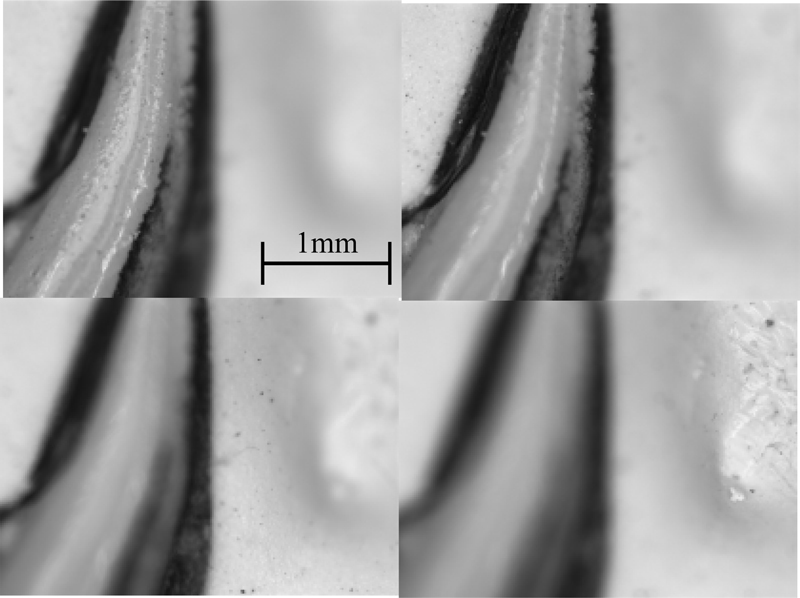

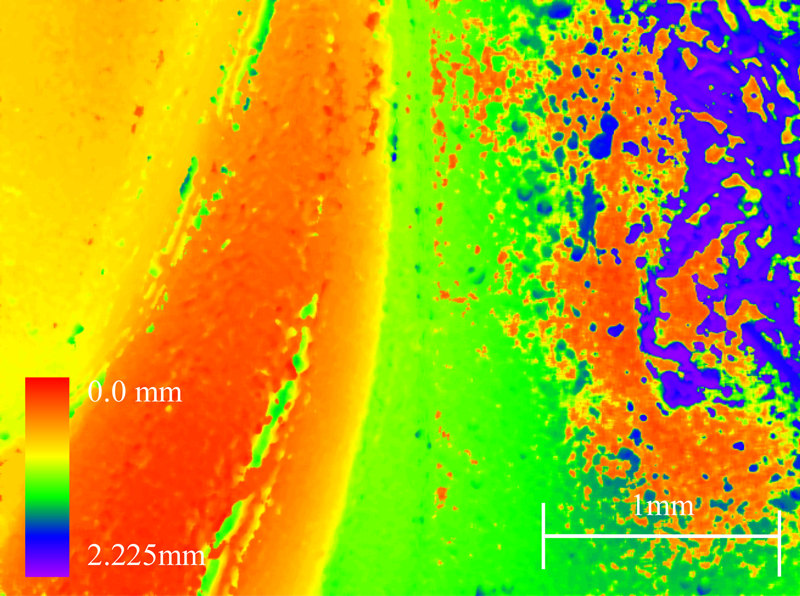

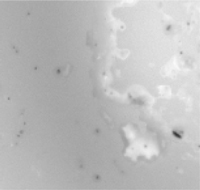

Fig. 10은 Fig. 6의 우측 패턴을 스캔한 영상 샘플이며 총 90장을 촬영하였다. 물감을 산맥같이 길게 늘어트린 형상으로 물감 부분이 높고, 주면이 낮게 구성되어 있다. 이전 경우와 같이 Sobel 연산 사이즈는 3 × 3이며, 중앙값 필터의 크기는 6 × 6을 적용하였다. 돌출부의 변화가 심하여 초점이 벗어나는 부분이 많으며 관찰 시 높낮이로 혼란 발생이 쉬운 형상이다. Fig. 11은 다중 초점 영상 합성 방법을 적영하여 얻어진 3차원 구성도이다. 물감이 지나는 부위가 적색으로 표시되었고, 주변부가 황색, 녹색, 청색, 보라색으로 표시되었다. 우측에 보라색으로 표시된 낮은 부분에는 붉은색으로 표시된 높은 부분과 혼합되어 있다. 연속적인 3차원 형상을 고려하면 현실에서는 발생하기 어려운 형상이다. 그러나, 다중 초점 영상 합성 결과 Fig. 12에서는 선명한 영상이 얻어지므로, 3차원 구성도에서 보이는 노이즈의 영향이 적은 것으로 보인다. Fig. 6 우측 이미지와 비교하면 영상이 일치함을 알 수 있다.

Fig. 9와 Fig. 12를 살펴보면, 본 연구에서 제안한 다중 초점 방법은 육안으로 보기에는 편한 영상을 제공한다는 것을 알 수 있다. Fig. 7과 Fig. 10의 현미경 원본 영상은 초점이 이탈한 부분이 많아 부분 관찰만 가능하여 불편한 점이 있다. 그러나, 다중 초점 영상은 전체적인 모습을 알 수 있어서 유화 표면 관찰에 매우 유리하다. 그러나, Fig. 8과 Fig. 11을 보면 3차원 구성도에서 노이즈 패턴과 불연속면이 혼재되어 있다는 사실을 고려하면, 높이 정보는 참고 용도라는 것을 알 수 있다. 원인으로는 스캐닝 시 현미경이 관측영역에 접근하면서 3차원 표면과 렌즈의 관측 각도가 변하는 것을 들 수 있다. 즉, 특정 3차원 표면 위치가 대응되는 픽셀은 영상마다 미세하게 이동할 수 있다. 그리고, 스캐닝 시 조명이 현미경에 부착되어 있어서 동시에 이동하므로 복잡한 3차원 형상에 의하여 반사각이 예측하기 어렵게 변하는 것도 생각할 수 있다. 변화하는 반사각에 의하여 포착되는 영상에 Tenenbaum 연산을 수행하면 임의의 고주파 성분이 검출되는데, 3차원적인 정확도를 보장하기는 어렵다. 조명의 위치 변화에 따라 유화 표면의 광택에 의하여 영상의 픽셀에 포화(Saturation)가 발생하는 것도 원인으로 들 수 있다. 픽셀에 포화가 발생하면 포화값 이상의 데이터를 얻을 수 없으므로 변별력이 감소하게 된다. 또한, 제안한 방법은 다수의 필터를 적용하고 있으므로 연산에 의한 누적 오차가 발생할 수 있다.

Table 2는 기존에 제안된 이산 코사인 변환 방법[12] 및 영상인덱스만 사용한 방법[16]과 비교한 결과이다. 영상 품질을 표시하는 σv는 영상 분산이며, σe은 영상 엔트로피 이다. 도표에서 각 그림들은 다중 초점 영상으로 합성 시 최적화된 이미지 필터를 적용하여 얻어진 선별된 영상의 부분이다. Sobel 연산자 및 중앙값 필터 크기 fs를 적절하게 조절하여 최적화된 영상을 얻는다. 전반적으로 선명한 이미지가 얻어지나, 각 영상에서 민감하게 반응하는 부분을 확대하여 도표에 첨부하였다.

1번 샘플은 Fig. 6의 좌측의 형상으로 점도가 높은 물감이 늘어나면서 끊어지는 현상을 보여준다. 기존의 방법들은 경계면 상에서 픽셀이 뭉치거나 경계면이 거칠거나 White Noise가 발생하였다. 제안된 방법의 경우 기존보다 자연스러운 영상이 얻어졌다. 영상의 품질을 비교해보면, 제안한 방법이 작은 필터 크기를 적용하고도 전반적으로 우수하게 나타났다. 물감이 끊어지는 부분은 바닥면과 단차가 있어서 일반적인 3차원 측정 방법으로 획득하기 어려운 형상인데, 제안 방법에서는 깨끗한 영상이 합성되었다.

Fig. 6의 우측에 보이는 2번 샘플의 경우는 이산 코사인 변환방법(DCT)에서는 픽셀의 뭉침이 관찰되었으나, Hwang의 방법과 제안 방법으로 자연스러운 영상이 합성되었다. Table 2의 2번 샘플을 보면 DCT 방법의 경우 사각형의 픽셀 뭉침이 이미지 전반에 걸쳐 높은 빈도로 나타났다. 그러나, Hwang의 방법의 경우 제시한 이미지 부근만 뭉침이 보이고, 다중 초점 영상이 전반적으로 자연스럽게 보였다. 영상 품질의 경우 제안 방법이 작은 필터 크기로도 다소 우수한 수치를 보이는 것을 확인하였다.

이와 같은 결과를 종합하면, 제안한 방법은 유화 등 굴곡이 있는 3차원 표면을 현미경으로 편리하게 관찰할 수 있는 기능을 제공해 준다는 것을 알 수 있다. 현미경 스캐닝과 렌즈의 특성으로 인하여 관측 영역 변화와 좁은 심도로 발생하는 영상의 변화를 보정하면, 기존의 방법도 활용할 수 있다. 다중 초점 영상의 품질은 기존 방법보다 다소 우수하며, 특히 기존 연구보다 휠씬 많은 이미지를 기반으로 합성할 수 있음을 보였다. 다만, 현미경의 이동에 따른 관측 각도, 조명 각도 및 표면 반사 부위의 변화에 의하여 실제 3차원 형상과 오차가 발생할 수 있다. 합성된 다중 초점 영상은 표면을 관찰 시 편리한 기능이나, 3차원 구조도는 실제 표면과 다소 차이가 있으므로 참고 사항으로 활용하여야 한다.

5. 결론

일반적으로 현미경의 심도보다 유화의 3차원 굴곡이 심하므로 영상의 초점이 벗어나 관찰에 불편함이 많다. 따라서, 본 연구에서는 현미경으로 유화를 관찰하는 경우 스캐닝한 다수의 영상을 활용하여 초점이 맞는 다중 초점 영상을 합성하는 방법을 제안하였다. 제안한 다중 초점 영상 합성 방법은 영상 취득과 합성으로 나누어진다. 영상 취득은 초점 방향으로 영상을 스캐닝하고, 영상 간 공통 영역을 균일한 배율로 추출하는 과정이다. 영상 합성은 추출된 영상에서 영상 인덱스가 높은 픽셀을 선별하고, 초점 방향의 3차원 구성도를 작성하고, 저주파 필터를 적용한 후, 대응되는 픽셀 값을 적용하여 최종적으로 초점이 맞는 영상을 얻는 과정이다.

제안한 방법은 기존 방법과 비교하면 픽셀의 뭉침이나 노이즈가 적었고, 보다 자연스러운 영상이 얻어졌다. 제안한 방법은 유화뿐만 아니라 3차원 물체를 현미경으로 관찰하는 과학 장비 및 산업 장비에도 적용할 수 있다.

NOMENCLATURE

| α : | Image Resize Ratio |

| α* : | Specified Image Resize Ratio |

| F : | Focus Index of Source Images |

| F″z : | Focus Index of Images of Common Area |

| Ic : | Local Image of Common Area |

| If : | Well-focused Image in Source Images |

| Im : | Multi-focus Image after Image Fusion |

| Iz : | Source Images |

| I′z : | Resized Images |

| I″z : | Images of Common Area in Source Images |

| n : | The Number of Images |

| Sx : | Image after Horizontal Sobel Operation |

| Sy : | Image after Vertical Sobel Operation |

| S″x : | Images of Common Area in Source Images after Sobel Operation |

| S″y : | Images of Common Area in Source Images after Sobel Operation |

| x : | Horizontal Position in an Image |

| x* : | Specified Horizontal Position in an Image |

| y : | Vertical Position in an Image |

| y* : | Specified Horizontal Position in an Image |

| z : | Camera Position in Focal Direction |

| : | Position of Maximum Image Index in Source Images |

| : | Filtered Position of Maximum Image Index in Source Images |

Acknowledgments

This paper was presented at KSPE Autumn Conference 2022

본 연구는 문화체육관광부 및 한국콘텐츠진흥원의 2022년도 문화기술 연구개발 사업으로 수행되었음(No. R2020060004, 근현대 미술품들의 디지털 데이터 확보 및 과학기반 미술품 신뢰도 분석 지원 시스템 개발).

REFERENCES

- Rim, S. R., Byun, S. H., (2020), A study on the new scheme for South Korea’s artwork authenticity with a review of the overseas art distribution dispute setting system, Journal of Arbitration Studies, 30(1), 199-215.

-

Vasan, K., Janosov, M., Barabási, A.-L., (2022), Quantifying NFT-driven networks in crypto art, Scientific Reports, 12(1), 1-11.

[https://doi.org/10.1038/s41598-022-05146-6]

-

De Meyer, S., Vanmeert, F., Vertongen, R., van Loon, A., Gonzalez, V., van der Snickt, G., Vandivere, A., Janssens, K., (2019), Imaging secondary reaction products at the surface of Vermeer’s girl with the pearl earring by means of macroscopic X-ray powder diffraction scanning, Heritage Science, 7, 1-11.

[https://doi.org/10.1186/s40494-019-0309-3]

-

Cutajar, J. D., Babini, A., Deborah, H., Hardeberg, J. Y., Joseph, E., Frøysaker, T., (2022), Hyperspectral imaging analyses of cleaning tests on edvard munch's monumental aula paintings, Studies in Conservation, 67(1), 59-68.

[https://doi.org/10.1080/00393630.2022.2054617]

-

Delaney, J. K., Thoury, M., Zeibel, J. G., Ricciardi, P., Morales, K. M., Dooley, K. A., (2016), Visible and infrared imaging spectroscopy of paintings and improved reflectography, Heritage Science, 4, 6.

[https://doi.org/10.1186/s40494-016-0075-4]

-

Dredge, P., Wuhrer, R., Phillips, M. R., (2003), Monet’s painting under the microscope, Microscopy and Microanalysis, 9(2), 139-143.

[https://doi.org/10.1017/S1431927603030198]

-

Townsend, J. H., Keune, K., (2006), Microscopical techniques applied to traditional paintings, Infocus Magazine, 41(1), 54-65.

[https://doi.org/10.22443/rms.inf.1.2]

-

Macchia, A., Biribicchi, C., Carnazza, P., Montorsi, S., Sangiorgi, N., Demasi, G., Prestileo, F., Cerafogli, E., Colasanti, I. A., Aureli, H., (2022), Multi-analytical investigation of the oil painting “Il Venditore di Cerini” by antonio mancini and definition of the best green cleaning treatment, Sustainability, 14(7), 3972.

[https://doi.org/10.3390/su14073972]

-

Liu, Y., Wang, L., Cheng, J., Li, C., Chen, X., (2020), Multi-focus image fusion: A survey of the state of the art, Information Fusion, 64, 71-91.

[https://doi.org/10.1016/j.inffus.2020.06.013]

-

Aymaz, S., Köse, C., (2019), A novel image decomposition-based hybrid technique with super-resolution method for multi-focus image fusion, Information Fusion, 45, 113-127.

[https://doi.org/10.1016/j.inffus.2018.01.015]

-

Cao, L., Jin, L., Tao, H., Li, G., Zhuang, Z., Zhang, Y., (2014), Multi-focus image fusion based on spatial frequency in discrete cosine transform domain, IEEE Signal Processing Letters, 22(2), 220-224.

[https://doi.org/10.1109/LSP.2014.2354534]

-

Huang, W., Jing, Z., (2007), Evaluation of focus measures in multi-focus image fusion, Pattern Recognition Letters, 28(4), 493-500.

[https://doi.org/10.1016/j.patrec.2006.09.005]

-

Yang, Y., Zhang, Y., Wu, J., Li, L., Huang, S., (2019), Multi-focus image fusion based on a non-fixed-base dictionary and multi-measure optimization, IEEE Access, 7, 46376-46388.

[https://doi.org/10.1109/ACCESS.2019.2908978]

-

Liu, Y., Chen, X., Peng, H., Wang, Z., (2017), Multi-focus image fusion with a deep convolutional neural network, Information Fusion, 36, 191-207.

[https://doi.org/10.1016/j.inffus.2016.12.001]

-

Guo, X., Nie, R., Cao, J., Zhou, D., Mei, L., He, K., (2019), FuseGAN: Learning to fuse multi-focus image via conditional generative adversarial network, IEEE Transactions on Multimedia, 21(8), 1982-1996.

[https://doi.org/10.1109/TMM.2019.2895292]

-

Haghighat, M. B. A., Aghagolzadeh, A., Seyedarabi, H., (2011), Multi-focus image fusion for visual sensor networks in DCT domain, Computers & Electrical Engineering, 37(5), 789-797.

[https://doi.org/10.1016/j.compeleceng.2011.04.016]

-

Azouz, A. A. E., Li, Z., (2015), Improved phase gradient autofocus algorithm based on segments of variable lengths and minimum-entropy phase correction, IET Radar, Sonar & Navigation, 9(4), 467-479.

[https://doi.org/10.1049/iet-rsn.2014.0201]

-

Lee, H., Jung, C.-S., Kim, K.-W., (2021), Feature preserving autofocus algorithm for phase error correction of SAR images, Sensors, 21(7), 2370.

[https://doi.org/10.3390/s21072370]

-

Kim, H., Moon, Y. J., Kang, H., Hwang, J. Y., (2020), On-machine measurement for surface flatness of transparent and thin film in laser ablation process, Coatings, 10(9), 885.

[https://doi.org/10.3390/coatings10090885]

-

Lee, Y., (2022), Performance analysis of improved hybrid median filter applied to X-ray computed tomography images obtained with high-resolution photon-counting CZT detector: A pilot study, Nuclear Engineering and Technology, 54(9), 3380-3389.

[https://doi.org/10.1016/j.net.2022.03.025]

-

Yadav, G., Yadav, D. K., Mouli, P. C., (2022), Statistical measures for palmprint image enhancement, Machine Learning for Biometrics, 65-85.

[https://doi.org/10.1016/B978-0-323-85209-8.00010-9]

-

Bull, D., Zhang, F., (2021), Measuring and managing picture quality, Intelligent Image and Video Compression, 335-384.

[https://doi.org/10.1016/B978-0-12-820353-8.00019-0]

-

Gabarda, S., Cristóbal, G., (2007), Blind image quality assessment through anisotropy, JOSA A, 24(12), B42-B51.

[https://doi.org/10.1364/JOSAA.24.000B42]

-

Ferzli, R., Karam, L. J., (2009), A no-reference objective image sharpness metric based on the notion of just noticeable blur (JNB), IEEE Transactions on Image Processing, 18(4), 717-728.

[https://doi.org/10.1109/TIP.2008.2011760]

-

Sun, Y., Duthaler, S., Nelson, B. J., (2004), Autofocusing in computer microscopy: Selecting the optimal focus algorithm, Microscopy Research and Technique, 65(3), 139-149.

[https://doi.org/10.1002/jemt.20118]

-

Chen, X., Zhang, Q., Lin, M., Yang, G., He, C., (2019), No-reference color image quality assessment: From entropy to perceptual quality, EURASIP Journal on Image and Video Processing, 2019(1), 1-14.

[https://doi.org/10.1186/s13640-019-0479-7]

Principal researcher in the Department of Digital Transformation of Korea Institute of Industrial Technology. His research interest is machine vision and image processing.

E-mail: htkim@kitech.re.kr

Senior researcher in the AI Robot R&D Departnemt of Korea Institute of Industrial Technology. His research interest is android robots and deep learning.

E-mail: proldy@kitech.re.kr

Senior researcher in the AI Robot R&D Departnemt of Korea Institute of Industrial Technology. His research interest is mechanical design and android robots.

E-mail: cdw@kitech.re.kr

Senior researcher in the AI Robot R&D Departnemt of Korea Institute of Industrial Technology. His research interest is sensor calibration and robot localization.

E-mail: jkang@kitech.re.kr

Principal researcher the AI Robot R&D Departnemt of Korea Institute of Industrial Technology. His research interest is android robot and social human-robot interaction.

E-mail: dwlee@kitech.re.kr