협소 공간 탐색을 위한 뱀형 로봇의 다중 센서 모듈 설계 및 운용

Copyright © The Korean Society for Precision Engineering

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License (http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

Abstract

In this study, a module combining various types of sensors was developed to increase search efficiency inside collapsed buildings. It was designed to be less than 70 mm in diameter so that it can be put into narrow spaces, and is equipped with a small & high-performance processor to process multiple sensor data. To increase sensor data processing efficiency, multi thread based software was configured, and the images were combined and transmitted to ensure time synchronization of multi-channel video data. A human detection function based on sound source detection using two microphones was implemented. The developed multi-sensor module was tested for operation by mounting it on a snake-type robot in a test bed simulating a disaster site. It was confirmed that the visible range of the robot to which the multi-sensor module was applied was expanded, and the ability to detect human and low-light human detect was secured.

Keywords:

Multi-sensor module, Snake robot, Disaster response robot, Narrow space키워드:

다중 센서 모듈, 뱀형 로봇, 재난대응로봇, 협소 공간1. 서론

최근 태풍, 폭설과 같은 자연재해나 테러, 부실시공 등으로 인해 건물 붕괴와 같은 재난 사고가 많이 발생하고 있다. 이러한 재난 환경에서 사람이 수행하는 특수한 업무를 대행하기 위한 로봇연구들이 다수 진행되고 있다[1-4]. 특히, 재난 사고 발생 후 골든타임(72시간 이내)에 인명 구조에 대한 요구가 많아지고 있다. 외부에서 음파 탐지를 통하여 생존자의 위치를 조속히 탐색하는 시도를 하고 있으나 생존자의 정확한 위치와 상태를 확인하기 어려운 상황이다[5]. 또한 탐사봉(Search Tab)을 활용한 협소 공간 탐색과 후각·청각이 발달한 동물을 이용한 열린 공간 탐색 등의 기존 탐색 방법으로는 제한된 범위에서의 구조 활동만을 수행할 수 있어 생존자를 찾는데 효율이 떨어진다. 이를 위해 생물체의 진보된 특성을 모방한 로봇 연구들이 진행되고 있다[3,4,6].

생체 모방 로봇 중 뱀형 로봇은 불규칙한 바닥 또는 장애물이 많은 지형을 극복할 수 있으며, 몸체의 무게를 다양한 형태로 분산시킬 수 있도록 다관절 형태로 구성되어 있어 기둥 또는 굴곡진 배관 내부에서도 이동할 수 있다[7,8]. 이러한 환경에서 다수의 관절로 구성된 자유도가 높은 뱀형 로봇을 활용하기 위해 기구학, 동역학 해석을 통한 다양한 연구가 진행되어 왔다[9-12]. 그 중, 2017년 10월 발생한 멕시코 지진에 CMU (Carnegie Mellon University)에서 개발한 뱀형 로봇이 실제 붕괴 건물에 투입된 사례가 있다. 이 연구에 따르면 뱀형 로봇의 머리에 카메라만 달려 있고, 마이크로폰, 스피커, 열화상 카메라, 가스 센서 등이 없는 탓에 생존자 탐지가 어렵고 조작이 불편한 문제가 제기되었다[13].

재난현장 복구 분야에서는 현장에서 특수목적 기계를 조종하는 원격 조종자의 제한된 상황 인지 능력 향상에 대한 필요성을 제기하고 이를 해결하기 위해 복합 센서를 활용한 지형/장애물 인식 기술에 관한 연구가 수행되었다[14,15]. 해당 연구는 고성능 센서들로 구성하여 조종자의 로봇 주변 상황 인지능력을 향상하였지만, 소형화가 되지 않아 협소 공간 탐색에는 불리하다.

본 연구에서는 재난 환경에서의 탐색 효율 증대를 위해 다종의 센서를 융합한 모듈을 개발하였다. 본 논문은 다음과 같은 기여를 가진다.

1) 개발한 다중 센서 모듈은 RGB 카메라, 열화상 카메라, 마이크, 가스 센서, IMU (Inertial Measurement Unit)가 탑재되고, LED (Light Emitting Diode) 조명, 적외선 패턴 프로젝터, 스피커를 추가 탑재하였다.

2) 탑재된 센서를 제어하고, 원활한 통신을 구성하기 위해 새로운 인터페이스 보드를 설계하였다. 이 인터페이스 보드를 통해 센서 데이터를 취득 및 가공하여 로봇 조종기로 전송될 수 있도록 통신을 구성하였다.

3) 인명 탐지 활동을 보조하기 위해 복수의 카메라를 이용한 파노라마 뷰 생성을 한다. 파노라마 뷰 생성을 위해 영상 간 시간 오차를 최소화하여 전달하는 방법을 고안하였다.

4) 마이크를 이용한 TDOA (Time Difference of Arrival) 기반 GCC-PHAT (Generalized Cross Correlation Phase Transform)를 활용한 음원 추정 알고리즘을 구현하여 생존자를 탐색할 수 있는 기능을 탑재하였다.

5) 제안하는 방법은 실제 하드웨어를 제작하여 재난 환경 테스트베드에서 실험을 통해 다중 센서 모듈의 유효성을 검증한다.

본 논문의 구성은 다음과 같다. 2장에서는 뱀형 로봇의 구조와 머리 모듈 설계에 대해 설명한다. 3장에서는 다중 센서 모듈제어를 위한 소프트웨어에 관해 설명한다. 4장에서는 개발한 다중 센서 모듈을 뱀형 로봇에 탑재하여 실재 환경을 모사한 테스트베드에서 탐색 기능 실험 결과를 제시한다.

2. 다중 센서 모듈 개발

2.1 뱀형 로봇의 구조

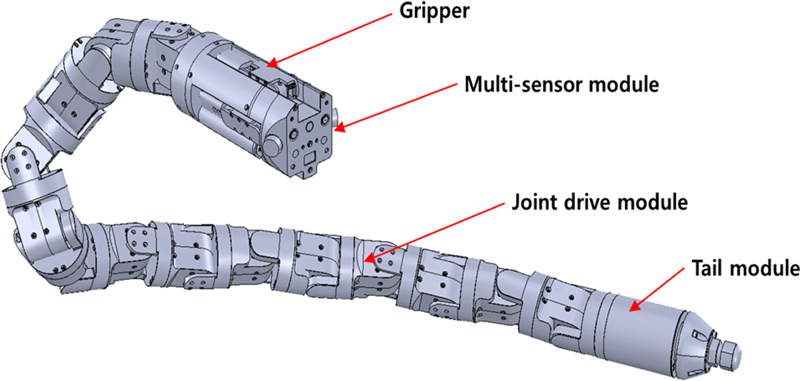

재난 사고로 인해 붕괴된 건물 내부의 협소한 공간을 탐색하기 위한 로봇의 구조는 Fig. 1과 같다. 이 로봇은 지름 100 mm 이하의 협소한 공간을 이동할 수 있도록 관절 구동 모듈 14개, 꼬리 모듈 1개, 다중 센서 모듈과 그리퍼가 포함된 머리 모듈 1개로 구성된 뱀형 로봇을 설계하였다. 다중 센서와 그리퍼가 통합된 머리 모듈은 직경 70 mm로 설계하였고, 로봇 몸통과 꼬리 모듈은 직경 58 mm로 설계하였다.

2.2 다중 센서 로봇 머리 모듈의 구성

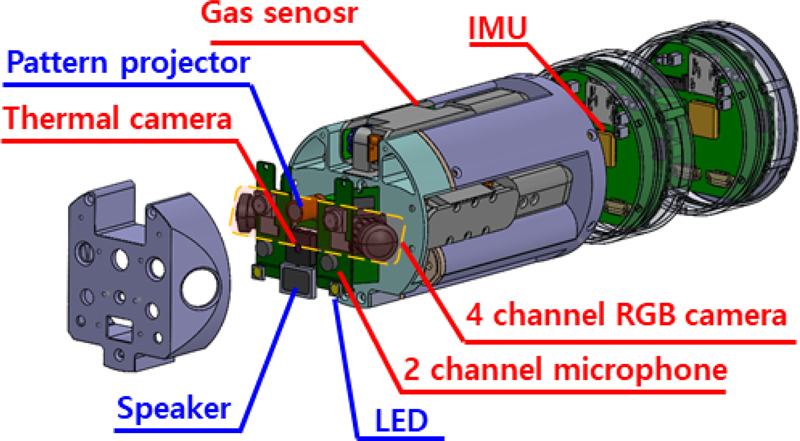

뱀형 로봇의 머리 모듈은 작업 지원을 위한 다자유도 그리퍼와 다중 센서 모듈로 구성된다. 본 논문에서 제안하는 다중 센서모듈은 CMU에서 제기한 센서 부재 문제를 해결하기 위해 RGB 카메라 4개, 열화상 카메라 1개, 가스 센서 1개, 마이크 2개, 스피커 1개, IMU 1개를 장착하였다.

생존자의 호흡 여부를 탐색할 수 있는 센서로 CO2를 검출하는 가스 센서를 선정하였다. 주변 환경과 생존자를 가시화하기 위해 저전력, 소형화에 유리한 CMOS 카메라를 선정하였으며, 4대의 카메라를 이용하여 파노라마 뷰를 생성한다. 농연 환경이나 어두운 곳과 같이 가시화가 힘든 환경에서 생존자를 탐색할 수 있는 센서로 열화상 카메라를 선정하였다. 열화상 카메라는 적외선을 사용하기 때문에 비가시 상황에서도 생존자 탐색이 가능하다. 센서 모듈의 위치 파악을 위한 센서로 IMU 을 선정하였다. 비가시 환경 내 인명 탐지를 위해 마이크 2개를 사용하여 전방 180°에 대해 생존자를 추정할 수 있는 알고리즘을 탑재하였다[16].

추가적으로 탐지 및 인명 탐지 활동 보조로 활용하기 위해 LED, 스피커를 구성하였다. 사용하는 센서 사양은 Table 1에 나타내었다.

뱀형 로봇의 머리 모듈은 100 mm의 협소한 공간에 투입 및 운용되어야 하는 제약사항으로 센서와 제어 보드 배치를 위한 내부 공간이 빈약하다. 또한, 그리퍼는 로봇 주행 시, 몸체 내부에 손가락이 수납될 수 있는 구조로 설계되어 센서 탑재 시 공간적 제약사항이 발생한다[17]. 이러한 문제를 해결하기 위해 탐지 센서들은 전방에 밀집 배치하고, 제어 보드는 후방에 배치하였다. 전체적인 센서 모듈의 구조는 Fig. 2와 같다.

2.3 다중 센서 모듈 인터페이스 구성

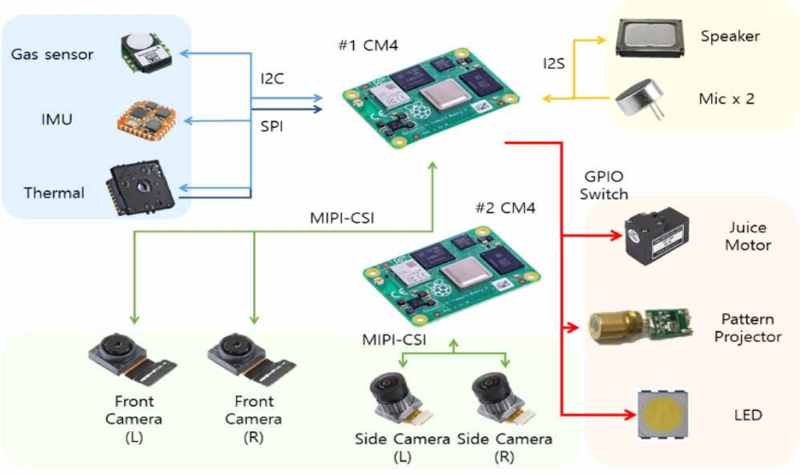

본 연구에서는 복수의 센서 처리를 위해 사용하는 MPU는 CM4 (Raspberry Pi Compute Module 4)를 적용하였다. CM4는 머리 모듈에서 구성하는 각종 센서의 인터페이스(I2C, SPI, I2S, MIPI)를 지원하여 머리 모듈의 소형화 및 데이터 처리에 적합하다. 기존 연구에서 사용한 모듈과의 비교는 Table 2에 나타내었다[16].

본 연구에서는 하나의 Master에 여러 개의 Slave를 연결할 수 있는 I2C 통신을 활용, 복수의 센서들을 연속적으로 연결하여 내부 통신망을 단순화하였다. 열화상 카메라와 같이 다량의 데이터를 전송하는 경우에는 별도의 SPI 통신망을 이용하여 인터페이스를 구성하였다.

CM4에서 사용 가능한 MIPI (Mobile Industry Processor Interface) 통신 라인은 최대 2개이며, 4개의 카메라 모듈을 사용하기 위해 2대의 CM4를 사용하여 전장부를 구성하였다. 스피커와 마이크는 일반적으로 USB 또는 HDMI 인터페이스를 사용하여 구성하지만, 소형화를 위해 ADC (Analog-digital Converter)와 DAC (Digital-analog Converter)를 통해 변환한 데이터를 I2S 통신망을 이용하도록 구성하였다. 전체적인 통신 인터페이스는 Fig. 3과 같다.

2.4 다중 센서 모듈 배치안 도출

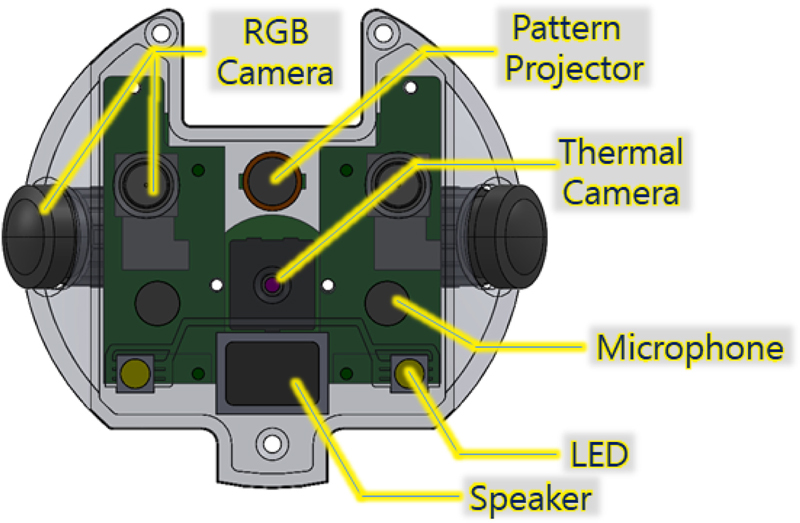

다중 센서 모듈의 센서 배치 구조는 Fig. 4와 같다. 이 모듈에는 4개의 RGB 카메라가 탑재되며 로봇 전방의 장애물에 대한 거리 정보를 얻기 위해 전방에 2개의 카메라를 배치하여 스테레오 비전으로 구성하였다. 로봇의 하드웨어 제약사항으로 인해 카메라 간 간격은 36 mm로 배치하였다.

그 외 열화상 카메라, 패턴 프로젝터, 마이크, LED 조명, 스피커는 서로 간섭이 발생하지 않는 범위에서 전방을 향하도록 배치하였다. 파노라마 영상 구현을 위해 측면의 광각 카메라와 전방 카메라의 FOV (Field of View)가 일정 영역 겹치도록 측면과 전방 카메라 사이 각도를 60°로 적용하여 배치하였다.

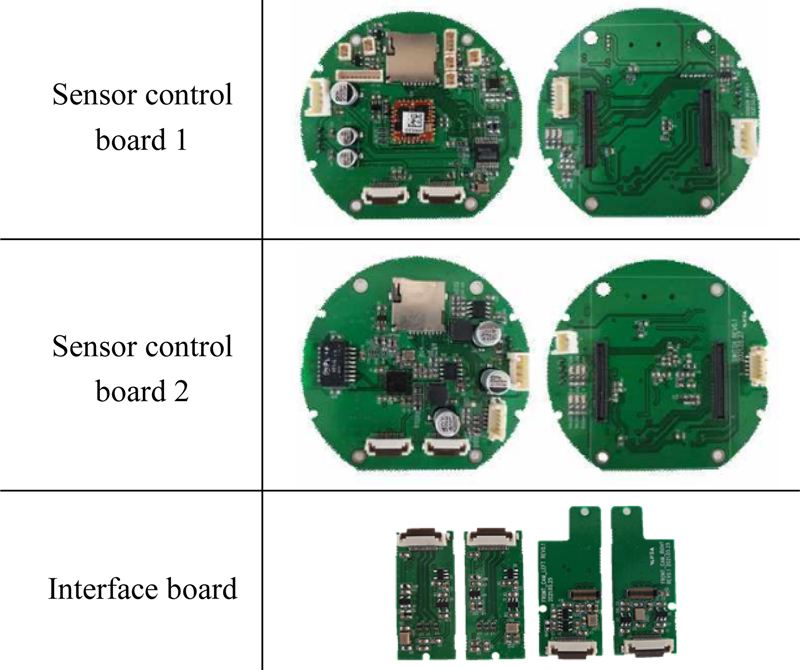

2.5 다중 센서 모듈 인터페이스 보드 개발

뱀형 로봇 머리 모듈의 전방에 배치된 센서로부터 취득된 정보를 처리하기 위해 센서 제어보드를 개발하였다. Fig. 5는 개발한 제어 보드이다. 제어 보드 1에서는 2개의 RGB 영상과 열화상, IMU 정보를 취득할 수 있으며, LED 및 패턴 프로젝터의 On/Off 제어를 담당한다. 제어 보드 2에서는 측면에 배치된 광각 카메라 2개와 가스 센서 정보를 취득할 수 있으며, 제어 보드 1의 정보를 Ethernet 인터페이스를 활용하여 중계할 수 있도록 Switching Hub 기능이 구현되었다.

전방에 배치된 센서와 제어 보드 사이에 배치된 그리퍼 모듈로 인해 약 100 mm의 간격이 발생하여 센서와 제어 보드를 연결할 케이블 확장 보드를 개발하였다.

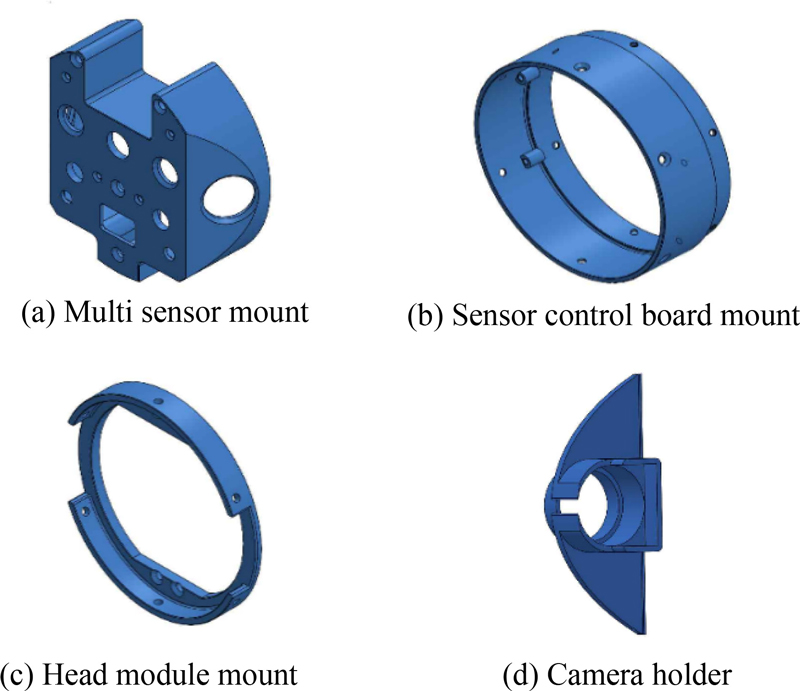

2.6 다중 센서 모듈 하우징 설계

뱀형 로봇의 탐색 작업을 수행하는 중 발생하는 진동 및 이물질로부터 센서 및 제어 보드를 보호하기 위해 다중 센서 모듈하우징을 설계하였다. 설계한 하우징은 Fig. 6과 같다.

Fig. 6(a)은 Multi Sensor Mount Part로 센서들이 배치되며 카메라 모듈이 고정될 수 있도록 한다. Fig. 6(b)은 Sensor Control Board Mount이며 센서 보드를 고정하는 역할을 한다. Fig. 6(c)은 Head Module Mount로 뱀형 로봇 머리 모듈이 몸통 모듈과 연결될 수 있도록 고정한다. 마지막으로 Fig. 6(d)은 Camera Holder로 측면에 장착된 광각 카메라가 내부 부품과 간섭되지 않도록 고정하는 역할을 한다.

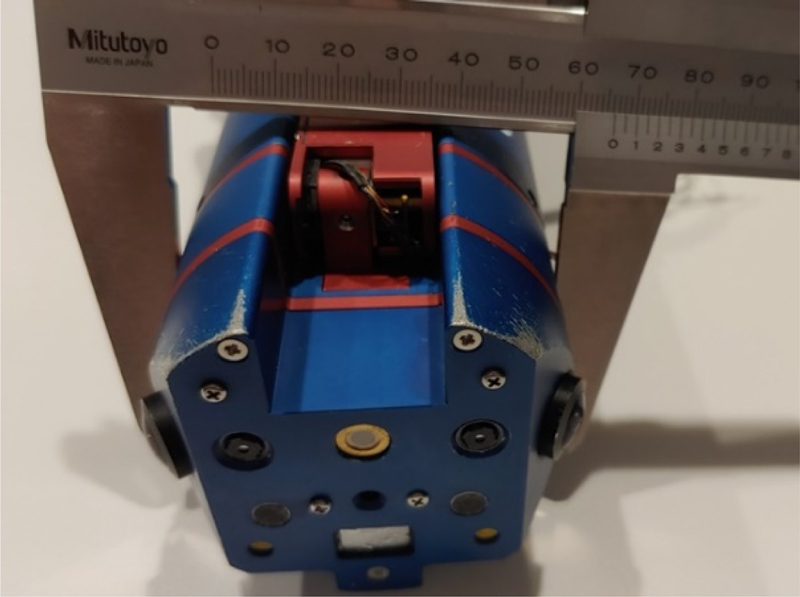

본 논문에서 제안하는 다중 센서 모듈의 프로토타입은 Fig. 7과 같다. 제작된 센서 모듈의 직경은 100 mm 이내의 협소 공간을 통과할 수 있도록 66.1 mm로 설계하였다.

3. 다중 센서 모듈 소프트웨어

3.1 다중 센서 모듈 소프트웨어 구성

센서 모듈의 소프트웨어를 개발하기 위해 CM4의 컴파일러는 g++9.0을 사용하였고, 영상처리 라이브러리는 OpenCV 3.4.0버전을 사용하였다. 또한, 열화상 카메라인 Lepton 3.5를 제어하기 위해 FLIR에서 제공하는 SDK를 활용하였으며, LED조도 제어 및 패턴프로젝트 On/Off를 위해 Wiring Pi 라이브러리를 활용하였다.

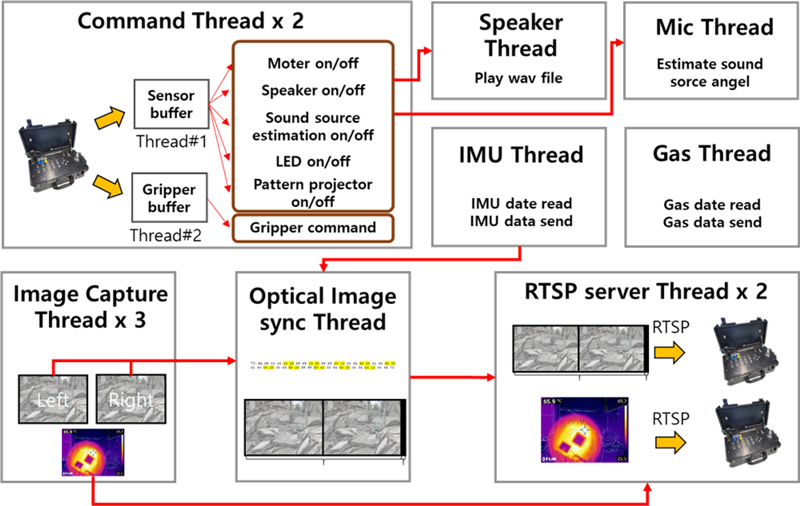

다중 센서 정보를 효과적으로 처리하기 위해 Fig. 8에서 보이는 것처럼 각 센서 및 기능별로 Thread를 구현하였다.

(a) Command Thread: 로봇 조종기에서 송신한 명령어 처리

(b) Image Capture Thread: 센서 보드에 연결된 카메라 영상정보 취득

(c) Optical Image Sync Thread: 다채널 영상의 시간 오차 문제 개선을 위한 영상 정합

(d) IMU/Mic/Gas/Speaker Thread: IMU/Mic/Gas/Speaker 정보 처리

(e) RTSP Server Thread: 영상정보 전송 서버

3.2 파노라마 뷰 생성을 위한 영상정보 시간 동기화

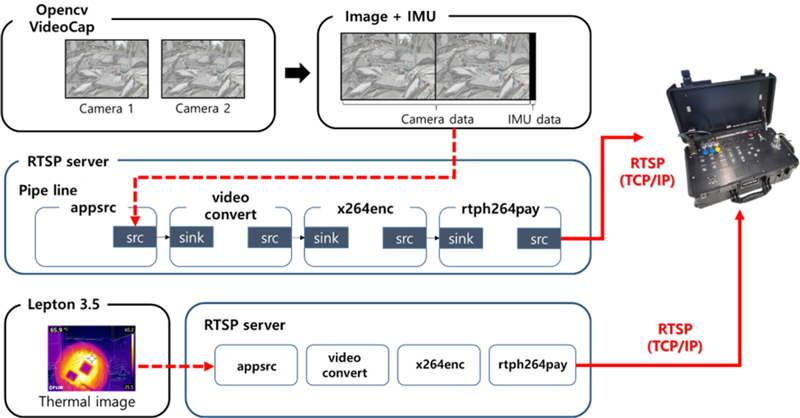

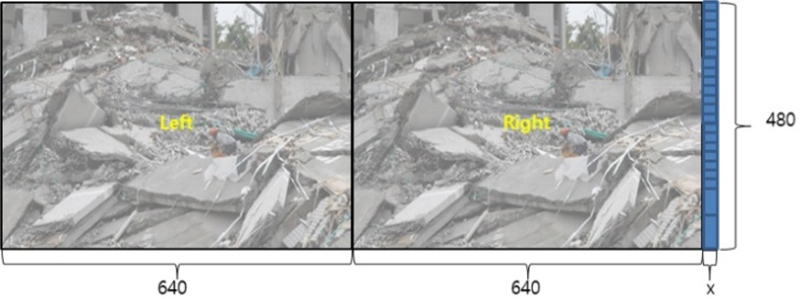

본 논문에서 제안하는 다중 센서 모듈의 Video Streaming Software Structure는 Fig. 9과 같다. 이것을 활용하여 영상정보 융합을 통한 파노라마 뷰를 생성하기 위해서는 카메라 간동기화된 영상 정보가 필요하다. 일반적으로 동기화된 영상정보를 얻기 위해 트리거 신호가 있는 카메라 모듈을 사용하지만, 본 연구에서 사용하는 센서 모듈은 소형화에 따른 제약사항으로 인해 트리거 신호가 없는 카메라를 사용하였다. 또한, 복수로 구성된 카메라의 영상정보를 원격의 장치에 각각 송신할 경우 통신 시간 오차로 인해 복수 영상 간 동기 오차가 더욱 커지게 된다. 이러한 문제를 해결하기 위해 CM4에서 640 × 480 크기를 가지는 복수의 카메라 영상 취득 함수를 하나의 Thread에서 구동하여 영상의 측정 시간 오차를 최소화하고, 통신 시간 오차 문제를 발생하지 않기 위해 CM4에서 취득한 영상들을 1,280 × 480 크기로 합성하였다.

다중 센서 모듈의 자세와 영상 정보의 동기성 확보를 위해 IMU 정보를 합성된 영상 배열에 인코딩하여 데이터 패킷을 구성하였다. 합성된 영상 및 IMU 정보는 Fig. 10과 같다.

3.3 음원을 활용한 생존자 탐지 알고리즘

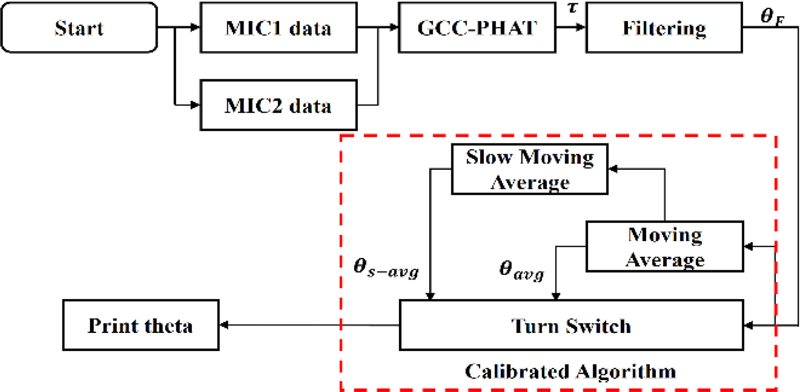

본 논문에서 제안하는 다중 센서 모듈에 탑재될 음원 추정 알고리즘은 TDOA 기반 GCC-PHAT를 활용한 음원 추정 알고리즘을 제안한다. TDOA 알고리즘은 적은 수의 마이크로도 간단한 연산을 통해 음원의 위치를 특정할 수 있는 장점이 있다. 그렇기에 공간적 제약사항으로 인해 다량의 마이크를 탑재하지 못하는 다중 센서 모듈에서 사용하기에 가장 적합한 알고리즘이다. TDOA의 시간 지연을 파악하고, 사람의 음역대에 해당하는 소리에 동작할 수 있도록 대역폭 통과 필터를 설계하기 위해 GCC-PGAT를 사용한다. 이후 Calibrated 알고리즘을 적용하여 안정적인 데이터를 확보한다. 전체 알고리즘 선도는 Fig. 11과 같다[18].

4. 실험 결과 및 고찰

4.1 파노라마 뷰 생성 실험

복수의 카메라 공통 시야각에 표현된 이미지 특징점은 식(1)과 같이 하나의 이미지 좌표계로 표현할 수 있다.

| (1) |

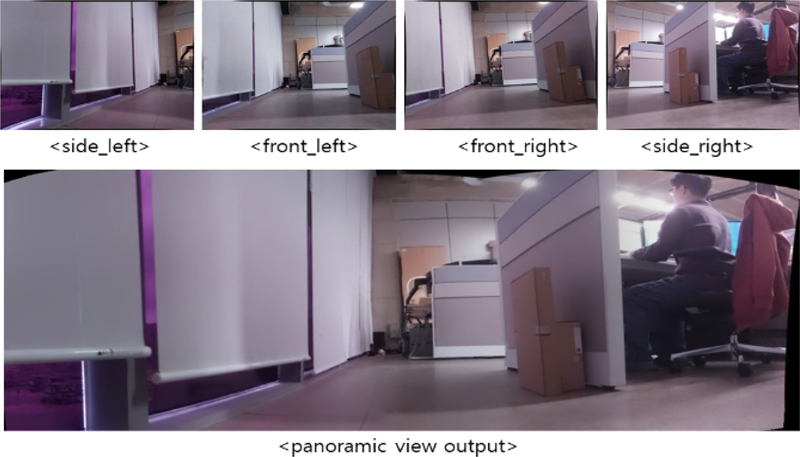

카메라 캘리브레이션을 위한 체스 보드를 활용하여 카메라 사이의 대응점을 검출한 후 식(2)를 통하여 4대 카메라 간 호모그래피(Homography)를 SVD (Singular Value Decomposition)로 계산하여 Fig. 12와 같이 4개의 영상으로 파노라마 뷰가 생성됨을 확인하였다.

| (2) |

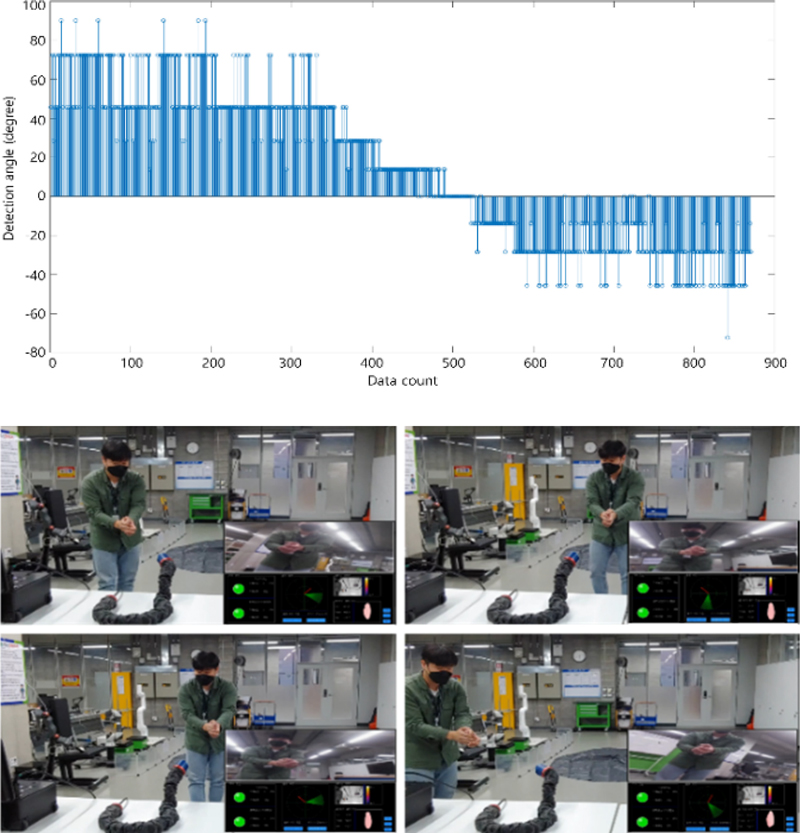

4.2 음원 추정 알고리즘 실험 결과

다중 센서 모듈에는 정면에 30 mm 간격으로 장착된 2개의 마이크가 장착되어 있고, TDOA 기반 GCC-PHAT를 활용한 음원 추정 알고리즘을 사용하여 음원 방향 추정 실험을 수행하였다. 음원 추정 성능 검증을 위해 -60~60° 범위에서 30° 간격으로 음원을 발생하여 각 15회 실험을 수행하였고 그 결과는 Table 3과 같다. 또한, 로봇과 연동하여 음원 추정을 수행하였고 이때 음원은 ±75° 범위에서 15°의 간격을 두고 생성하였다. Fig. 13에서 보이듯 정면을 기준으로 ±75°에서 발생한 소리에 대한 인식 가능함을 확인하였고, ±45° 범위에서는 보다 안정적으로 음원 추정이 가능하였다.

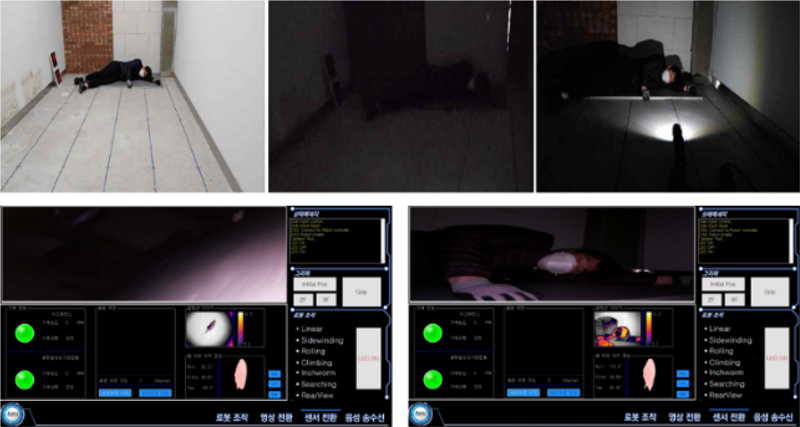

4.3 뱀형 로봇 탑재 및 운용 실험

14개의 관절 구동 모듈과 1개의 꼬리 모듈로 구성된 뱀형 로봇에 다중 센서 모듈을 탑재하였다. 실재 재난 환경을 모사한 테스트 환경에서 생존자 탐지 실험을 수행하였다. Fig. 14에서 보이듯 조도가 낮은 실내에서 쓰러진 사람을 찾기 위해 LED 조명을 가동하여 탐색하여도 탑재된 카메라 영상을 통해서는 사람이 잘 보이지 않지만, 다중 센서 모듈에 탑재된 열화상 카메라를 통해서는 사람이 포착됨을 확인하였다.

CMU에서 개발한 뱀형 로봇의 경우 1개의 RGB 카메라를 통해 들어오는 영상 정보가 제약적이었으나, Fig. 15에서 보이듯 본 연구를 통해 개발된 다중 센서 모듈에서는 4개의 영상을 합성하여 파노라마 뷰를 제공함으로써, 넓은 가시 영역을 확보할 수 있음을 확인하였다. 또한, 2개의 마이크를 이용한 음원 추정 기능을 통해 사람이 존재하는 방향으로 탐사 각도를 조정 후 RGB, 열화상 카메라의 가시화 정보를 통해 사람의 유무를 확인할 수 있어 인명 탐색 효율이 증대됨을 확인하였다.

5. 결론

본 연구에서는 뱀형 로봇에 탑재되어 협소 공간 내 생존자 탐색 기능을 수행하는 다중 센서 모듈을 개발하였다. CMU에서 개발한 뱀형 로봇의 탐지 센서 부재 문제를 해결하기 위해 RGB 카메라 4개, 열화상 카메라 1개, 가스 센서 1개, 마이크 2개, IMU 1개를 탑재하였다. 상술한 센서들과 LED 조명, 적외선 패턴 프로젝터 등을 밀집 배치한 결과 다중 센서 모듈의 직경은 66.1 mm로 목표한 100 mm 이내의 협소 공간 투입이 가능하였다.

복수의 센서에서 획득한 정보를 효율적으로 처리하기 위해 센서 보드에서 기능별로 Thread를 독립 운용하였다. 캡쳐 트리거가 없는 복수의 소형 카메라 영상 간의 시간 오차를 최소화하기 위해 영상 캡쳐 및 합성 소프트웨어를 구현하였다. 합성된 다채널 영상정보를 활용하여 파노라마 뷰를 생성하여 인명 탐지를 위한 시야 확보 기능을 구현하였다. 또한, TDOA기반 GCC-PHAT 활용 음원 위치 추정 알고리즘을 통합하여 다중 센서 모듈에서 인명 탐지 임무 수행을 위한 기능을 구현하였다.

본 연구에서 제안한 다중 센서 모듈을 뱀형 로봇에 탑재하여 실재 재난 현장을 모사한 테스트 환경에서 운용한 결과 복수의 카메라 정보를 융합하여 확장된 영상정보를 제공할 수 있어 탐색에 유용함을 확인하였고, 열화상카메라 및 조명은 저조도 환경에서 생존자 탐색에 유용함을 확인하였다. 또한, 다채널 마이크를 이용한 음원 추정 기술은 생존자의 방향 추정 후 가시화 센서 정보를 통해 탐색할 수 있어 생존자 탐색 효율의 향상이 가능함을 확인하였다.

Acknowledgments

이 연구는 행정안전부 및 한국산업기술기획평가원(KEIT) 연구비 지원을 받아 수행된 연구임(No. 20026195, 재난 환경 인식 및 인명 탐지를 위한 멀티모달센서 개발).

REFERENCES

-

Kim, E., Moeller, R., (2007), Biomimetic whiskers for shape recognition, Robotics and Autonomous Systems, 55(3), 229-243.

[https://doi.org/10.1016/j.robot.2006.08.001]

-

Wangbo, J., Lee, J., Dosovitskiy, A., Bellicoso, D., Tsounis, V., Koltun, V., Hutter, M., (2019), Learning agile and dynamic motor skills for legged robots, Science Robotics, 4(26).

[https://doi.org/10.1126/scirobotics.aau5872]

-

Zhang, F., Teng, S., Wang, Y., Guo, Z., Wang, J., Xu, R., (2020), Design of bionic goat quadruped robot mechanism and walking gait planning, International Journal of Agricultural and Biological Engineering, 13(5), 32-39.

[https://doi.org/10.25165/j.ijabe.20201305.5769]

-

Ahn, I.-S., Jang, J.-Y., Seo, K.-S., (2009), Generation of locomotion for snake-like robot using genetic algorithm and analysis for selections of partial modules, Journal of The Korean Institute of Intelligent Systems, 19(5), 661-666.

[https://doi.org/10.5391/JKIIS.2009.19.5.661]

-

Kang, K., Moon, H., Lee, W., Kim, S., (2018), Barometer information-based 3D localization for rescuing a buried person in disaster environments, Journal of Korean Institute of Communications and Information Sciences, 32(3), 489-496.

[https://doi.org/10.7840/kics.2018.43.3.489]

- Nam, K.-H., Jang, M.-S., (2019), A study on the exploration device of the disaster site using drones, Journal of the Korea Institute of Electronic Communication Sciences, 14(3), 579-586.

-

Inazawa, M., Takemori, T., Tanaka, M., Matsuno, F., (2021), Unified approach to the motion design for a snake robot negotiating complicated pipe structures, Frontiers in Robotics and AI, 8, 629368.

[https://doi.org/10.3389/frobt.2021.629368]

-

Wang, Y., Kamegawa, T., (2022), Realization of crowded pipes climbing locomotion of snake robot using hybrid force-position control method, Sensors, 22(22), 9016.

[https://doi.org/10.3390/s22229016]

-

Transeth, A. A., Pettersen, K. Y., Liljebäck, P., (2009), A survey on snake robot modeling and locomotion, Robotica, 27(7), 999-1015.

[https://doi.org/10.1017/S0263574709005414]

-

Schmitt, J., Garcia, M., Razo, R. C., Holmes, P., Full, R. J., (2002), Dynamics and stability of legged locomotion in the horizontal plane: A test case using insects, Biological Cybernetics, 86(5), 343-353.

[https://doi.org/10.1007/s00422-001-0300-3]

-

González Gómez, J., Zhang, H., Boemo, E., (2007), Locomotion principles of 1D topology pitch and pitch-yaw-connecting modular robots, in: Bioinspiration and robotics walking and climbing robots, Habib, M. K. (Ed.), Tech Education and Publishing.

[https://doi.org/10.5772/5513]

- Hirose, S., Mori, M., (2004), Biologically inspired snake-like robots, Proceedings of the IEEE International Conference on Robotics and Biomimetics, 1-7.

-

Whitman, J., Zevallos, N., Travers, M., Choset, H., (2018), Snake robot urban search after the 2017 mexico city earthquake, IEEE International Symposium on Safety, Security, and Rescue Robotics, 1-6.

[https://doi.org/10.1109/SSRR.2018.8468633]

- Seo, M. K., Yoon, B. J., Shin, H. Y., Lee, K. J., (2020), Development of an integrated sensor module for terrain recognition at disaster sites, Journal of Drive and Control, 17(3), 9-14.

-

Kim, H.-G., Park, J.-W., Lee, H.-J., Park, S.-H., Choi, Y.-H., Lee, B.-K., Suh, J.-H., (2021), Development of a realistic simulator for driving education of a disaster-responding special purpose machinery, Journal of Power System Engineering, 25(2), 86-92.

[https://doi.org/10.9726/kspse.2021.25.2.086]

-

Kim, S, Shin, D.-G., Pyo, J., Shin, J., Jin, M., Suh, J., (2021), A multi-sensor module of snake robot for searching survivors in narrow space, Journal of Korea Robotics Society, 16(4), 291-298.

[https://doi.org/10.7746/jkros.2021.16.4.291]

-

Han, S., Chon, S., Kim, J., Seo, J., Shin, D. G., Park, S., Kim, J. T., Kim, J., Jin, M., Cho, J., (2022), Snake robot gripper module for search and rescue in narrow spaces, IEEE Robotics and Automation Letters, 7(2), 1667-1673.

[https://doi.org/10.1109/LRA.2022.3140812]

-

Han, S.-W., Kim, S.-J., Shin, D.-G., Pyo, J.-H., Lee, M,-S., Jin, M., Suh, J.-H., (2022), A study on sound localization of survivors for the robot searching victims in a narrow space, Journal of Korean Society of Precision Engineering, 39(7), 509-516.

[https://doi.org/10.7736/JKSPE.022.019]

Senior Researcher in Korea Institute of Robotics & Technology Convergence, and Ph.D. candidate in the Department of Mechanical System Engineering, Pukyong National University. His research interest is robot control, robot system integration, automation application.

E-mail: shingun@kiro.re.kr

Assistant Researcher in Korea Institute of Robotics & Technology Convergence. His research interest is field robotics, robot system integration, intelligent robotics.

E-mail: meungsuklee@kiro.re.kr

Chief Researcher in Korea Institute of Robotics & Technology Convergence. His research interest is disaster robotics, robot motion control, electro-hydraulic actuators.

E-mail: mulimkim@kiro.re.kr

Postdoctoral researcher in the Major of Intelligent Robot Engineering. His research interest is robot control systems, control engineering, intelligent control, robust control.

E-mail: bbman7020@gmail.com

Professor in the Major of Mechanical System Engineering, Division of Energy Transport Systems Engineering, College of Engineering, Pukyong National University. His research interest is disaster response robot, underwater robots, and system control & integration in field robotics.

E-mail: suhgang@pknu.ac.kr