로봇 의수 설계 및 근전도 기반의 손동작 인식

Copyright © The Korean Society for Precision Engineering

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License (http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

This paper was presented at KSPE Spring Conference 2019

Abstract

In this paper, a prosthetic robot hand was designed and fabricated and experimental evaluation of the realization of basic gripping motions was performed. As a first step, a robot finger was designed with same structural configuration of the human hand and the movement of the finger was evaluated via kinematic analysis. Electromyogram (EMG) signals for hand motions were measured using commercial wearable EMG sensors and classification of hand motions was achieved by applying the artificial neural network (ANN) algorithm. After training and testing for three kinds of gripping motions via ANN, it was observed that high classification accuracy can be obtained. A prototype of the proposed robot hand is manufactured through 3D printing and servomotors are included for position control of fingers. It was demonstrated that effective realization of gripping motions of the proposed prosthetic robot hand can be achieved by using EMG measurement and machine learning-based classification under a real-time environment.

Keywords:

Prosthetic robot hand, Surface electromyography, Hand motion recognition, Artificial neural network키워드:

로봇 의수, 표면 근전도, 손동작 인식, 인공 신경망1. 서론

의수는 상지 절단자의 일상생활을 돕기 위한 보조 기구로 크게 장식 의수(미용 의수), 작업 의수, 인체 구동형 의수, 전동 의수 등으로 분류할 수 있다. 장식 의수는 외형만 손의 모양과 비슷하게 한 것으로 동작은 불가능한 것이고, 작업 의수는 갈고리 모양의 손끝으로 물건을 잡거나 이동시킬 수 있는 형태이다. 인체 구동형 의수는 어깨 움직임 등을 이용해서 간단한 동작을 구현할 수 있으나, 인체 특정 부분에 무리를 줄 수 있는 단점이 있다. 전동 의수는 모터를 이용하여 손가락을 움직일 수 있는 형태로 제한된 손동작을 구현할 수 있지만, 가격이 매우 높아 제한적으로 활용되고 있다. 최근에는 신체의 잔존 근육에서 측정할 수 있는 표면 근전도를 이용하여 손동작을 구현하는 다양한 형태의 의수들이 제안되고 있으며 관련 연구가 활발하게 진행되고 있다.

Saridis와 Gootee1는 이두근과 삼두근의 근전도를 측정하여 전완의 동작을 구현하는 의수를 제안하고 실험을 통하여 검증하였다. Zero Crossing과 분산을 이용하여 특징을 추출하고, 계층적 지능 제어기를 이용하여 패턴을 분류하였다. Matrone2 등은 주성분 분석 기반의 제어기를 이용한 과소 구동 전동 의수의 제어를 제안하고, 실험을 통하여 효과를 고찰하였다. Ma3 등은 근육 시너지 모델을 이용하여 근전도 기반 의수의 손과 손목 운동을 제어하는 것을 제안하였고, 가상 공간에서 의수가 동작을 효과적으로 구현하는 것을 확인하였다. Guo4 등은 근전도 신호와 함께 근적외선 분광법(Near-Infrared Spectroscopy, NIRS)을 함께 이용하여 근전도 신호만을 이용할 때보다 분류 정확도를 높일 수 있는 방법을 제안하고 가상 공간의 의수를 이용하여 검증하였다. Lee5,6 등은 근전도 측정을 위한 전극이 포함되어 있는 니트 밴드 형태의 장치를 제안하고, 실험으로 효율성을 검증하였다. Lee7 등은 의수의 파지 성능 평가 방법을 제안하고, 이를 바탕으로 주요 설계 인자들이 파지 성능에 미치는 영향을 검증하였다. Lim8 등은 전동 의수의 파지력 제어를 위하여 케이블의 장력을 측정하여 되먹임 제어를 수행하도록 하였으며, 진동 신호를 이용한 햅틱 시스템을 구성하고 평가하였다. Bae9 등은 전동 의수 사용자에게 햅틱 피드백을 줄 수 있도록 감각을 측정하고 전달하는 시스템을 제안하고 실험을 통하여 효율성을 확인하였다. Noh10 등은 물건을 잡는 네 가지 동작에 대하여 세 단계의 악력 조절을 수행하기 위한 추정 모델을 제안하고 정확도를 실험으로 검증하였다. Kim11 등은 뇌파를 이용하여 의수의 움직임을 제어하는 것을 제안하고, 동작에 따른 뇌파의 특징을 분류하는 기법을 제안하고 실험을 통하여 검증하였다. Jo와 Oh12는 최근 다양한 분야에 적용되고 있는 딥러닝 기법을 이용하여 근전도 신호에 따른 손동작을 분류하고 능동 의수에 적용을 제안하였으며, 딥러닝 파라미터 변화에 대하여 분류 정확도를 검증하였다.

본 연구에서는 새로운 형태의 로봇 의수 모델을 제안하고, 이를 이용하여 일상생활에 필요한 기본적인 손동작을 효과적으로 구현할 수 있음을 확인한다. 사람의 손과 동일하게 세 개의 링크를 이용하여 손가락을 구성하고, 사람의 힘줄과 동일한 역할을 할 수 있도록 폴리에틸렌 와이어를 삽입하며, 복원을 위해서 탄성이 있는 밴드를 포함하도록 한다. 제안된 링크 구조를 이용하여 사람의 손가락 운동을 유사하게 구현할 수 있는지 손가락 끝 위치에 대한 기구학 해석을 수행한 후, 3D 프린터를 이용하여 제작한다. 일상생활에서 많이 쓰이는 사람의 손동작 세 가지를 정의하고, 동작에 대한 근전도 신호를 측정한다. 동일 동작에 대하여 반복 측정된 근전도 신호를 이용하여 동작 인식을 위한 학습을 수행하고, 테스트를 수행하여 분류 정확도를 높이도록 한다. 근전도 신호를 이용하여 사용자가 의도하는 손동작을 인식하고, 로봇 의수가 동일한 동작을 정확하게 구현하는 것을 실시간 환경의 실험을 통하여 확인한다. 제안된 방식이 실제 상항에서도 효과적으로 활용될 수 있음을 실험을 통하여 확인한다.

2. 로봇 의수 설계

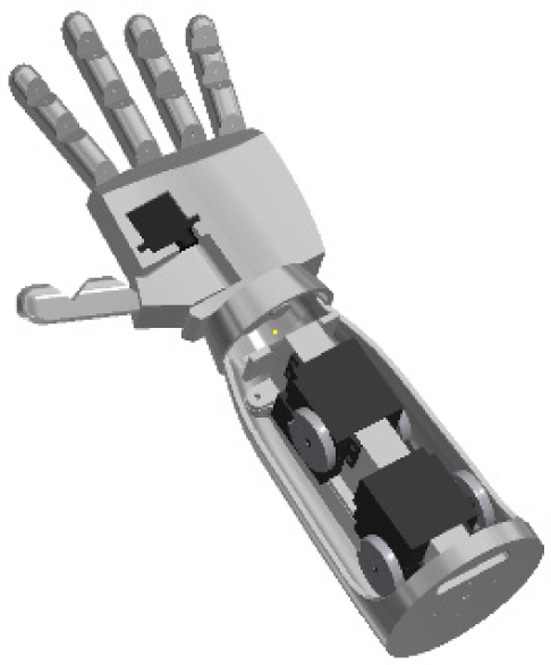

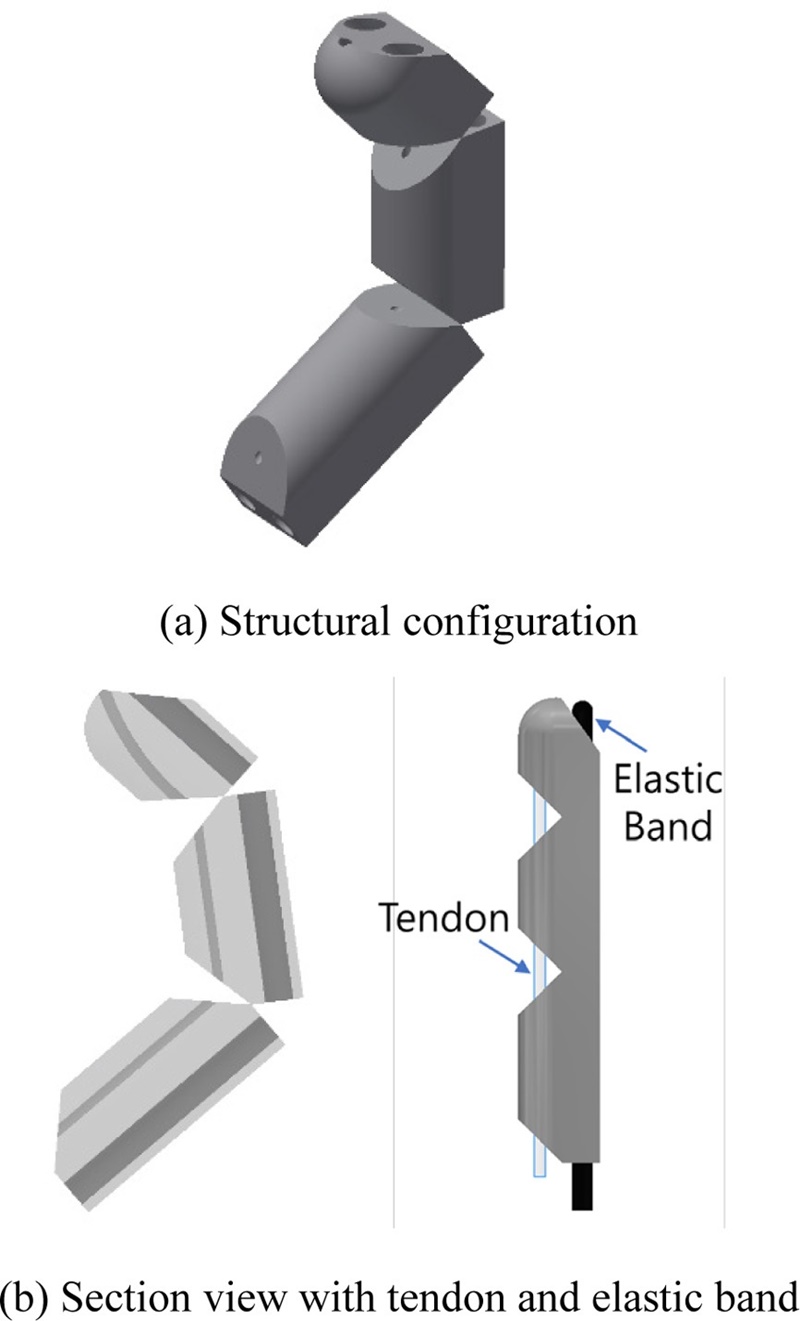

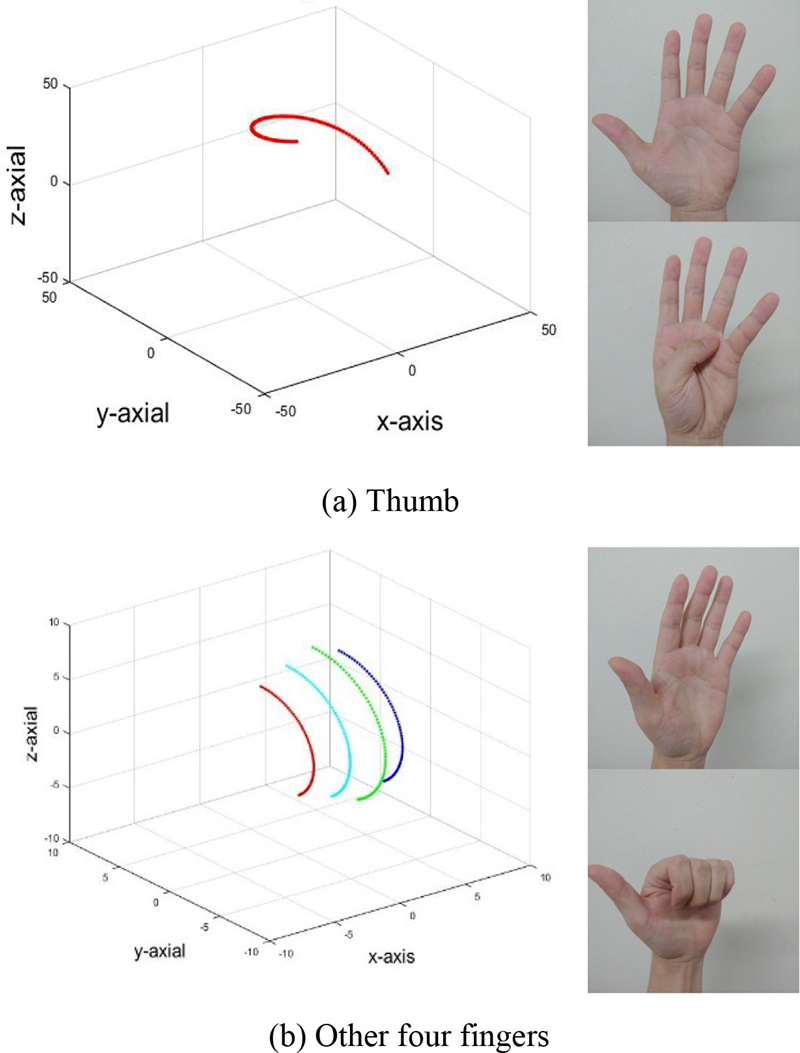

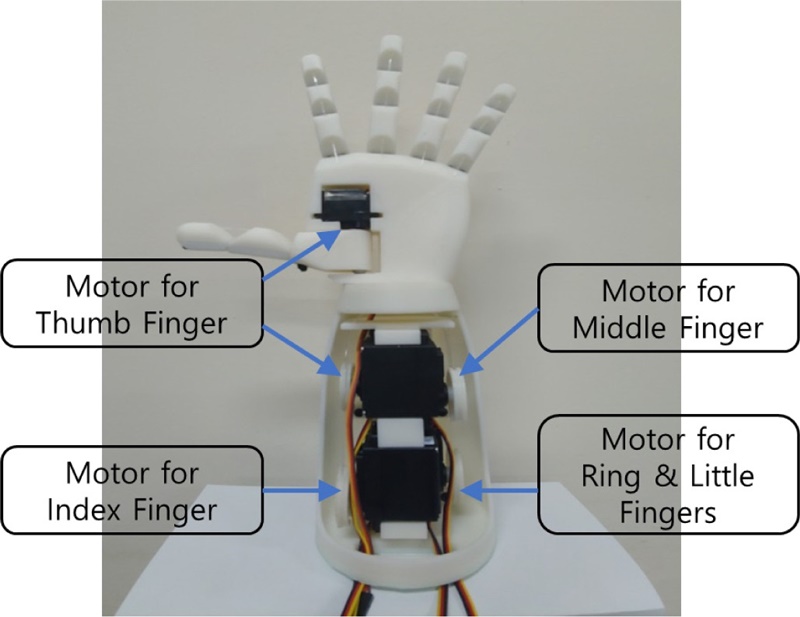

본 연구에서 고려한 로봇 의수의 전체 구조 개략도를 Fig. 1에 나타내었다. 사람의 손과 동일한 크기와 구조의 손가락을 갖는 의수를 고려하였으며, 엄지와 연결된 손허리뼈의 운동 구현을 위한 모터를 제외한 나머지 손가락의 구동을 위한 모터들은 손목 아래쪽에 위치하도록 하였다. 실제 사람에게 장착을 위한 소켓과 같은 연결 부분은 고려하지 않고 손가락의 동작 구현만을 고려하여 설계를 수행하였다. 로봇 의수의 크기는 성인 남성의 왼손을 기준으로 하였으며, 손바닥의 높이와 폭은 81 mm로 설계하였다. 사람의 손에는 엄지, 검지, 중지, 약지, 소지의 다섯개의 손가락이 있으며, 엄지를 제외한 나머지 네 손가락은 끝마디뼈, 중간마디뼈, 첫마디뼈, 세 개의 손가락뼈로 구성되어 있고, 엄지는 중간마디뼈가 없이 끝마디뼈와 첫마디뼈로만 구성되어 있다. 각 손가락의 첫마디뼈는 손바닥 내부에 있는 손허리뼈를 통해 손목뼈와 연결되어 있다. 이러한 손가락의 해부학적 특징을 고려하여 세 개의 링크 기구를 이용하여 손가락을 구성하였다. 본 연구에서 제안된 손가락의 모델을 Fig. 2(a)에 나타내었고, 손가락 모델의 단면을 Fig. 2(b)에 나타내었다. 엄지를 손바닥 안쪽으로 굽히는 동작은 손바닥 내부에 있는 손허리뼈에 의하여 구현되므로, 제안된 의수에서 엄지는 손허리뼈를 포함하여 세 개의 링크를 이용하여 구성하였다. 제안된 손가락 모델에는 각 관절 구동을 위한 모터를 따로 사용하지 않고, 와이어를 이용하여 한 번의 모터 구동으로 손가락의 세 개의 링크가 움직일 수 있도록 하였다. Fig. 2(b)의 단면도에 나타난 바와 같이 손가락 내부에 폴리에틸렌 와이어를 설치하여 손가락을 구성하는 세 개의 링크를 연결하고, 손가락의 힘줄과 같은 역할을 수행하도록 하였으며, 손가락의 굽힘 동작 후 초기 위치로 복귀를 위해서 탄성 밴드를 이용하였다. 단면도에서 손가락의 안쪽에 힘줄이, 바깥쪽에 탄성 밴드가 장착된다. 제안된 손가락 모델이 사람의 손과 동일한 운동을 구현하는지 확인하기 위하여 손가락 끝점의 운동 경로를 확인하였고, 엄지 손가락과 나머지 네손가락의 시뮬레이션 결과를 실제 사람 손의 사진과 함께 Figs. 3(a)와 3(b)에 각각 나타내었다. 다섯 손가락 모두 사람 손의 운동과 동일한 형태로 운동하는 것을 확인할 수 있으며, 제안된 손가락 모델을 의수에 적용하는 것이 가능함을 확인할 수 있다.

3. 손동작 인식

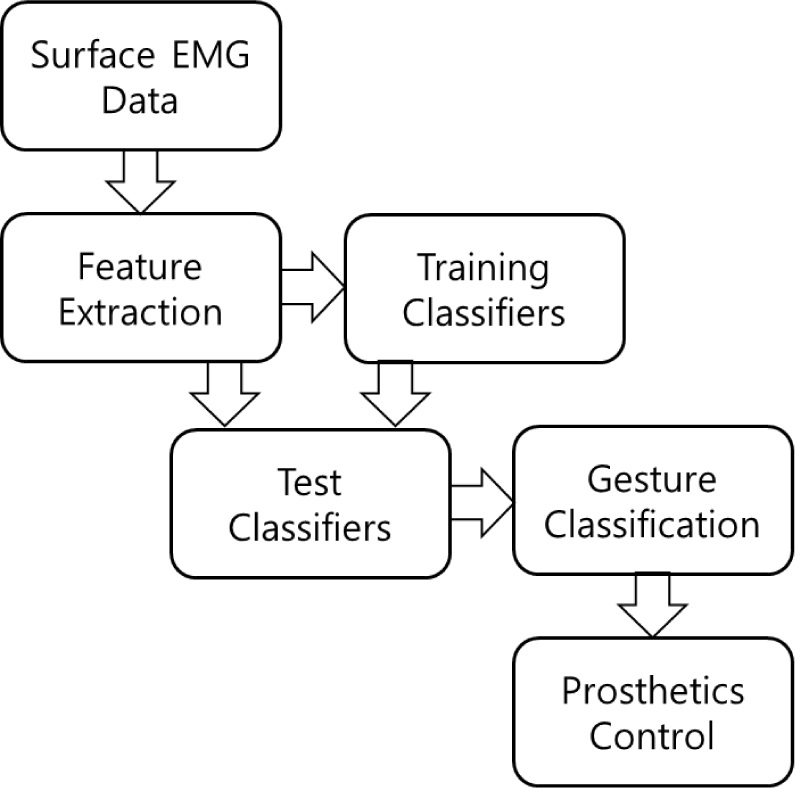

본 연구에서는 근전도 신호를 이용하여 손동작을 인식하고 그 결과를 의수를 통해 구현할 수 있도록 하였다. 근전도 측정은 암밴드 형태의 상용 근전도 측정 장치인 Talmic사의 MYO를 이용하였다. MYO에는 8 채널의 근전도 센서가 장착되어 있으며, 샘플링 주파수는 200 Hz로 고정되어 있다. 실제 근전도 신호는 mV 단위로 측정되나 MYO는 -128에서 128 사이의 정수값으로 결과를 출력하며 단위는 Activation이다. 측정된 근전도 신호는 블루투스 통신을 통하여 개인용 컴퓨터로 전송되고, MATLAB을 이용하여 실시간으로 측정된 근전도 데이터를 수집하고, 분류를 수행하도록 하였다. 본 연구에서 수행된 데이터 수집과 분류의 동작 인식 과정을 Fig. 4에 나타내었다.

손가락을 굽힐 때 사용하는 심지굴근(Flexor Digitorum Profundus), 천지굴근(Flexor Digitorum Superficialis), 장무지굴근(Flexor Pollicis Longus), 손가락을 펼 때 사용하는 수지신근(Extensor Digitorum), 장무지신근(Extensor Pollicis Longus), 장무지외전근(Abductor Pollicis Longus) 등의 근육이 위치하고 있는 아래팔(전완)의 팔꿈치 아래쪽에 근전도 측정 장치를 착용하고 데이터를 수집하였다. 기계 학습을 위해서는 손동작에 대하여 측정된 근전도 신호의 특징을 추출해야 하는데, 본 연구에서는 절대 평균값(Mean Absolute Value, MAV)을 특징으로 사용하였다. 절대 평균값은 다음 식(1)과 같은 식으로 나타낼 수 있다.

| (1) |

여기서, x(i)는 측정된 데이터이고, L은 측정 주파수와 윈도잉(Windowing) 시간의 곱으로 결정되는 윈도우의 크기로 본 연구에서는 L = 100으로 사용하였다.

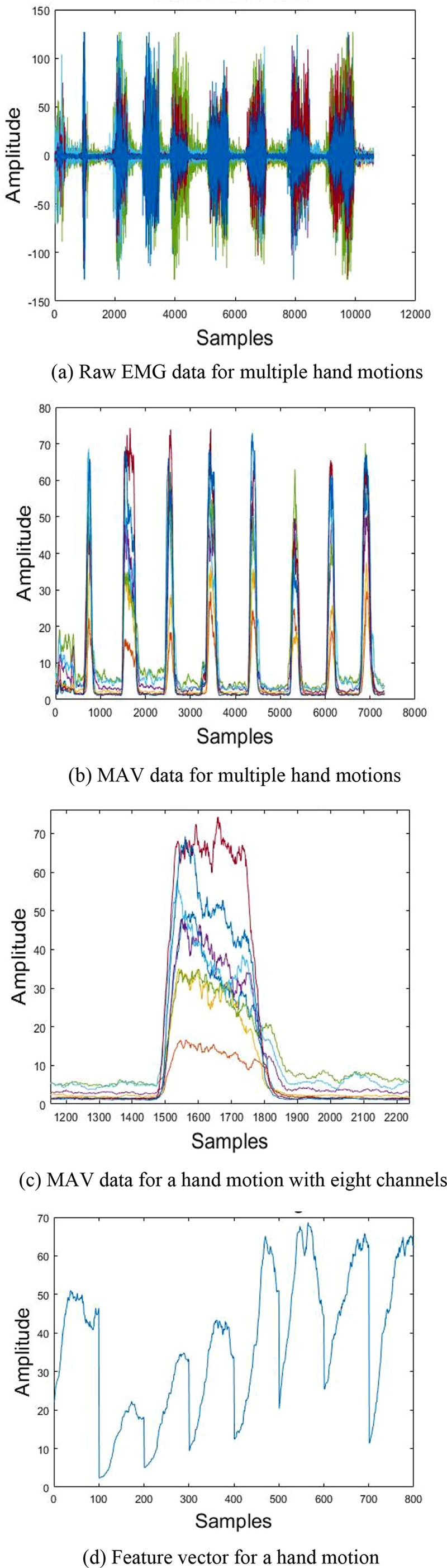

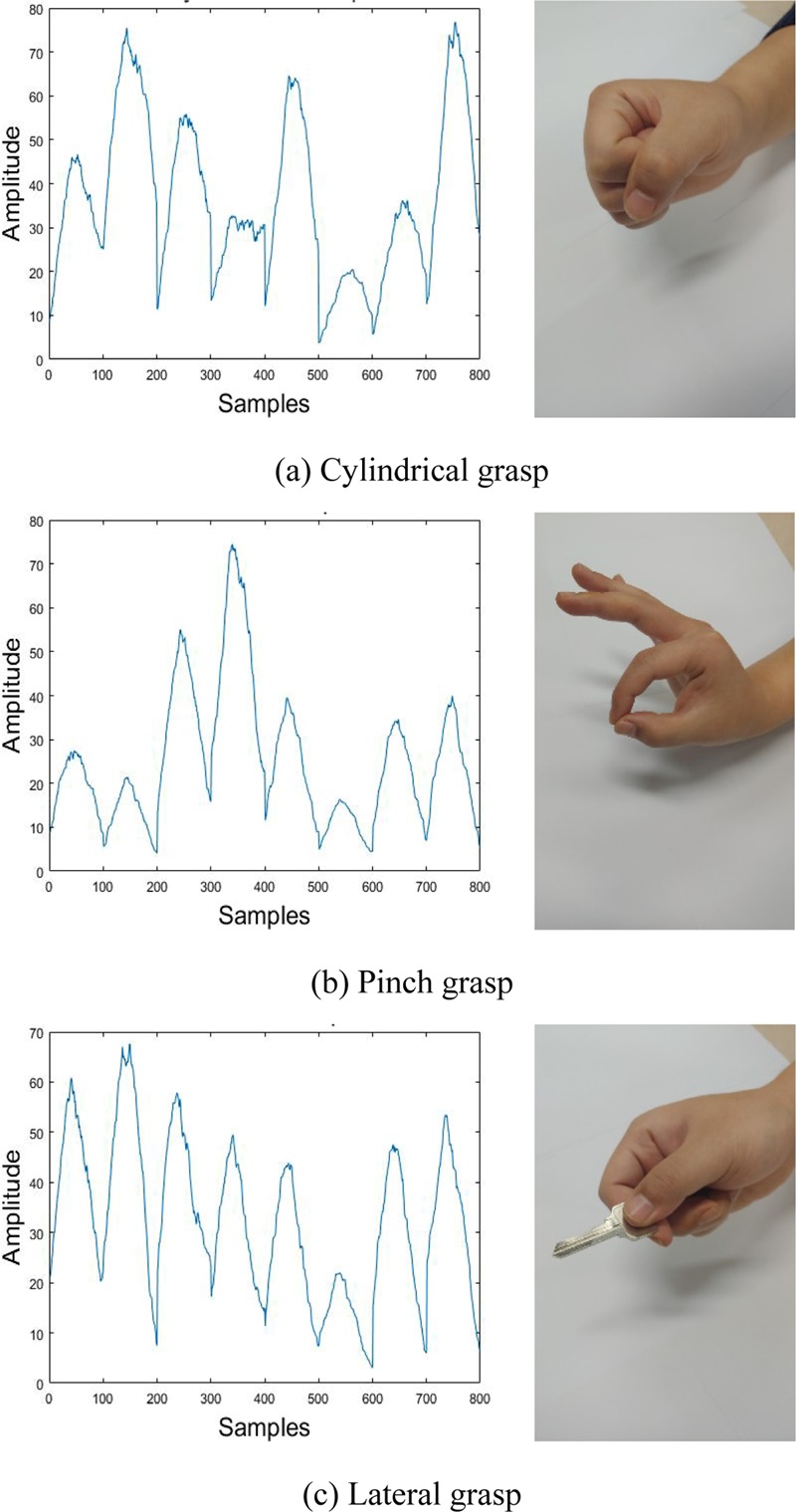

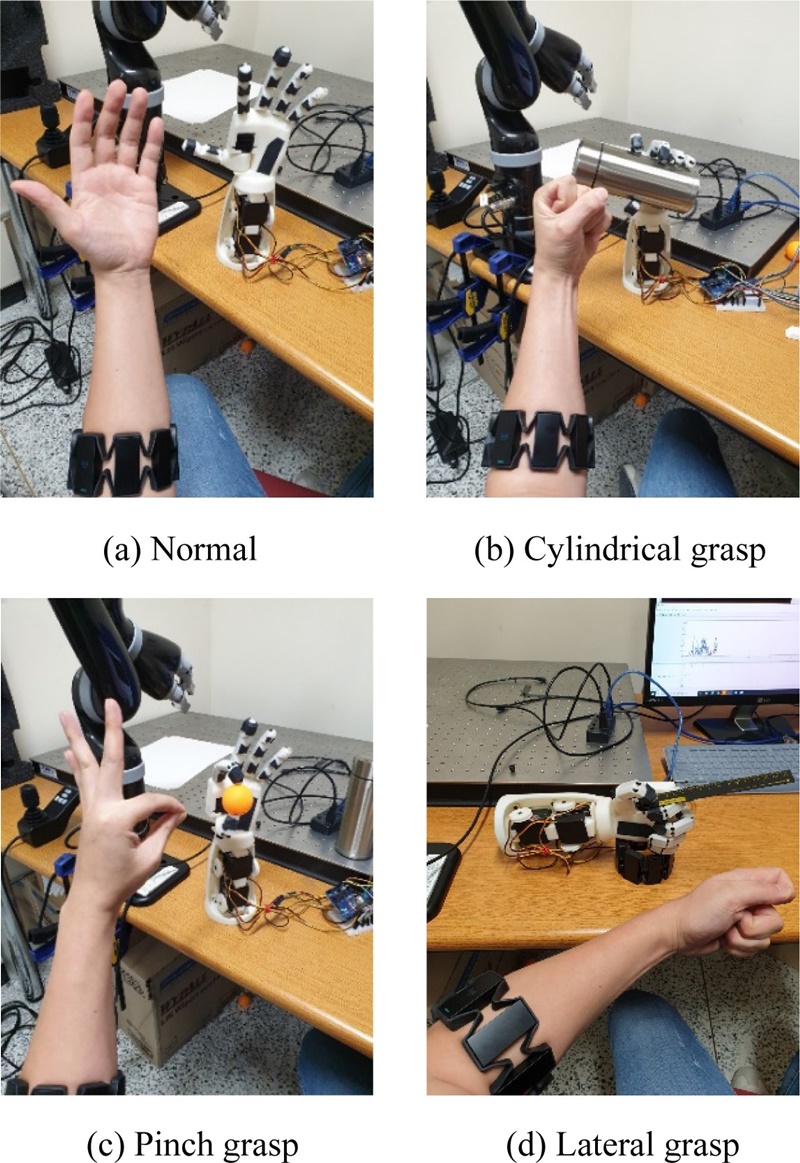

다양한 8회의 손동작에 대하여 측정된 근전도의 원신호와 절대평균값을 Figs. 5(a)와 5(b)에 각각 나타내었다. 한 가지 손동작에 대하여 동시에 8 채널의 근전도 신호가 측정되므로 Fig. 5(c)와 같이 나타나고, 데이터는 100X8 형태의 행렬로 저장된다. 이러한 데이터를 처리하기 쉽도록 Fig. 5(d)와 같이 1에서 8까지 채널의 결과를 이어 붙여서 800X1 형태의 열벡터로 변환하고, 이를 해당 동작에 대한 특징 벡터로 사용하게 된다. 본 연구에서는 일상생활에서 가장 많이 사용하는 실린더 그립(Cylindrical Grasp), 핀치 그립(Pinch Grasp), 래터럴 그립(Lateral Grasp)의 세 가지 동작에 대하여 구현할 수 있도록 하였다. 물병 등의 물건을 잡을 때 사용되는 동작이 실린더 그립, 엄지와 검지를 이용하여 작은 물체를 잡는 동작이 핀치 그립, 명함과 같이 얇은 종이 등을 잡는 동작이 래터럴 그립이다. 세 가지 동작과 해당 특징 벡터를 Fig. 6에 나타내었다. Fig. 6(a)의 실린더 그립은 물건을 잡는 형태로 구현되지만, 본 연구에서는 주먹을 쥐는 형태의 손동작을 인식하여 로봇 의수가 실린더 그립을 구현하도록 하였다.

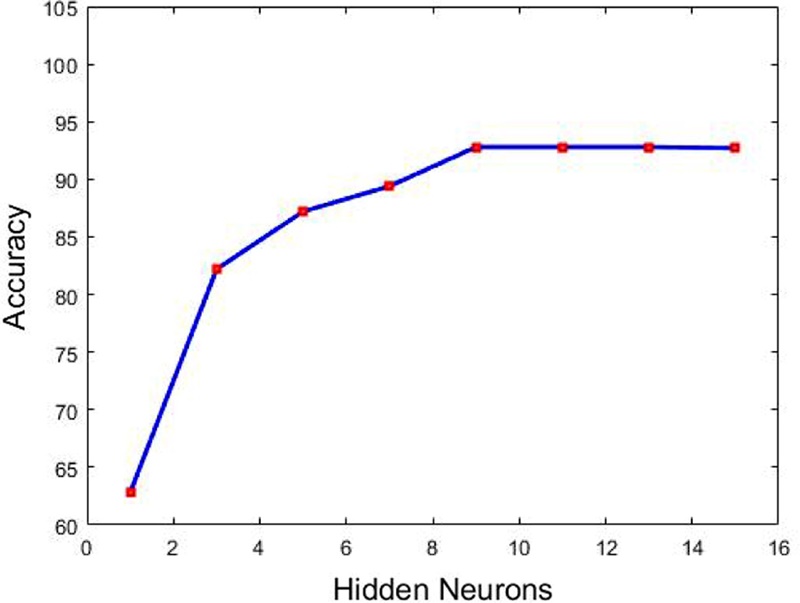

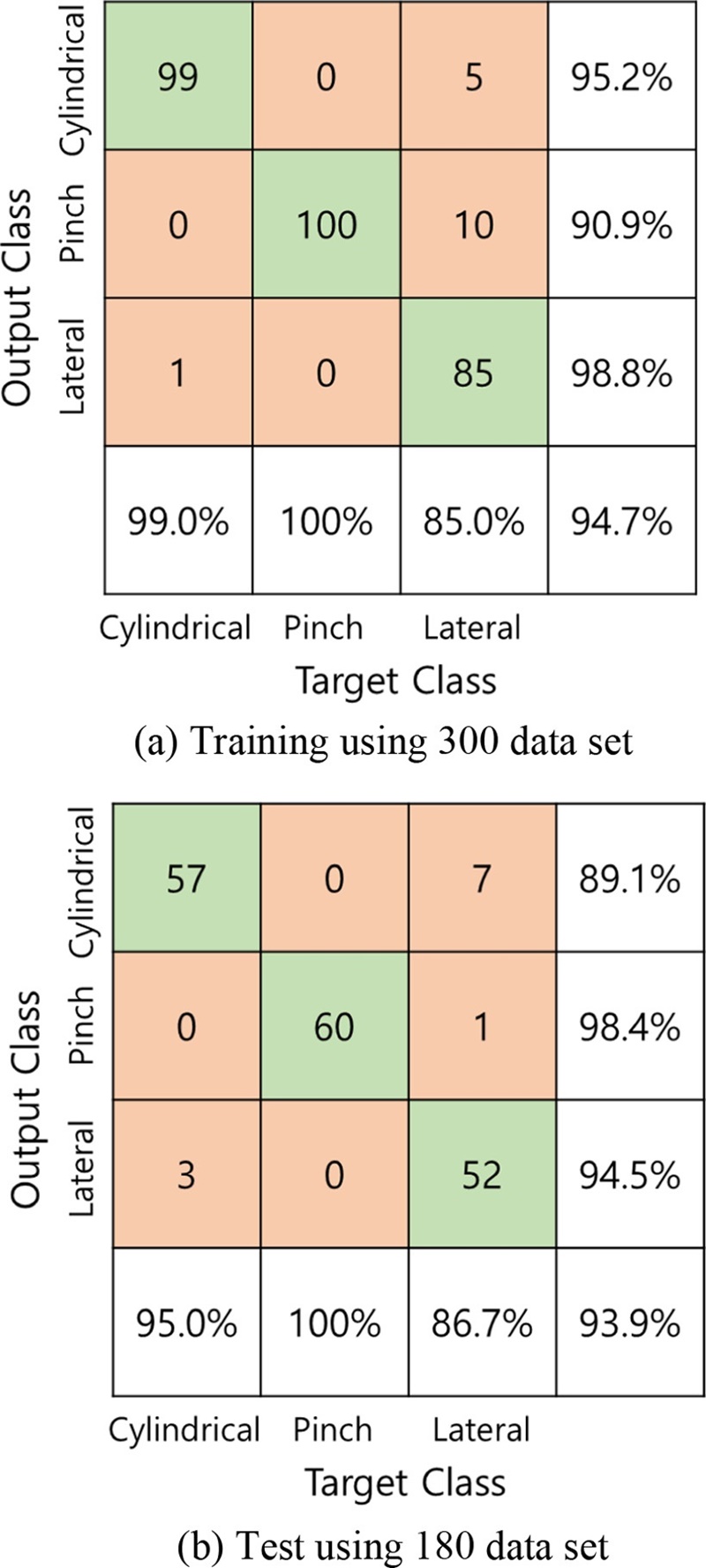

한 가지 동작을 160회 반복 측정하여 총 480개의 데이터를 확보하였고, 이 중에서 300개는 학습에 사용하고, 나머지 180개는 테스트에 사용하도록 하였다. 손동작 인식을 위한 기계 학습은 오류 역전파 알고리즘을 이용하여 학습을 진행하는 인공 신경망(Artificial Neural Network)의 다층 퍼셉트론(Multi-Layer Perceptron) 모델을 사용하였고, MATLAB의 Neural Network Toolbox를 이용하여 구현하였다. 다층 퍼셉트론은 각각 세 개의 뉴런으로 구성되는 입력층과 출력층을 갖고 있으며, 은닉층의 뉴런의 수를 변화시켜가면서 분류 정확도를 확인하였고, 이를 Fig. 7에 나타내었다. 초기에는 은닉 뉴런의 수가 증가할수록 분류 정확도가 증가하지만, 10개 이후에는 수렴하는 것을 확인할 수 있다. Fig. 8(a)에는 300개의 데이터를 이용한 학습 과정에서의 분류 정확도를 나타내었고, Fig. 8(b)에는 테스트 과정의 분류 정확도를 나타내었다. Fig. 8에서 초록색으로 표시된 부분은 목표 동작에 대해서 분류가 정확하게 된 경우이고, 붉은색으로 표시된 부분은 목표 동작과 분류된 동작이 일치하지 않는 분류가 잘못된 경우를 나타낸다. 학습 과정에서 실린더 그립과 핀치 그립은 각각 99%와 100%의 매우 높은 분류 정확도를 보였으나, 래터럴 그립은 상대적으로 낮은 85%의 분류 정확도를 갖는 것을 확인할 수 있다. 각 동작별 60개, 총 180개의 데이터를 이용한 테스트 과정에서도 핀치 그립은 100%의 매우 높은 분류 정확도를 보였으나, 실린더 그립은 래터럴 그립으로 잘못 분류되는 경우가 3회 발생하여 95%의 분류 정확도를 나타내었다. 래터럴 그립은 상대적으로 더 낮은 86.7%의 분류 정확도를 나타내었고, 실린더 그립 동작으로 잘못 분류되는 경우가 많은 것으로 나타났다. 이는 실린더 그립과 래터럴 그립의 경우, 엄지와 검지 손가락의 동작은 다소 차이가 있으나, 나머지 세 손가락은 동작이 매우 유사하기 때문인 것으로 판단된다. 이는 Fig. 8(a)의 학습 결과와 유사한 경향을 갖는 것으로 판단된다.

4. 손동작 구현

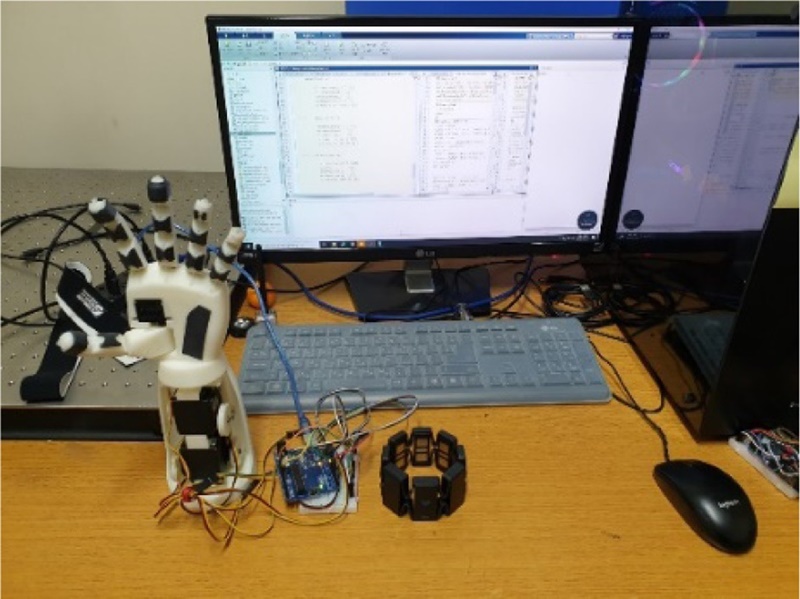

3D 프린터를 이용하여 제안된 의수 형상을 출력하고, 손가락 동작 구현을 위한 모터를 장착하여 로봇 의수를 제작하였으며, Fig. 9에 나타내었다. FDM (Fused Deposition Modeling) 방식의 3D 프린터를 사용하였으며, 친환경 수지인 PLA (Poly Lactic Acid) 필라멘트를 사용하였다. 엄지 손가락의 첫마디뼈 동작을 위한 모터는 손바닥 내부에 설치하였고, 엄지, 검지, 중지, 약지 및 소지 동작을 위하여 네 개의 모터를 손목 아랫부분에 설치하였다. 힘줄은 폴리에틸렌 재질의 지름 0.37 mm 와이어를 사용하였고, 탄성 밴드는 폴리에스테르 재질의 지름 3.5 mm 와이어를 사용하였다. 제안된 로봇 의수의 실시간 동작 구현 성능을 평가하기 위하여 Fig. 10과 같이 실험을 구성하였다. MYO를 이용하여 사람의 손동작에 대한 근전도를 측정하고 블루투스 통신을 이용하여 컴퓨터로 전달한다. 전달된 신호를 바탕으로 MATLAB을 이용하여 실시간으로 동작을 분류한다. 분류된 동작에 대하여 손가락 끝의 위치를 결정하고 이를 유선 USB 장치를 통하여 아두이노 UNO 보드로 전송하며, 아두이노 보드에서는 모터의 입력 신호를 인가하게 된다.

근전도 신호를 이용하여 사람의 손동작을 인식하고, 이를 실시간 환경에서 의수를 동작하도록 한 실험의 사진을 Fig. 11에 나타내었다. Fig. 11(a)는 초기 기본 동작 상태이다. Fig. 11(b)는 실린더 그립을 이용하여 물체를 잡는 동작, Fig. 11(c)는 핀치 그립을 이용하여 탁구공과 같은 작은 물체를 잡는 동작, Fig. 11(d)는 래터럴 그립을 이용하여 얇은 물체를 잡는 동작을 각각 구현한 것이다. 실시간 환경에서 사람 손의 동작을 인식하고 로봇 의수의 동작을 명확하게 구현하였으며 실제로 물건을 잡거나 들 수 있는 것을 확인하였다.

5. 결론

본 연구에서는 로봇 의수에 대한 설계, 해석, 제작을 수행하고 측정된 근전도 신호에 대한 실시간 손동작 구현 성능을 실험을 통하여 제안된 시스템의 성능을 평가하였다. 사람의 손가락과 동일한 구조적 특징을 갖는 의수를 설계하고, 기구학 해석을 수행하여 원하는 동작의 구현이 가능함을 확인하였다. 물건의 파지를 위한 세 가지 동작에 대한 근전도 신호를 측정하고 인공 신경망을 이용하여 평균 90% 이상의 높은 분류 정확도를 가지면서 동작을 정확하게 구분할 수 있음을 확인하였다. 실시간 환경에서, 측정된 근전도 신호를 이용하여 의도하는 손동작을 인식하고 적절한 동작을 구현할 수 있음을 3D 프린터를 이용하여 제작된 의수를 활용한 실험을 통하여 확인하였다. 다음 단계 연구에서는 추가적으로 더욱 다양한 손동작 구현을 위한 연구를 수행할 예정이며, 딥러닝 기반의 다양한 분류기에 대한 평가를 통하여 분류 정확도를 높일 수 있도록 할 것이다.

Acknowledgments

본 연구는 금오공과대학교 학술연구비로 지원되었음(No. 2018-104-122).

References

-

Saridis, G. N. and Gootee, T. P., “EMG Pattern Analysis and Classification for a Prosthetic Arm,” IEEE Transactions on Biomedical Engineering, Vol. BME-29, No. 6, pp. 403-412, 1982.

[https://doi.org/10.1109/TBME.1982.324954]

-

Matrone, G. C., Cipriani, C., Secco, E. L., Magenes, G., and Carrozza, M. C., “Principal Components Analysis Based Control of a Multi-DOF Underactuated Prosthetic Hand,” Journal of Neuroengineering and Rehabilitation, Vol. 7, No. 1, pp. 1-13, 2010.

[https://doi.org/10.1186/1743-0003-7-16]

-

Ma, J., Thakor, N. V., and Matsuno, F., “Hand and Wrist Movement Control of Myoelectric Prosthesis based on Synergy,” IEEE Transactions on Human-Machine Systems, Vol. 45, No. 1, pp. 74-83, 2014.

[https://doi.org/10.1109/THMS.2014.2358634]

-

Guo, W., Sheng, X., Liu, H., and Zhu, X., “Toward an Enhanced Human-Machine Interface for Upper-Limb Prosthesis Control with Combined EMG and NIRS Signals,” IEEE Transactions on Human-Machine Systems, Vol. 47, No. 4, pp. 564-575, 2017.

[https://doi.org/10.1109/THMS.2016.2641389]

-

Lee, S., Kim, M. O., Kang, T., Park, J., and Choi, Y., “Knit Band Sensor for Myoelectric Control of Surface EMG-Based Prosthetic Hand,” IEEE Sensors Journal, Vol. 18, No. 20, pp. 8578-8586, 2018.

[https://doi.org/10.1109/JSEN.2018.2865623]

-

Lee, S., Choi, Y., Yang, S., Hong, G. Y., and Choi, Y., “Development of Multi-DoFs Prosthetic Forearm based on EMG Pattern Recognition and Classification,” The Journal of Korea Robotics Society, Vol. 14, No. 3, pp. 228-235, 2019.

[https://doi.org/10.7746/jkros.2019.14.3.228]

-

Lee, G. H., Kwon, H. C., and Kim, K. H., “Improvement of an Underactuated Prosthetic Hand based on Grasp Performance Evaluation,” Transactions of the Korean Society of Mechanical Engineers, A, Vol. 40, No. 10, pp. 843-849, 2016.

[https://doi.org/10.3795/KSME-A.2016.40.10.843]

- Lim, H. S., Kwon, H. C., and Kim, K. H., “Development of a Haptic System for Grasp Force Control of Underactuated Prosthetics Hands,” Transactions of the Korean Society of Mechanical Engineers, A, Vol. 41, No. 5, pp. 415-420, 2017.

-

Bae, J. H., Jung, S. Y., Kim, S., Mun, M., and Ko, C. Y., “Development of Sensory Feedback System for Myoelectric Prosthetic Hand,” Journal of the Korean Society for Precision Engineering, Vol. 32, No. 10, pp. 851-856, 2015.

[https://doi.org/10.7736/KSPE.2015.32.10.851]

-

Noh, J., Cho, W., and Kim, J. H., “Design of a Regression Model for Four Grasping Patterns and Three Grip Force Intensities of a Myoelectric Prosthetic Hand,” Journal of the Korean Society for Precision Engineering, Vol. 35, No. 8, pp. 809-816, 2018.

[https://doi.org/10.7736/KSPE.2018.35.8.809]

-

Kim, D. E., Yu, J. H., and Sim, K. B., “EEG Feature Classification for Precise Motion Control of Artificial Hand,” Journal of Korean Institute of Intelligent Systems, Vol. 25, No. 1, pp. 29-34, 2015.

[https://doi.org/10.5391/JKIIS.2015.25.1.029]

-

Jo, Y. U. and Oh, D. C., “Study on the EMG-Based Grasp Gesture Classification Using Deep Learning and Application to Active Prosthetics,” Journal of Institute of Control, Robotics and Systems, Vol. 25, No. 3, pp. 229-234, 2019.

[https://doi.org/10.5302/J.ICROS.2019.19.8002]

M.Sc. candidate in the Department of Mechanical Design Engineering, Kumoh National Institute of Technology. His research interest is design and control of smart rehabilitation systems with machine learning algorithm.

E-mail: ghaud6614@kumoh.ac.kr

Professor in the Department of Mechanical Design Engineering, Kumoh National Institute of Technology. His research interests are smart systems control, robotics, and applications of artificial intelligence.

E-mail: jwsohn@kumoh.ac.kr