영상기반 파지 동작 제어를 위한 딥러닝 기반 물체검출과 파지물체 선정

Copyright © The Korean Society for Precision Engineering

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License (http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

Abstract

Hands perform various functions. There are many inconveniences in life without the use of hands. People without the use of hands wear prostheses. Recently, there have been many developments and studies about robotic prosthetic hands performing hand functions. Grasping motions of robotic prosthetic hands are integral in performing various functions. Grasping motions of robotic prosthetic hands are required recognition of grasping targets. A path toward using images to recognize grasping targets exists. In this study, object recognition in images for grasping motions are performed by using object detection based on deep-learning. A suitable model for the grasping motion was examined through three object detection models. Also, we present a method for selecting a grasping target when several objects are recognized. Additionally, it will be used for grasping control of robotic prosthetic hands in the future and possibly enable automatic control robotic prosthetic hands.

Keywords:

Deep learning, Object detection, Grasping, Robotic prosthetic hand키워드:

딥러닝, 물체검출, 파지, 로봇의수1. 서론

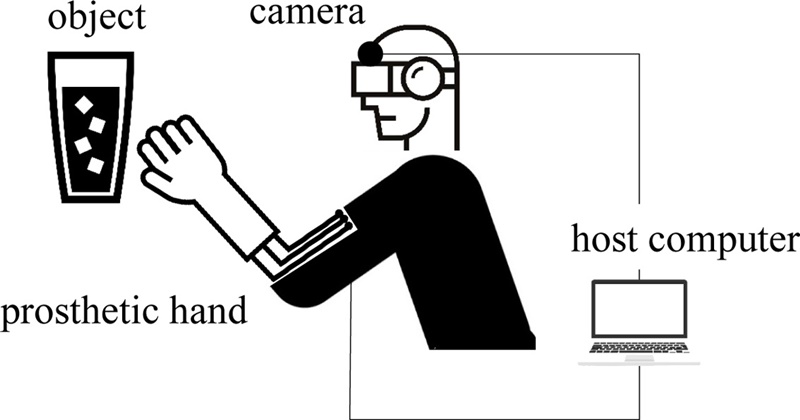

전쟁과 산업재해 등 여러 원인으로 과거에서부터 현재까지 손이 절단된 환자들은 지속적으로 발생하고 있다. 손은 일상생활에서 많은 기능을 수행하기 때문에 손이 없는 불편함은 매우 클 것이다. 손의 기능을 대체하기 위해 의수의 개발 및 사용이 이루어지고 있고, 근래에는 로봇공학과 생체공학의 발전으로 다양한 기능과 자연스러운 동작이 가능한 로봇의수가 개발되고 있다.1,2 로봇의수는 기구학적 다자유도 구현을 통해 실제 손과 같은 자유로운 움직임이 가능하게 하는 것도 중요하지만 물체를 사용자의 의도에 맞게 파지할 수 있도록 제어하는 기술의 개발이 절실하다. 이를 위해 절단 부위 근처 피부에서 획득한 근전도 신호를 분석하여 로봇의수를 제어하는 연구들이 주로 소개되어 왔다.3,4 하지만 근전도를 이용하는 방식은 절단 장애인의 절단 부위나 잔존 근육의 형태 등이 개인마다 다르므로 근전도 신호의 패턴 대비 파지 의도 간의 관계를 일반화하기 어렵다는 문제가 있다. 이 때문에 일부 상용화된 로봇의수의 경우 파지 동작을 제어하기 위해 의수 장치에 달려있는 파지 동작 버튼을 누르거나 스마트폰 앱을 통한 무선조작을 통해 파지 동작을 결정하는 경우도 있다.5,6 본 연구에서는 기존의 파지 동작 제어 방식이 아니라 Fig. 1과 같이 1인칭 시점의 카메라를 절단 장애인이 착용하고 이를 통해 얻은 영상에서 물체를 검출하고 물체의 형상에 따른 파지 동작을 자동으로 구분하고자 한다. 특히 전통적인 컴퓨터 비전 기술을 이용한 영상기반 물체검출이 아닌 최근 많은 분야에 응용되고 있는 딥러닝 기반 물체검출 기술을 접목하고자 한다. 로봇의수의 파지 대상 검출을 위해 딥러닝 기술을 접목한 사례로, EOG (Electrooculography) 신호와 카메라를 사용하여 영상 내 하나의 물체만 나타나도록 영상을 획득하고 딥러닝 Classifier를 통해 물체 형태를 검출하는 연구가 소개된 바 있다.7 또한 하나의 물체가 촬영된 영상 내 배경을 다양한 기법으로 삭제하고 딥러닝 Classifier와 근전도 신호로 로봇의수 파지 동작을 제어하는 연구가 소개되었다.8 하지만 이와 같은 연구들은 여러 전처리가 필요하고 각 연구에서 자체 제작한 CNN 알고리즘을 사용하여 현재 개발 중인 로봇의수 시스템에 적용하거나 수정 및 보완이 어렵다.

본 연구에서는 수정과 보완이 용이하도록 현재 공개된 3가지 물체검출 알고리즘 YOLO (You Only Look Once) v3,9,10 Inception SSD (Single Shot MultiBox Detector)11,12 그리고 Mobilenet SSD11,13 알고리즘으로 대표적인 파지 동작인 Cylindrical Grasp와 Tripod Pinch에 대한 물체를 재학습 후 테스트를 통해 최적의 알고리즘을 선정하였다. 또한 영상 내 여러 파지 대상 물체가 검출되었을 때 하나의 파지 대상을 선정하는 방식에 대해 소개하고자 한다.

2. 딥러닝 기반 물체검출 방법

앞서 선정한 3가지 알고리즘의 선정 배경으로 Faster R-CNN (Regions with CNN),14 Mask R-CNN15 등 기존 Object Detection 알고리즘들과 같이 높은 정확도를 가지지는 않지만 실시간 동작이 가능하도록 높은 계산 속도와 전처리 작업이 없는 YOLOv3, Inception SSD와 Mobilenet SSD 알고리즘을 선택하였다. 2장에서는 선택한 알고리즘들에 대한 설명은 다음과 같다.

2.1 YOLO Algorithm

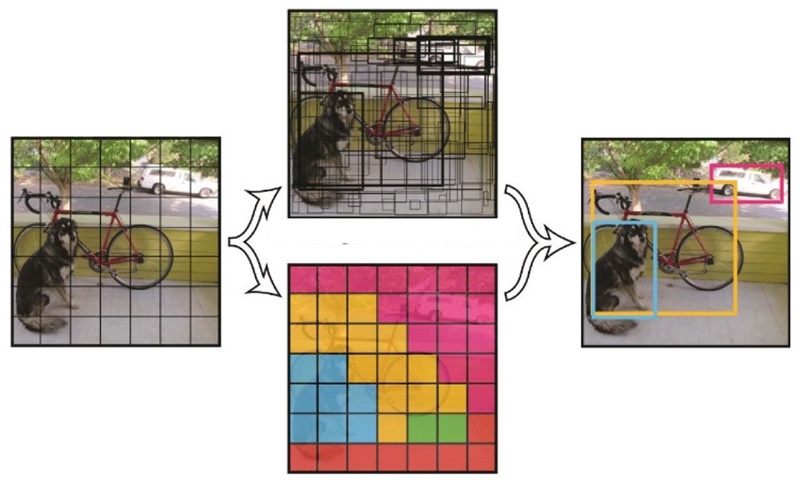

우선 YOLO는 2015년 소개되었다.9 YOLO가 소개되던 당시 기존에 소개되었던 알고리즘들은 이미지 내 물체의 경계 상자를 찾기 위한 Region Proposal과 경계 상자 내 물체의 종류를 구별하는 Classification 두 단계를 거치게 된다. 이러한 알고리즘들은 높은 정확도를 가지지만 Region Proposal에서 많은 수의 경계 상자 추정으로 인해 실행속도가 느리다는 단점이 있었다. YOLO는 실행속도가 느린 단점을 해결하고자 아래의 Fig. 2에서 볼 수 있듯이 이미지를 격자로 나누어 각각의 격자에서 일정 수의 경계 상자와 박스 내 물체 종류를 동시에 추정하도록 두 단계를 한 단계로 합하여 진행하였다. 두 단계를 거치는 기존 알고리즘들보다 경계 상자를 추정하는 횟수가 줄어들어 정확도는 낮아지고 실행속도를 위해 격자를 크게 나누어 영상 내 작은 물체는 식별이 어렵다는 문제가 있지만 실행속도가 상당히 높아진 알고리즘을 소개하였다. 실행속도는 유지하고 정확도와 작은 물체검출을 위한 다양한 기법10을 시도한 v3 버전을 본 연구에서는 사용하였다.

2.2 SSD Algorithm

다음으로 Inception SSD와 Mobilenet SSD에 공통적으로 들어가는 SSD이다.11 SSD는 Fig. 2의 YOLO와 동일하게 이미지를 격자로 나누어 각 격자당 경계 상자와 물체 식별을 동시에 진행한다. 하지만 YOLO와 다른 점은 대표적으로 Convolution 연산으로 영상에서 Feature Map을 추출하는데 이 Feature Map을 크기가 다르게 추출한다. 이것으로 영상 내 영역을 많이 차지하지 않는 작은 물체는 큰 Feature Map에서 경계 상자와 물체 식별이 이루어지고, 영상 내 영역을 많이 차지하는 큰 물체는 작은 Feature Map에서 경계 상자와 물체 식별이 이루어진다. 이로 인해 높은 실행속도와 정확도를 가진다고 소개하였다.

SSD 알고리즘은 Feature Map을 추출하는 다른 알고리즘 구조를 가지고 이후에 여러 보조적인 구조를 추가하였다. 그러므로 Feature를 추출하는 알고리즘을 추가해야 한다. 본 연구에서는 이 Feature를 추출하는 알고리즘으로 Inception과 Mobilenet을 사용하였다. 여기서 Inception은 Google에서 개발한 알고리즘으로 딥러닝 연산 중 하나인 Convolution 연산을 좀 더 작은 형태의 Convolution 연산 조합으로 분할하여 계산하는 방식이다. 이를 통해 전체 연산해야 할 알고리즘의 Parameter 수를 줄이는 결과를 소개하였다.12 그리고 M obilen et은 속도를 향상시키기 위해 Convolution 연산을 변형하여 Depth-Wise Separable Convolution (DSC)을 사용한다. 이 DSC를 사용하면 정확도에는 영향을 크게 미치지 않지만 계산량이 약 9배 낮아지는 결과가 나타났다.13 이 2가지 알고리즘을 SSD 알고리즘 앞 Feature를 추출하는 구조에 적합하여 사용하였다.

3. 딥러닝 학습 방법

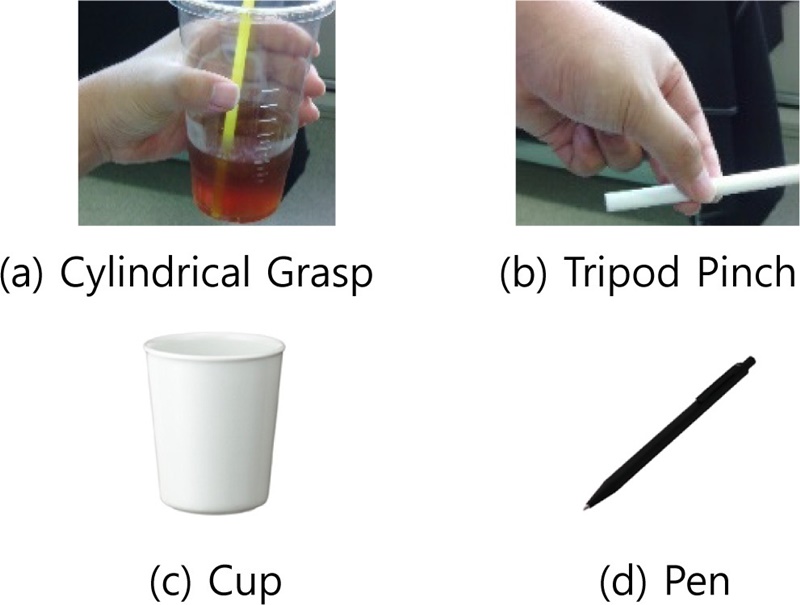

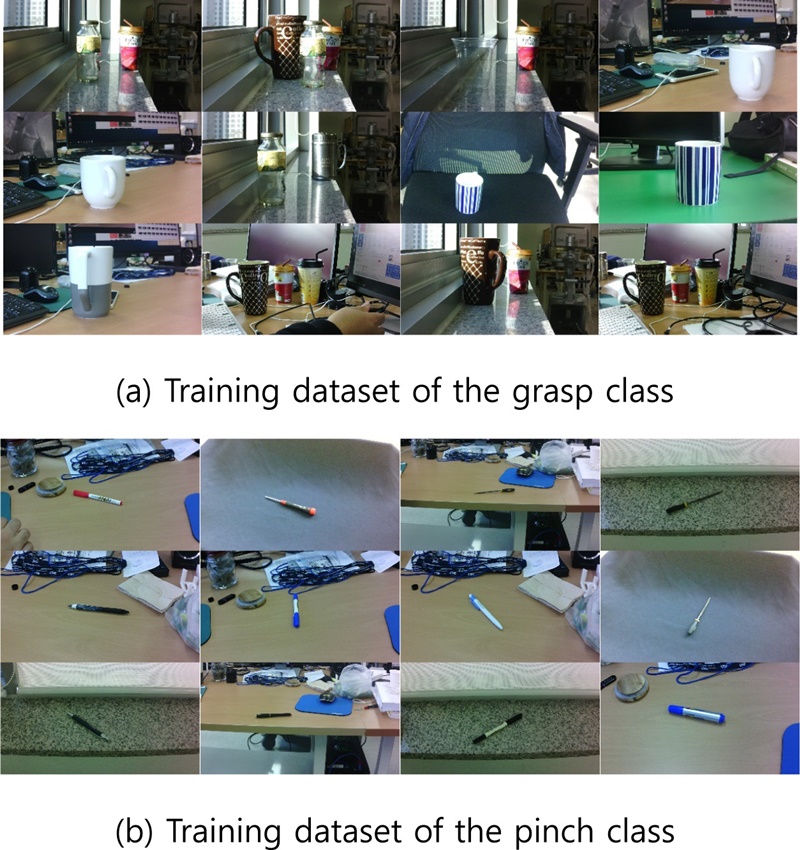

로봇의수 파지 동작 제어의 최적인 알고리즘을 선정하기 위한 후보 알고리즘들을 살펴보았다. 후보 알고리즘들 중 가장 최적의 알고리즘을 선정하기 위해 파지 동작에 맞추어 알고리즘들을 재학습하였다. 재학습 시 물체 인식을 위한 Class는 Figs. 3(a)와 3(b)와 같이 Cylindrical Grasp, Tripod Pinch의 2가지 파지 동작을 선정하였고, 파지 동작별 대표되는 물체를 Figs. 3(c)와 3(d)에 나타냈다. 학습에는 Figs. 3(c)와 3(d)를 인식하도록 Training Dataset을 구축하였다. 2가지 파지 동작의 선정 배경은 다양한 파지 동작이 있지만 그 중 사용 빈도 수가 가장 높고 동작별 물체 외부 모양 차이가 두드러지게 나타나는 2가지를 선택하였다. 재학습에 필요한 2가지 물체 이미지 3000장을 촬영하였고, 몇 가지 대표되는 훈련 이미지를 Fig. 4에 나타내었다. 이미지의 크기는 촬영 시 1920 × 1080 크기로 촬영하였고, Training 시 300 × 300의 크기로 Resize하여 입력하였다. 훈련 이미지의 정답이 되는 이미지 내 물체의 위치와 크기, 물체의 종류가 표현된 Label을 PASCAL VOC Dataset 양식을 따라 작성하였다. 모든 알고리즘들은 2가지 Class만 식별하도록 마지막 Layer를 수정하였고, Imagenet Dataset을 통해 미리 학습되어 있는 가중치를 기반으로 재학습하였다. 재학습 시 사용된 환경은 i7-4790(CPU), 16 GB (RAM), NVIDIA TITAN X (GPU) 그리고 UBUNTU 16.04의 환경과 하드웨어이고 Test 역시 동일한 환경과 하드웨어에서 진행하였다.

4. 딥러닝을 이용한 물체검출

4.1 학습된 딥러닝을 이용한 물체검출 방법

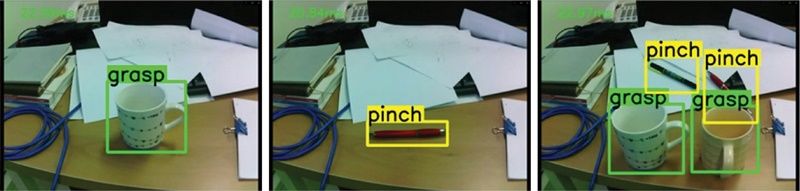

의수로봇 제어에 최적인 알고리즘을 선정하기 위해 테스트를 진행하였다. 알고리즘 비교를 위해 정확한 의수로봇 제어에 필요한 물체검출 성능, 즉 mAP (mean Average Precision)16와 실시간 의수로봇 제어를 위해 물체검출 시 소요되는 계산 속도를 측정하였다. mAP와 계산 속도를 측정하기 위해 학습에 사용하지 않은 새로운 물체로 100장의 이미지를 촬영하였다. 이미지는 학습과 동일하게 1920 × 1080 크기로 촬영되었고, 300 × 300 크기로 Resize하여 알고리즘에 입력하였다. 테스트를 통해 검출된 결과에서는 Class 이름을 간결하게 “Cylindrical Grasp”은 “Grasp”으로, “Tripod Pinch”는 “ Pinch”로 표현하였으며 몇 가지 결과 이미지를 Fig. 5에 나타내었다.

4.2 학습된 딥러닝을 이용한 물체검출 결과

4.1절에서 언급한 방법으로 테스트를 진행하였고 mAP 도출에 필요한 False Positive (FP)와 True Positive (TP)를 찾아 Table 2에 나타내었다. 여기서 FP는 테스트 영상 내 검출된 물체 중 정답과 다른 검출을 말하고, TP는 FP와 반대로 정답과 동일한 검출을 말한다. Table 2에서는 전체 테스트를 통해 검출된 물체들 중 TP와 FP 수를 나타낸 것이고, 이를 통해 검출된 물체 중 얼마나 정확한 물체검출이 이루어졌는지 확인할 수 있다. 각 알고리즘별 FP의 수를 보면 Inception SSD와 Mobilenet SSD는 49이지만 YOLOv3는 23으로 다른 두 알고리즘에 비해 낮게 나타난다. 이는 YOLO가 다른 두 알고리즘에 비해 물체검출 시 배경에 의한 영향이 적은 특징이 있기 때문으로 판단된다. Table 2의 결과를 이용하여 각 알고리즘별 mAP를 도출하였고 1장의 이미지가 계산되는 시간을 측정하여 Table 1에 각각 나타내었다. 의수로봇 제어에 중요한 성능 지표인 검출 정확도와 검출 속도를 고려하여 의수로봇 제어에 가장 적합한 알고리즘을 선정하였다. 그 결과 mAP 80%, 계산 속도는 21 ms의 성능을 가지는 YOLOv3를 의수로봇 제어를 위한 물체검출 알고리즘으로 선정하였다.

5. 이미지 분류와 파지 대상 선정

5.1 파지 대상 선정 방법

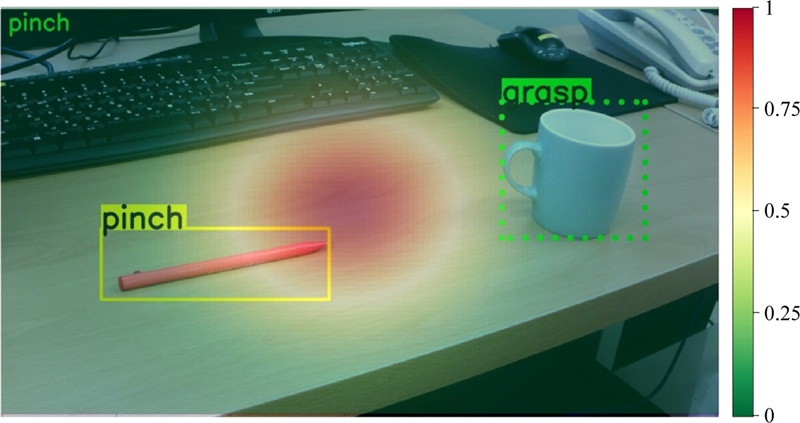

만약 획득한 영상 내 여러 개의 파지 후보 물체가 검출되는 경우 로봇의수 파지 동작 결정을 위한 하나의 파지 대상 선정이 필요하다. 본 연구에서는 1인칭 카메라로 영상을 획득하므로 영상의 중심에 파지 대상이 존재할 것으로 가정하였다. 따라서 파지 대상이 영상 내에 존재할 확률을 영상 중심을 기준으로

| (1) |

식(1)과 같은 2차원 가우시안 분포를 나타낸다고 가정하였다. 식(1)에서 x는 확률 변수 벡터이고, ∑는 공분산 행렬이며 μ와 det는 평균 벡터와 행렬식(Determinant)이다. 물론 이때 공분산 행렬(∑)은 개인마다 달라질 수 있다. Fig. 6의 경우 파지 대상 선정 실험을 위해

| (2) |

으로 하였다. 이를 실제 이미지 위에 투영하면 Fig. 6과 같다. 또한 영상 내 여러 물체가 검출되었을 때 물체별 대푯값(P)을

| (3) |

로 정의하였다. 여기서, 대푯값은 검출된 경계 상자 내 각 픽셀(Pixel) 위치(g)에 따른 확률 값(A)을 모두 합하여 경계 상자 내 전체 픽셀 수(G)로 나눈 값이다. 이와 같은 방법으로 여러 개의 물체가 동시에 검출되었을 때 가장 높은 대푯값(P)을 가지는 물체를 파지 대상으로 선정하였다. Fig. 6에서 볼 수 있듯이 파지 대상으로 선정된 Tripod Pinch는 경계 상자가 실선으로 나타나며, 이미지의 왼쪽 상단에 선정된 파지 대상이 표시되도록 하였다.

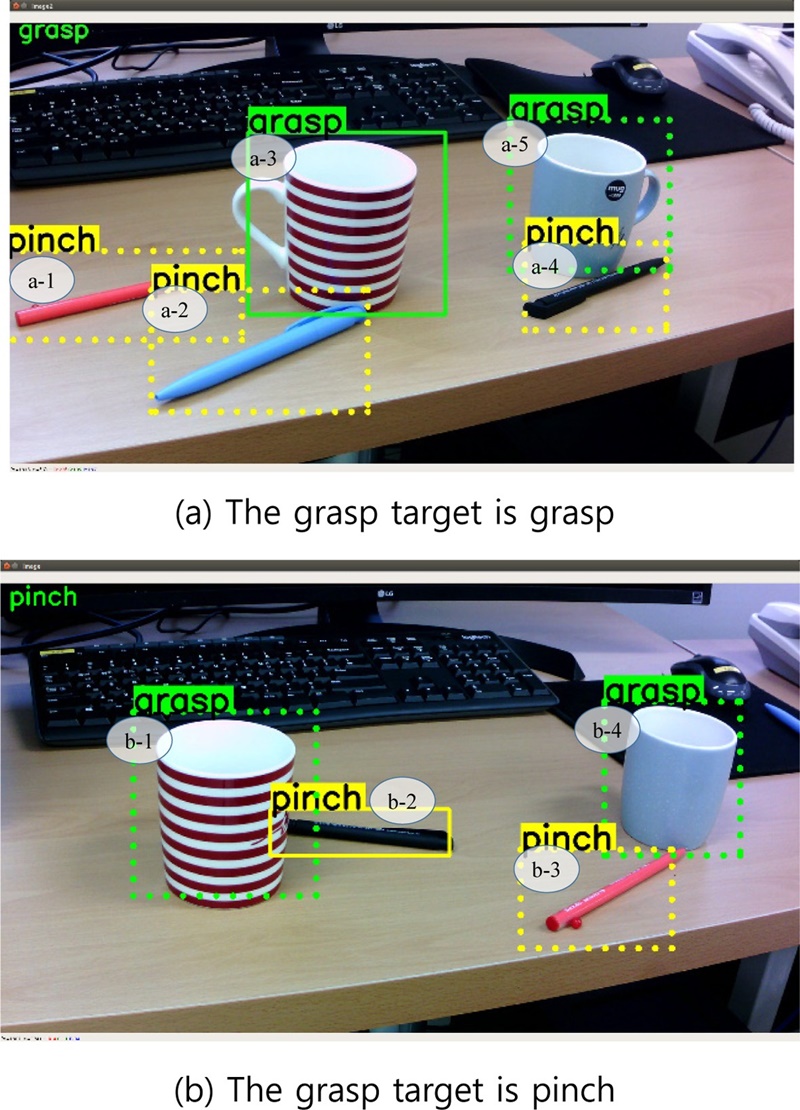

5.2 파지 대상 선정 수행 결과

Fig. 7(a)는 파지 대상이 중심부 a-3의 물체가 가장 높은 값(12.1%)을 가지는 경우의 이미지이고, Fig. 7(b)는 중심부 b-2의 물체가 가장 높은 값(8.7%)을 가지는 경우이다. 각 물체가 파지 대상이 될 확률을 Table 3에 정리하였다. 두 이미지 모두 파지 대상으로 선정된 물체의 대푯값이 가장 높게 나타나고 경계 상자가 실선으로 표시되며 각 이미지의 왼쪽 위에 선정된 파지 대상이 잘 표시되는 것을 확인할 수 있었다.

6. 토의

본 논문은 로봇의수의 대표적인 2가지 파지 동작인 Cylindrical Grasp, Tripod Pinch를 적용할 수 있는 물체들에 대하여 학습을 수행하고 딥러닝 알고리즘별 물체검출 정확도와 계산 속도를 측정하여 로봇의수 제어에 적합한 알고리즘을 찾았다. 그 결과 YOLOv3가 최적의 알고리즘으로 선정되었다. 그리고 하나의 영상 내 여러 물체가 검출되었을 때 영상 내 파지 대상이 존재할 확률을 바탕으로 파지 대상을 선정하였고, 실시간으로 촬영된 각 이미지에 대해 파지 대상 검출을 수행하였다. 향후 좀 더 다양한 종류의 파지 동작과 다양한 학습 데이터로 딥러닝 알고리즘을 학습하여 다양한 물체에 적합한 파지 동작 검출이 가능하도록 할 예정이다. 본 논문에서의 파지 대상 선정 실험은 정상인의 1인칭 시점 영상을 이용하여 진행되었다. 이는 실제 로봇의수를 착용한 절단 환자의 시점에서 파지 대상 선정 확률과 차이가 있을 것이라 예상된다. 이를 보완하기 위해 절단 환자가 착용한 로봇의수를 인식하고 검출된 물체와의 관계를 파악하여 파지 대상을 선정하는 방법을 제안할 것이며, 로봇의 수 제어를 위해 선정된 파지 대상을 물체검출과 파지 대상 선정이 이루어지는 Host PC에서 무선으로 의수로봇에 전송하여 파지 대상에 적합한 파지 동작이 구동될 수 있도록 계획 중이다. 영상기반 의수로봇 제어는 기존 연구3,4,6와 다르게 파지 동작이 시작될 시점이 중요하다. 이는 앞서 계획한 로봇의수를 인식하여 물체와 로봇의수 간 관계로 파지 동작 제어 시점을 결정할 수 있을 것이다. 그리고 2차원 영상을 이용하여 공간상 로봇의 수와 대상 물체의 정확한 위치 관계 파악이 어려울 것이므로 3차원 데이터를 이용하여 이러한 문제를 해결하는 연구를 계획하고 있다. 4.2절의 Table 1에서 YOLOv3의 mAP가 다른 두 알고리즘보다 높게 나타나는 것을 볼 수 있는데 이는 COCO Dataset17을 이용하여 알고리즘을 훈련하여 계산하고 공개한 mAP 값18,19 Mobilenet SSD = 21%,18 Inception SSD = 24%,18 YOLOv3 = 52%19을 비교하여도 YOLOv3의 mAP 값이 다른 두 알고리즘보다 높게 나타나는 것을 알 수 있다. 또한 Table 2를 보면 각 알고리즘에서 모두 “Grasp”의 FP가 높게 나타나는데 이는 훈련 데이터로 사용된 “Cup”이 다양한 물체들과 상황의 영상이 충분히 학습되지 못한 것으로 보인다. 향후 좀 더 다양하고 많은 양의 학습 데이터를 확보하고 학습한다면 좀 더 높은 정확도를 가질 수 있을 것으로 보인다.

7. 결론

본 논문에서는 로봇의수의 자동적인 자세 추정을 위한 첫 번째 단계로 로봇의수 제어에 적합한 딥러닝 기반 Object Detection 알고리즘을 선정하였고, 영상 내 여러 물체가 검출 되었을 때 하나의 파지 대상을 선정하는 방식을 소개하였다. 구체적으로, 로봇의수 제어에 적합한 Object Detection 후보 알고리즘은 Inception SSD, Mobilenet SSD, 그리고 YOLOv3이다. 이들을 본 논문에서 설정한 2가지 파지 동작과 물체를 이용하여 재학습하고 테스트를 통해 mAP와 실행속도를 비교하였다. 그 결과 YOLOv3 알고리즘이 최적의 알고리즘의 결과를 알 수 있었다. 또한 하나의 영상 내 여러 물체들이 검출되었을 때 하나의 물체에 대해서만 파지 동작이 결정되어야 하므로 영상의 중심에 파지 대상이 존재할 것으로 가정하고 검출된 물체의 대푯값을 계산하여 대푯값이 가장 큰 물체를 파지 대상으로 선정하였다. 몇가지 테스트를 통해 파지 대상 선정이 잘 이루어지는 것을 확인하였다. 이를 통해 기존 연구3-6대비 편리하고 효과적인 의수로봇 파지 동작 제어 방법이 될 것으로 기대한다.

Acknowledgments

이 연구 결과는 한국기계연구원 기관고유과제(No. NK217F)와 과학기술정보통신부의 재원으로 국가과학기술연구회 창의형 융합 연구사업(No. CAP-18-01-KIST)에 의한 연구결과임.

References

-

Weiner, P., Starke, J., Hundhausen, F., Beil, J., and Asfour, T., “The KIT Prosthetic Hand: Design and Control,” Proc. of the IEEE/RSJ International Conference on Intelligent Robots and Systems, pp. 3328-3334, 2018.

[https://doi.org/10.1109/IROS.2018.8593851]

-

Roy, R., Roy, A., and Mahadevappa, M., “Adaptive Grasping Using an Interphalangeal Flexion Angle Model and Particle Swarm Optimization,” Proc. of the 7th IEEE International Conference on Biomedical Robotics and Biomechatronics, pp. 695-700, 2018.

[https://doi.org/10.1109/BIOROB.2018.8487795]

-

Kim, D., Kang, B. B., Kim, K. B., Choi, H., Ha, J., et al., “Eyes Are Faster than Hands: A Soft Wearable Robot Learns User Intention from the Egocentric View,” Science Robotics, Vol. 4, No. 26, pp. 1-3, 2019.

[https://doi.org/10.1126/scirobotics.aav2949]

-

Hwang, M. J., “Sensor-Based Recognition of Human's Hand Motion for Control of a Robotic Hand,” Journal of the Korea Academia-Industrial Cooperation Society, Vol. 15, No. 9, pp. 5440-5445, 2014.

[https://doi.org/10.5762/KAIS.2014.15.9.5440]

-

Fajardo, J., Ferman, V., Muñoz, A., Andrade, D., Neto, A. R., et al., “User-Prosthesis Interface for Upper Limb Prosthesis based on Object Classification,” Proc. of the Latin American Robotic Symposium, Brazilian Symposium on Robotics and Workshop on Robotics in Education, pp. 390-395, 2018.

[https://doi.org/10.1109/LARS/SBR/WRE.2018.00076]

- Moon, M. K., Kwak, H. G., Yoo, D. H., and Kang, S. M., “Development of a Prosthetic Arm for Controlling Fingers Using Arduino,” Proc. of the HCI Society of Korea Conference, pp. 334-337, 2017.

-

Roy, R., Kumar, A., Mahadevappa, M., and Kumar, C. S., “Deep Learning Based Object Shape Identification from EOG Controlled Vision System,” Proc. of the SENSORS, pp. 1-4, 2018.

[https://doi.org/10.1109/ICSENS.2018.8589722]

-

Ghazaei, G., Alameer, A., Degenaar, P., Morgan, G., and Nazarpour, K., “Deep Learning-Based Artificial Vision for Grasp Classification in Myoelectric Hands,” Journal of Neural Engineering, Vol. 14, No. 3, Paper No. 036025, 2017.

[https://doi.org/10.1088/1741-2552/aa6802]

-

Redmon, J., Divvala, S., Girshick, R., and Farhadi, A., “You Only Look Once: Unified, Real-Time Object Detection,” Proc. of the IEEE Conference on Computer Vision and Pattern Recognition, pp. 779-788, 2016.

[https://doi.org/10.1109/CVPR.2016.91]

- Redmon, J. and Farhadi, A., “YOLOv3: An Incremental Improvement,” https://arxiv.org/pdf/1804.02767.pdf, (Accessed 9 APR 2020)

-

Liu, W., Anguelov, D., Erhan, D., Szegedy, C., Reed, S., et al., “SSD: Single Shot Multibox Detector,” Proc. of the European Conference on Computer Vision, pp. 21-37, 2016.

[https://doi.org/10.1007/978-3-319-46448-0_2]

-

Szegedy, C., Vanhoucke, V., Ioffe, S., Shlens, J., and Wojna, Z., “Rethinking the Inception Architecture for Computer Vision,” Proc. of the IEEE Conference on Computer Vision and Pattern Recognition, pp. 2818-2826, 2016.

[https://doi.org/10.1109/CVPR.2016.308]

- Howard, A. G., Zhu, M., Chen, B., Kalenichenko, D., Wang, W., et al., “Mobilenets: Efficient Convolutional Neural Networks for Mobile Vision Applications,” https://arxiv.org/pdf/1704.04861.pdf, (Accessed 9 APR 2020)

- Ren, S., He, K., Girshick, R., and Sun, J., “Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks,” Advances in Neural Information Processing Systems, pp. 91-99, 2015.

-

He, K., Gkioxari, G., Dollár, P., and Girshick, R., “Mask R-CNN,” Proc. of the IEEE International Conference on Computer Vision, pp. 2961-2969, 2017.

[https://doi.org/10.1109/ICCV.2017.322]

-

Henderson, P. and Ferrari, V., “End-to-End Training of Object Class Detectors for Mean Average Precision,” Proc. of the Asian Conference on Computer Vision, pp. 198-213, 2016.

[https://doi.org/10.1007/978-3-319-54193-8_13]

- COCO Object Detection Dataset, “COCO Common Object in Context,” http://cocodataset.org/#download, (Accessed 22 APR 2020)

- Tensorflow, “Tensorflow Detection Model Zoo,” https://github.com/tensorflow/models/blob/master/research/object_detection/g3doc/detection_model_zoo.md, (Accessed 9 APR 2020)

- YOLO: Real-Time Object Detection, “Performance on the COCO Dataset,” https://pjreddie.com/darknet/yolo/, (Accessed 22 APR 2020)

Ph.D. candidate in the Department of Electrics Engineering, Kyung Pook National University and Korea Institute of Machinery & Materials. His research interest is robotic control.

E-mail: haejune@kimm.re.kr

Professor in School of Electronics Engineering, Kyungpook National University. His research interests are robot, machine vision, robot sensor and operating system, and medical robot system.

E-mail: minyoung.kim2@gmail.com

Senior researcher in the Department of Medical Machinery, Korea Institute of Machinery & Materials. His research interest is Remote medical robot, AI based computer vision, visual servoing.

E-mail: jhseo@kimm.re.kr