극한환경에서 적외선 카메라의 객체 탐지를 위한 딥러닝 기반 데이터 증강 방법에 관한 연구

Copyright © The Korean Society for Precision Engineering

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License (http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

Abstract

Recently, in-depth studies on sensors of autonomous vehicles have been conducted. In particular, the trend to pursue only camera-based autonomous driving is progressing. Studies on object detection using IR (Infrared) cameras is essential in overcoming the limitations of the VIS (Visible) camera environment. Deep learning-based object detection technology requires sufficient data, and data augmentation can make the object detection network more robust and improve performance. In this paper, a method to increase the performance of object detection by generating and learning a high-resolution image of an infrared dataset, based on a data augmentation method based on a Generative Adversarial Network (GAN) was studied. We collected data from VIS and IR cameras under severe conditions such as snowfall, fog, and heavy rain. The infrared data images from KAIST were used for data learning and verification. We confirmed that the proposed data augmentation method improved the object detection performance, by applying generated dataset to various object detection networks. Based on the study results, we plan on developing object detection technology using only cameras, by creating IR datasets from numerous VIS camera data to be secured in the future and fusion with VIS cameras.

Keywords:

Data augmentation, Infrared camera, Object detection, Inception module, Deep learning, Autonomous vehicles, Generative adversarial network키워드:

데이터 증강, 적외선 카메라, 객체 탐지, 인셉션 모듈, 딥러닝, 자율주행차, 생성적 적대 신경망1. 서론

자율주행차량의 센서 기술의 발전과 객체 탐지(Object Detection) 기술은 미래를 혁신할 수 있는 중추 기술이 되고 있다. 자율주행 기술 중 인식 단계에서의 가장 핵심은 객체 탐지 기술이다. 특히, 카메라를 통한 객체 탐지는 자율주행 시스템에서 차량 주변을 인식하는 기본 요소이며, 여러 센서를 통합한 자율주행 차량은 안전성과 성능을 결정하는 요인이 된다. 카메라를 활용하는 것은 모든 자율주행 시스템과 그 구성 카메라의 기초 센서이며, 센서 융합 및 인식 프로세스가 구현되기 전에 카메라의 객체 탐지 기술이 올바르게 수행되어야 한다. 하지만 카메라는 특히 안개, 야간, 악천후 등으로 시도 조건이 좋지 않을 때 성능이 많이 저하된다는 단점이 있다. 그렇기 때문에 적외선 카메라는 기존 가시광선 카메라의 한계를 극복해줄 수 있는 대안이 될 수 있다. 적외선 카메라는 야간, 빛 반사, 어둠과 같이 시각적으로 한계가 있는 환경에서 뛰어난 성능을 보여줄 수 있기 때문이다.

일반적으로 센서에서 많이 활용되는 가시광선 카메라의 프로세스는 사람의 시각 시스템과 동일하다고 볼 수 있다. 외부로부터 받은 빛을 물체 표면에서 방사하는 복사에너지를 통해 이미지의 세부사항(Feature)을 제공하게 된다. 반면에 적외선 카메라는 물체가 발산하는 전자기파(Electromagnetic Radiation, EMR) 즉, 열의 정보를 탐지하여 전기 신호로 변환해주는 프로세스 이다. 변환된 전기 신호는 적외선(Infrared) 이미지나 영상으로 변환되어 출력되고 온도 정보를 산출하게 된다[1]. 그래서 적외선 카메라를 통해 감지된 열을 기반으로 정확하게 측정되기 때문에 주변환경에서 온도와 관련 정보를 통제하지 않는다면 출력된 이미지와 영상에 대한 정보가 왜곡될 수 있게 된다.

특히, 적외선 카메라는 VIS (Visible) 카메라와 결합하여 다양한 조건에서 물체를 감지하고 식별하는데 도움을 줄 수 있다. 기존의 ADAS 시스템[2]과 개발 중인 자율주행 시스템에서 장애물, 사람 등을 야간과 같은 극한환경 속에서 적외선 객체 탐지 성능은 더욱 빛을 발할 수 있다. 이러한 적외선 카메라가 가진 강점을 활용하기 위해서는 자율주행 객체 탐지를 위한 많은 양의 적외선 데이터셋이 필요하다. 즉 데이터가 완벽한 안정성을 추구할 만큼 충분히 다양하고 양질의 데이터가 요구되며, 최대 수백만개의 매개변수를 사용하여 딥러닝을 활용한 객체 탐지 훈련에 사용되어야 한다.

자율주행 인식을 위한 VIS 카메라 데이터셋을 충분히 확보하고 있는 반면에 적외선 카메라 데이터셋은 매우 적은 것이 현실이다. 적외선 객체 탐지 학습을 위해서 새롭게 적외선 카메라의 데이터셋을 수집하는 방법도 있지만, 이는 많은 시간과 비용이 요구된다. 또한, 수십년 동안 쌓아왔던 RGB 영역의 데이터셋에 버금가는 적외선 데이터셋을 지금부터 다시 마련한다는 것은 쉽지 않기 때문이다. 그렇기 때문에 현존하는 VIS 카메라의 데이터셋을 적외선 이미지화를 실시하는 데이터 증강 방법이 요구된다. 그러므로 자율주행차량의 카메라 기반의 인식 시스템에서 활용할 수 있는 적외선 카메라의 객체 탐지를 위한 데이터 증강 방법에 대한 연구를 진행하고 있다. 본 논문에서는 적외선 카메라에 범용적으로 활용할 수 있는 객체 탐지를 위한 데이터 증강 방법에 대해 제안하였고 이 방법에 대한 성능을 정량적, 정성적 실험으로 비교 분석하였다.

2. 데이터 증강 방법

2.1 기존 방법을 적용한 데이터 증강 방법

기존의 U-Net 구조를 활용하는 데이터 증강 방법인 2017년에 발표된 Isola의 Pix2Pix 방법[3]을 사용하여 고해상도 이미지를 생성하였을 때 훈련이 불안정하고 생성된 이미지의 품질이 만족스럽지 않음을 발견했다. 또한, 생성된 이미지를 학습 감지 네트워크에 사용하는 경우 감지 정확도는 기본적으로 변경되지 않았다.

특히, 기존 방법을 활용하여 RGB 이미지의 모습을 적외선 이미지화시켰을 때의 결과를 보게 되면 Fig. 1과 같이 Generated 이미지 내에서 블러된 부분(흐릿한 이미지)이 많이 보이며, 지나가는 사람에 대한 정확한 디테일이 없었다. 또한, 결정적으로 1,024*1,024의 Input 이미지를 넣었을 때 낮은 해상도의 이미지가 생성되었다. 이런 부분을 개선하기 위해 해당 계수 즉, 파라미터값을 변경하여 시도해보았다. 특히 해상도를 높이기 위하여 파라미터값인 Stride를 2에서 1로 변경하였는데 학습의 연산량이 많아져 트레이닝 시간이 기하급수적으로 늘어나는 것을 확인할 수 있었다. 여기서 Stride 파라미터는 윈도우의 이동할 간격을 조절하는 파라미터이다. 또한, 학습의 Epoch를 100에서 200, 300으로 늘렸을 때에도 초기의 실험을 했던 해상도와의 차이는 없었다(Epoch는 학습의 순환 주기를 나타내는 파라미터이다.).

2.2 인셉션 모듈을 활용한 네트워크 구조

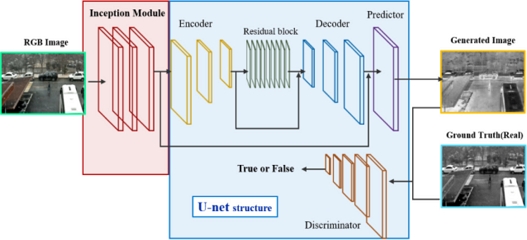

기존 방법을 적용한 결과 이미지의 디테일이 없어지는 문제점은 세분화된 Feature를 제대로 추출하지 못했기 때문이라고 판단하였다. Input의 이미지 Feature를 더욱 세분화된 레이어로 추출할 수 있는 인셉션 모듈(Inception Module)을 추가한다면 높은 해상도의 이미지를 생성할 수 있다고 판단하게 되었다. 특히, 대표적인 Image Translation에 사용되는 네트워크인 Pix2Pix의 Generator는 U-Net이라는 네트워크를 베이스로 하는데, 즉, Input이 U-Net의 인코더에 들어가기 전에 인셉션 모듈로 먼저 Feature들을 추출하는 구조이다.

위의 Fig. 2를 보게 되면 Generator 네트워크 전에 삽입된 인셉션 모듈을 입력하게 되면 적외선 이미지의 고해상도 Feature를 추출하기 위해 먼저 적용한 다음 2개의 Convolution 레이어에서 추출된 고해상도 Feature를 인코딩하는 인코더로 사용되었다. 그 후 9개의 Residual Block의 학습능력을 향상하기 위하여 인코더와 디코더 사이에 삽입되어 있다. 디코더 부분에서는 Convolution 층이 원래 해상도와 같은 Feature Map으로 해상도를 높이기 위하여 적용되었다. 이후에는 적외선 이미지를 얻을 수 있는 Feature Map으로 변환하기 위한 Convolution이 사용되었다.

Discriminator 네트워크는 5개의 CNN 구조로 구성되어 있다. 이는 기존의 U-Net 구조에서 사용되었던 방식에 기존 인셉션 모듈을 추가하여 적외선 이미지의 Feature를 효율적으로 추출할 수 있는 구조이다.

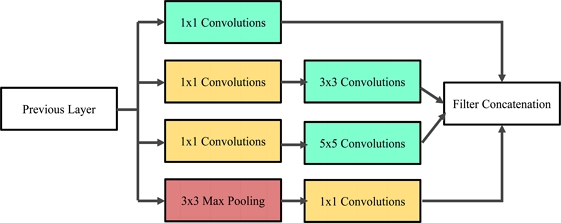

2.3 인셉션 모듈

인셉션 모듈은 GoogLeNet [4]에 처음으로 제안된 개념이다. 인셉션 모듈의 목적은 연산량을 줄이는 동시에 Feature를 효율적으로 추출하는 것이다. 초록색 박스의 Convolution들은 Feature를 효율적으로 추출하는 레이어이며, 특히 이 연산에서는 Gabor Filter가 사용되게 되는데 이는 사물의 윤곽선을 추출하는 필터로 수행된다.

Fig. 3에서 보게 되면 이 레이어들은 Feature를 추출하는 1 × 1, 3 × 3, 5 × 5의 Convolution 연산을 각각 수행한다. 또한, 빨간색 박스는 3 × 3의 Max Pooling이며, 입력과 출력의 H(높이), W(너비)가 같아야 하므로 Pooling 연산에서는 Padding을 추가해준다. 이는 Feature를 추출할 때 더욱 성능을 향상해주며, 행렬 연산은 간단하게 만들어 주는 역할을 한다. 그러나 이렇게 되면 연산량이 너무 많아지게 되기 때문에 연산해야 하는 노드들을 노란색 박스의 1 × 1 Filter로 줄여주어, 각 Feature의 정보는 보존함과 동시에 전체 이미지의 크기를 줄일 수 있다.

2.4 잔차 블록

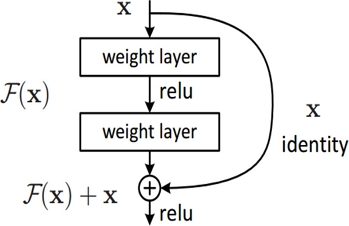

잔차 블록(Residual Block)은 기존 신경망에서 각 레이어들은 다음 레이어로 전달되는 것을 돕는 기능을 한다. 잔차 블록은 Fig. 4와 같이 참조되지 않은 함수를 학습하는 대신 레이어의 인풋을 참조하여 잔차 함수를 학습하는 Skip Connection 블록이다.

본 논문에서는 학습능력을 향상하기 위해서 다중 잔차 블록을 적용하였다. 잔차 블록을 활용하게 되면 입력만이 아닌 출력과 입력의 잔차 블록을 학습하는 것이 학습능력의 성능을 높여주는 역할을 한다. 또한 역전파와 레이어 수가 증가함에 따라 Gradient의 손실 문제가 발생하기 때문에 이러한 Skip Connection이 더 큰 Gradient를 초기 레이어로 전달할 수 있고, 다음 레이어도 이를 학습할 수 있게 되어진다. 특히, 잔차블록을 활용하여 더 깊은 네트워크를 훈련할 수 있게 되는 장점이 있다.

3. 실험 방법

3.1 실험 설계

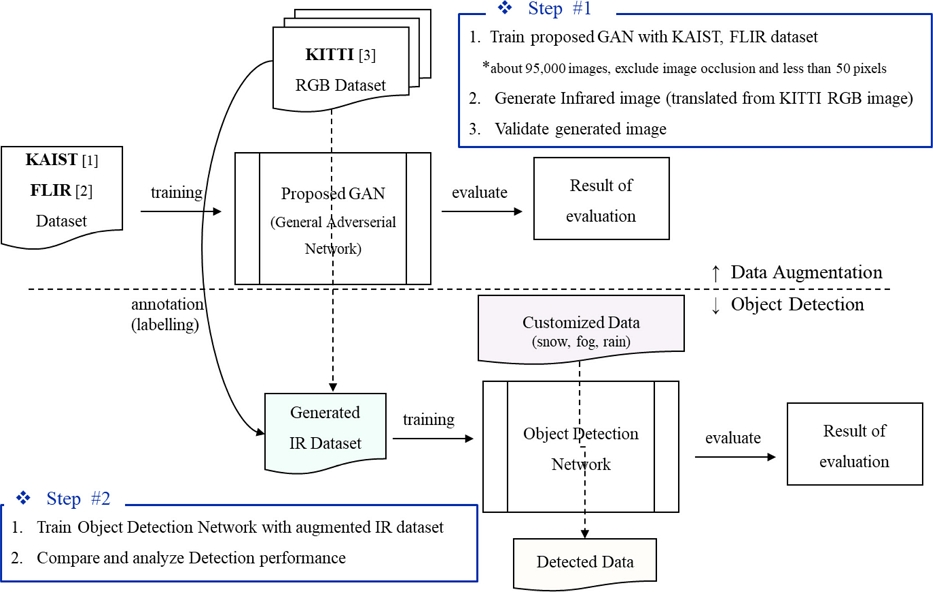

Data Augmentation은 생성된 데이터가 얼마나 효과적인지 실제로 적용했을 때 얼마나 효과적인지 확인하는 것은 필수적이다. 따라서 제안한 방법을 2단계로 나누어 실험을 진행하였다.

첫 번째 단계는 제안한 데이터 증강 모델을 활용하여 KAIST 데이터셋을 학습시켰다. 데이터셋은 50 픽셀 미만 또는 이미지 왜곡이 있는 사진을 제외하고 적외선과 RGB 이미지로 구성된 약 95,000개의 사진으로 구성되었다. 매칭된 이미지를 데이터 증강 방법으로 학습한 네트워크를 통해 자율주행차 KITTI의 RGB 데이터셋을 적외선 이미지로 생성하였다. 생성한 이미지에 대한 실험적 검증을 위해 정성적, 정량적 평가를 실시하였다.

두 번째 단계에서는 생성된 적외선 데이터셋으로 객체 탐지 네트워크에 적용하여 성능을 평가하였다. 특히 강설환경에서 데이터셋을 수집하여 악기상에서도 학습된 적외선 데이터셋을 적용했을 때 물체감지 성능에 대하여 비교 분석하였다.

3.2 하드웨어 구성

실험에 사용된 GPU는 Table 1에서 보는 바와 같이 NVIDIA의 GeForce RTX 2080Ti 모델이며, GPU 메모리는 11이다.

또한, 적외선 카메라와 VIS 카메라가 매칭된 데이터를 얻기 위해 Fig. 6과 같이 구성하였다. VIS 카메라가 취약한 환경에서 데이터셋을 얻기 위해 총 5회에 걸쳐 데이터를 획득하였다. VIS 카메라는 GMSL 모델을 사용하였고, 적외선 카메라는 i3 시스템사의 TE-EQ1 모델을 사용하였다.

GMSL 카메라 2대로 활용한 해당 모듈은 추후에 다른 센서들(LiDAR, Radar, IMU, GPS)과의 퓨전을 위해 활용하였다. 이번 실험에서는 적외선 카메라를 중심으로 카메라 좌표 보정(Calibration)을 실시하였고, 실험간 GMSL 카메라의 초점이 흐트러질 경우를 대비하여 2개의 화면을 활용하였다. 실험간 우측 GMSL 카메라의 Angle이 안 맞는 경우가 생겨 해당하는 2개의 이미지를 스티칭(Stitching)하였다.

그러나 Table 2에서 보게 되면 적외선 카메라의 FOV 값(Field of View)이 GMSL 카메라보다 작았기 때문에 녹화된 이미지를 자르고(Crop), 크기를 조정(Resize)하였다.

3.3 데이터셋 수집

데이터는 국내 각 지역의 계절적 특성을 활용하여 Table 3과 같이 극한 환경(눈, 비, 안개)에서 5회에 걸쳐 수집하였다. 극한 환경에서만 데이터를 수집한 이유는 적외선 카메라가 극한환경에서 VIS 카메라의 가시성이 제한적인 부분을 보완해주는 역할을 하기 때문이다. 각 데이터의 수는 강설환경에서 5,245개, 강우 환경에서 2,903개, 안개환경에서 1,887개로 총 10,035개의 Image 데이터셋을 수집하여 활용하였다. 참고로 Training, Validation, Test 데이터셋은 7 : 2 : 1의 비율로 설정하여 학습하였다.

각 데이터에 대한 전처리 과정은 크게 3단계의 과정(1단계 Masking, 2단계 Labelling, 3단계 Matching)을 거쳐 데이터셋화시켰다. 먼저 1단계는 크기가 작거나 식별이 불가하여 객체 탐지 Network의 학습에 오류가 되는 객체들을 마스킹하여 해당 정보를 제거하였다. 각 데이터에서 객체들을 먼저 탐지하여 일정 기준의 크기가 작은 객체와 사람이 육안으로 식별하기 불가능한 객체를 마스킹 처리하였다. 마스킹의 레이블을 설정하여 해당 Class의 인덱스를 변경하였다. 또한, 마스킹 대상 객체의 Bounding Box 내의 픽셀값은 0으로 설정하여 해당 영역의 정보를 삭제하였다. 2단계는 Class의 범위가 벗어나거나 누락된 Label을 추가하고, 중복된 정보를 가진 객체들의 정보를 수정하였다. 특히 오류가 있는 데이터의 목록을 출력하여 직접 수정하였고 누락된 Label의 경우 추가하였다. 예를 들어 자전거나 킥보드를 타고있는 사람의 경우 각각의 Class 정보가 누락된 경우를 많이 볼 수 있는데 이러한 객체들의 라벨(Multi-Label)을 추가시켰다. 마지막 3단계는 주석(Annotation)의 데이터 수와 원본 데이터 수를 비교하여 매칭하고 데이터셋의 Class별 객체 수와 비율 등을 산출하였다. 이미지만 존재하는 데이터의 경우 Annotation을 생성하고, Annotation 데이터만 존재하는 경우 파일과 일치하는 원본 데이터를 매칭해주거나 Annotation 데이터를 삭제하였다.

4. 실험 결과 및 고찰

4.1 정성적 평가 결과 분석

정성적 평가(Qualitative Evaluation)는 시각적으로 비교 분석하였다. Fig. 7과 같이 첫 번째 분석은 강설환경과 같은 극한환경에서 IR 카메라가 VIS 카메라보다 더 견고하다는 것을 알 수 있었다. Fig. 7의 왼쪽은 VIS 카메라이며, 나무 뒤에 가려진 사람이 감지되지 않는 것을 볼 수 있다. 하지만 Fig. 7의 오른쪽 그림을 보게 되면 가려진 사람(Obscured Object)는 IR 카메라로 잘 탐지되는 것을 알 수 있다. 또한 환경이나 가시환경이 조건이 좋지 않은 경우에 IR 카메라로 감지하는 것이 VIS 카메라로 감지하는 것보다 더 효과적인 것을 확인할 수 있다.

Comparison of infrared camera and vision camera in the obscured image (a) Vision camera (GMSL), and (b) Infrared camera

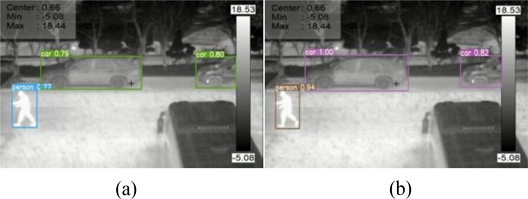

다음 Fig. 8은 제안한 방법으로 데이터를 학습시켰을 때 Detection의 성능이 얼마나 개선되었는지에 대해 시각적으로 비교한 그림이다. 여기에 사용된 Object Detection 네트워크는 DSSD (Deep Single Shot Detector)이다. 제안한 방법으로 생성된 영상을 학습시켰을 때 생성된 이미지에 대한 학습을 통해 적외선 이미지에 대한 Detection 성능이 향상됨을 알 수 있다.

4.2 정량적 평가 결과 분석

실제 이미지와 생성된 이미지의 차이를 정량적으로 비교하기 위해 IS (Inception Score)와 FID (Fréchet Inception Distance) 방법을 사용하였다. IS는 Salimans 등이 제안한 이미지 측정 방법[5]으로 모델 학습을 통한 생성된 이미지의 평가에 품질과 생성된 영상의 다양성 두 가지 기준을 사용한다. IS는 Inception 모델에서 식별하기 쉬운 영상 및 식별된 레이블의 변수가 풍부할수록 Score가 높게 출력되도록 설정되어 있다. FID 방법은 Heusel 등이 제안한 방법으로 생성된 이미지의 분포만 평가하는 IS와 달리 생성된 이미지의 분포를 생성자 학습에 사용된 실제 이미지의 분포와 비교를 하게 된다[6]. 특히 FID 점수가 낮을수록 Ground Truth와 생성된 이미지의 분포가 더 유사하다는 의미를 나타내므로 점수가 낮을수록 성능이 좋은 것을 의미한다.

제안된 모델을 검증하기 위해 KAIST 데이터 셋[9]을 활용하였고, 이는 검증된 적외선 카메라 데이터셋이며 다른 연구에서 널리 사용된다. Table 4의 비교표는 데이터셋으로 RGB 이미지와 적외선 이미지를 매칭시켜 학습시켰을 때 이미지를 정량적으로 평가한 결과이다. 가장 좋은 성능을 낸 것은 제안한 방법이었으며, 특히 기존 U-Net 구조를 활용하는 Pix2Pix 모델보다 IS 점수는 1.03 향상되었으며, FID 점수는 1.09가 향상되어 유의미한 결과를 얻었다고 볼 수 있다.

하지만 IS와 FID 방법을 통한 평가는 한계가 있다. FID의 단점은 사전 훈련된 ImageNet 데이터의 경우 이미지 클래스의 ImageNet 데이터가 다른 이미지를 처리할 때 원하는 특성을 포착하지 못할 수 있다. 또한, 사전에 훈련되지 않은 경우 FID 점수가 나쁜 편향된 Feature 레이어를 학습하지 않고 많은 샘플을 얻을 수 있게 된다. IS의 한계점은 Discriminator가 생성된 이미지를 판별할 때 학습 데이터셋의 클래스에 없는 경우 이를 올바르게 판단하지 못한다는 단점이 있다. 그러므로 이미지 자체에 대한 품질을 평가하는 다른 방법이 추가적으로 필요하다고 할 수 있다.

생성된 이미지 자체에 대한 품질 비교를 하기 위해 PNSR (Peak Signal to Noise Ratio)과 SSIM (Structural Index Similarity), 이 두 가지 방법을 사용하였다. 피크 신호 대 노이즈비(PSNR)와 구조적 지수 유사성(SSIM)은 이미지 품질 평가에 널리 사용되는 두 가지 측정 도구이다. 특히, 이미지에서 이 두 가지 측정 도구를 사용하여 시각적인 품질을 측정하게 된다. PSNR은 SSIM보다 먼저 사용되었으며, 쉽고 간편하여 다양한 디지털 이미지 측정에 널리 사용된다. SSIM은 인간의 시각적인 시스템의 작동에 더 잘 맞도록 휘도, 대비 및 구조의 세 가지 요소를 기반으로 설계된 최신 측정 도구이다.

위의 Table 5를 보면 PNSR과 SSIM 모두 기존 모델인 Pix2Pix보다 향상된 것을 확인할 수 있었다. 특히 PNSR은 2.33, SSIM은 0.01 향상되었는데, 제안한 모델의 성능이 가장 우수함을 알 수 있었다.

4.3 객체 탐지 네트워크 적용 결과 비교

딥러닝 기반의 데이터를 학습시켰을 때 성능의 향상 정도를 확인하기 위해 객체 탐지 네트워크에 적용하여 탐지 성능 실험을 실시하였다. 성능에 대한 척도는 비젼 분야에서 정확도를 판별할 때 주로 사용하는 Map 방법을 적용하였다.

실험 결과로 Table 6을 보면 제안한 데이터 증강 방법(Pix2Pix)을 통해 데이터셋을 학습시켰을 때, 기존의 방법보다 Detection 성능이 향상됨을 확인할 수 있었다. 흥미롭게도 IOU (Intersection over Union)의 임계값 0.5 이상에서 DSSD (Deconvolutional Single Shot Detector) 탐지 네트워크가 가장 좋은 객체 탐지 성능을 보여주었다. 적외선 카메라 데이터셋을 훈련할 때 SSD (Single Shot Detection) 계열의 객체 탐지 네트워크가 YOLO (You Only Look Once) 네트워크보다 정확도를 가장 많이 향상시켰다는 것 또한 확인할 수 있었다. 기존의 데이터 증강 방법을 비교하였을 때 제안된 데이터 증강 방법으로 데이터셋을 학습시키는 결과가 유의미하다는 것을 다시 한 번 검증할 수 있었다.

앞의 실험 결과에서 비교적 높은 성능을 보여주었던 SSD와 DSSD의 Detection 네트워크를 기준으로 극한환경에서 수집한 눈, 비, 안개 데이터셋을 적용하여 비교 실험을 실시하였다. 해당 실험의 결과 Table 7을 보면 모든 환경에서 일정 수준 이상의 Detection 성능이 향상된 것을 확인할 수 있다. 특히 가장 Detection의 성능이 저하되었던 안개환경에서 제안한 방법의 데이터셋으로 학습을 시켰을 때 Detection 정확도가 가장 향상된 것을 확인할 수 있었다. 이는 가시적 상황이 좋지 않은 경우에 해당 방법으로 데이터를 증강시키면 객체 탐지 성능이 좋다는 것을 추측할 수 있다.

Comparison of detection performance in extreme environment when trained with each data augmentation method

인셉션 모듈을 활용한 데이터 증강 방법에 대하여 이미지 검증의 정성적 및 정량적 결과를 평가하였다. 특히 정성평가를 통해 생성된 영상으로부터 얻은 IS, FID, PNSR, SSIM 방법 모두 높은 성능을 보여 데이터셋으로서 의미 있는 결과를 얻었다. 특히 인셉션 모듈 방식은 기존 연구에서 증강된 영상이 저해상도에서 생성되는 한계를 극복하였다. 인셉션 모듈에 사용된 Gaber 필터를 활용하여 이미지 특징의 윤곽선을 선명하게 추출한 것이 기존 방식보다 더 높은 해상도의 이미지를 생성한 주요인이라고 판단된다.

또한, 증강된 적외선 데이터셋을 객체 탐지에 적용했을 때 기존의 사전 훈련된 모델에 비해 성능이 향상되었다. 특히 극한 환경에서 제안한 방법으로 학습할 때 높은 성능을 보였다. 본 논문에서 제안한 데이터 증강 방법은 매개변수값과 FLOP 값을 비교했을 때 다른 GAN 모델보다 경량화된 모델로서 평가된다.

실험 장비로 사용한 적외선 카메라(TE-EQ1) 모델의 경우 실측온도 -10− -150oC 내에서 주변 온도와 환경을 파악하여 측정하는 타겟에 반사가 되는 온도를 측정하여 자동으로 온도를 보정하게 된다. 특히 주변환경과 풍속 등 여러 환경 조건 등으로 온도 측정 시 오차가 발생할 수 있다. 해당 모델의 i3 시스템사의 온도 측정의 정확도는 ±3oC 또는 ±3% 내외로 규정하고 있다[16]. 하지만 GMSL 카메라를 활용한 RGB 이미지 기반으로 생성한 적외선 이미지에 대한 온도 보정은 적외선 카메라로 동시에 수집한 온도 정보를 활용할 수 밖에 없었다. 즉, 가시광선에서 수집한 데이터로 생성한 적외선 이미지는 매칭되는 데이터의 온도 정보를 활용해야 한다. 하지만 적외선 카메라의 온도 정보가 없는 RGB 이미지에 대한 온도 보정에 관한 연구는 더 진행되어야 할 것으로 판단된다.

5. 결론

제안했던 방법에 대한 실현가능성(Feasibility)을 적합성, 현실성, 효율성 측면에서 평가해보았다. 먼저 적합성 측면에서 살펴보면, 현재 배포되었거나 앞으로 활용될 RGB 영역의 데이터 셋을 가공하여 적외선 데이터셋을 얻음으로써 적외선 데이터 셋을 범용적으로 활용이 가능하다. 현실적인 측면에서 보게 되면, 적외선 카메라 데이터셋을 어떤 장비라도 적용할 수 있다는 장점이 있지만 적외선 카메라의 단점 부분을 VIS 카메라가 보완해주어야 한다. 예를 들어 거울에 비친 객체는 탐지가 되지 않고 카메라를 들고 있는 사람이 보이는데, 이러한 부분들은 RGB 영역에서 보완되어야 한다고 판단된다. 마지막으로 효율적 측면을 살펴보면 적외선 카메라의 데이터셋을 구성하는 시간과 비용을 절약할 수 있다. 최근까지의 객체 탐지 방법은 RGB의 영역에서만 집중되어 왔으며, 적외선 카메라를 활용하는 것은 비교적 적게 논의되어 왔다. 하지만 적외선 카메라가 가진 강점은 충분하며, 카메라 기반의 자율주행을 구현한다고 하였을 때 VIS 카메라의 제한사항을 보완해줄 수 있는 센서라고 판단한다[17]. 특히 본 연구에서는 적외선 카메라의 객체 탐지를 위한 데이터 증강 방법에 대한 연구를 집중적으로 다루었다. 인공지능을 활용하기 위해서는 절대적인 데이터셋의 양의 확보가 필요한데 이 데이터셋을 구비하기 위한 방법적인 측면을 제시했다는 점에서 큰 의미가 있다고 판단한다. 자율주행 시스템과 더불어 국방 분야와 산업 분야 등 범용적으로 사용되는 적외선 카메라를 활용한 딥러닝 기술은 지속적으로 개발되고 연구되어져야 한다.

Acknowledgments

This paper was presented at KSPE Spring Conference 2021

이 논문은 민군겸용 연구사업 “활주로 제설장비의 무인화 기술 개발(No. 19-CM-GU-02)” 과제로부터 연구를 지원 받아 작성된 논문임.

REFERENCES

-

Ma, J., Ma, Y., Li, C., (2019), Infrared and visible image fusion methods and applications: A survey, Information Fusion, 45, 153-178.

[https://doi.org/10.1016/j.inffus.2018.02.004]

-

Okuda, R., Kajiwara, Y., Terashima, K., (2014), A survey of technical trend of ADAS and autonomous driving, Technical Papers of 2014 International Symposium on VLSI Design, Automation and Test, 1-4.

[https://doi.org/10.1109/VLSI-DAT.2014.6834940]

-

Isola, P., Zhu, J.-Y., Zhou, T., Efros, A. A., (2017), Image-to-image translation with conditional adversarial networks, Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 1125-1134.

[https://doi.org/10.1109/CVPR.2017.632]

-

Szegedy, C., Liu, W., Jia, Y., Sermanet, P., Reed, S., Anguelov, D., Erhan, D., Vanhoucke, V., Rabinovich, A., (2015), Going deeper with convolutions, Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 1-9.

[https://doi.org/10.1109/CVPR.2015.7298594]

- Salimans, T., Goodfellow, I., Zaremba, W., Cheung, V., Radford, A., Chen, X., (2016), Improved techniques for training GANs, Advances in Neural Information Processing Systems, 29.

- Heusel, M., Ramsauer, H., Unterthiner, T., Nessler, B., Hochreiter, S., (2017), GANs trained by a two time-scale update rule converge to a local nash equilibrium, Advances in Neural Information Processing Systems, 30.

-

Zhu, J.-Y., Park, T., Isola, P., Efros, A. A., (2017), Unpaired image-to-image translation using cycle-consistent adversarial networks, Proceedings of the IEEE International Conference on Computer Vision, 2223-2232.

[https://doi.org/10.1109/ICCV.2017.244]

-

Choi, Y., Choi, M., Kim, M., Ha, J.-W., Kim, S., Choo, J., (2018), StarGAN: Unified generative adversarial networks for multi-domain image-to-image translation, Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 8789-8797.

[https://doi.org/10.1109/CVPR.2018.00916]

-

Choi, Y., Kim, N., Hwang, S., Park, K., Yoon, J. S., An, K., Kweon, I. S., (2018), KAIST multi-spectral day/night data set for autonomous and assisted driving, IEEE Transactions on Intelligent Transportation Systems, 19(3), 934-948.

[https://doi.org/10.1109/TITS.2018.2791533]

-

Liu, W., Anguelov, D., Erhan, D., Szegedy, C., Reed, S., Fu, C.-Y., Berg, A. C., (2016), SSD: Single shot multibox detector, European Conference on Computer Vision, 21-37.

[https://doi.org/10.1007/978-3-319-46448-0_2]

- Fu, C.-Y., Liu, W., Ranga, A., Tyagi, A., Berg, A. C., (in press), DSSD: Deconvolutional single shot detector.

-

Redmon, J., Farhadi, A., (2017), YOLO9000: Better, faster, stronger, Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 7263-7271.

[https://doi.org/10.1109/CVPR.2017.690]

- Redmon, J., Farhadi, A., (in press), YOLOv3: An incremental improvement.

- Bochkovskiy, A., Wang, C.-Y., Liao, H.-Y. M., (2020), YOLOv4: Optimal speed and accuracy of object detection.

-

Kasper-Eulaers, M., Hahn, N., Berger, S., Sebulonsen, T., Myrland, Ø., Kummervold, P. E., (2021), Detecting heavy goods vehicles in rest areas in winter conditions using YOLOv5, Algorithms, 14(4), 114.

[https://doi.org/10.3390/a14040114]

- I3system, Thermal Expert_ User Manual. https://www.thermalexpert.eu/english-1/support/

- Cho, J. W., Park, J. I., Lee, M. Y., Jeon, H. Y., Kim, K. S., (2021), Analysis on object detection using infrared camera, Proceedings of the Spring Conference on the Korean Society for the Precision Engineering, 207.

Instructor in Department of Mechanical Engineering, Korea Army Academy at Yeongcheon. His research interest is infrared camera, object detection, data augmentation, and computer vision.

E-mail: jw91125@kaist.ac.kr

Ph.D. candidate in Department of Mechanical Engineering, KAIST. His research interest is LiDAR, radar, computer vision, and sensor fusion for self-driving vehicles.

E-mail: tinz64@kaist.ac.kr

Ph.D. candidate in Department of Mechanical Engineering, KAIST. His research interest is computer vision, and sensors for self-driving vehicles.

E-mail: junhy425@kaist.ac.kr

Assistant Professor in the Department of Automotive Engineering, Yeungnam University. His research interest is mechatronic systems and robotic systems control, vibration control, autonomous driving, machine learning in robotics, and indoor/outdoor mobile robot navigation.

E-mail: jihpark@yu.ac.kr

Professor in Department of Mechanical Engineering, KAIST. His research interest is digital system design for controlled mechatronics, actuator design, and control theory, such as robust controls and sliding mode controls.

E-mail: kyungsookim@kaist.ac.kr