360o 라이다를 이용한 CNN 기반 사람 인식 및 확장 칼만 필터 기반 위치 추적

Copyright © The Korean Society for Precision Engineering

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License (http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

Abstract

The collaboration of robots and humans sharing workspace, can increase productivity and reduce production costs. However, occupational accidents resulting in injuries can increase, by removing the physical safety around the robot, and allowing the human to enter the workspace of the robot. In preventing occupational accidents, studies on recognizing humans, by installing various sensors around the robot and responding to humans, have been proposed. Using the LiDAR (Light Detection and Ranging) sensor, a wider range can be measured simultaneously, which has advantages in that the LiDAR sensor is less impacted by the brightness of light, and so on. This paper proposes a simple and fast method to recognize humans, and estimate the path of humans using a single stationary 360o LiDAR sensor. The moving object is extracted from background using the occupied grid map method, from the data measured by the sensor. From the extracted data, a human recognition model is created using CNN machine learning method, and the hyper-parameters of the model are set, using a grid search method to increase accuracy. The path of recognized human is estimated and tracked by the extended Kalman filter.

Keywords:

LiDAR, CNN machine learning, Extended kalman filter, Occupied grid map키워드:

라이다, CNN 머신러닝, 확장 칼만 필터, 점유 격자 지도1. 서론

최근 기술이 발전함에 따라 차세대 정보 기술과 첨단 제조 기술의 통합 및 혁신으로 지능형 제조로 대표되는 스마트 팩토리가 많아지며 제조 산업에 많은 변화를 일으키고 있다[1,2]. 스마트 팩토리는 기존의 공장에 비해 제품 제조 자동화와 유연성에 더 많은 관심을 쏟고 있다[3]. 이를 위해 이동형 산업용 로봇 및 협업 로봇 등의 장비를 사용하지만 기존 제조 환경에서 로봇과 작업자의 작업 공간이 분리되어 물리적으로 안전이 확보되어 있던 것과는 달리 작업자와 로봇의 작업 공간이 겹치게 되어 새로운 물리적 안전 위험이 발생한다[4]. 예를 들면 2015년 6월 독일의 폭스바겐 공장에서 작업자가 로봇에 작업 도중 로봇이 작업자의 가슴을 강타하여 작업자의 가슴에 금속판이 박혀 사망하는 사고도 있었다. 이후 8월에는 미국 자동차 부품 제조사의 조립 라인에서 실수로 산업용 로봇이 가동을 시작해 정비 기사의 머리에 부품을 조립해 두개골이 부서져 그 자리에서 사망하는 사고도 있었다[5]. 앞선 사고들은 작업자와 로봇의 작업 공간이 겹치면서도 작업자의 안전을 확보할 수 있는 방법의 필요성을 보여준다.

본 논문에서는 360o로 회전하는 라이다(360o 라이다)를 이용하여 생산 환경에서 로봇과 작업자를 인식하고, 작업자의 위치를 예측 및 추적하여 작업자의 안전을 확보하는 방법을 제안한다. 360o 라이다를 이용하여 얻은 데이터에서 점유 격자 지도(Occupied Grid Map) 방법을 이용하여 동적 객체를 추출 후 CNN 머신러닝을 통해 작업자와 작업자가 아닌 것을 분리하여 작업자의 위치를 파악하고, 확장 칼만 필터(Extended Kalman Filter)를 이용하여 이동 경로를 예측 및 추적하여 작업자의 안전을 확보하는 방법을 제안한다. 제안한 방법은 RGB 카메라에 비해 인식 범위가 수십 미터로 넓으며 조명 조건 및 측정 대상의 색에 영향을 받지 않으며, 측정 대상의 키나 외형에 영향을 받지 않고 거리를 보다 정확하게 측정할 수 있는 장점이 있다[6-8]. 1개의 360o 라이다를 사용하여 측정하기에 다수의 센서를 작업 공간에 설치하여 작업자를 인식하는 방법에 비해 공간의 제약이 작고, 동시에 관측 가능한 범위가 360o로 한 번에 많이 관측할 수 있어 협업 로봇 주변의 모든 방향에 대해서 작업자의 안전을 확보할 수 있으며 다수의 센서를 사용할 때와 달리 이미지 및 데이터 합성에 의한 왜곡이나 데이터 처리에 소요되는 시간이 짧다. 또한 다른 장비 없이 1개의 라이다 센서만을 이용해 사람 및 객체를 인식 및 추적이 가능하여 다양한 협업 로봇 및 장비에 설치가 용이하며, 다양한 환경에서 적용 가능한 장점이 있다.

2. 라이다를 이용한 사람 인식과 위치 추적 방법

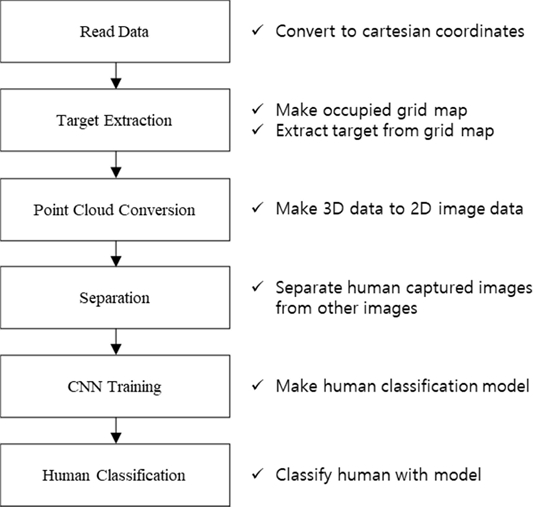

360o 라이다의 데이터로부터 Fig. 1과 같은 알고리즘을 통해 사람 인식 모델을 생성하고 사람을 분류한다. 라이다의 Raw 데이터로부터 점유 격자 지도 방법을 이용해 동적 객체를 추출하고, CNN 사용을 위해 포인트 클라우드(Point Cloud) 데이터를 2D의 이미지로 투사한다. 투사된 2D 이미지들을 사람과 사람이 아닌 것들을 분류하고, 이를 이용해 CNN 학습을 시켜 사람 인식 모델을 생성한다. 생성한 모델을 사용하여 라이다로 주변 데이터를 수집함과 동시에 사람을 인식한다. 사람을 인식 후 사람이라 파악된 객체에 대해 칼만 필터를 이용하여 위치를 추적한다.

2.1 라이다 데이터에서 동적 객체 추출

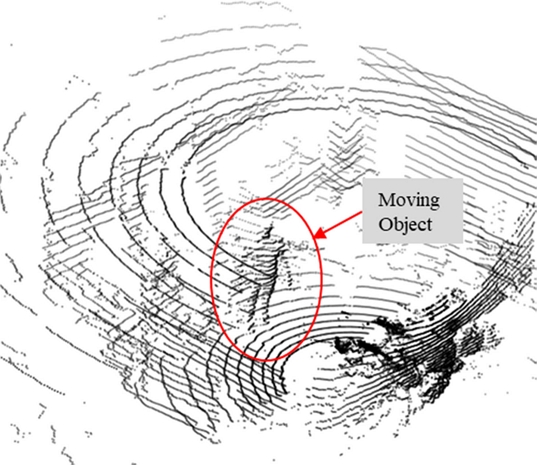

본 논문에서 사용한 OS0-32 라이다는 Table 1과 같은 성능을 가지고 있으며, Fig. 2와 같이 데이터를 보여준다. 스마트 팩토리에서 협업 로봇과 작업 도중 작업의 연속성을 저해하지 않고 사람의 안전을 확보하려면 혼동 없이 사람을 높은 확률로 인식할 수 있어야 한다. 또한 협업 로봇과 작업자 간에 생기는 안전사고를 방지하기 위함이므로 협업 로봇과 가까운 거리에서의 사람 인식이 주목표다. 이를 위해 작업 환경 내에서 협업 로봇의 근거리에서 움직이는 물체를 파악해야 할 필요가 있다.

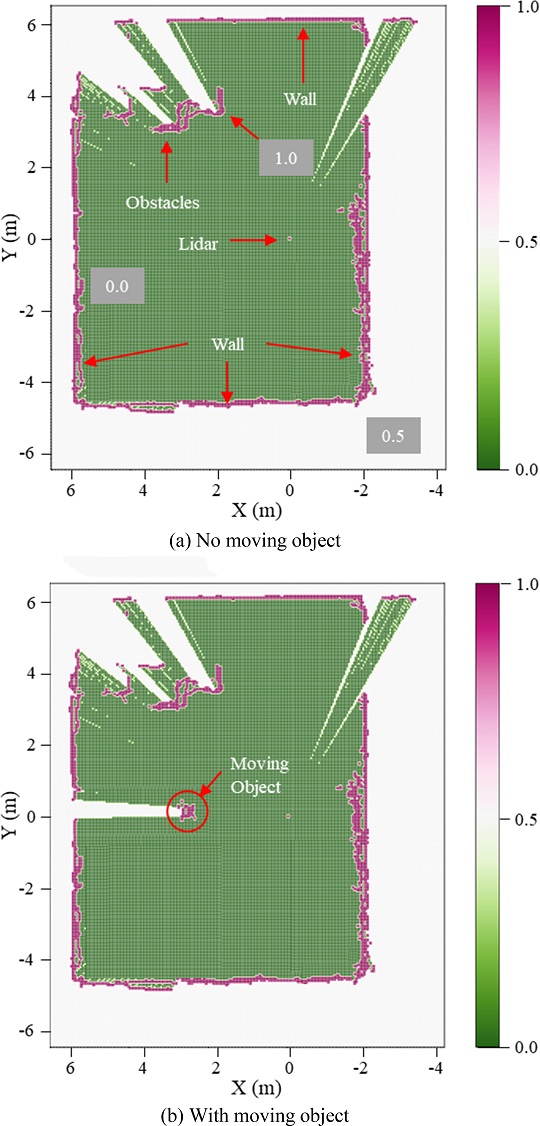

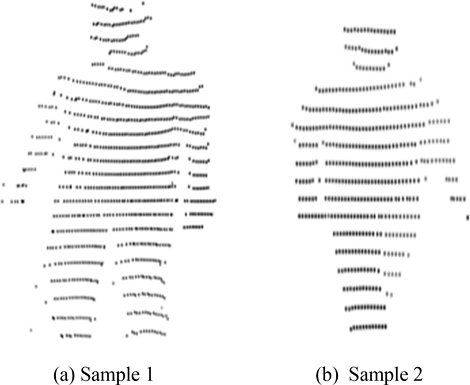

사람을 인식하기 전 작업 환경 내의 동적 객체를 파악하기 위해 움직이는 물체를 파악하는데 효과적인 점유 격자 지도 방법을 사용하였다[9-14]. 점유 격자 지도는 공간을 일정한 크기의 격자로 나눈 후 공간상에서 장애물의 유무에 따라 점유 지역(Occupied Area)과 비어 있는 지역(Empty Area)으로 나타내는 지도이다. 점유 격자 지도에서는 일정한 크기로 나눈 영역을 물체가 존재하는지에 대한 확률에 따라 나타내는데 Fig. 3(a)와 같이 작업 환경을 100*100 mm2의 크기의 격자로 나눠 물체가 관측된 영역을 1, 물체가 관측되지 않은 영역을 0, 관측이 이루어지지 않은 영역을 0.5로 나타낸다. 라이다로 수집한 포인트 클라우드를 점유 격자 지도로 나타낸 후 정지한 물체가 차지하고 있을 확률이 0인 빈 공간에서 동적 객체를 추출한다. Figs. 3(a)와 같이 빈 공간으로 관측된 영역에서 3(b)와 같이 물체가 관측되면 해당 물체가 있는 영역을 라이다 데이터에서 추출해낸 후 노이즈 필터링을 통해 노이즈를 제거하고, 동적 객체만을 추출하여 2D 투사를 통해 4와 같은 데이터를 확보할 수 있다. Fig. 4는 약 5 m 거리에서 관측한 모습이고, 협업 로봇과 작업자 간의 안전사고 방지가 목적이므로 10 m 이내의 사람 이미지 데이터를 확보하였다.

2.2 CNN 머신러닝을 통한 사람 인식

CNN은 합성곱 신경망(Convolutional Neural Network)의 약자로, 필터링 기법을 인공신경망에 적용함으로써 이미지를 더욱 효과적으로 처리하는 머신러닝 방법이다[15]. 데이터의 특징을 추출하여 특징들의 패턴을 파악하는 구조를 가지고 있으며, 컨볼루션(Convolution) 과정과 풀링(Pooling) 과정을 통해 진행된다[16,17].

컨볼루션 과정은 데이터의 특징을 추출하는 과정으로 데이터에 각 성분의 인접 성분들을 조사해 특징을 파악하고 파악한 특징을 한 장의 데이터로 도출시키는 과정이다. 이때 도출된 데이터를 컨볼루션 층(Convolution Layer)이라고 한다. 이 과정은 하나의 압축 과정이며 데이터의 파라미터 개수를 효과적으로 줄이는 역할을 한다. 풀링 과정은 컨볼루션 과정을 거친 데이터의 사이즈를 줄여주는 과정이다. 노이즈를 상쇄시키며, 국소적인 부분들을 하나의 대표적인 스칼라값으로 변환함으로써 이미지의 크기를 줄이는 등의 역할을 한다[18,19].

CNN 머신러닝을 진행하기 위해서는 3D 데이터 또는 2D 데이터가 필요하다. 3D 데이터를 사용하면 2D 데이터에 비해 정확도는 높지만 데이터의 양이 많아 이를 처리하는데 시간이 더 많이 소요되어 안전사고 방지를 위한 빠른 응답에는 맞지 않아 2D 데이터를 사용한다[20].

포인트 클라우드에서 추출된 객체의 3D 데이터를 Fig. 4와 같이 2D 이미지로 투사하여 생성한다. 사람 인식의 정확도 향상을 위해 포인트 클라우드의 X, Y, Z 데이터를 각각 X-Z, Y-Z 평면에 투사한 2장의 이미지로 만들어 학습 데이터를 생성하였다. 또한 사람이 움직이는 방향과 라이다로부터 위치에 따라 모습이 변하기 때문에 라이다로부터 사람까지의 방향과 거리를 달리하여 학습용 데이터를 구축하였다. CNN 머신러닝을 위해 사람을 라이다로 촬영한 2D 이미지 데이터와 일반 사물을 촬영한 2D 이미지 데이터를 수집 후 학습 데이터와 테스트 데이터로 7 : 3 비율로 나누어서 머신러닝을 진행한다. 머신러닝을 통해 만들어진 모델을 이용해 움직이는 대상 중에서 사람을 인식한다. 이러한 방식은 사전에 모델을 생성함으로써 실시간으로 사람을 인식하고 위치를 예측 및 추적하는 것에 속도 면에서 이점을 가진다.

CNN의 구조를 가지고 학습할 때는 배치 크기(Batch Size), 활성화 함수 등의 하이퍼-파라미터(Hyper-Parameter)를 결정해야 한다. 하이퍼-파라미터는 CNN 모델을 생성함에 있어서 정확도와 손실 값, 학습 시간 등에 큰 영향을 주며, 과적합(Overfitting)에 빠지지 않고 목표하는 결과를 얻기 위해서는 하이퍼-파라미터를 최적화하는 작업이 선행되어야 한다. 하지만 현재까지 하이퍼-파라미터를 결정함에 있어서 규칙이 없는 것이 일반적이기에 그리드 서치(Grid Search) 기법이나 랜덤 서치(Random Search) 기법을 이용한 설계자의 직관에 따라야 하는 부분이 있다[21,22].

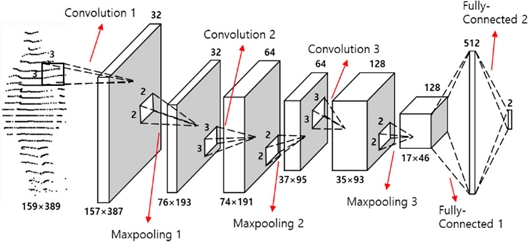

본 연구에서는 그리드 서치 기법을 이용하여 손실 값을 기준으로 컨볼루션 층의 수와 배치 크기, 활성화 함수, 옵티마이저(Optimizer)의 종류를 설정하였다. CNN 모델의 구성은 Fig. 5와 같이 한 개의 입력 층(Input Layer)과 3개의 컨볼루션 층과 2개의 완전 연결 층(Fully-Connected Layer)으로 구성하였다. 입력 데이터의 크기는 159*389 픽셀의 2D 이미지 데이터이며, 컨볼루션 층을 통해 합성곱 연산 과정을 거쳐 특징값을 추출하여 모델을 학습시키게 된다[23]. 풀링 층은 모델의 과적합을 방지하기 위해 최댓값 풀링(Max Pooling) 방식을 사용하였다. 최댓값 풀링은 행렬의 데이터 중 가장 높은 값을 반환하는 방식을 사용한다[24]. 배치 크기는 15개로 설정하였으며, 활성화 함수는 ReLU, 옵티마이저는 RMSProp로 설정하였다.

그리드 서치 기법을 이용해 최적화된 CNN 모델은 최종적으로 Fully-Connected Layer를 거쳐 입력된 이미지에 대해 2개의 클래스(사람, 그 밖의 물체) 중 하나로 분류한다.

2.3 칼만 필터를 이용한 사람 위치 추적 방법

본 논문에서 제안한 방법을 통해 사람을 인식 후, 위치 추적과 예측에 확장 칼만 필터를 사용하였다[25-27]. 확장 칼만 필터는 비강체의 움직임 등에서 움직임을 파악하고 추적하는데 유용하다고 알려져 있다[28,29]. 칼만 필터는 k+1 시점의 상태를 추정(Estimation)하기 위해 k 시점까지의 자료를 이용하여 각 추정 시점마다 연속적으로 최적의 예측(Prediction)을 추구한다. 또한, 시간 영역에서 모델을 형성함으로써 수학적으로 다루기 쉽다는 장점이 있어 관측자료에 대한 실시간 추정 방법으로 많이 이용되고 있다. 하지만 칼만 필터는 선형 시스템에서만 적용 가능하다는 단점이 있다. 확장 칼만 필터는 비선형 시스템을 마지막 추정치의 근방에서 1차식으로 선형화하여 칼만 필터를 적용한 것으로서 선형으로 근사화된 시스템에 대하여 칼만 필터의 특성을 이어받는 장점과 다른 비선형 필터에 비해 연산속도가 빠르다는 장점을 지닌다[30]. 현실에서 시스템이 선형을 따르는 것은 많지 않으므로 확장 칼만 필터를 사용하였다. 사람이라고 판단된 동적 객체에 대해 라이다로 측정한 데이터를 사용하여 위치를 계산한다. 동적 객체의 포인트 값의 평균값을 객체의 위치로 하여, 이 값을 기준으로 이동 경로와 향후 이동 방향을 추정한다.

본 논문에서 사람의 움직임을 예측 및 추적 하기 위해 사람의 위치정보 x, y 좌표와 각도 Θ에 대해 추정하여 확장 칼만 필터를 구성하였다. 사람의 위치정보 x, y 좌표는 라이다를 이용해 수집할 수 있으며, 각도 Θ는 초깃값 0이며 사람의 이전 경로에 대한 다음 움직임이 이루는 각도이다. 사람 위치에 대한 모델링은 다음 식(1)부터 식(3)과 같다.

| (1) |

| (2) |

| (3) |

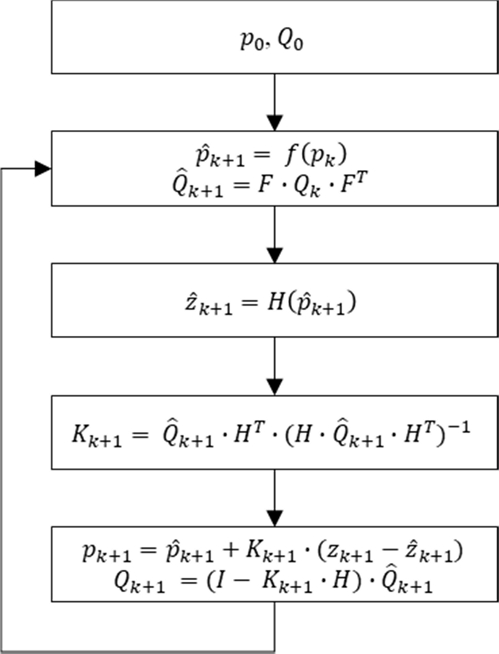

이때의 T는 k와 k+1 사이의 걸린 시간이다. 식(1)을 확장 칼만 필터 알고리즘에 적용시킨다. 확장 칼만 필터의 알고리즘은 Fig. 6과 같다.

1) 상태 모델

| (4) |

2) 관측 모델

| (5) |

k+1번째 예측값 을 구하기 위해 k번째의 추정값 pk에 비선형 함수 f를 사용한다. 예측한 관측값 은 k+1번째 예측값 을 이용하고, 비선형 방정식을 선형화하기 위해 자코비안 행렬을 이용한다.

| (6) |

여기서 k에서의 오차 공분산을 예측하면 식(7)과 같다.

| (7) |

칼만 이득 K를 구하기 위하여 식(8)을 사용한다.

| (8) |

식(8)의 칼만 이득 K를 이용해 k+1번째 추정값 pk+1을 업데이트하면 식(9)와 같다.

| (9) |

여기서 는 오차라고 하며, 측정된 관측값과 예측된 관측값의 차이를 나타낸다. k+1번째 상태 추정이 끝나면 오차 공분산 Qk+1을 식(10)과 같이 업데이트한다.

| (10) |

위치에 대한 초깃값 p0는 사람이 관측되는 순간 확인되는 사람의 위칫값이 되며, 오차 공분산의 초깃값 Q0는 단위행렬로 나타내었다.

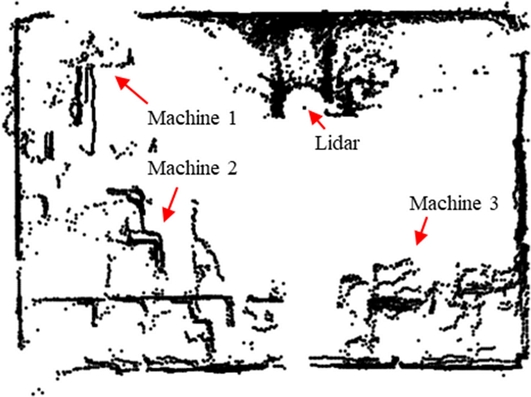

3. 제안된 방법의 실험 및 검증

실제 작업환경에 비슷한 환경에서 테스트하기 위해 기계들이 다수 있는 환경에서 360o 라이다를 1개 설치하여 실험을 하였다. 실험 환경은 Fig. 7과 같다. CNN 학습을 위한 데이터는 3D 라이다 센서 데이터에서 점유 격자 지도 방법을 통해 동적 객체를 추출하고, 추출된 객체의 3D 데이터를 X-Z 평면, Y-Z 평면으로 투영시켜 각 좌표 평면별 이미지로 변환하였다. 이를 통해 얻은 데이터셋은 학습 데이터, 검증 데이터, 시험 데이터로 나누었다. 데이터의 개수는 총 88,820개로 학습 데이터 55,957개, 검증 데이터 23,981개, 시험 데이터 8,882개로 이루어져 있다. 학습은 매 Epoch마다 데이터셋을 무작위로 섞어서 학습시켰으며, 검증 정확도가 99를 초과할 때까지 학습을 실행하였다.

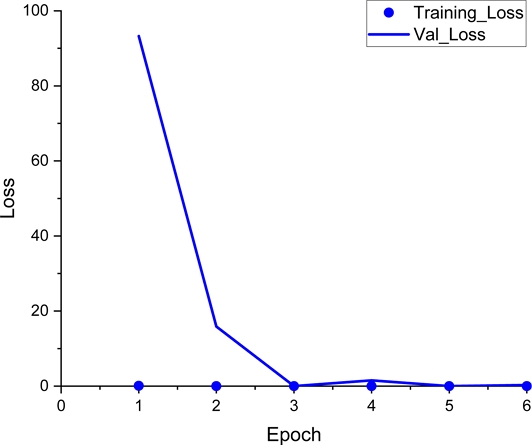

학습 결과, Fig. 8과 같이 6번의 Epoch만에 학습 정확도 99.92, 검증 정확도 99.46%를 얻을 수 있었다.

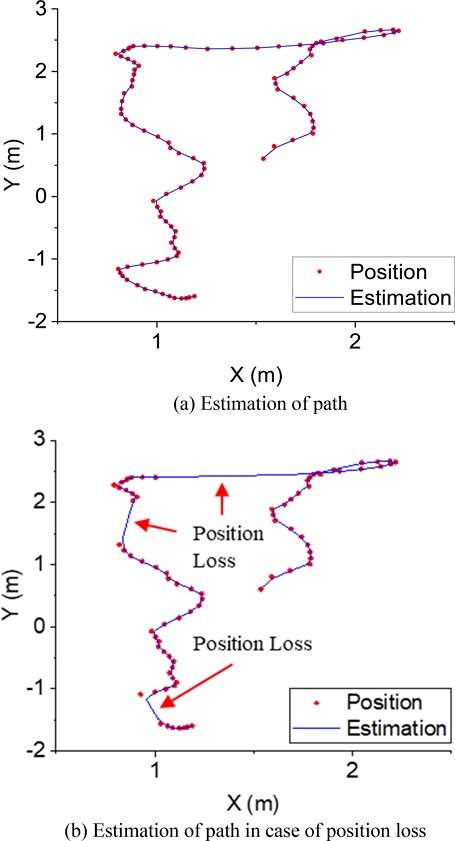

인식된 데이터가 사람인 경우 위치 좌표를 추출하고, 위치 좌표를 칼만 필터의 입력값으로 하여 이동 경로를 추정하였다. Fig. 9(a)에서 점은 실제의 이동 위치이며, 실선은 칼만 필터를 이용해 추정한 경로다. 실제 작업 환경에서 작업자가 무작위의 움직임을 보일 때 이동 경로를 예측할 수 있는지 확인하기 위해 Fig. 9(a)와 같이 무작위의 움직임을 보였으나 실제 이동 경로와 예측된 이동 경로를 비교해 보면 약간의 오차는 있지만 사람의 이동 경로를 예측하여 위치를 파악하고 안전사고를 방지하는 역할을 하는 것에는 문제가 없다고 판단된다. 또한 작업자와 라이다 센서 사이의 장애물에 의해 작업자의 위치를 알 수 없는 경우에도 Fig. 9(b)와 같이 이동 경로를 예측하여 추적하는 것을 확인하였으며 최대오차 27, 평균 오차 5 cm를 보였다.

4. 결론

본 연구는 360o 라이다를 이용하여 실시간으로 사람을 인식하고 위치를 예측 및 추적하는 간단한 방법을 제안하고 실험하여 검증하였다. 점유 격자 지도 기법을 이용하여 라이다 주변의 움직이는 물체를 확인하였고, CNN 기법을 이용해 99.46%의 검증 정확도로 사람을 인식하였다. 인식된 사람에 대하여 확장 칼만 필터를 적용해 이동 경로를 평균 오차 5 cm 수준에서 예측 및 추적하였다.

NOMENCLATURE

| zk : | Measured Position at the Sampling Instance k |

| pk : | Estimated Position at the Sampling Instance k |

| Qk : | Error Covariance at the Sampling Instance k |

| Kk : | Kalman Gain at the Sampling Instance k |

| vk : | Velocity at the Sampling Instance k |

| f : | State Transition Vector Function |

| F : | Jacobian Matrix of f(·) |

| I : | Identity Matrix |

| T : | Time Interval |

Acknowledgments

이 논문은 2021년도 정부(과학기술정보통신부)의 재원으로 정보통신기획평가원의 지원을 받아 수행된 연구임(No. 2021-0-01577, 사상가공용 로봇을 위한 AI 기반 로봇 모니터링 및 운용기술).

REFERENCES

-

Chen, B., Wan, J., Shu, L., Li, P., Mukherjee, M., Yin, B., (2017), Smart factory of industry 4.0: Key technologies, application case, and challenges, IEEE Access, 6, 6505-6519.

[https://doi.org/10.1109/ACCESS.2017.2783682]

-

Wang, S., Wan, J., Li, D., Zhang, C., (2016), Implementing smart factory of industrie 4.0: An outlook, International Journal of Distributed Sensor Networks, 12(1), 3159805.

[https://doi.org/10.1155/2016/3159805]

-

Mabkhot, M. M., Al-Ahmari, A. M., Salah, B., Alkhalefah, H., (2018), Requirements of the smart factory system: A survey and perspective, Machines, 6(2), 23.

[https://doi.org/10.3390/machines6020023]

-

Bdiwi, M., Pfeifer, M., Sterzing, A., (2017), A new strategy for ensuring human safety during various levels of interaction with industrial robots, CIRP Annals, 66(1), 453-456.

[https://doi.org/10.1016/j.cirp.2017.04.009]

-

Cheng, Z., Likai, J., Min, C., Xiangyan, Z., (2021), Mechanical safety risk analysis of smart factory, Journal of Physics: Conference Series, 1884, 012037.

[https://doi.org/10.1088/1742-6596/1884/1/012037]

-

Yan, Z., Duckett, T., Bellotto, N., (2020), Online learning for 3D LiDAR-based human detection: Experimental analysis of point cloud clustering and classification methods, Autonomous Robots, 44(2), 147-164.

[https://doi.org/10.1007/s10514-019-09883-y]

- Koh, J.-H., Kim, J.-K., Kim, Y.-C., Choi, J.-W., (2019), Survey on deep learning-based 3D object detection algorithms using LiDAR data, Communications of the Korean Institute of Information Scientists and Engineers, 37(1), 61-71.

-

Zhao, H., Shibasaki, R., (2005), A novel system for tracking pedestrians using multiple single-row laser-range scanners, IEEE Transactions on Systems, Man, and Cybernetics-Part A: Systems and Humans, 35(2), 283-291.

[https://doi.org/10.1109/TSMCA.2005.843396]

- Takagi, K., Ando, S., Hashimoto, M., (2006), Pedestrian detection using in-vehicle multilayer LiDAR, Proceedings of the 13th World Congress & Exhibition on Intelligent Transport Systems and Services.

-

Mitsou, N. C., Tzafestas, C. S., (2007), Temporal occupancy grid for mobile robot dynamic environment mapping, Proceedings of the Mediterranean Conference on Control & Automation, 1-8.

[https://doi.org/10.1109/MED.2007.4433892]

- Hashimoto, M., Ogata, S., Oba, F., Murayama, T., (2006), A laser based multi-target tracking for mobile robot, Intelligent Autonomous Systems, 9, 135-144.

-

Chen, C., Tay, C., Laugier, C., Mekhnacha, K., (2006), Dynamic environment modeling with gridmap: A multiple-object tracking application, Proceedings of the 9th International Conference on Control, Automation, Robotics and Vision, 1-6.

[https://doi.org/10.1109/ICARCV.2006.345399]

-

Weiss, T., Schiele, B., Dietmayer, K., (2007), Robust driving path detection in urban and highway scenarios using a laser scanner and online occupancy grids, Proceedings of the IEEE Intelligent Vehicles Symposium, 184-189.

[https://doi.org/10.1109/IVS.2007.4290112]

-

Vu, T.-D., Aycard, O., Appenrodt, N., (2007), Online localization and mapping with moving object tracking in dynamic outdoor environments, Proceedings of the IEEE Intelligent Vehicles Symposium, 190-195.

[https://doi.org/10.1109/IVS.2007.4290113]

-

LeCun, Y., Bottou, L., Bengio, Y., Haffner, P., (1998), Gradient-based learning applied to document recognition, Proceedings of the IEEE, 86(11), 2278-2324.

[https://doi.org/10.1109/5.726791]

-

Wang, W., Yang, J., Xiao, J., Li, S., Zhou, D., (2014), Face recognition based on deep learning, Proceedings of the International Conference on Human Centered Computing, 812-820.

[https://doi.org/10.1007/978-3-319-15554-8_73]

-

Ahn, S., (2016), Deep learning architectures and applications, Journal of Intelligence and Information Systems, 22(2), 127-142.

[https://doi.org/10.13088/jiis.2016.22.2.127]

- Srivastava, N., Hinton, G., Krizhevsky, A., Sutskever, I., Salakhutdinov, R., (2014), Dropout: A simple way to prevent neural networks from overfitting, The Journal of Machine Learning Research, 15(1), 1929-1958.

-

Yu, J.-H., Sim, K.-B., (2016), Face classification using cascade facial detection and convolutional neural network, Journal of the Korean Institute of Intelligent Systems, 26(1), 70-75.

[https://doi.org/10.5391/JKIIS.2016.26.1.070]

-

Ji, S., Xu, W., Yang, M., Yu, K., (2012), 3D convolutional neural networks for human action recognition, IEEE Transactions on Pattern Analysis and Machine Intelligence, 35(1), 221-231.

[https://doi.org/10.1109/TPAMI.2012.59]

-

Scherer, D., Müller, A., Behnke, S., (2010), Evaluation of pooling operations in convolutional architectures for object recognition, Proceedings of the International Conference on Artificial Neural Networks, 92-101.

[https://doi.org/10.1007/978-3-642-15825-4_10]

- Krizhevsky, A., Sutskever, I., Hinton, G. E., (2012), Imagenet classification with deep convolutional neural networks, Advances in Neural Information Processing Systems, 25, 1097-1105.

- Aghdam, H. H., Heravi, E. J., (2017), Guide to convolutional neural networks, Springer.

-

Zeiler, M. D., Fergus, R., (2014), Visualizing and understanding convolutional networks, Proceedings of the European Conference on Computer Vision, 818-833.

[https://doi.org/10.1007/978-3-319-10590-1_53]

- Marins, J. L., Yun, X., Bachmann, E. R., McGhee, R. B., Zyda, M. J., (2001), An extended Kalman filter for quaternion-based orientation estimation using MARG sensors, Proceedings of the IEEE/RSJ International Conference on Intelligent Robots and Systems, 4, 2003-2011.

-

Moore, T., Stouch, D., A generalized extended Kalman filter implementation for the robot operating system, Intelligent Autonomous Systems 13, 335-348.

[https://doi.org/10.1007/978-3-319-08338-4_25]

-

Song, Y., Grizzle, J. W., (1992), The extended Kalman filter as a local asymptotic observer for nonlinear discrete-time systems, Proceedings of the American Control Conference, 3365-3369.

[https://doi.org/10.23919/ACC.1992.4792775]

-

Metaxas, D., Terzopoulos, D., (1993), Shape and nonrigid motion estimation through physics-based synthesis, IEEE Transactions on Pattern Analysis and Machine Intelligence, 15(6), 580-591.

[https://doi.org/10.1109/34.216727]

-

Pentland, A., Horowitz, B., (1991), Recovery of nonrigid motion and structure, IEEE Transactions on Pattern Analysis and Machine Intelligence, 13(7), 730-742.

[https://doi.org/10.1109/34.85661]

-

Li, Q., Li, R., Ji, K., Dai, W., (2015), Kalman filter and its application, Proceedings of the 8th International Conference on Intelligent Networks and Intelligent Systems, 74-77.

[https://doi.org/10.1109/ICINIS.2015.35]

MS Student in School of Mechanical Engineering, Kyungpook National University. His research interest is intelligent manufacturing systems.

E-mail: j71bum@gmail.com

Research Fellow in Institute of Mechanical Engineering Technology, Kyungpook National University. His research interests are intelligent manufacturing systems and robotics.

E-mail: kesar@knu.ac.kr

Associate Professor in School of Mechanical Engineering, Purdue University. His research interests are smart manufacturing and micro manufacturing processes.

E-mail: mbgjun@purdue.edu

Associate Professor in School of Mechanical Engineering, Kyungpook National University. His research interest is advanced manufacturing processes.

E-mail: yhjeong@knu.ac.kr

Professor in School of Mechanical Engineering, Kyungpook National University. His research interests are intelligent manufacturing systems and CAD/CAM.

E-mail: syang@knu.ac.kr