객체 탐지를 통한 휠 너트 제품의 단조 공정에서 불량 검출

Copyright © The Korean Society for Precision Engineering

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License (http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

Abstract

This study developed a defect-detecting system for automotive wheel nuts. We proposed an image processing method using OpenCV for efficient defect-detection of automotive wheel nuts. Image processing method focused on noise removal, ratio adjustment, binarization, polar coordinate system formation, and orthogonal coordinate system conversion. Through data collection, preprocessing, object detection model training, and testing, we established a system capable of accurately classifying defects and tracking their positions. There are four defect types. Types 1 and 2 defects are defects of products where the product is completely broken circumferentially. Types 3 and 4 defects are defects are small circumferential dents and scratches in the product. We utilized Faster R-CNN and YOLOv8 models to detect defect types. By employing effective preprocessing and post-processing steps, we enhanced the accuracy. In the case of Fast RCNN, AP values were 0.92, 0.93, 0.76, and 0.49 for types 1, 2, 3, and 4 defects, respectively. The mAP was 0.77. In the case of YOLOv8, AP values were 0.78, 0.96, 0.8, and 0.51 for types for types 1, 2, 3, and 4 defects, respectively. The mAP was 0.76. These results could contribute to defect detection and quality improvement in the automotive manufacturing sector.

Keywords:

Image processing, Object detection, Forging, Wheel nut, Defect detection, Image augmentation키워드:

영상 처리, 객체 탐지, 단조, 휠 너트, 불량 검출, 이미지 증대1. 서론

단조로 제조된 휠 너트는 높은 온도와 압력의 영향으로 금속구조가 밀도 높은 결정 구조로 형성된다. 이에 따라 휠 너트는 높은 강도와 내구성을 가질 수 있어, 주행 중에 발생하는 진동, 충격 및 하중을 견딜 수 있다.

냉간 단조는 생산성과 가격 경쟁력이 우수하고 고정밀/고품질의 금속부품 생산이 가능해 자동차, 전자 등 국내 주력산업부품 제조의 핵심 생산기술이다. 또한 대량 생산을 요하는 국가적 주력산업의 경쟁력에 큰 영향을 주는 뿌리 산업 중 하나이다.

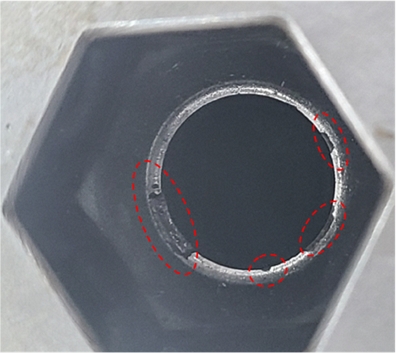

Fig. 1은 자동차용 휠 너트이다. 자동차용 휠 너트는 자동차의 휠을 결합시키기 위한 부품이다. 자동차의 휠과 구동 로터가 결합되도록 하며, 운행 중 휠의 이탈을 방지하는 중요한 기능을 수행한다. 따라서, 차량의 안정성에 직접적인 영향을 미치는 부품 중 하나이다.

휠 너트는 다단 냉간 단조 공정을 통해 생산한다. Fig. 2는 자동차용 휠 너트의 단조 공정 중 하나로, 해당 공정에서 가장 높은 성형 하중이 발생한다. 이때, 하단 금형에 많은 응력이 가해지며, 피로 파괴에 의한 파손이 발생한다. 이와 같이 금형의 파손이 발생하는 경우 제품 표면에 Fig. 3과 같이 파손이 발생한다.

단조 산업의 스마트화[1]를 통해 단조 공정의 생산성을 향상할 수 있고, 제품의 품질 및 가격 경쟁력을 확보할 수 있다. 스마트화에서 머신비전[2]은 인간의 시각과 판단 기능을 기계로 구현한 것으로 이러한 기능을 로봇 시스템이 대체하는 기술이다. 생산품의 최종 검사 단계에 표면 결함 인식을 적용하여 생산성의 개선과 품질개선을 기대할 수 있다[3].

선행연구에는 기어 단면 결함 검출에 객체 검출 방법을 적용하고, 생산 공정에서 금속 기어 단면 결함의 실시간 검출을 실현한 연구[4]와, 패브릭 결함 감지를 자동화하기 위해 바닐라 Faster R-CNN을 기반으로 구축된 패브릭 결함 감지 네트워크(FabricNet)를 제시하여 Faster R-CNN을 개선한 연구[5]가 있다.

본 연구에서는 생산된 제품을 분석하여, 금형 파손 여부를 확인할 수 있는 방법을 제시하고자 한다. 이미지에서 인공지능을 활용하여 사물, 패턴, 형태를 인식하는 방법은 크게 4가지가 있다. 첫 번째로, 분류(Classification)는 주어진 이미지가 어떤 범주 또는 그룹에 속하는지 판별하는 작업을 의미한다. 두 번째로, 분류 및 위치 식별(Classification with Localization)은 주어진 이미지를 분류하는 동시에 해당 객체의 위치를 바운딩 박스로 정확히 지정하는 방법을 나타낸다. 세 번째로, 객체 탐지(Object Detection)는 다양한 객체가 포함된 이미지에서 객체를 감지하고, 각 객체의 위치를 바운딩 박스로 표시하며 해당 객체의 종류를 식별하는 작업이다. 마지막으로, 인스턴스 분할(Instance Segmentation)은 이미지 내에 존재하는 모든 객체를 개별적으로 식별하고, 객체의 경계를 픽셀 수준에서 정확하게 분리하는 작업이다.

제품의 이미지에서 파손 형상과 위치를 객체 탐지를 통해 검출하고자 한다. 객체 탐지는 객체의 위치를 매우 정확하게 파악할 수 있어, 다양한 응용 분야에서 신뢰성 있는 결과를 제공하며 실시간 모니터링 및 응용에 적합하다.

본 연구는 불량 제품의 이미지 데이터를 수집하여 불량 유형을 정의한다. 정의한 유형의 결함을 기준으로 데이터를 분류한다. 이후 대표적인 객체 탐지 모델인 Faster RCNN과 YOLOv8에 데이터를 학습하여 결함의 종류를 분류하고, 위치를 추적하는 결함 검출기의 개발을 목표로 한다.

기존 객체 탐지 모델의 단점은 축 대칭 형상에 대해 특징 형상의 각도에 따라 같은 형상임에도 다르게 분류하고, 학습 데이터와 입력 이미지의 크기 차이가 크면 검출률이 매우 떨어진다는 것이다. 본 연구는 이러한 문제를 해결하기 위해 축 대칭 형상의 이미지를 Open CV 라이브러리를 통해 영상 처리하여 직사각형 형태의 이미지로 가공한다. 가공한 이미지를 데이터 증대를 거쳐 모델에 학습시키고, 검출 결과를 원본 이미지에 출력하여, 불량이 발생한 위치를 가시화하고자 한다.

2. 객체 탐지를 통한 불량 검출

2.1 금형 파손에 따른 휠 너트 제품의 불량 특성 분석

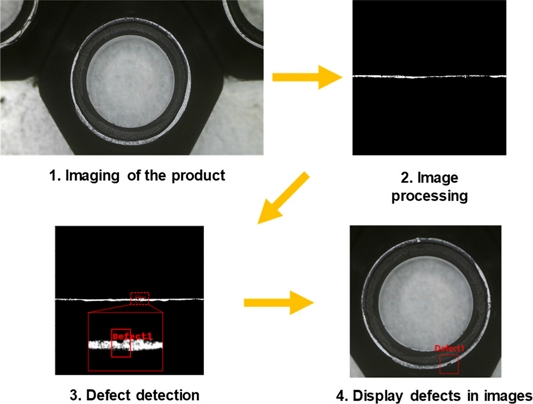

단조 공정에서 생산되는 휠 너트의 이미지데이터 수집 과정은 Fig. 4와 같다. 촬영은 48 MP HDMI 디지털 확대경을 사용하여 촬영하였다. 렌즈 배율은 광학 5배율 렌즈를 사용하여 제품의 표면을 촬영하였다. 모두 동일한 위치에서 촬영하기 위하여 너트 세 개를 고정하고 피사체 너트를 사이에 배치하여 동일한 위치의 너트를 촬영하였다.

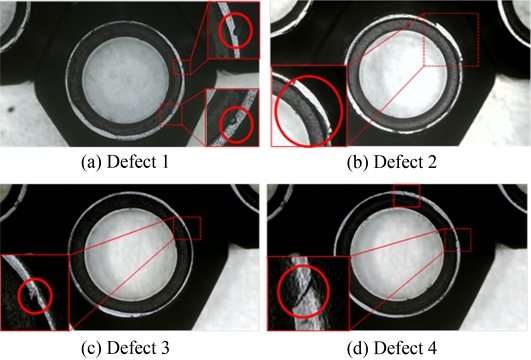

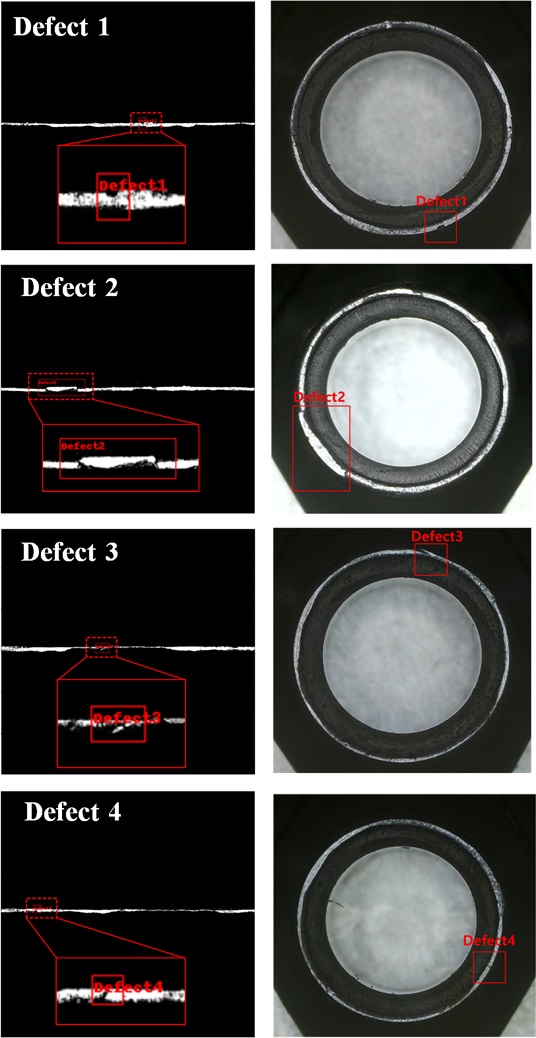

3단 단조 공정에서의 금형의 파손 특성에는 크게 4개의 파손 유형이 있다. 첫 번째는 파손 부분이 넓어서 눌림이나 덧살이 발생하는 경우로 찍힌 결함(Defect 1)과 제품 일부가 완전히 떨어진 결함(Defect 2)이 있으며, 두 번째는 테이퍼 하단의 흠집으로 인한 결함으로 일부가 뾰족하게 튀어나오는 결함(Defect 3)과 반경 방향의 결함(Defect 4)이 해당한다. Fig. 5는 각 결함이 확인되는 이미지의 예시이다.

2.2 객체 탐지 모델

여러 가지 객체 검출 모델 중 서로 다른 장점을 가진 두 가지(Faster R-CNN, YOLOv8) 모델을 선택하였다.

Faster R-CNN [6,7]은 후보 R-CNN의 병목현상을 RPN (Region Proposal Network)의 도입으로 해결한 객체 검출 모델이다. 영역 추출을 위해 사용되는 선택적 검색(Selective Search) 알고리즘은 CPU 상에서 동작하고 이에 따라 네트워크에서 병목현상이 발생한다. RPN은 원본 이미지에서 제안된 위치를 추출하는 네트워크[8]이며, 제안된 위치를 더욱 정교하게 추출하기 위해 다양한 크기와 가로세로비를 가지는 경계 상자인 앵커 상자를 사용한다.

Faster R-CNN의 검출 프로세스는 다음과 같다. 1) 원본 이미지를 미리 학습된 CNN 모델에 입력하여 피처 맵(Feature Map)을 얻는다. 2) 피처 맵은 RPN에 전달되어 적절한 위치를 제안한다. 3) 제안된 위치와 피처 맵을 통해 RoI (Region of Interest) 풀링을 수행하여 고정된 크기의 피처 맵을 얻는다. 4) Fast R-CNN 모델에 고정된 크기의 피처 맵을 입력하여 분류 과정과 경계 상자 회귀를 수행한다.

YOLOv8는 실시간 물체 검출을 위한 최신 버전의 YOLO (You Only Look Once) 모델로, 경량화와 성능 향상을 중점으로 개발되었다. YOLOv8은 입력 이미지를 그리드로 나누고, 각 그리드 셀에서 물체가 존재할 확률과 경계 상자의 위치를 직접 예측한다[9]. 주로 사용되는 딥러닝 아키텍처인 ResNet을 기반으로 한 백본 네트워크(Backbone Network)를 사용하여 특징을 추출한다.

YOLOv8의 검출 프로세스는 다음과 같다. 1. 입력 이미지를 모델의 입력 계층으로 전달한다. 2. 백본 네트워크는 이미지의 다양한 특성을 추출하고 이 정보를 객체 탐지 네트워크로 전달한다. 3. 여러 개의 다양한 크기의 그리드 셀을 사용하여 이미지를 세분화하고 각 셀은 객체의 위치와 클래스에 대한 정보를 예측한다. 예측된 정보는 바운딩 박스의 좌표, 객체 클래스 식별, 신뢰도(객체가 실제로 존재할 확률) 등을 포함한다. 4. 예측한 바운딩 박스는 정확한 위치와 크기로 변환한다. 최종적으로 객체의 위치를 나타낸다.

2.3 영상 처리 과정

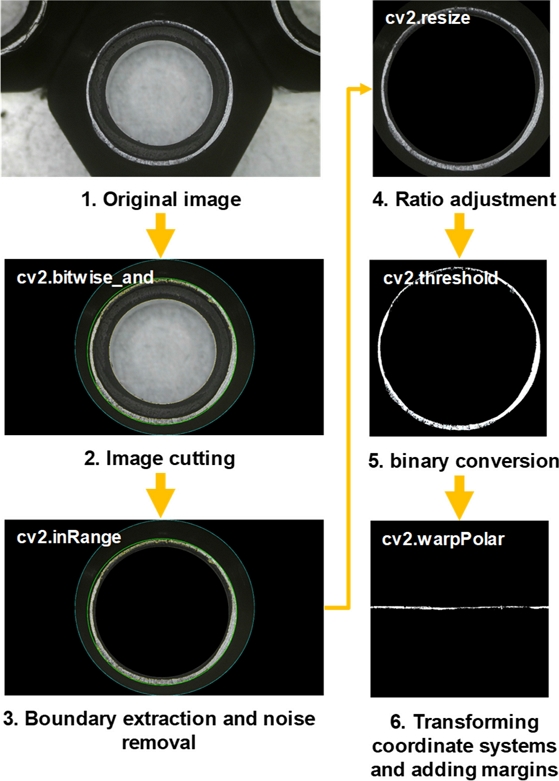

원활한 학습을 위해 영상처리[10]를 활용하여 이미지를 전처리하였다. 이미지 전처리는 Python과 OpenCV를 사용하였다. 프로그램은 Google Colab 환경에서 수행하였다.

이미지 전처리 순서는 Fig. 6과 같다. 1) 촬영한 휠 너트의 원본 이미지를 불러온다. 2) 이미지에서 제품에 해당하는 가운데 부분을 남기고 외부 영역을 제거한다. 그 후, findContours 명령어를 통해 색 추출을 활용하여 휠 너트의 표면과 내부 여백을 추출한다. 또한 minEnclosingCircle 명령어를 통하여 해당 영역에 가장 최소로 접하는 원을 피팅한다. 3) 피팅 한 원의 중심을 기준으로 반지름에 90%에 해당하는 원으로 zeros 명령어를 활용하여 내부의 노이즈를 제거한다. 4) 이후 resize 명령어를 활용하여 가로와 세로의 길이를 각각 600 pixel로 원하는 부분을 자른다. 이는 사용하는 라벨링 툴의 제한으로 정사각형의 이미지만 사용할 수 있기 때문이다. 5) 원활한 결함을 검출하기 위해 Threshold 명령어를 활용하여 이진화 처리를 한다. 6) 마지막으로 기존 객체 탐지 모델의 문제점인 축 대칭 형상에 대해 특징 형상의 각도에 따라 같은 형상임에도 다르게 분류하는 것을 보완하고자 이미지에 극좌표계를 형성하고 직교 좌표계로 변환하는 과정을 통해 Rotate 명령어를 활용하여 이미지를 직사각형으로 변환시킨다.

본 연구에서는 원형의 제품 이미지를 warpPolar를 통해 직사각형 형태로 변형하였다. 이처럼 변형한 이유는 제품의 불량이 원형을 따라 발생하기 때문이다. 일반적인 이미지 검출에서는 이미지의 배치 각도에 따라 이미지 검출이 불가능한 경우가 많다. 따라서 최근 Rotated Object Detection [11] 등이 개발되고 있다. 여기서는 원형 띠 형태의 제품을 직사각형 형태로 변환하여, 파손의 발생 위치와 관계없이, 다양한 형태, 크기, 각도를 갖는 파손이 검출되도록 하였다.

실제 산업 현장에서 제품의 앞면 사진을 위치 상관없이 획득한다면 최소 원 피팅을 통해 원의 중심을 기준으로 동일한 위치로 조정되어 검출에 무리가 없다.

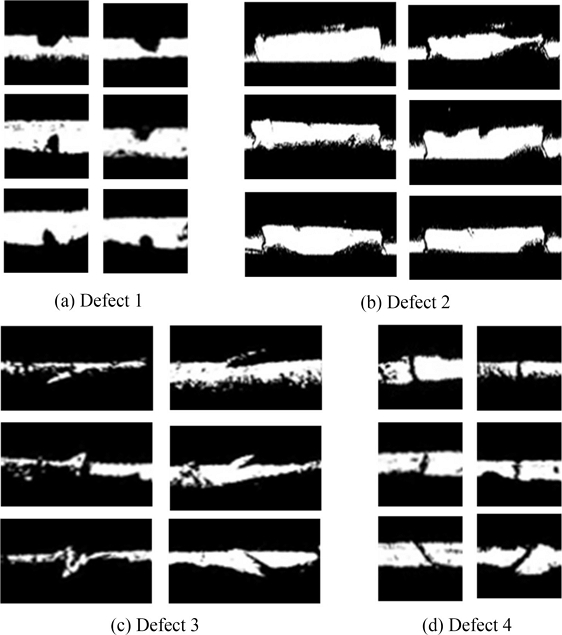

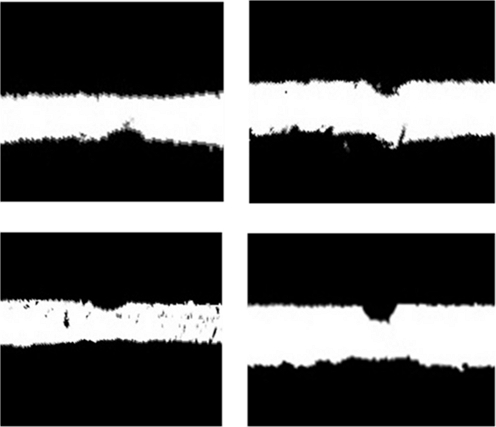

2.4 영상 처리 결과 및 이미지 증대

Fig. 7은 영상처리를 통해 가공한 4가지 종류의 결함에 대한 이미지의 예시이다. 각각의 결함에 대해 결함의 특징이 포함될 수 있도록 영역을 선택하였고, 해당 영역을 라벨링하여 각 결함에 대한 학습 데이터로 사용하였다.

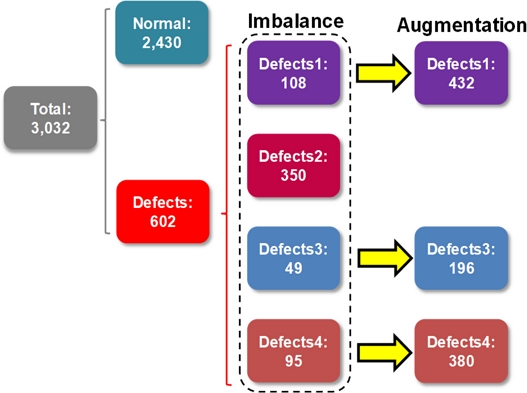

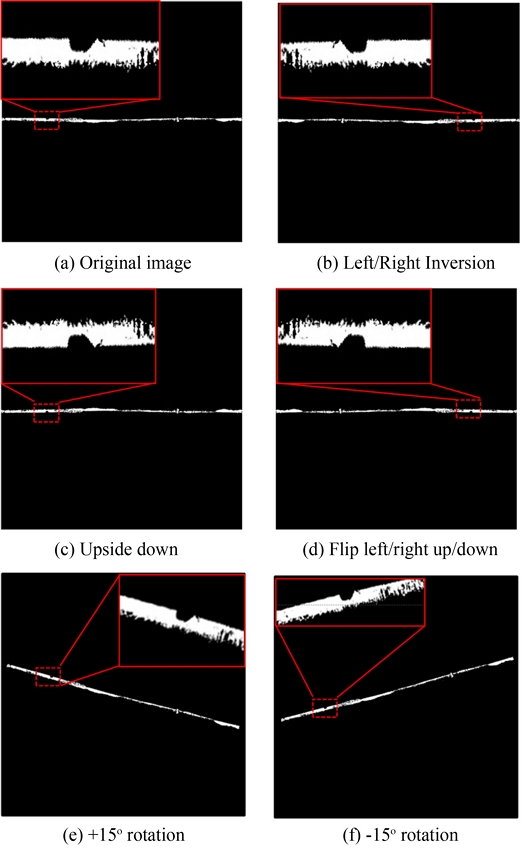

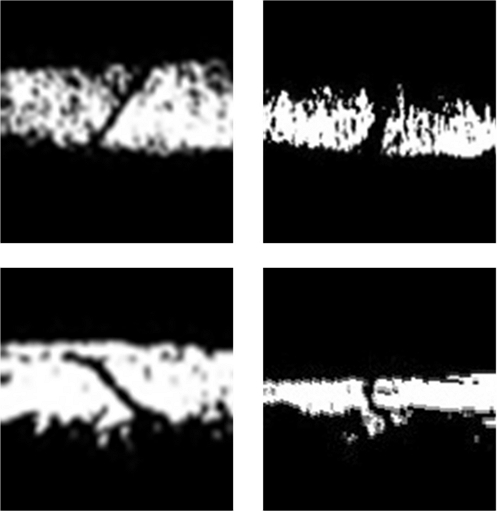

총 수집한 데이터 수는 3,032개(정상 데이터: 2,430개, 결함 데이터: 602개)이다. Defect 2의 데이터 수는 충분하지만, 그 외의 데이터 수가 충분하지 않아 데이터 불균형으로 인한 정확도 하락의 문제를 미연에 방지하고자 이미지 증대를 도입하여 이를 해결하였다. 데이터 증대 방식은 상하 반전, 좌우 반전, 상하좌우 반전을 선택하였으며, 그 결과 Defect 2를 제외한 각 클래스의 데이터 수는 4배로 증대되었다.

Fig. 8은 각 데이터 수 변화를 가시화한 것이며, 최종 학습에 사용된 각 결함의 클래스 당 데이터 수는 결함 1, 2, 3, 4, 각각 432, 350, 196, 380개로 총 1,358개이다. 또한 Fig. 9는 이미지 증대로 생성된 이미지의 예시이다.

3. 객체 검출을 통한 불량 검출

3.1 데이터 라벨링 및 분할

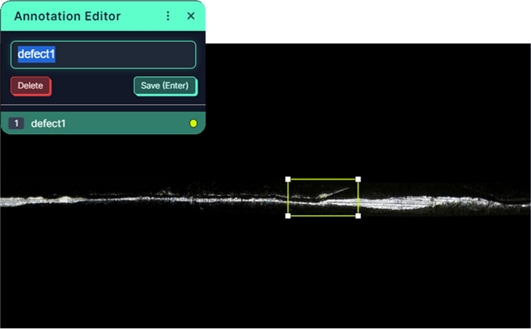

본 연구에서는 이미지 증대를 거친 1,358개의 데이터를 Roboflow [12]에서 제공하는 라벨링 툴을 활용하여 라벨링하였다. Train : Validation : Test = 7 : 2 : 1의 비율로 데이터 분할을 진행하였다. Fig. 10은 Roboflow에서 제공하는 라벨링 툴을 사용하여 라벨링을 진행하는 과정의 예시이다.

3.2 학습 결과

학습은 Faster-RCNN, YOLOv8 모두 클라우드 기반 가상 개발 환경인 Colab에서 진행하였다.

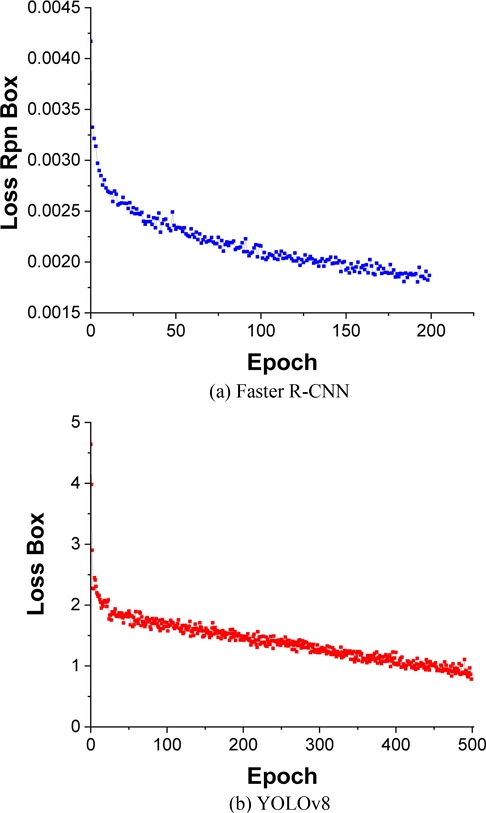

Faster-RCNN 의 경우 Epoch를 200으로 설정했을 때, Loss가 0에 수렴하여 Epoch를 200으로 학습을 진행하였고, YOLOv8 Epoch를 200으로 설정했을 때, Loss가 0.5 정도로 확인되어 Epoch를 500으로 설정하여 학습을 진행하였다. 학습 진행 중 Validation Loss 결과 중 가장 낮은 결과를 기준으로 테스트를 진행하였다. Loss는 학습 시 발생하는 손실을 의미하고 Epoch는 학습의 반복 횟수를 의미하며 AP는 각 클래스의 정확도를 의미한다. mAP는 모든 클래스의 평균 AP를 의미한다.

Fig. 11(a)는 Epoch를 200으로 학습한 Faster-RCNN의 Loss이며, Fig. 11(b)는 Epoch를 500으로 학습한 YOLOv8의 Loss이다. Faster-RCNN, YOLOv8 모두 Epoch가 증가함에 따라, 0에 수렴하는 것을 확인하여 적절한 학습[4]으로 판단하였다.

휠 너트의 4가지 Defect 유형 중 가장 AP (Average Precision)값이 높게 나온 결함은 Defect 2로, Faster-RCNN, YOLOv8 모두 90% 이상으로 가장 높게 나왔다. 반면, Defect 4는 다른 결함과는 다르게 Faster-RCNN, YOLOv8에서 모두 가장 낮은 AP값을 도출하였다.

Defect 1의 경우 AP가 Faster R-CNN과 YOLOv8의 차이가 가장 큰 것으로 확인되었다. 이는 Defect 1의 크기가 비슷하여 Faster R-CNN에서 풀링을 통한 피처 맵의 크기를 제안하는 과정에서 효율적이기 때문에 Faster R-CNN에서 YOLOv8보다 높은 AP 값을 도출함을 확인하였다.

Faster-RCNN과 YOLOv8에서의 각 Class마다 AP (Average Precision) 값과 mAP (mean Average Precision)는 Table 1과 같다. Faster-RCNN에서의 mAP값은 77%이므로, YOLOv8의 mAP값 인 76%보다 높은 값을 도출하는 것을 확인하였다.

3.3 후처리 및 불량 검출 결과

Faster R-CNN과 YOLOv8을 통해 불량 검출한 이미지는 직교 좌표계로 변환한 일자 이미지이다. 해당 이미지의 검출 결과를 원본 이미지에 표시하기 위해 경계 상자의 위치를 다시 극좌표계로 변환할 필요가 있다. 원본 이미지에 극좌표계를 형성하면 3시 방향을 기준으로 시계방향으로 0에서 360까지 각도가 증가한다. 또한 직교 좌표계에서 불량의 수평 방향 위치의 비율이 극좌표계의 각도와 비례한다. 이로부터 극좌표 원점 기준 경계상자 중심의 각도를 계산한다. 이후 중심 위치를 보정한 후 전 처리되기 이전의 원본 이미지에 Class와 경계상자를 표시한다. 해당 과정은 Fig. 12와 같다.

Fig. 13은 전처리된 이미지로 학습한 모델의 검출 결과와 해당 결과에서 바운딩 박스의 위치 정보를 통해 원본 이미지에 다시 출력한 결과의 각 클래스의 예시 이미지이다. 이때, IoU = 0.6을 기준으로 결함 여부를 판단하였다. IoU 값이 커지면 정밀도가 증가하지만 재현율이 감소한다. 총 Test 이미지 133개에 대해서 진행하였으며, 결함유형별로 원활히 검출해내는 것을 확인하였다. 결함유형별로 원활히 검출해내는 것을 확인하였으나, 반경 방향의 결함인 Defect 4의 경우 다른 결함과는 다르게 픽셀 수가 작고, 단조공정에서 생산되는 휠 너트의 특성상 쓸린 부분의 형상이 반경 향 결함과 유사하며, Defect 4 자체를 Background로 인식하는 경우가 있으므로, 검출률이 떨어지는 경향을 보였다.

4. 고찰

Faster R-CNN과 YOLOv8의 손실 그래프가 0에 수렴하는 것으로 보아 학습이 원활하게 진행됨을 확인했다. 하지만 Defect 1의 경우 Faster R-CNN과 YOLOv8의 검출률이 차이가 발생하였고, Defect 4의 경우 모두 낮은 검출률을 보였다.

Defect 1의 AP가 Faster R-CNN과 YOLOv8의 차이가 가장 컸다. YOLOv8을 통해 검출하지 못한 Defect 1의 제품 사진 중 일부를 Fig. 14에 정리하였다. Fig. 13에서와 같이 결함의 크기가 작은 경우 YOLOv8에서는 검출 성능이 좋지 못하였다. 하지만 Faster R-CNN에서 풀링을 통한 피처 맵의 크기를 제안하는 과정에서 효율적[5]이기 때문에 검출 효율이 더 높았다.

Defect 4의 특징 형상이 명확하지 않아 검출률이 가장 떨어지는 것으로 보이며, 그 이유는 Defect 1과 다르게 표면이 완전히 분리된 형태로 검은색의 여백과 구분이 원활하지 않은 것으로 판단된다. 또한 해당 불량은 YOLOv8과 Faster R-CNN 모두 유사하게 검출 효율이 낮았다. 검출이 어려운 제품 사진은 Fig. 15와 같다.

본 연구를 통해 개발된 자동차용 휠 너트 결함 검출기는 사용자의 지식수준과 무관하게 단순하게 작동하고, 공간의 제약 없이 카메라와 컴퓨터로 조작이 가능하며, 모든 제품에 대해서 동일한 기준으로 품질 검사를 진행하기에 실제 산업 현장에서 불량률을 줄이는데 기여할 것으로 기대한다. 현재 결함의 형상을 통해 금형의 마모를 파악하고 금형 교체 주기를 예상하는 등의 연구를 진행 중이다.

5. 결론

본 연구에서는 자동차용 휠 너트의 냉간 단조 공정에서 발생하는 금형 파손으로 인한 불량 검출을 위해 객체 탐지 기술을 적용하였다. 이미지 데이터 수집, 영상 처리, 데이터 증대, 라벨링, Faster R-CNN 및 YOLOv8 모델 학습 및 검증 등의 다양한 단계를 거쳐 불량 휠 너트를 식별하고 위치를 추적하는 결함 검출기를 개발하였다. 이 과정에서 데이터 불균형 문제를 극복하기 위해 이미지 데이터를 증대하였으며, 다양한 불량 유형에 대한 검출 정확도를 향상하기 위해 Faster R-CNN 및 YOLOv8 모델을 비교하였다.

연구 결과, Faster R-CNN과 YOLOv8 모두 불량 휠 너트의 검출에서 높은 성과를 보였다. 두 모델의 mAP는 각각 77, 76%로 나타났으며, 특히 Defect 2에 대한 검출률은 두 모델에서 90% 이상으로 높게 나타났다.

불량 휠 너트의 검출 과정에서 Defect 4의 검출률이 다른 결함에 비해 낮았지만, 본 연구에서 개발한 결함 검출기는 불량 휠 너트의 대부분을 식별하고 위치를 추적할 수 있는 방법임을 확인하였다.

이러한 결과는 자동차 부품 제조 공정에서 불량 검출을 자동화하고 생산 효율성을 향상할 수 있는 가능성을 제시한다. 또한, 이 기술은 다른 산업 부문에서도 응용할 수 있으며, 불량 검출 및 품질 향상에 큰 도움이 될 것으로 기대된다.

Acknowledgments

본 연구는 서울과학기술대학교 교내연구비의 지원으로 수행되었으며, 연구에 도움을 주신 ㈜풍강에 감사드립니다.

REFERENCES

-

Kim, D., Kong, J., Lim, J., Sho, B., (2020), A study on data collection and object detection using faster R-CNN for application to construction site safety, Journal of the Korean Society of Hazard Mitigation, 20(1), 119-126.

[https://doi.org/10.9798/KOSHAM.2020.20.1.119]

- Yu, S., Lee, H., Park, T., Yoon, J., Seo, K., (2021), A comparative study on the performance of deep learning model for small defects in metal precision casting products, Proceedings of the Human Computer Interaction Korea 2022, 677-681.

- Lee, M.-R., Yasir, S. M., Ahn, H., (2022), Defect detection of motion blurred metal surface images using YOLOv5, Proceedings of the Journal of the Institute of Electronics and Information Engineers, 2267-2268.

-

Su, Y., Yan, P., (2020), A defect detection method of gear end-face-based on modified YOLO-v3, Proceedings of the 2020 10th Institute of Electrical and Electronics Engineers International Conference on Cyber Technology in Automation, Control, and Intelligent Systems (CYBER), 283-288.

[https://doi.org/10.1109/CYBER50695.2020.9279161]

-

Zhou, H., Jang, B., Chen, Y., Troendle, D., (2020), Exploring faster R-CNN for fabric defect detection, Proceedings of the 2020 Third International Conference on Artificial Intelligence for Industries (AI4I), 52-55.

[https://doi.org/10.1109/AI4I49448.2020.00018]

- Kim, H. S., Ko, D. B., Lee, W. G., Bae, Y. S., (2022), A study on tire surface defect detection method using depth image, Journal of the Korean Information Processing Society Transactions on Software and Data Engineering, 11(5), 211-220.

-

Kim, D.-C., Park J.-M., Lee, S.-.M, Hone, I.-H., Kim, S.-K., Lee, W.-G., Bae, Y.-S., (2022), Detection of foreign object in cutting surfaces using artificial intelligence in plastic processing, The Journal of Korean Institute of Information Technology, 20(2), 1-10.

[https://doi.org/10.14801/jkiit.2022.20.2.1]

-

Roh, M.-C., Lee, J.-Y., (2017), Refining faster-rcnn for accurate object detection, Proceedings of the Fifteenth IAPR International Conference on Machine Vision Applications (MVA), 514-517.

[https://doi.org/10.23919/MVA.2017.7986913]

-

Lee, S.-H., Kang, S.-H., Shin, Y.-S., Choi, O.-K., Kim, S.-J., Kang, J.-M., (2022), YOLO-based detection of metal surface defects, Journal of Korean Institute of Intelligent Systems, 32(4), 275-285.

[https://doi.org/10.5391/JKIIS.2022.32.4.275]

- Park, J.-B., Park, Y.-S., Kim, Y.-J., (2021), Defect detection of metal facility based on convergence technology of deep learning and image processing, Proceedings of the Korean Institute of Electrical Engineers 2021 Autumn Conference, 181-183.

-

Koo, J., Seo, J., Jeon, S., Choe, J., Jeon, T., (2018), RBox-CNN: Rotated bounding box based cnn for ship detection in remote sensing image, Proceedings of the 26th ACM SIGSPATIAL International Conference on Advances in Geographic Information Systems, 420-423.

[https://doi.org/10.1145/3274895.3274915]

-

ACM Digital Library, RBox-CNN: Rotated bounding box based CNN for ship detection in remote sensing image. https://dl.acm.org

[https://doi.org/10.1145/3274895.3274915]

Undergraduate Student in the Department of Mechanical Information Engineering in Seoul National University of Science and Technology. His research interests include machine vision, AI metal forming.

E-mail: ckdeo2301@seoultech.ac.kr

Undergraduate Student in the Department of Mechanical Information Engineering in Seoul National University of Science and Technology. His research interests include machine vision, AI metal forming.

E-mail: sw174800@seoultech.ac.kr

Professor in the Department of Mechanical System and Design Engineering, Seoul National University of Science and Technology. His research interests include simulation (FEM) and sheet metal forming.

E-mail: wjchung@seoultech.ac.kr

Associate Professor in the Department of Mechanical System and Design Engineering, Seoul National University of Science and Technology. His research interests include simulation and development of the metal forming process and lightweight materials.

E-mail: cwlee@seoultech.ac.kr