VR 인터페이스 기반의 동적 물체의 원격 매니퓰레이션을 위한 실시간 환경 가상화 방법

Copyright © The Korean Society for Precision Engineering

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License (http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

Abstract

With the evolution of robotic technology, the expansion of operations into challenging environments underscores the growing need for effective teleoperation systems. In such an environment, robots or machines can improve the efficiency and safety of tasks by delivering more detailed and accurate information to workers through virtual reality (VR). Current teleoperation systems have limitations in providing a comprehensive understanding of the work environment. Accordingly, this study proposes a technology that utilizes VR to provide a high level of telepresence to workers and enable intuitive control. To achieve this, we introduce a pregenerated computer-assisted design model for static objects beyond the viewing area of RGB-D cameras and a method to update the point cloud of the target objects, which are dynamic objects, in real-time. By incorporating this information, we created a 3D visual map and delivered it to the operator in real-time through HMD, enabling the operator to clearly recognize the robot's current location and surroundings. In addition, we introduced hand motion recognition through HMD viewpoints and VR controllers, allowing the operator to intuitively control the robot. These techniques can improve the efficiency and safety of remote work.

Keywords:

Telemanipulation, VR interface, 3D visual map, Telepresence키워드:

원격 제어, VR 인터페이스, 3차원 시각 지도, 원격 현장감1. 서론

로봇 기술의 발전에 따라 사람이 접근할 수 없는 지역에서의 작업 또는 시간과 비용의 절감을 위해 원격 제어(Telemanipulation) 기술과 관련된 연구가 활발하게 진행되고 있다[1-3]. 로봇이 재난 환경, 산악 지역, 우주 공간 등 다양한 환경에서 인간의 업무를 보조하거나 대행하는 경우, 이러한 로봇의 효율적인 원격 제어가 필수적으로 요구되고 있다. 그중에서도 가상 현실(Virtual Reality, VR)과 증강 현실(Augmented Reality, AR)을 통한 원격 제어는 사용자에게 원격 현장감(Telepresence)을 제공함으로써 효과적인 작업 수행을 가능하게 한다. 따라서 VR과 AR을 활용한 원격 제어 연구는 최근 몇 년 동안 활발하게 이루어지고 있다[4,5].

VR/AR 기반 원격 현장감을 위한 시각 정보 전달 기술에 관한 연구[6]에서는 원격 현장감의 필요성과 VR/AR 기반의 원격 현장감을 위한 시각 정보 전달 기술 중 Point Cloud, 복셀(Voxel), View Synthesis와 객체 자세 추정의 특징과 문제점에 관해 설명하였다. 그중 Point Cloud의 경우, 원격 환경을 그대로 전달하기 때문에 사용자가 환경에서 객체를 구분하기 어렵다는 단점이 있다.

Head Mounted Display (HMD)를 활용해 4족 보행 로봇을 원격으로 제어한 연구[7]에서는 VR 환경을 통해서 작업자에게 로봇에 부착된 카메라부터 얻은 Depth 정보와 RGB 이미지 정보 그리고 로봇의 현재 상태에 대한 정보를 실시간으로 제공하여 Target Object를 Pick and Place 하는 것을 목표로 한다. 하지만 로봇에 부착된 카메라로부터 작업자에게 전송된 화면은 2D 이미지로 제공되는 반면, 로봇의 현재 상태는 3D로 표현되기 때문에 작업자는 로봇의 카메라 화면과 로봇의 상태를 연결 지어 이해해야 된다는 문제점이 존재한다.

HMD를 활용해 Manipulator를 원격 제어하는 연구[8]에서는 작업자에게 로봇의 현재 상태와 로봇의 부착된 카메라의 RGB 이미지, Point Cloud 데이터를 실시간으로 제공한다. 이 데이터를 통해 작업자는 현재 로봇의 상태를 파악하고, Target Object와 Manipulator End Effector(이하 EEF) 사이의 거리를 쉽게 파악할 수 있다. 하지만 로봇에 부착된 카메라의 현재 Point Cloud만을 활용하기 때문에 Field of View(이하 FOV) 내의 환경 정보를 얻을 수는 있지만, 로봇이 위치한 전체적인 환경에 대한 포괄적인 정보를 얻을 수 없다는 문제점이 존재한다.

본 연구는 로봇의 현재 자세와 작업 공간의 이해를 돕고, FOV 내에 동적인 물체에 대한 실시간 업데이트를 통해 원격 작업 환경의 원격 현장감을 향상시키는 기술을 제시한다. 사전에 작업 환경의 모델링을 통해 CAD 모델과 획득된 Point Cloud를 결합하여 3D Visual Map을 생성한다. 이를 통해 작업자는 작업 환경을 더 명확하게 이해할 수 있다. 또한, 작업자의 시점을 작업자가 바라보는 방향을 기반으로 동적으로 설정하여 작업자가 필요한 위치와 방향에서 작업 환경을 쉽게 파악할 수 있도록 지원한다. 3D Visual Map은 작업자의 HMD로 공유되어 작업자가 로봇의 현재 자세와 주변 환경을 명확하게 인식할 수 있도록 한다. 더불어, VR 컨트롤러를 통해 작업자의 손동작을 실시간으로 추적하여 Manipulator를 직관적으로 원격 제어함으로써 작업 효율성을 향상시킨다. 또한 본 논문에서 제안하는 방법을 활용하여 실험을 통해 Target Object를 Pick and Place 하는 작업의 효율성과 정확성이 향상됨을 증명한다.

2. 문제 정의

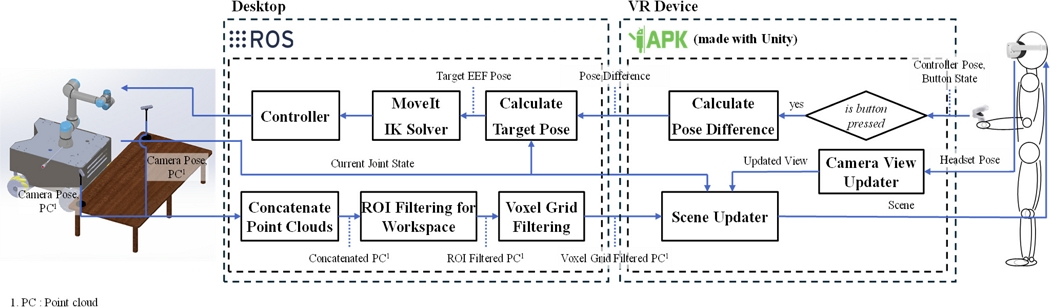

본 논문에서는 원격 현장감 있는 VR 인터페이스 개발을 위해 RGB-D 카메라를 통해 획득한 Point Cloud 정보를 전처리 과정을 통해 Target Objects’ Point Cloud와 Solidworks를 통해 제작한 고정된 환경 요소들의 CAD Model, Manipulator 상태가 포함된 3D Visual Map을 생성한다. 생성된 3D Visual Map을 VR 디바이스인 Meta 사의 Oculus Quest 2(이하 VR 디바이스)를 활용하여 VR 인터페이스를 통해 작업자에게 제공한다. 이때 RGB-D 카메라의 데이터 처리와 Manipulator의 제어는 데스크탑 OS인 Ubuntu 20.04에서 ROS Noetic을 활용하여 개발하였고, VR 인터페이스의 개발은 게임 엔진 중 Unity를 사용하여 Fig. 1와 같이 진행하였다.

작업 공간 내의 Target Object를 확인하기 위해 작업 공간의 양옆으로 설치한 두 카메라의 데이터를 하나의 일관된 좌표계로 매핑하고 병합함으로써 통합된 시각적 정보를 얻는다. 다음으로, 관심 영역(Region of Interest, ROI)을 설정하고 Passthrough Filter를 적용하여 특정 작업 영역에 대한 정보를 추출한다. 데이터 처리의 효율성을 높이기 위해 Voxel Grid Filter를 사용하여 중복점을 제거하고 Down Sampling된 Point Cloud를 생성한다. 이 데이터는 Unity의 Scene Updater를 통해 VR 헤드셋으로 전송된다.

원격 제어를 위해 작업자가 헤드셋을 통해 Manipulator 주변 환을 공유받고 컨트롤러의 버튼을 누른 상태에서 VR 디바이스의 컨트롤러를 움직일 경우, 컨트롤러의 자세 변화량을 ROS로 전달한다. ROS에서는 자세 변화량을 활용해서 EEF의 목표 자세를 계산한다. EEF의 목표 자세를 IK (Inverse Kinematics) Solver에서 Manipulator 각 축의 각도로 역기구학 해석한 후 Controller에서 Manipulator를 제어한다.

3. VR 인터페이스 디자인 및 원격 제어

3.1 작업 공간 내 Object 스캔

Manipulator의 작업 공간 내의 존재하는 Objects를 특정하고 VR 인터페이스에 시각화하기 위해서 두 대의 RGB-D 카메라를 통해 얻은 RGB 정보를 포함한 Point Clouds를 사용한다. 전처리 과정에서 연산 횟수를 최소화하기 위해 두 Point Clouds를 병합한다. 두 Point Clouds를 하나의 Point Cloud로 병합하기 위해, 각 RGB-D 카메라로부터 획득한 Point Clouds의 좌표는 각 RGB-D 카메라의 자세를 원점으로 하는 좌표계로부터 통일시키기 위해 새롭게 생성한 기준 좌표계로 매핑(Mapping)하여 표현한다. 각 Point Cloud를 기준 좌표계로 매핑하는 과정은 식(1)과 같다.

For every points in pointcloud,

| (1) |

xmap, ymap, zmap은 매핑 후 좌표를 의미한다. 는 각 카메라 좌표계로부터 기준 좌표계로 매핑을 위한 변환 행렬이고, x, y, z는 매핑 전 좌표를 의미한다. 식(1)을 통해 하나의 기준 좌표계로 매핑한 두 Point Clouds를 병합한다. 위와 같은 과정으로 서로 다른 시점의 Point Cloud인 Figs. 2(a)와 2(b)를 병합하여 Fig. 2(c)와 같은 결과를 획득하였다.

Concatenate point clouds (a) Right camera’s point cloud, (b) Left camera’s point cloud, and (c) Concatenated point cloud

병합된 Point Cloud는 작업 공간 내의 Objects만 특정하기 위해서 다음과 같은 과정으로 전처리한다. 먼저 Objects에 해당하는 점들만 남을 수 있도록 카메라의 FOV 내에 고정된 환경을 제외한 영역을 ROI로 설정한다. Passthrough Filter를 통해 XYZ 좌표 공간에서 ROI 범위에 해당하는 각 축에 대한 최솟값과 최댓값을 설정하여 범위에 속하지 않는 점들을 제거한다.

이후 병합된 Point Cloud에서 중복되거나 불필요한 정보를 제거하고 데이터를 효과적으로 축소하기 위해 Voxel Grid Filter를 사용한다. Voxel Grid Filter는 3D 공간을 격자로 분할하고, 각 격자 내에서의 대푯값으로 복셀화하여 작업 공간 내의 객체를 표현하면서도 계산 비용을 최소화한다.

최종적으로, 복셀화된 Point Cloud의 Noise를 제거하기 위해 밀도 기반 클러스터링(DBSCAN, Density-based Spatial Clustering of Applications with Noise)을 적용한다. DBSCAN은 각 점을 중심으로 하는 반경(Epsilon) 내에 최소한의 이웃 점이 존재하면 해당 점을 클러스터에 할당한다. 이웃 점의 밀도가 일정 기준 이상이 되면 클러스터를 확장한다. 이 과정에서 클러스터에 속하지 못한 점들을 Noise로 간주한다. DBSCAN을 활용하여 작업 공간 내의 Object를 명확하게 구분하고 Noise를 제거한다. Fig. 3에서 ROI Filter와 Voxel Grid Filter를 거친 Point Cloud에서 DBSCAN을 통해 Noise가 제거됨을 확인할 수 있다.

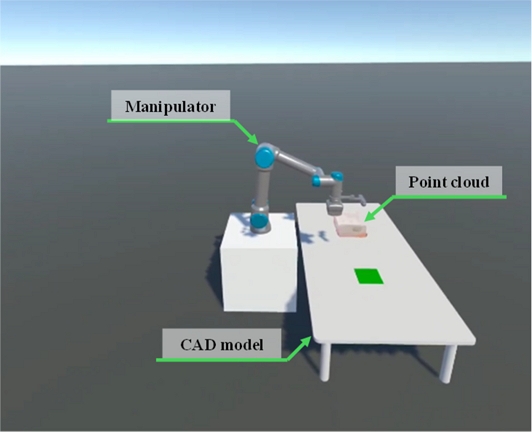

3.2 VR 인터페이스

Manipulator를 원격으로 제어할 작업자에게 Manipulator의 현재 상태 및 Target Objects와 같은 환경 정보를 시각적으로 제공하기 위해 Unity를 사용한 VR 인터페이스를 개발한다. 인터페이스를 통해 3차원 공간에 전처리된 Point Cloud와 Solidworks를 사용하여 CAD Model로 제작한 고정된 환경 요소들을 Fig. 4와 같이 렌더링한다. Manipulator의 CAD Model은 ROS로부터 현재 조인트 상태를 반영하여 위치 및 방위를 현재 Manipultor의 상태와 동일하게 조정한다. 이를 통해 작업자는 VR 환경에서 Manipulator의 현재 상태를 시각적으로 파악할 수 있다.

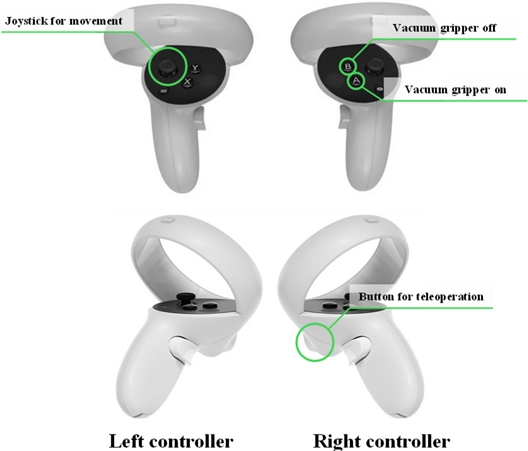

VR 공간에서의 상호작용을 통해 원격 제어를 하기 위해서 작업자의 VR 디바이스를 통해 헤드셋과 컨트롤러의 자세 및 조이스틱과 버튼의 상태를 실시간으로 획득한다. 이 정보를 활용하여 VR 환경에서 양손의 컨트롤러를 렌더링하여 작업자가 현재 가상 공간에서 어떻게 상호작용하고 있는지 시각적으로 확인할 수 있다. 또한, Fig. 5와 같이 지정된 왼쪽 컨트롤러의 조이스틱을 조작하면 입력된 값을 2D 벡터로 표현한다. 2D 벡터를 바탕으로 VR 공간상의 시점을 이동시키기 위한 이동 방향과 속도를 결정한다. 조이스틱을 활용한 시점의 이동은 작업자는 물리적인 이동없이도 VR 공간 내에서 다양한 위치로 이동할 수 있다. 또한, VR 헤드셋의 위치 및 방위를 활용하여 VR 공간 내에서 시점의 위치와 방위를 동적으로 조절한다. 이를 통해 작업자는 컨트롤러의 조이스틱 조작과 헤드셋의 위치 및 방위 조절을 통해 다양한 시점에서 VR 공간의 작업 환경을 관찰할 수 있다. 이러한 시스템은 고정된 위치에서 작업을 수행하는 작업자가 다양한 시점에서 작업 공간을 자세히 살펴보고 상호작용할 수 있도록 한다.

3.3 원격 제어

Manipulator를 VR 디바이스의 컨트롤러를 활용해서 원격 제어하기 위해서 다음과 같은 과정을 통해 EEF의 목표 자세를 계산하였다. 먼저, Fig. 5와 같이 지정된 오른쪽 컨트롤러의 버튼이 눌렸을 경우, 그때의 컨트롤러의 자세와 EEF의 자세를 각각 Home Pose로 설정한다. 버튼이 눌리는 동안 VR 공간의 원점에서 바라본 컨트롤러의 Home Pose 와 현재 컨트롤러의 자세 로 식(2)를 통해 컨트롤러의 Home Pose로부터 자세의 변화량 를 구한다.

| (2) |

컨트롤러의 Home Pose로부터 자세의 변화량 와 EEF의 Home Pose 를 통해 EEF의 목표 자세를 구할 수 있다. 이때 VR 공간의 좌표계 Manipulator의 좌표계가 다르므로, 식(3)을 통해 VR 공간의 좌표계로부터 Manipulator의 좌표계로 변환하는 행렬인 를 활용하여 EEF의 목표 변화량인 를 구한다.

| (3) |

최종적으로, 계산된 EEF의 목표 변화량 과 EEF의 Home Pose 를 활용하여 EEF의 목표 자세 를 계산한다. 그 과정은 식(4)와 같다.

| (4) |

4. 실험 평가

4.1 실험환경 구축

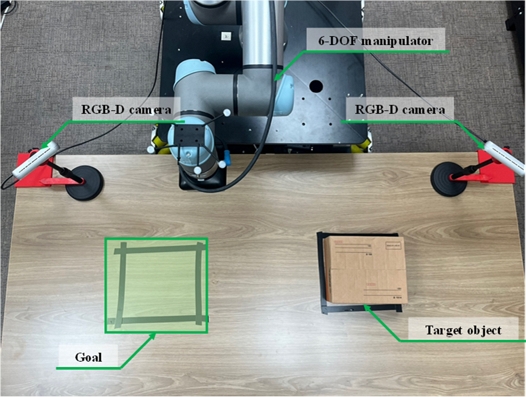

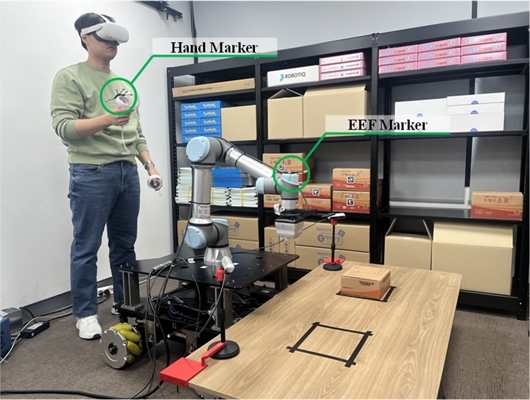

본 논문에서는 새롭게 디자인한 원격 제어를 위한 VR 인터페이스를 검증하기 위해 실험환경을 Fig. 6와 같이 구축하였다. 6-DOF Manipulator인 Universal Robotics 사의 UR5e를 원격 제어하여 Target Object의 Pick and Place를 수행할 때, Objects의 위치, 크기, 색상 등의 정보를 획득하기 위해 Fig. 6과 같이 작업 공간의 사각지대를 최소화하여 촬영할 수 있도록 RGB-D 카메라인 RealSense 사의 D455를 작업 공간의 양쪽으로 FOV가 겹치도록 두 대 설치하였다.

4.2 실험 방법

추종 정확성을 평가하기 위해 Fig. 7과 같이 작업자의 손과 Manipulator EEF에 마커를 부착하고 모션 캡처 카메라인 Optitrack사의 Prime 13을 이용하여 원격 제어할 때 작업자의 손 궤적과 Manipulator EEF 궤적을 획득하였다.

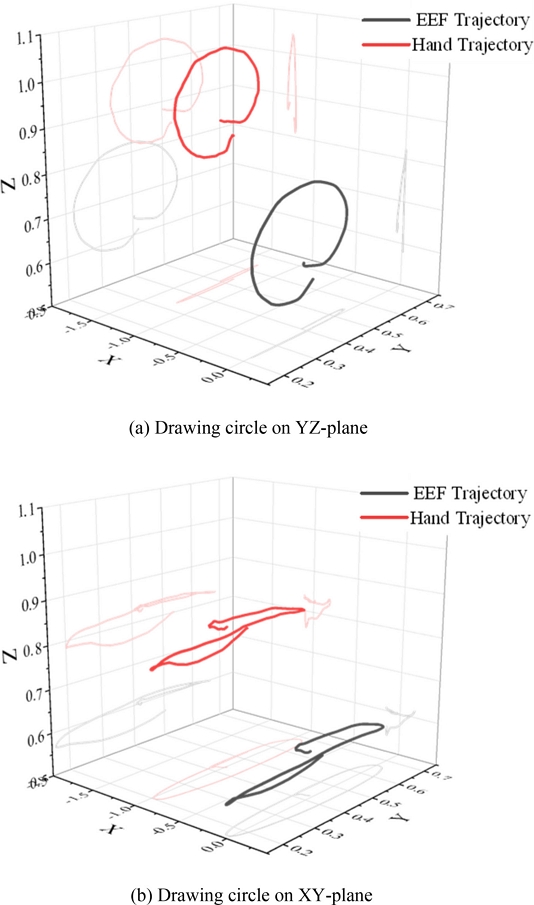

Figs. 8(a)와 8(b)는 각각 YZ 평면과 XY 평면에 원을 그렸을 때 작업자의 손과 Manipulator EEF 궤적을 나타낸 것이다.

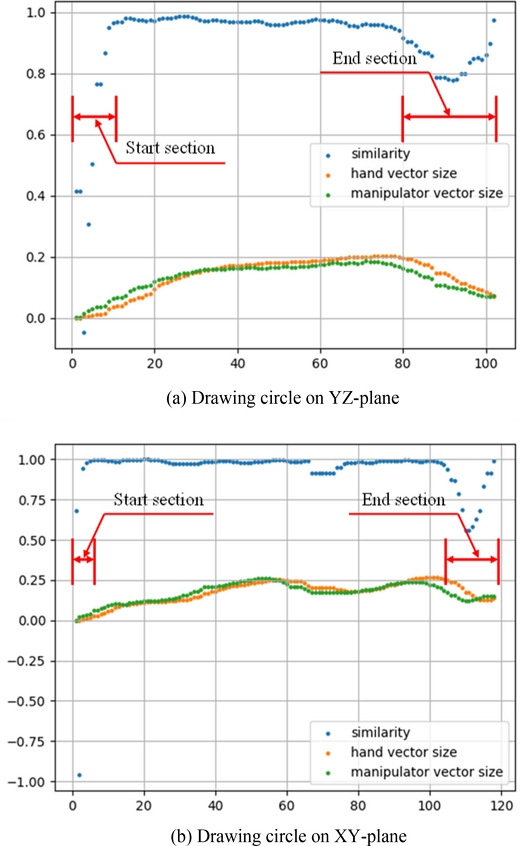

두 궤적의 유사성을 확인하기 위해 코사인 유사도(Cosine Similarity)를 활용한다. 코사인 유사도는 내적공간의 두 벡터 간 각도의 코사인 값을 이용하여 측정된 벡터 간의 유사한 정도를 의미한다. 식(5)을 통해 두 궤적의 시작점을 시점으로 하고 같은 시간에 측정된 두 궤적상의 점을 종점으로 하는 두 벡터의 코사인 유사도를 계산한다. 각 실험에 대한 코사인 유사도 결과는 Tabel 1과 Fig. 9와 같다.

| (5) |

코사인 유사도의 평균은 YZ 평면에 원을 그렸을 때가 0.904, XY 평면을 원을 그렸을 때 0.937로 두 궤적이 유사도가 높음을 알 수 있다. 이때 최솟값이 각각 -0.048, -0.961로, 코사인 유사도가 낮은 구간이 있음을 알 수 있다. 이는 Fig. 9의 두 그래프를 통해 두 벡터의 크기가 작은 원격 제어 시작 구간과 종료 구간에서 정지상태에서의 측정 오차로 인해 유사도가 떨어지는 것을 확인하였다. 또한 코사인 유사도의 표준 편차가 낮은 것을 통해 대부분의 코사인 유사도가 평균에 가까움을 알 수 있다. 따라서 작업자의 손 궤적을 Manipulator EEF가 올바르게 추종함을 알 수 있다.

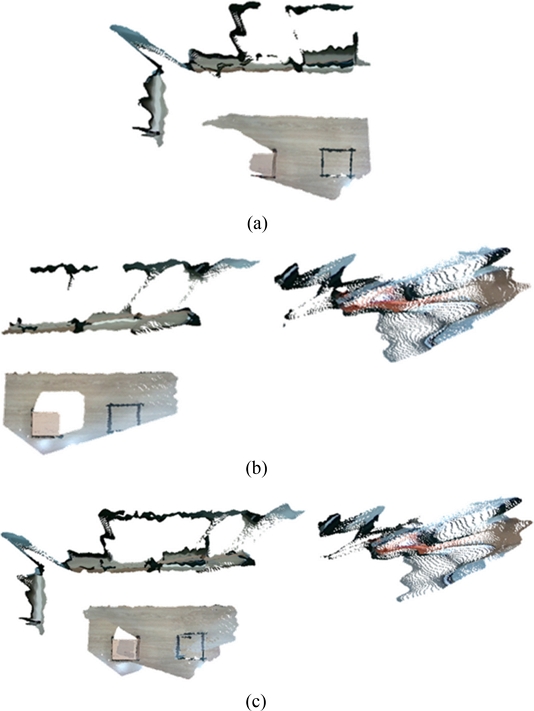

성인 남성 2명과 성인 여성 2명을 대상으로 Fig. 10과 같은 두 RGB-D 카메라로부터 획득한 서로 다른 시점의 2D RGB 이미지 또는 Fig. 4와 같은 3D Visual Map을 활용하여 하나의 Target Object에 대해서 Pick and Place를 수행하는데 걸리는 시간과 Picking에 실패한 횟수를 두 경우 각각 측정하였다. 그 결과는 Table 2와 같다.

측정 결과 모든 피실험자가 2D RGB 이미지를 활용하여 Pick and Place를 수행할 때보다 3D Visual Map을 활용하여 Pick and Place를 수행하였을 때 작업 시간이 평균 15.5초 짧은 것을 알 수 있다. 또한 3D Visual Map을 활용하여 Pick and Place를 수행한 경우 Picking에 실패한 경우가 없는 반면, 2D RGB 이미지를 활용하여 Pick and Place를 수행한 경우 Manipulator의 현재 자세를 알 수 없고 Target Object와 EEF 사이의 거리를 정확하게 가늠하지 못해 EEF와 Target Object가 충돌하는 경우가 발생하여 Pick and Place에 실패한 경우가 발생하였다. 이를 통해 Pick and Place를 수행할 때, 3D Visual Map을 활용하는 것이 2D RGB 이미지를 활용하는 것보다 작업의 정확성을 향상시키고 작업 시간이 단축됨을 확인할 수 있다.

5. 결론

본 논문에서는 원격 현장감을 향상시키기 위해서 RGB-D 카메라의 Point Cloud 정보와 3D CAD Model 등으로 구성된 3D Visual Map을 생성하였다. 생성된 3D Visual Map을 기반으로 Manipulator의 원격 제어를 수행하는 작업자를 위한 VR 인터페이스를 제안하고 이를 검증하기 위한 실험을 진행하였다.

제안한 VR 인터페이스를 활용한 원격 제어의 추종 정확성을 검증하기 위해 모션 캡처 카메라를 활용하여 작업자의 손 궤적과 Manipulator EEF의 궤적을 비교하는 실험을 진행하였다. 두 번의 실험 동안 EEF가 작업자의 손 궤적 사이의 코사인 유사도가 평균 0.9 이상임을 알 수 있었다. 이를 통해 Manipulator EEF가 작업자의 손 궤적을 정확하게 추종함을 알 수 있었다.

다음으로 작업자가 활용하기에 적합한가를 확인하기 위해 두 번의 같은 작업을 수행할 때 서로 다른 영상을 활용하는 실험을 진행하였다. 이를 통해 2D RGB 이미지를 활용하는 것보다 3D Visual Map을 활용하는 것이 작업 시간을 평균 15.5초 단축시키고 정확도를 향상시키는 것을 확인할 수 있었다.

위 실험들을 통해 본 논문에서 제안한 3D Visual Map 기반 원격 제어를 위한 VR 인터페이스가 원격 현장감을 가진다는 것을 확인하였다. 이를 통해 제안된 VR 인터페이스가 Pick and Place 등과 같은 원격 제어 작업을 수행할 때, 정확성을 향상시키고 수행시간을 단축시킬 수 있을 것이라 기대한다.

Acknowledgments

이 논문은 2024년도 정부(과학기술정보통신부)의 재원으로 정보통신기획평가원의 지원을 받아 수행된 지역지능화혁신인재양성사업(No. IITP-2024-RS-2022-00156360)과, 정부(과학기술정보통신부)의 재원으로 한국연구재단의 지원(No. 2024R1F1A1074704), 정부(산업통상자원부)의 재원으로 한국산업기술진흥원의 지원(No. P0017033, 2024년 산업혁신인재성장지원사업)을 받아 수행된 연구임.

REFERENCES

-

Noh, D., Choi, H., Jeon, H., Kim, T., Lee, D., (2024), Upper extremity motion-based telemanipulation with component-wise rescaling of spatial twist and parameter-invariant skeletal kinematics, Mathematics, 12(2), 358.

[https://doi.org/10.3390/math12020358]

-

Choi, H., Jeon, H., Noh, D., Kim, T., Lee, D., (2023), Hand-guiding gesture-based telemanipulation with the gesture mode classification and state estimation using wearable imu sensors, Mathematics, 11(16), 3514.

[https://doi.org/10.3390/math11163514]

-

Pan, Y., Chen, C., Li, D., Zhao, Z., Hong, J., (2021), Augmented reality-based robot teleoperation system using RGB-D imaging and attitude teaching device, Robotics and Computer-Integrated Manufacturing, 71, 102167.

[https://doi.org/10.1016/j.rcim.2021.102167]

- Kim, M. U., Choi, J., Yoon, Y., Park, J., (2023), VR-based remote robotic control for reusable launch vehicle refueling, Proceedings of the Symposium of the Korean Institute of communications and Information Sciences, 582-583.

-

Stotko, P., Krumpen, S., Schwarz, M., Lenz, C., Behnke, S., Klein, R., Weinmann, M., (2019), A VR system for immersive teleoperation and live exploration with a mobile robot, Proceedings of the 2019 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), 3630-3637.

[https://doi.org/10.1109/IROS40897.2019.8968598]

-

Kim, M., Kim, H.-S., Kim, H.-J., Hwang, C.-H., (2023), Visual information transmission methods for virtual/augmented-reality–based telepresence, Journal of Digital Contents Society, 24(10), 2509-2517.

[https://doi.org/10.9728/dcs.2023.10.24.10.2509]

-

Jo, H.-H., Ishangulyyev, G., Kim, J.-Y., (2023), Development and motion control of a lightweight robot arm for teleoperation using VR headset, Proceedings of the Transactions of the Korean Society of Mechanical Engineers-A, 47(12), 927-935.

[https://doi.org/10.3795/KSME-A.2023.47.12.927]

-

Su, Y., Chen, X., Zhou, T., Pretty, C., Chase, G., (2022), Mixed reality-integrated 3D/2D vision mapping for intuitive teleoperation of mobile manipulator, Robotics and Computer-Integrated Manufacturing, 77, 102332.

[https://doi.org/10.1016/j.rcim.2022.102332]

B.Sc. candidate in the School of Mechanical Engineering, Soongsil University. His research interest is robot engineering.

E-mail: wogns1218@gmail.com

M.Sc. candidate in the Department of Intelligent Robotics, Sungkyunkwan University. His research interest is robot engineering.

E-mail: jinkanglee@g.skku.edu

B.Sc. candidate in the School of Mechanical Engineering, Soongsil University. Her research interest is robot engineering.

E-mail: gdan7140@gmail.com

Ph.D. candidate in the School of Mechanical Engineering, Soongsil University. His research interest is robot engineering.

E-mail: choihg@soongsil.ac.kr

Professor in the School of Mechanical Engineering, Soongsil University. His research interest is robot engineering.

E-mail: dhlee04@ssu.ac.kr