궤도형 로봇의 계단 주행 조건 분석을 통한 객체 인식 알고리즘 기반 계단 자율 주행 시스템 개발

Copyright © The Korean Society for Precision Engineering

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License (http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

Abstract

In this paper, we propose an autonomous stair-driving system for the stable traversal of stairs by a tracked mobile robot operating in indoor disaster environments. Before developing the system, we conduct dynamic simulations to analyze the requirements for the robot to climb stairs. Simulations are performed under various initial conditions, and based on a detailed analysis of the results, we derive the necessary conditions for the robot's ascent. Using these requirements, we design the autonomous stair-driving system, which includes three main components: stair approach, stair alignment, and stair traversal. First, during the approach stage, we present a strategy for recognizing stairs using an object detection algorithm and generating control inputs for the stair approach motion. Next, in the alignment process, we outline an image processing sequence that extracts the edge contour of the stairs and a method for generating control inputs from the combined contour. Finally, in the traversal sequence, we describe the strategy for driving up the stairs. Additionally, we introduce an integrated ROS system to ensure the sequential execution of each strategy. We also verify the effectiveness of the individual strategies and demonstrate the capability of the proposed system through experiments using mock-up stairs and tracked robots.

Keywords:

Tracked mobile robot, Stair driving requirements analysis, Stair approach, Stair alignment, Stair Traversal, Autonomous system키워드:

궤도형 이동 로봇, 계단 주행 요구사항 분석, 계단 접근, 계단 정렬, 계단 극복, 자율 시스템1. 서론

현재 세계 각지에서는 다양한 형태의 테러·범죄·전쟁 등의 재난 상황이 끊임없이 발생하고 있다. 이러한 현장에서 적절한 대응을 하기 위해서는 건물 내부의 위험 요인들을 파악하고, 생존자를 식별하는 등의 내부 상황을 명확하게 인식하는 것이 무엇보다 우선시된다. 현재 이를 위해 인적 자원이 투입되고 있지만, 내부의 위험 요소가 파악되지 않은 상태에서 인력을 투입하는 것은 2차적인 피해를 야기한다[1]. 이에 다양한 형태의 원격 이동 로봇을 활용하고자 하는 노력이 지속되어 왔고, 일반적으로 궤도형 로봇의 형태가 재난 상황에 가장 적합하다[2-7]. 이러한 궤도형 로봇을 운용하여 건물 내부를 탐색할 때, 로봇은 최대한 넓은 영역을 탐색할 수 있어야 한다. 일반적인 건물은 계단으로 층계가 연결되어 로봇의 탐색 영역이 확장되기 위해서는 계단을 통과해야 한다. 그러나, 실내·외 환경에서 운용되는 궤도형 로봇에 대해 계단은 극복하기 가장 어려운 장애물 중 하나이고, 이러한 계단을 극복하지 못하는 경우 로봇의 조사 대상 지역이 크게 제한된다.

로봇의 운용 환경에 존재하는 계단을 극복하는 것은 카메라 정보와 같은 제한적인 데이터로 주변 환경을 인식하는 조종자에게 숙련된 조종 기술이 요구된다. 다시 말해, 이는 상당한 경험이 요구되는 어려운 작업으로 계단 주행 성공 여부는 조종자의 숙련도에 좌우된다. 더구나 로봇 조작 미숙은 로봇의 파손으로 이어질 수 있으며 조종자를 훈련시키는 것 또한 금전적·시간적으로 바람직하지 않다[8,9]. 이 밖에도, 로봇 제어 및 센서 데이터 파악을 동시에 수행해야 하는 작업자의 업무 부하가 가중 될 수 있다[10,11]. 즉, 이동 로봇이 계단을 주행함에 있어 사람의 실수로 인한 로봇의 파손을 방지하는 것과 동시에 조종자가 조종 외의 다른 임무에 집중할 수 있도록 하는 조치가 필요하다.

이러한 문제점을 해결하기 위해 기존에 많은 연구들이 수행 되었다. 특히 [12-14]에서는 ToF (Time of Flight) 방식의 센서를 사용하여 계단을 인식하거나 주행하기 위한 방법들이 제안 되었다. 그러나, IR (Infra-Red) ToF 방식의 센서는 외부 광원, 특히 강한 일광에 의해 센서의 정확도가 영향을 받을 수 있다. 그리고 ToF 센서는 물체의 재질과 색상에 따라 반사율이 달라지는 경향을 보이며, 어두운 색상이나 광택이 있는 표면 등에 대해서는 정확한 거리 측정이 어렵다. 그렇기 때문에 해당 센서를 주된 인식 장치로 사용하는 것은 통제해야 할 요인이 많아 다양한 환경에 적용하기 어려울 수 있다. 또한, 이러한 연구에서 제안되는 접근법들은 전체적인 계단 주행을 위한 전략을 제시하지 않으며, 챌판이 없거나 폭을 모르는 계단과 같이 모든 계단에 적용할 수 없는 한계점을 가진다.

[15-17]의 연구에서는 RGB (Red, Green, Blue) 카메라를 사용하는 방법을 제안하였다. [15]에서는 환경적 영향을 억제하기 위한 Gabor 필터와 영상처리를 통한 계단 윤곽선 추출 및 윤곽선의 중점을 연결하여 로봇이 추종해야 하는 경로를 생성하는 방법을 제안하였다. 하지만, 제안된 영상처리 방법은 조도의 영향을 적응적으로 대응하지 못하며, 외부 광원의 영향으로 영상데이터의 특정 영역이 포화되는 경우에 부적절한 경로 생성으로 로봇이 파손될 위험성이 존재한다. [16]에서는 원거리 접근, 근거리 접근, 계단 정렬, 계단 극복으로 구성되는 하강 계단 주행 방법을 제안한다. 이때, 원거리 접근에서 사용하는 질감 에너지 측정 기반의 방법은 빛의 각도, 표면 상태, 거리 등에 따라 계단을 오검출할 가능성이 크며, 근거리 접근에서 사용하는 광학흐름 기법은 많은 시간이 소요된다. 이는 신속한 탐색 및 조사가 요구되는 재난 현장에 적합하지 않다.

[18-22]에서는 RGB-D (Red, Green, Blue-Depth) 센서를 사용하여 계단을 주행하기 위한 방법들을 제안하였다. [18]에서는 전역적인 공간에서 계단의 탐색을 수행하기 위해 벽 추종(Wall-following) 기법을 제안한다. 그러나, 해당 방법은 갑작스럽게 벽이 사라지거나, 하행 계단이 등장하는 경우에는 로봇에 상당한 위험이 될 수 있다. [18,19], [21,22]의 연구에서는 계단에 대한 정렬을 수행하기 위해 계단의 챌판에 반사되는 깊이 값을 사용하는 방법을 제안하지만, 이는 산업용 계단과 같이 챌판이 없는 계단에 대해서는 적용할 수 없어 범용성이 떨어진다. 추가적으로, ToF 방식의 깊이 측정 방식을 가지는 RGB-D 카메라는 물체의 가장자리에서 빛의 회절로 인한 구멍 현상(Hole Phenomenon)으로 깊이 측정값에 대한 신뢰성을 기대하기 어렵다[23-25]. 특히, 계단처럼 급격한 곡률이 많은 구조에 대해서는 RGB-D 센서의 불확실성이 증대한다. 이에 따라, 계단의 모서리에 해당하는 깊이 값을 사용하여 계단을 인식하는 것은 불확실성에 의존하는 문제점을 안게 된다. [22]에서는 이러한 구멍 현상을 방지하기 위해 중앙값 필터의 사용을 제안한다. 중앙값 필터는 잡음을 제거하며 데이터의 정보를 완만화하는데 효과적이며, 특히 소금-후추 잡음(Salt-and-Pepper Noise)라 하는 무작위 및 급격한 값의 변화에 강인함을 보인다[26]. 하지만, 중앙값 필터는 필터 자체의 특성으로 유용한 정보가 손실될 수 있다. 또한, 필터 내에서 값이 유사한 특성을 가지는 경우에는 잘 작동 하지만, 특정한 영역에 해당하는 값이 균일하지 못하고 크게 다른 영역에서는 오작동할 위험성이 존재한다[27]. 이러한 문제점으로 RGB-D 카메라의 깊이 값을 기반으로 특정한 동작을 생성하는 것은 많은 어려움이 존재한다.

[28,29]에서는 다중 센서를 사용한 계단 주행 방법을 제안한다. [28]에서는 가속도계, 소나(Sonar), 카메라를 이용하는 전략을 제시하였다. 해당 논문의 저자는 각 센서의 취약점을 기술하고, 이를 회피하여 안정적인 계단 주행을 위해 각 센서의 신뢰도를 평가하여 하나의 센서 데이터를 선택하는 방법을 제안한다. [29]에서는 자이로 센서, 기울기 센서와 2개의 카메라 및 레이더를 사용하고, 각 센서의 정보들을 통합하는 방법을 제안하였다. 해당 연구에서 제안된 방법들은 ToF 방식을 사용하는 센서에 의존성이 높다. 이에 따라, 벽이 없거나 챌판이 없는 계단에는 적용할 수 없으며, 조종자의 개입 없이는 전체적인 계단 주행에 필요한 모든 과정을 자율적으로 수행하기 힘들다.

[10,30] 에서는 딥러닝 기반의 객체 분할 및 객체 인식 기법을 적용한 방법을 제안한다. 특히 [10]의 연구에서는 객체 분할 알고리즘과 모방 학습 기반의 행동 복제를 통한 계단 정렬 방법을 제안한다. 하지만, 모방 제어를 통한 계단 정렬 방법은 정밀한 제어를 수행하기 위한 기준 신호를 생성하지 못한다. 또한, 객체 분할 알고리즘은 특정한 영역을 정밀하게 구분할 수 있지만, 이를 통해 처리된 영역에 대해 각도 추정 및 모서리 추출 등의 영상처리를 수행하기 어려운 단점을 가진다. [30]에서는 객체 인식 알고리즘을 통해 계단을 인식하기 위해 총 848장의 사진이 사용되었지만, 이는 다양한 색상·형태·조도 환경의 계단을 안정적으로 인식하기에는 부족하다. 또한, 제안된 방법은 조도의 영향을 적응적으로 처리할 수 없으며, 로봇이 계단에 대해 적절한 위치에 배치된 상황을 가정한다.

따라서 계단 주행의 완전 자율화, 시스템의 범용성, 특정 센서의 사용 등으로 인한 한계점을 종합적으로 해결하고 궤도형 로봇이 안정적으로 계단을 주행하기 위한 방안이 요구된다. 이에 본 논문에서는 궤도형 로봇의 안정적인 계단 주행을 위한 방법에 대한 연구를 제안한다. 본 연구에서는 제시하는 기여는 다음과 같다.

- ● 동역학 해석 프로그램인 RecurDyn을 사용하여 기존 연구에서 제시되지 않은 계단 주행 요구사항을 명시적으로 도출하고, 요구사항을 기반으로 계단 접근, 계단 정렬, 계단 극복으로 구성되는 계단 자율 주행 시스템을 제시한다.

- ● 실내외 계단, 산업용 계단 등 다양한 형태·재질·색상의 계단을 포함하는 14,351장의 데이터 세트를 구축하고, 객체 인식 알고리즘을 학습하여 계단을 인식한다. 이러한 방법을 통해 제안하는 시스템은 다양한 형태의 계단에 적용할 수 있으며, 기존의 방법들보다 보편적인 시스템을 구성할 수 있다.

- ● 제안하는 계단 접근, 계단 정렬, 계단 극복 단계별 알고리즘은 다음과 같이 구현한다. 접근 동작을 수행하기 위해 계단 인식 정보를 기반으로 기준 신호를 생성하여 제어기를 설계한다. 정렬 동작은 계단 인식 정보와 강인한 영상 처리기법을 통하여 기준 신호 및 제어 입력을 생성한다. 극복 과정에서는 안정적인 계단 주행을 위해 로봇의 Yaw 각도를 유지하기 위한 제어기를 설계하며, 각 과정에 대한 전략을 통합하여 전체 계단 자율 주행 시스템을 개발한다.

- ● 궤도형 로봇에 계단 자율 주행 시스템을 탑재하여, 각 과정에 대한 실험을 통해 제안하는 전략에 대한 유효성을 입증한다.

본 논문은 다음과 같이 구성된다. 2장에서는 궤도형 로봇이 계단을 주행함에 필요한 사항들을 도출하기 위한 동역학 시뮬레이션을 진행하고, 시뮬레이션 결과에 대한 상세한 분석을 기반으로 요구사항을 제시한다. 3장에서는 도출된 사항들을 기반으로 계단 자율 주행 시스템을 설계하고, 시스템의 세부적인 내용을 설명한다. 4장에서는 실험을 통해 제안하는 시스템을 검증하고, 마지막 5장에서 본 논문의 결론과 향후 계획을 서술한다.

2. 계단 주행 요구사항 도출

본 장에서는 궤도형 이동 로봇이 계단을 주행함에 있어 필요한 사항들을 파악하기 위한 동역학 시뮬레이션을 진행한다. 또한, 시뮬레이션 결과를 분석하고 이를 기반으로 하여 계단 주행 요구사항을 도출한다.

2.1 계단 주행 시뮬레이션

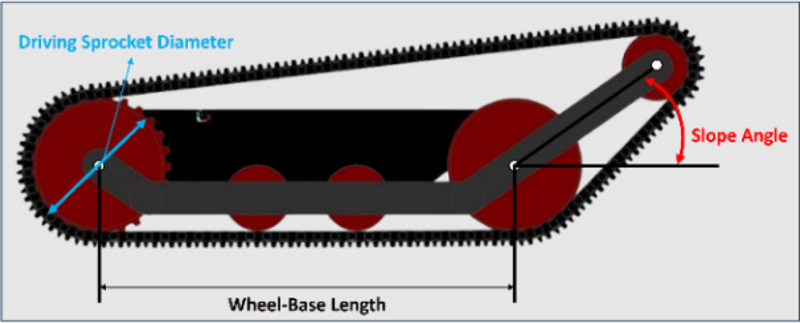

먼저, 궤도형 로봇이 계단을 주행하기 위해 요구되는 사항들을 파악하기 위한 동역학 시뮬레이션을 진행한다. 시뮬레이션은 상용 동역학 해석 프로그램인 RecurDyn을 사용하여 진행하고, 시뮬레이션에 사용된 궤도형 로봇의 형태는 Fig. 1과 같다.

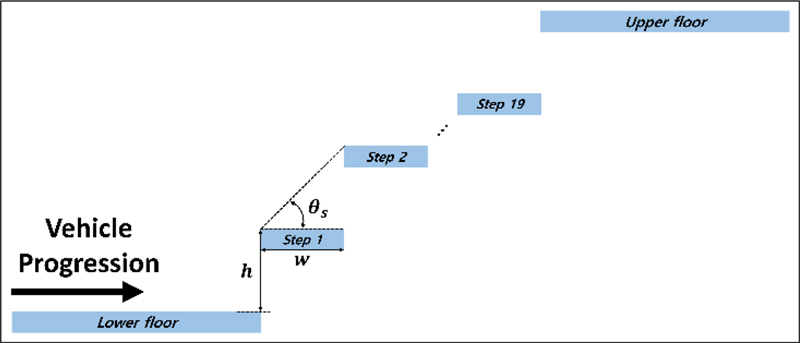

Fig. 1과 같이 설계되는 궤도형 로봇의 설계 사양은 Table 1과 같다. 또한, 시뮬레이션에 사용되는 계단의 형상은 Fig. 2와 같으며, 해당 계단의 치수는 Table 2와 같이 일반적으로 실제 환경에서 볼 수 있는 계단의 형상과 유사하게 적용한다.

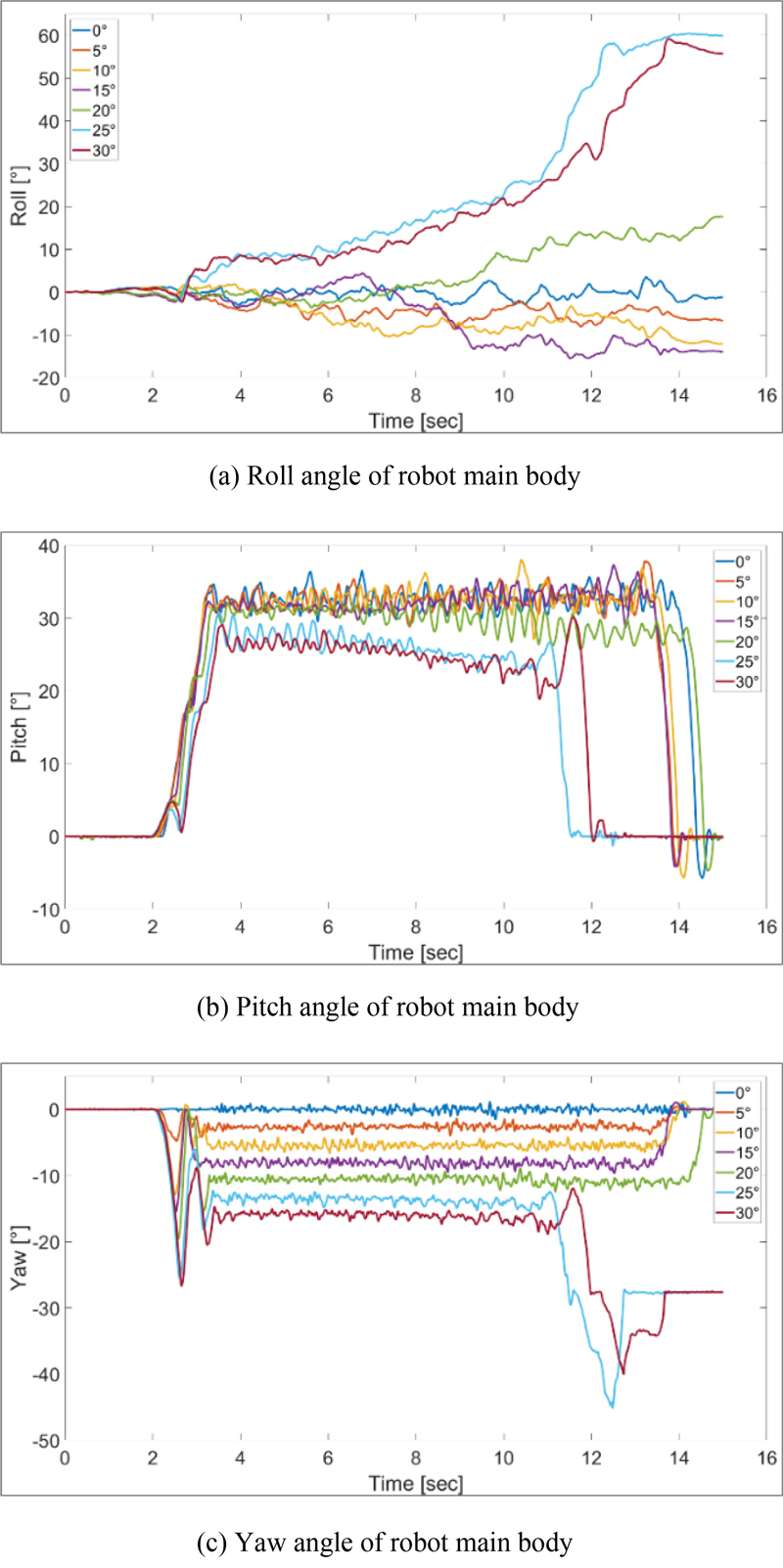

시뮬레이션은 계단을 주행할 때, 진입 각도의 영향을 분석하고 안정적인 계단 주행을 위한 제약 사항을 파악하기 위해 진행한다. 이를 위해 계단에 대해 로봇의 각도를 0부터 30°까지 5°간격으로 회전하며 직진 주행을 수행하고, 주행은 Driving Sprocket에 66 RPM (Revolution Per Minute)의 입력을 인가한다. 이때 로봇의 선속도는 약 0.7 m/s이고, 계단을 완전히 주행하기 위해 총 15초간 시뮬레이션을 진행한다. Fig. 3는 시뮬레이션 결과로 Figs. 3(a), 3(b), 그리고 3(c)는 각각 로봇 본체의 Roll, Pitch, Yaw 각도 변화를 나타낸다.

Fig. 3에서 계단에 대한 로봇의 진입 각도에 따라 계단 주행의 결과가 극명하게 달라지는 경향을 보인다.

2.2 요구사항 도출

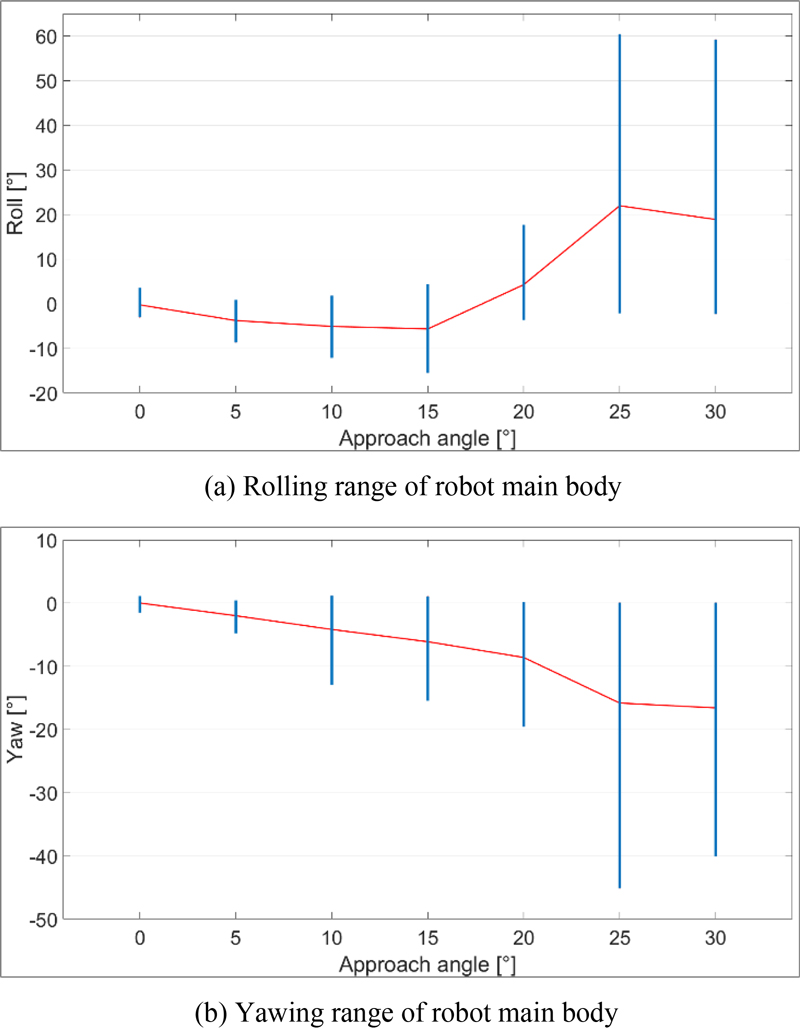

본 절에서는 앞선 시뮬레이션 결과에 대한 상세한 분석을 기반으로 계단 주행 요구사항을 도출한다. 먼저, Fig. 3에서 제시되는 결과와 같이 계단에 대한 로봇의 진입 각도가 증가함에 따라 주행 특성이 불안정해지는 것을 확인할 수 있다. 특히, 진입 각도가 25와 30°에 해당하는 결과에서 모든 값이 11초 부근에서 크게 변화함을 보이며, 로봇이 계단에서 추락하여 주행에 실패한다. 이는 로봇의 Yaw 및 Roll 각도가 특정한 범위를 초과하면 계단 주행에 실패함을 시사하고, 아래의 Figs. 4(a)와 4(b)는 계단 주행 중 Rolling과 Yawing의 경향성을 보다 명확하게 나타낸다.

Fig. 4와 같이 계단에 대한 진입 각도가 증가함에 따라 Roll 및 Yaw 각도의 평균값 및 범위가 비선형적으로 증가함을 보인다. 진입 각도가 25°를 초과하는 경우에는 그 범위가 급격하게 증가함을 보이고, 이는 로봇이 조향 능력을 잃어 제어 불능 상태에 빠짐을 의미한다. 이러한 분석을 기반으로 계단에 대한 로봇의 초기 진입 각도가 주행 성능에 상당한 영향을 미치고, 계단 주행의 성공 여부에 크게 기여함을 알 수 있다. 이는 계단에 진입하기 전, 로봇의 진입 각도가 보정되어야 함을 의미한다.

다음으로, 실질적인 계단 주행 과정에서 진입 각도가 0°에 가깝게 보정된다고 하더라도 안정적인 주행을 수행할 수 있는 것은 아니다.

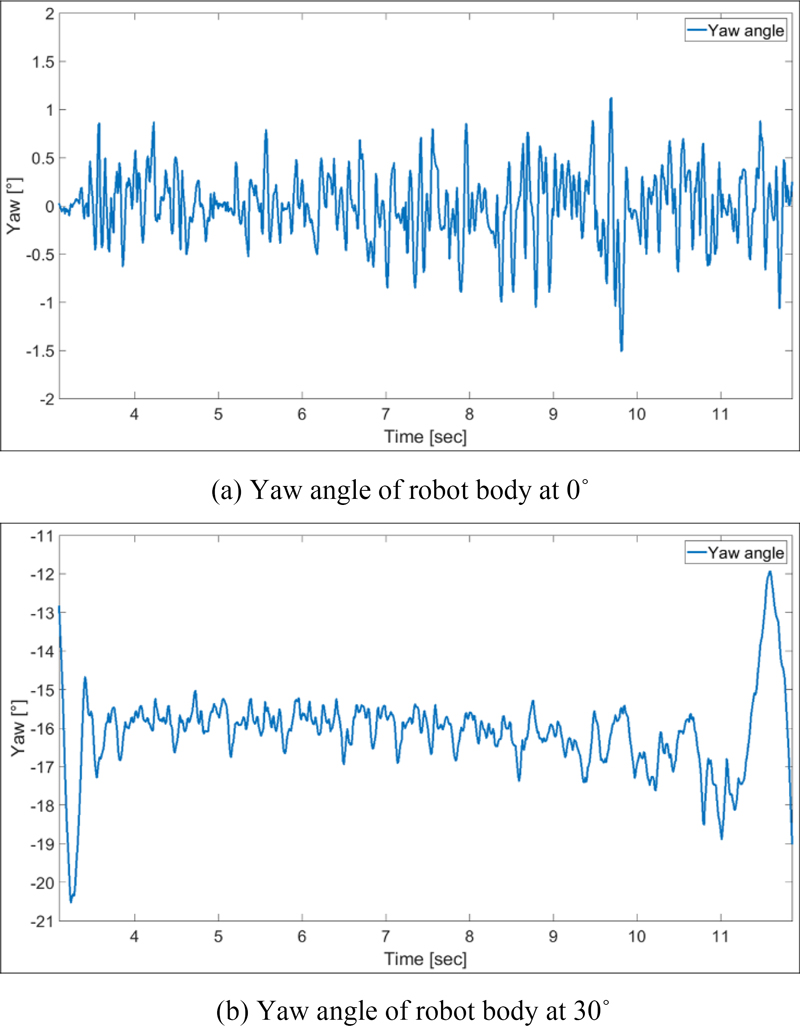

Figs. 5(a)와 5(b)는 각각 0°와 30°에서 진행한 시뮬레이션에서 로봇의 Yaw 각도를 표현한 그림으로, Fig. 5(a)는 진입 각도가 0°인 상황이지만, 계단을 주행을 수행하는 약 3초부터 약 14.5초까지 로봇의 방향각이 유의미하게 진동하는 것을 확인할 수 있다. 이때, 계단 주행 과정으로 판단되는 해당 시간 범위 내에서 방향각은 최대 1.11685에서 최소 –1.50973°까지 2.62658°의 범위에서 흔들린다.

Fig. 5(b)는 진입 각도가 30°인 상황으로 초기에 계단에 진입하는 과정에서 방향각에 큰 폭의 변화가 발생함을 보인다. 또한, 계단에 진입한 것으로 판단되는 4초부터는 0°에 나타난 경향과 유사하게 특정한 범위 내에서 방향각이 존재하는 것을 확인할 수 있다. 하지만, 계단에서 전복을 시작하는 시점으로 판단되는 11초부터는 경향성을 벗어나 크게 변화하는 것을 볼 수 있다. 이를 시작하는 시점에서 방향각은 -18.8859°이고, 계단을 주행중에 해당 값과 가장 차이가 큰 값은 –15.0328°이다. 이는 계단 주행 중에 방향각이 3.8531°의 범위에서 흔들리는 것을 의미하고, 이러한 범위를 벗어나는 경우 궤도형 로봇이 전복하여 계단 주행에 실패할 가능성이 증대한다.

즉, 방향각이 2.62658°의 범위내에 존재하는 경우에는 전복이 발생하지 않고, 3.8531°의 범위에서 벗어나는 경우에는 전복이 발생하는 것을 의미한다. 이러한 분석을 통해 궤도형 로봇이 계단을 안정적으로 주행하고, 계단 주행에 성공하기 위해서는 방향각의 제어가 요구된다. 즉, 궤도형 로봇의 안정적인 계단 주행을 위해 가장 필수적인 요구사항은 로봇의 방향각을 일정하게 제어하여 2.62658°의 범위내에 유지되어야 함을 의미한다.

마지막으로, 이처럼 도출된 3개의 요구사항을 정리하면 다음과 같다.

- 1) 계단 주행 전, 안정적인 계단 주행을 목적으로 계단에 대한 궤도형 로봇의 진입 각도를 0°에 가깝게 보정한다.

- 2) 계단 주행 중, 계단 극복 성공을 목적으로 궤도형 로봇의 Yaw 각도를 일정하게 유지한다.

- 3) 계단 극복 과정에서 작업자의 업무 부하 감소를 목적으로 전체적인 계단 주행 업무 자율화한다.

다음 장에서는 위와 같이 도출된 요구사항을 기반으로 계단 자율 주행 시스템을 개발한다.

3. 계단 자율 주행 시스템

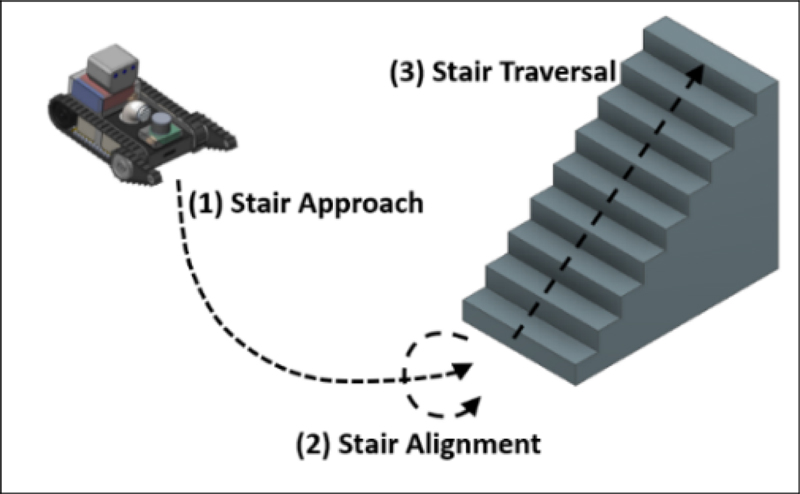

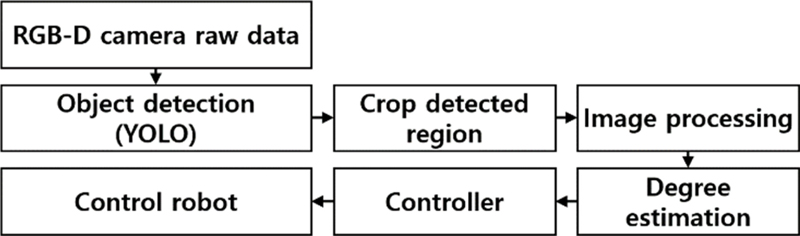

본 장에서는 앞서 도출한 요구사항들을 기반으로 계단 자율주행 시스템을 설계하고, 구현하기 위한 전략들을 제시한다. 먼저, 해당 연구에서는 앞서 제시한 요구사항들을 모두 충족하며 계단을 극복하기 위해 Fig. 6과 같은 시스템을 제안한다.

Fig. 6은 본 연구에서 제안하는 계단 자율 주행 시스템의 개략도를 나타낸다. 그림과 같이 제안하는 시스템은 (1) Stair Approach, (2) Stair Alignment, (3) Stair Traversal 단계로 구성된다. 해당 장에서는 각 과정에 대한 독립적인 전략을 제시하고, 이를 통합하여 전체적인 계단 자율 주행 시스템을 개발한다.

3.1 계단 접근 알고리즘

해당 절에서는 (1) Stair Approach를 수행하기 위해 고려되는 사항들과 계단 접근 동작을 구현하기 위한 전략을 제시한다. 먼저, 앞선 도출된 요구사항 3)을 충족하기 위하여 궤도형 로봇은 자율적으로 계단을 인식하고, 인식된 계단에 접근해야 한다. 이에 본 연구에서는 RGB-D 센서를 사용한 계단 접근 전략을 제안한다.

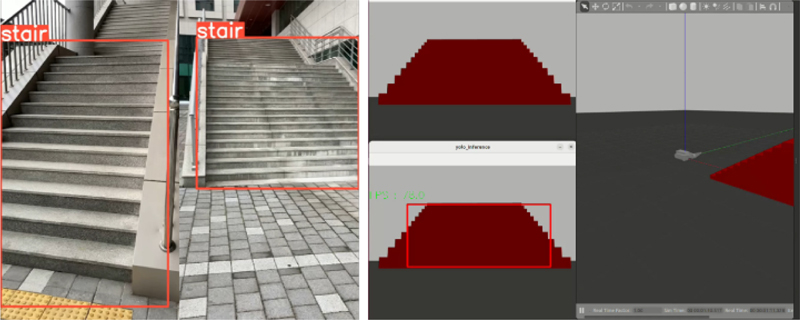

우선, 계단에 접근하는 동작을 수행하기 위해서 극복하고자 하는 계단을 인식하는 과정이 요구된다. 기존 객체 인식을 위한 다양한 방법들이 제안되었고 [31], 본 연구에서는 인식 성능과 연산 속도를 고려하여 YOLO (You Look Only Once) v5 모델을 사용한다[32]. 해당 모델을 통한 계단 인식을 위해 학습을 진행하고, 학습에 사용되는 데이터 세트는 총 14,351개의 계단 사진으로 구성되며, 계단 사진에는 실내외 계단, 산업용 계단 등 다양한 형태·재질·색상의 계단이 포함된다. 이때, 학습 데이터에 대한 과적합을 방지하고, 안정적인 학습을 수행하기 위해 전체 데이터 세트를 8:2의 비율로 학습 데이터와 검증 데이터로 구분한다. 학습을 진행한 결과, mAP0.5 (Mean Average Precision)가 0.962를 달성함을 확인하였다. 또한, Fig. 7과 같이 학습된 가중치를 적용하는 경우 크기, 모양, 색상과 같은 계단의 물리적인 속성과 무관하게 계단을 안정적으로 인식할 수 있음을 보인다.

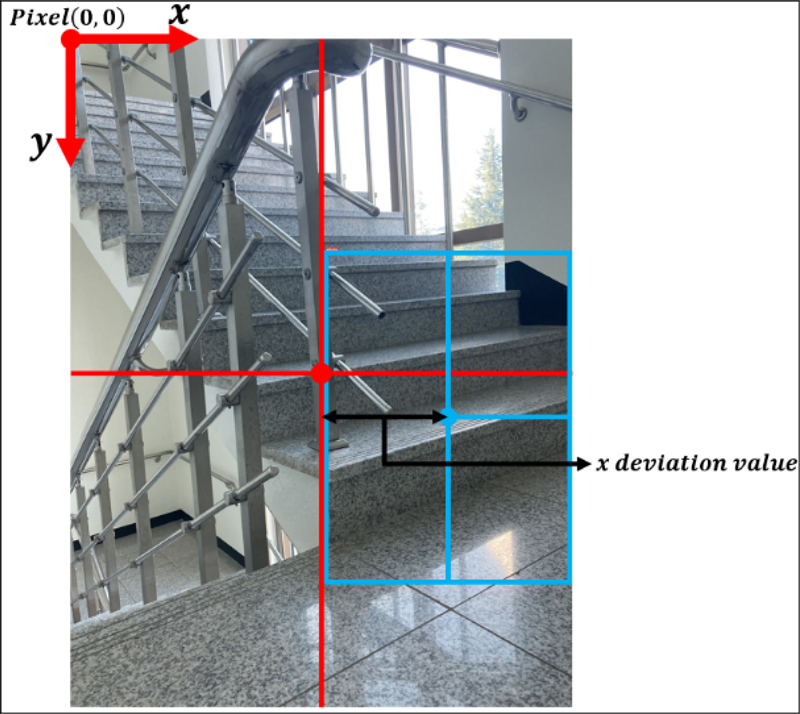

다음으로, 인식된 계단에 대한 접근을 수행하기 위해 인식된 계단 영역을 사용하여 오차 신호를 생성하고, 이를 기반으로 하여 계단 접근을 위한 제어 입력을 생성한다. 이를 위해 Fig. 8과 같이 픽셀 좌표계를 정의한다.

Fig. 8과 같이 RGB 영역에서 좌측 상단의 점을 좌표계의 원점 pixel(0, 0)으로 설정하고, 카메라 영역의 중심점을 camc = pixel(xc, yc), 인식 영역의 중심점을 dets = pixel(xs, ys)으로 정의한다. 여기서 xc, yc, xs, ys는 각 중심점의 픽셀 좌표를 의미한다. 여기서 xc를 기준 신호, xs를 현재 상태로 사용하여 식(1)과 같이 오차 신호를 정의한다.

| (1) |

식(2)에서 xdev는 Fig. 8에서 ‘x Deviation Value’로 표현되는 값을 의미하고, 이를 오차 신호로 사용하여 계단에 접근하기 위한 제어 입력을 생성한다. 이때, 미끄럼 조향을 하는 궤도형 로봇의 경우 좌·우 바퀴의 속도 차를 기반으로 주행 방향을 조절한다. 즉, 궤도형 로봇이 계단에 접근하기 위해서는 전진 동작과 회전 동작에 대한 입력을 구분할 수 있고, 좌·우 바퀴에 인가되는 제어 입력을 식(2) 및 식(3)과 같이 표현할 수 있다.

| (2) |

| (3) |

식(2)와 식(3)에서 ωthrottle는 계단에 접근하기 위한 전진 주행을 구현하는 항이고, ωsteer는 계단 방향으로 조향 방향을 결정하는 항을 의미한다. 여기서 ωthrottle는 고정된 값을 사용하고, ωsteer는 아래와 같이 계산된다.

| (4) |

| (5) |

식(4)에서 kapproach는 계단 접근 과정에서 방향각을 제어하기 위해 사용되는 제어 이득을 의미하고, 해당 제어 이득은 식(5)을 통해 정의된다. 해당 식에서 a1, a2, a3는 사용자가 결정하는 설계 매개변수를 의미하며, 각 변수의 역할은 Table 3과 같다[33].

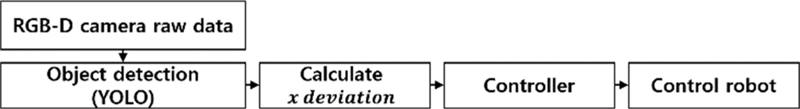

이와 같은 방법으로 제어 입력을 생성하여 계단의 중심선에 근접하게 조향 각도를 설정할 수 있으며, 계단에 대한 접근을 수행할 수 있다. 추가적으로, 계단 접근 과정을 종료하고 계단 정렬 과정으로의 전환을 위해 RGB-D 카메라의 깊이 정보를 사용한다. 즉, 인식 영역 내부에 존재하는 최소 깊이 값 depth(min(dets))과 xdev의 값이 사전에 설정한 임계값보다 작으면 해당 과정을 종료한다. Fig. 9는 제안하는 계단 접근 전략을 개략적으로 나타낸다.

3.2 계단 정렬 알고리즘

해당 절에서는 요구사항 1)을 충족하는 것을 목적으로 Fig. 7의 (2) Stair Alignment 과정의 전략을 제시한다. 해당 계단 정렬 과정에서는 계단을 바라보는 방향에 따라 계단 모서리 윤곽선의 각도가 다르게 보임을 사용한다. 그러나, 카메라 센서로부터 얻는 정보에는 사용하지 않는 불필요한 정보가 포함되는 것이 일반적이다. 이는 영상처리에 악영향을 줄 수 있어 제거하는 것이 이상적이다. 이를 위해 앞서 제시한 객체 인식을 수행하여 인식 영역만을 추출하고, 이를 통해 계단 손잡이, 창문, 기타 불필요한 정보들을 배제시킬 수 있다.

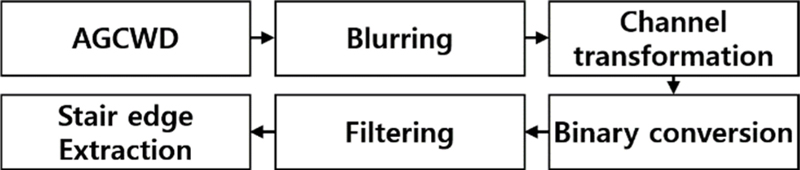

다음으로 추출된 영역에 대해서 영상처리를 수행함으로 계단 외 요소로부터 발생하는 잡음을 억제한다. 앞선 과정을 통해 계단을 제외한 요소들을 대부분 제거할 수 있지만, 일부 포함되는 요소들과 조도와 같은 환경적 영향이 계단 모서리 추출에 영향을 줄 수 있다. 또한, 계단의 재질이나 색상과 같은 물리적인 속성이 영상처리에 지대한 영향을 미치기 때문에 강인한 영상처리 기법이 요구된다. 본 연구에서는 이러한 영향에 대응하기 위해 Fig. 10의 순서를 따르는 영상처리 기법을 적용한다.

일반적으로 영상처리를 진행함에 가장 큰 영향을 주는 요인은 주변 환경의 조도이고, 이러한 영향을 억제하기 위해 감마 보정 작업이 요구된다. 그러나, 로봇이 운용되는 환경의 조도 상태는 미리 알 수 없어 일정한 감마 보정을 적용하는 것은 시스템의 강인성에 문제를 야기한다. 즉, 이는 주변 환경의 조도에 맞추어 적응적인 처리가 요구됨을 의미한다. Fig. 10에서 표현된 AGCWD(Adaptive Gamma Correction with Weighting Distribution)을 통해 적응적으로 주변 조도의 영향을 억제한다[34]. 또한, 계단은 다양한 재질로 구성될 수 있고, 재질의 종류에 따라 안정적으로 모서리 윤곽선을 추출하는 데 영향을 줄 수 있다. 이는 블러링(Blurring) 작업을 통해 억제할 수 있고, 이러한 작업은 특히 대리석과 같이 무늬가 존재하는 계단에 효과적으로 작용한다. 이후 단일 채널 변환과 이진 변환을 수행하고, 실질적인 계단 모서리의 윤곽선을 추출하기 위한 필터링(Filtering)을 수행한다. 필터링 작업은 일반적인 직선 추출을 위해 많이 사용되는 Canny 필터와 Hough 변환으로 구성한다[35,36].

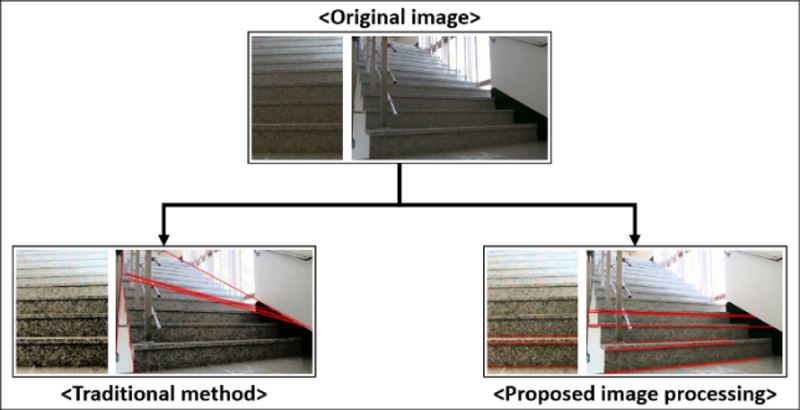

Fig. 11은 제안하는 일련의 영상 처리 방법을 통한 계단 모서리 추출의 결과를 나타낸다. 해당 결과와 같이 제안하는 영상처리 과정을 통해 안정적으로 계단 모서리 윤곽선을 추출할 수 있음을 보인다. 이때, 추출되는 윤곽선을 아래에서부터 Li(i – 1, 2,..., n)로 정의한다.

다음으로, 추출된 윤곽선으로부터 제어 신호를 생성하기 위한 각도 추정을 진행한다. 이는 추출된 윤곽선을 Li의 양 끝점을 Pi,1 = (xi, 1, yi, 1)과 Pi,2 = (xi, 2, yi, 2)로 정의하여 아래의 식(7)을 통해 수행될 수 있다.

| (6) |

또한, Fig. 11과 같이 추출되는 다수의 윤곽선에서 계단의 하단부에 존재하는 윤곽선은 명확한 기울기를 가진다. 하지만, 상단부에 존재하는 윤곽선은 로봇의 자세와 무관하게 0°에 가까워진다. 즉, 화각의 하단부에 위치하는 윤곽선은 뚜렷한 경향성을 보이지만, 상단부에 위치하는 윤곽선을 그렇지 못하다. 이러한 사항을 고려하여 윤곽선 각도에 식(7)과 표현되는 지수가중이동평균을 적용하여 결합한다[37].

| (7) |

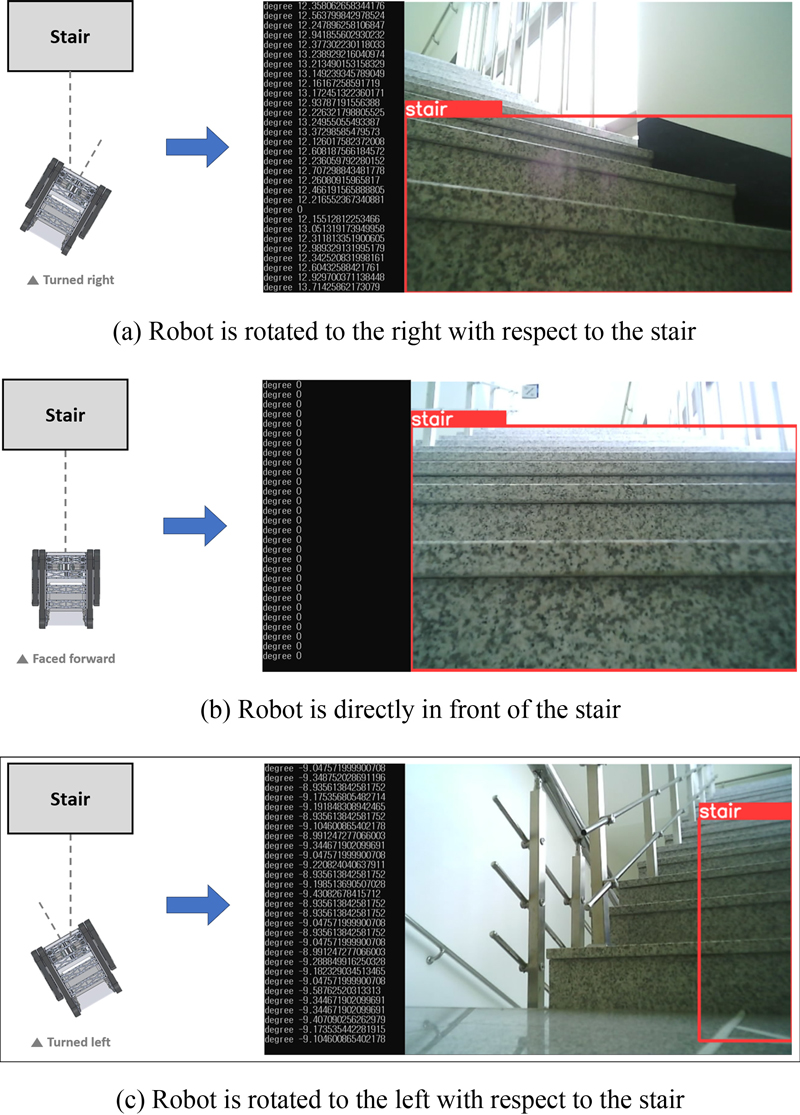

식(7)에서 θ1, stair는 각 윤곽선의 각도를 의미한다. 여기서 i = 1은 최하단, i = n은 최상단에 존재하는 윤곽선을 의미한다. α는 사용자가 설정하는 가중치를 의미하고, 0.5와 1사이의 값을 가지도록 설정한다. 이러한 과정을 통한 계단의 모서리 각도 추정 결과는 Fig. 12와 같다. Figs. 12(a), 12(b) 그리고 12(c)는 각각 로봇이 계단에 대해 우측으로 회전, 정면, 좌측으로 회전된 상태로 배치된 경우에 대한 결과를 나타낸다.

앞선 과정들을 통해 결합된 계단 각도 추정치를 사용하여 식(8)과 같이 오차 신호를 정의한다.

| (8) |

식(8)에서 θref_align는 계단에 정렬하기 위한 기준 신호를 의미하고, 계단을 정면으로 바라본 때 윤곽선의 각도인 0°를 사용한다. 위와 같이 생성되는 오차 신호를 기반으로 식(9)를 통해 조향 신호를 만들 수 있다.

| (9) |

식(9)에서 kP, kI, kD는 각각 비례, 적분, 미분 제어 이득을 의미한다. 해당 식을 통해 생성되는 조향 제어 입력을 식(2)과 식(3)에 대입하고, ωthrottle = 0으로 설정하여 순수 회전 동작을 구현할 수 있다.

본 절에서 제시한 전략을 통해 계단 앞에 존재하는 궤도형 로봇이 계단에 정렬하는 동작을 수행할 수 있다. 추가적으로 계단 정렬 과정을 종료 및 계단 극복 과정 실행을 위해 계단 모서리의 각도인 θstair를 사용한다. 즉, θstair 값이 사용자가 설정하는 임계값보다 작아지면 본 과정이 종료된다. Fig. 13은 제안하는 계단 정렬 전략이 수행되는 과정을 도식적으로 표현한다.

3.3 계단 극복 알고리즘

본 절에서는 (3) Stair Traversal 과정의 전략과 이를 구현함에 고려되는 사항들을 제시한다.

Fig. 14는 계단 극복 알고리즘을 도식적으로 표현한 그림이다. 해당 과정을 수행하며 요구사항 2)를 충족해야 하며, 이는 로봇이 직진 주행을 하며 방향각을 유지하기 위한 제어가 요구됨을 의미한다. 먼저, 방향각에 대한 제어 신호를 생성하기 위해 오차신호를 식(11)과 같이 정의한다.

| (11) |

식(11)에서 θref_traversal는 극복 과정에서 사용되는 기준 신호를 의미하며, 이는 앞선 정렬 과정이 종료된 시점에서의 로봇의 Yaw 각도를 사용한다. 또한, θcurrent는 현재 로봇의 Yaw 각도를 의미한다. 이처럼 정의되는 오차 신호를 기반으로 식(12)와 같이 제어 입력을 생성할 수 있다.

| (12) |

식(12)는 계단을 주행하며 로봇의 방향각을 제어하는 입력을 의미하며, 해당 입력을 통해 요구사항 2)을 충족할 수 있다. 그러나, Fig. 6(b)와 같이 짧은 시간에 방향각이 큰 폭으로 변화되는 것은 안정적인 주행에 문제가 될 수 있다. 이에 본 연구에서는 과도한 회전을 방지하기 위해 식(13)과 같이 동작하는 포화함수를 사용한다.

| (13) |

식(13)에서 upper input과 lower input는 각각 입력값을 포화시키는 상한값과 하한값을 의미한다.

추가적으로, 본 절에서 제시한 계단 극복 과정의 진행 상태를 판단하고, 전체적인 계단 자율 주행 시스템을 종료하기 위해 로봇의 Pitch 각도를 사용한다. 즉, 사용자가 사전에 설정하는 특정한 임계값보다 측정되는 로봇의 Pitch 각도가 작아지면 로봇이 계단을 벗어난 것으로 판단할 수 있다. 이러한 조간을 평가하여 계단 극복 과정을 종료한다. 또한, 계단 극복 과정은 본 연구에서 제안하는 계단 자율 주행 시스템의 마지막 단계로 전체적인 계단 주행 시스템을 종료한다. 또한, 제안하는 각 과정에 대한 전략들은 ROS (Robot Operating System)을 통해 구현된다[38].

4. 계단 자율 주행 시스템 검증 실험

본 장에서는 제안하는 시스템의 유효성을 검증하기 위한 실험을 진행한다. 먼저, 실험을 진행하기에 앞서 실험을 진행하는 환경과 조건에 대해 설명한다.

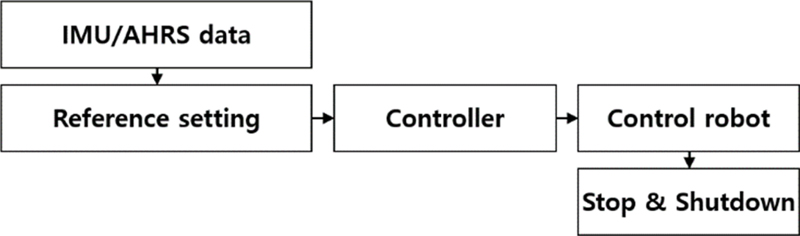

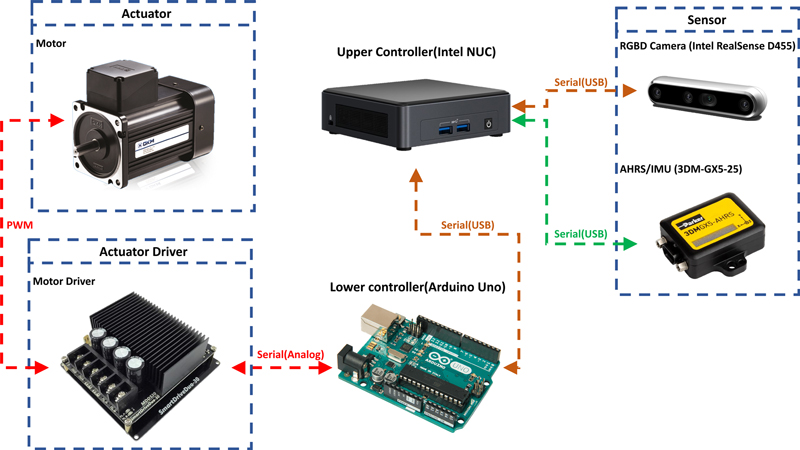

Fig. 15는 계단 자율 주행 시스템을 구현하기 위한 하드웨어적 구조를 나타내는 그림으로, 제안하는 시스템을 구현하기 위한 최소한의 장비로 구성된다. 다음으로, 실험에는 모형 계단을 사용하고, Fig. 3에서 표현되는 계단의 치수는 Table 4와 같다.

본 연구에서는 시스템의 유효성을 검증하기 위해 Table 4의 치수를 가지는 계단에 대한 실험을 진행한다. 해당 조건에서 앞서 제안한 각 과정의 세부 전략들에 대한 실험을 수행하여 제안하는 계단 자율 주행 시스템의 효용성을 입증한다.

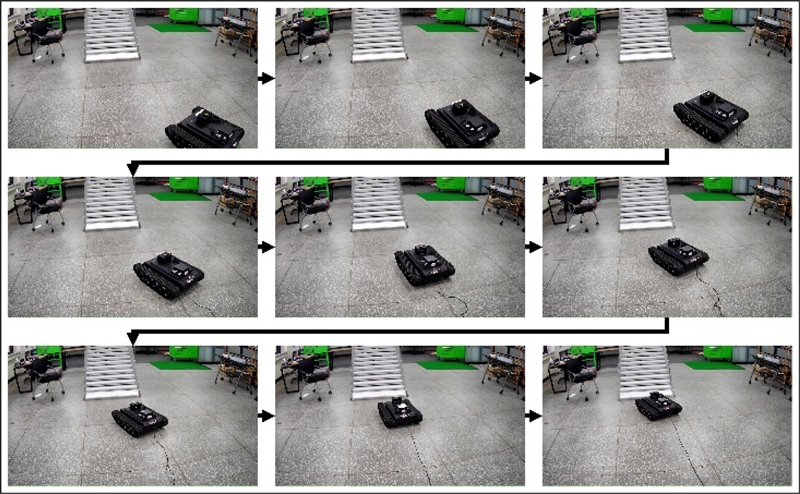

먼저, 제안하는 계단 접근 전략의 안정성 및 유효성을 검증하기 위한 실험을 진행한다. 실험은 모형 계단에 대해 궤도형 로봇을 임의의 위치에 배치하고, 계단 접근 알고리즘을 실행하여 진행한다. Fig. 16은 계단 접근 과정의 실험 결과를 나타낸다. 해당 그림과 같이 임의의 초기 조건으로 배치된 로봇이 계단에 대해 안정적으로 접근 동작을 수행할 수 있음을 보인다. 또한, 접근 과정에서 로봇이 계단의 중심선에 근접하게 이동함을 확인할 수 있고, 이는 후속되는 정렬 및 극복 과정을 수행함에 있어 기본적인 요건을 충족하는 것을 의미한다.

다음으로, 앞서 제시한 계단 정렬 전략을 검증하기 위한 실험을 진행한다. 해당 실험에서는 로봇을 계단의 정면에 임의의 자세로 배치하여 제안하는 계단 정렬 알고리즘을 실행한다. 이때, 정렬 과정의 정확성을 평가하기 위한 정량적인 지표를 설정할 수 없기에 알고리즘이 종료된 시점에서 로봇의 방향각의 수렴 정도를 평가한다.

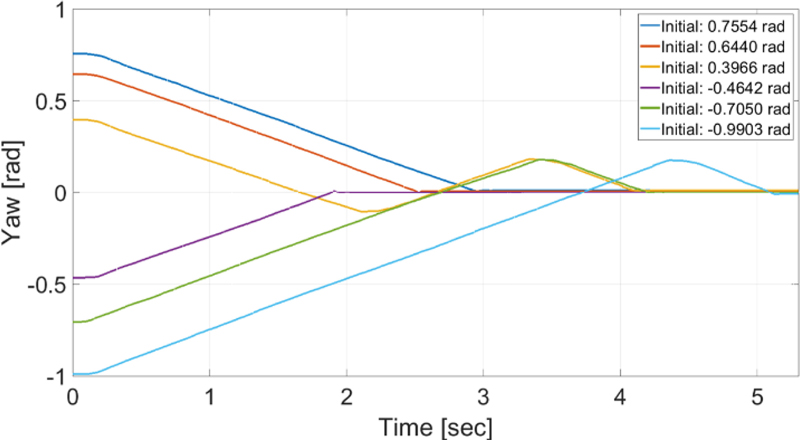

Fig. 17은 계단 정렬 동작을 수행하는 동안 측정되는 로봇의 Yaw 각도를 표현한다. 해당 그림은 로봇의 초기 자세에 무관하게 계단에 대한 정렬을 수행할 수 있음을 보인다. 해당 결과와 같이 정렬 과정이 수행된 후, 정상 상태에서 로봇의 Yaw 각도는 최대 0.018634 rad의 범위를 갖는다. 즉, 로봇의 정렬 과정을 수행하는 경우 1.07° 이내의 정밀도를 가짐을 의미한다. 이는 2장에서 제시한 시뮬레이션 결과에 기반하여 이어지는 극복 과정을 안정적으로 수행할 수 있음을 방증한다.

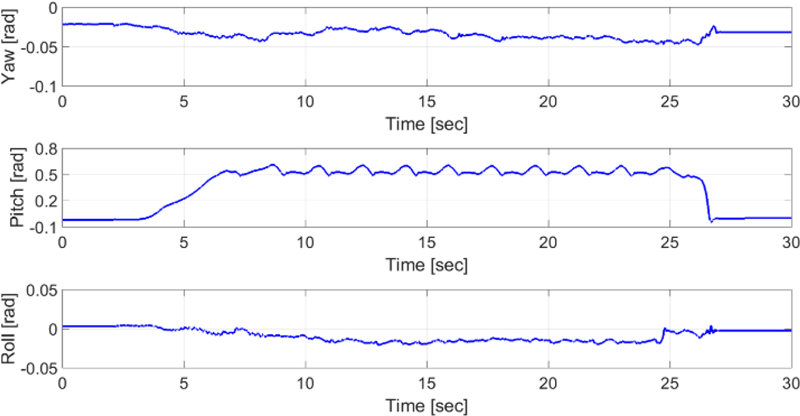

마지막으로, 실질적인 계단 주행을 위한 계단 극복 알고리즘의 검증을 위한 실험을 진행한다. 해당 실험은 앞선 계단 접근 및 정렬 과정을 통해 로봇이 계단의 정면에 도달하여 정렬이 완료된 상황을 가정하여 로봇을 계단의 정면에 배치한다. Fig. 18은 계단 극복 과정을 수행하는 중, 로봇의 3축에 대한 회전을 표현한다.

상기한 실험의 조건에 따라 시작 시점의 Yaw 각도는 정렬이 완료된 상태의 로봇의 Yaw 각도를 의미하고, 해당 값은 극복 과정의 기준 신호로 사용된다. 본 실험에서 사용된 기준 신호는 -0.02165 rad이며, 로봇이 계단을 극복하는 동안에 로봇의 Yaw 각도는 0.023679 rad의 범위 내에 존재함을 보인다. 즉, 해당 결과와 같이 궤도형 로봇이 안정적으로 계단을 주행함을 알 수 있음을 의미한다. 또한, 27초 부근에서 계단의 최상단에 도달하여 모든 시스템이 종료되어 정지함을 보인다.

앞서 제시한 각 과정의 실험 결과를 통해, 제안하는 전략들의 안정성 및 효용성을 검증하였다. 다시 말해, 해당 결과는 각 과정의 알고리즘을 통합하여 운용함으로 전체적인 계단 자율 주행이 안정적으로 수행될 수 있음을 의미한다. 따라서, 해당 실험 결과를 통해 본 연구에서 제안하는 계단 자율 주행 시스템을 통해 2장에서 도출한 요구사항을 모두 충족하며 계단을 주행할 수 있음을 입증하였다.

5. 결론

본 논문에서는 실내 재난 환경 탐색에 사용되는 궤도형 로봇의 안정적인 계단 주행을 위한 계단 자율 주행 시스템 제안한다.

시스템을 설계하기에 앞서, 계단 주행의 요구사항을 도출하기 위해 다양한 초기 조건에서 동역학 시뮬레이션을 수행한다. 상세한 시뮬레이션 결과 분석을 통해 명확한 계단 주행 요구사항을 도출하고, 도출된 요구사항을 기반으로 계단 접근 · 계단 정렬 · 계단 극복 단계로 구분되는 계단 자율 주행 시스템을 설계한다. 또한, 각 단계를 적절하게 수행하기 위한 전략을 제시한다. 먼저, 계단 접근 과정에서는 객체 인식 알고리즘을 사용한 계단 인식과 계단의 중심에 접근하기 위한 제어기를 설계한다. 다음으로, 계단 정렬 단계에서는 강인한 영상 처리 기법 및 계단 모서리 각도 추정을 통해 제어 신호를 생성하여 계단 정렬을 수행한다. 마지막으로, 계단 극복 과정에서는 실질적으로 계단을 주행하기 위한 기준 신호 설정 및 제어 방법을 제시한다. 추가적으로, 제안하는 각 전략이 순차적으로 수행될 수 있도록 하는 통합 시스템을 구축한다.

본 논문에서 제안하는 각 단계의 전략과 전체적인 계단 자율 주행 시스템의 유효성을 검증하기 위해 궤도형 로봇과 모형 계단을 이용하여 실험을 진행하였다. 계단 접근 실험에서 임의의 위치에 배치된 궤도형 로봇이 계단의 중심에 근접하게 접근하는 것을 확인할 수 있으며, 계단 접근 과정에서는 로봇의 Yaw 각도가 0.018634 rad 이내의 수렴 성능을 보였다. 계단 극복 실험에서는 초기 기준 신호 대비 최대 오차가 0.025806 rad, 최종 정상 상태 오차가 0.009886 rad으로 안정적인 주행이 가능함을 보였다.

즉, 본 논문에서 제안하는 계단 자율 주행 시스템이 유효하다는 것을 입증하였다. 향후에는 본 논문에서 고려되지 않는 최적 경로 생성에 관한 연구를 수행할 예정이다. 이와 함께 다양한 제어 기법을 적용하여 시스템의 성능을 더욱 향상시킬 계획이다.

Acknowledgments

본 연구는 산업통상자원부의 재난 및 위험작업 현장근로자의 사고방지를 위한 안전로봇 기술개발 사업(No. 20026194, 소방용 4족 보행 로봇 인명탐지·화재진압 솔루션 개발 및 소방 로봇·센서 실증)의 지원을 받았습니다.

References

- Shin, J., Pyo, J., Lee, M., Park, S., Park, S., Suh, J., Jin, M., (2022), Hazardous gas detecting and capturing robot, Journal of Drive and Control, 19(2), 27-35.

-

Kim, S.-J., Suh, J.-H., (2023), Adaptive robust RBF-NN nonsingular terminal sliding mode control scheme for application to snake robot’s head for image stabilization, Applied Sciences, 13(8), 4899.

[https://doi.org/10.3390/app13084899]

-

Kim, S. J., Suh, J. H., (2024), A study on I-PID-based 2-DOF snake robot head control scheme using RBF neural network and robust term, Journal of Korea Robotics Society, 19(2), 139-148.

[https://doi.org/10.7746/jkros.2024.19.2.139]

-

Sun, B., Jing, X., (2017), A tracked robot with novel bio-inspired passive “legs”, Robotics and biomimetics, 4(18), 1-14.

[https://doi.org/10.1186/s40638-017-0070-6]

-

Huang, H., Li, D., Xue, Z., Chen, X., Liu, S., Leng, J., Wei, Y., (2017), Design and performance analysis of a tracked wall-climbing robot for ship inspection in shipbuilding, Ocean Engineering, 131, 224-230.

[https://doi.org/10.1016/j.oceaneng.2017.01.003]

-

Bai, Y., Sun, L., Zhang, M., (2020), Terramechanics modeling and grouser optimization for multistage adaptive lateral deformation tracked robot, IEEE Access, 8, 171387-171396.

[https://doi.org/10.1109/ACCESS.2020.3024977]

-

Ugenti, A., Galati, R., Mantriota, G., Reina, G., (2023), Analysis of an all-terrain tracked robot with innovative suspension system, Mechanism and Machine Theory, 182, 105237.

[https://doi.org/10.1016/j.mechmachtheory.2023.105237]

-

Adiwahono, A. H., Saputra, B., Chang, T. W., Yong, Z. X., (2014), Autonomous stair identification, climbing, and descending for tracked robots, Proceedings of the 13th International Conference on Control Automation Robotics & Vision (ICARCV), 48-53.

[https://doi.org/10.1109/ICARCV.2014.7064278]

-

Ding, Z., Li, Y., Tang, Z., (2020), Theoretical model for prediction of turning resistance of tracked vehicle on soft terrain, Mathematical Problems in Engineering, 1, 4247904.

[https://doi.org/10.1155/2020/4247904]

-

Panchi, N., Agrawal, K., Patil, U., Gujarathi, A., Jain, A., Namdeo, H., Chiddarwar, S. S., (2019), Deep learning-based stair segmentation and behavioral cloning for autonomous stair climbing, International Journal of Semantic Computing, 13(04), 497-512.

[https://doi.org/10.1142/S1793351X1940021X]

-

Endo, D., Watanabe, A., Nagatani, K., (2017), Stair Climbing Control for 4?DOF Tracked Vehicle Based on Internal Sensors, Journal of Robotics, 1, 3624589.

[https://doi.org/10.1155/2017/3624589]

-

Zhang, Q., Ge, S. S., Tao, P. Y., (2011), Autonomous stair climbing for mobile tracked robot, IEEE International Symposium on Safety, Security, and Rescue Robotics, 92-98.

[https://doi.org/10.1109/SSRR.2011.6106757]

-

Mihankhah, E., Kalantari, A., Aboosaeedan, E., Taghirad, H. D., Ali, S., Moosavian, A., (2009), Autonomous staircase detection and stair climbing for a tracked mobile robot using fuzzy controller, IEEE International Conference on Robotics and Biomimetics, 1980-1985.

[https://doi.org/10.1109/ROBIO.2009.4913304]

- Fair, M., Miller, D. P., (2001), Automated staircase detection, alignment & traversal, Proceedings of International Conference on Robotics and Manufacturing, 218-222.

-

Cong, Y., Li, X., Liu, J., Tang, Y., (2008), A stairway detection algorithm based on vision for UGV stair climbing, IEEE International Conference on Networking, Sensing and Control, 1806-1811.

[https://doi.org/10.1109/ICNSC.2008.4525517]

-

Hesch, J. A., Mariottini, G. L., Roumeliotis, S. I., (2010), Descending-stair detection, approach, and traversal with an autonomous tracked vehicle, Proceedings of the IEEE/RSJ International Conference on Intelligent Robots and Systems, 5525-5531.

[https://doi.org/10.1109/IROS.2010.5649411]

-

Xiong, Y., Matthies, L., (2000), Vision-guided autonomous stair climbing, IEEE International Conference on Robotics and Automation, 2, 1842-1847.

[https://doi.org/10.1109/ROBOT.2000.844863]

-

Hsiao, C.-W., Chien, Y.-H., Wang, W.-Y., Li, I.-H., Chen, M.-C., Su, S.-F., (2015), Wall following and continuously stair climbing systems for a tracked robot, Proceedings of the IEEE 12th International Conference on Networking, Sensing and Control, 371-375

[https://doi.org/10.1109/ICNSC.2015.7116065]

-

Guo, J., Shi, J., Zhu, W., Wang, J., (2017), Approach to autonomous stair climbing for tracked robot, Proceedings of the IEEE International Conference on Unmanned Systems, 182-186.

[https://doi.org/10.1109/ICUS.2017.8278337]

-

Fourre, J., Vauchey, V., Dupuis, Y., Savatier, X., (2020), Autonomous RGBD-based industrial staircase localization from tracked robots, Proceedings of the IEEE/RSJ International Conference on Intelligent Robots and Systems, 10691-10696.

[https://doi.org/10.1109/IROS45743.2020.9340941]

-

Tseng, C.-K., Li, I.-H., Chien, Y.-H., Chen, M.-C., Wang, W.-Y., (2013), Autonomous stair detection and climbing systems for a tracked robot, Proceedings of the International Conference on System Science and Engineering, 201-204.

[https://doi.org/10.1109/ICSSE.2013.6614659]

-

Li, I.-H., Wang, W.-Y., Tseng, C.-K., (2014), A kinect-sensor-based tracked robot for exploring and climbing stairs, International Journal of Advanced Robotic Systems, 11(5), 80.

[https://doi.org/10.5772/58583]

-

Köppel, M., Ndjiki-Nya, P., Doshkov, D., Lakshman, H., Merkle, P., Müller, K., Wiegand, T., (2010), Temporally consistent handling of disocclusions with texture synthesis for depth-image-based rendering, Proceedings of the IEEE International Conference on Image Processing, 1809-1812.

[https://doi.org/10.1109/ICIP.2010.5652138]

-

Sun, J., Xie, Y., Chen, L., Zhou, X., Bao, H., (2021), Neuralrecon: Real-time coherent 3D reconstruction from monocular video, Proceedings of the IEEE/CVF conference on computer vision and pattern recognition (CVPR), 15598-15607.

[https://doi.org/10.1109/CVPR46437.2021.01534]

-

Lee, K., Ban, Y., Lee, S., (2017), Efficient depth enhancement using a combination of color and depth information, Sensors, 17(7), 1544.

[https://doi.org/10.3390/s17071544]

- Tukey, J. W., (1977), Exploratory data analysis, Addison-wesley.

-

Cao, N., Liu, Y., (2024), High-noise grayscale image denoising using an improved median filter for the adaptive selection of a threshold, Applied Sciences, 14(2), 635.

[https://doi.org/10.3390/app14020635]

-

Steplight, S., Egnal, G., Jung, S.-H., Walker, D. B., Taylor, C. J., Ostrowski, J. P., (2000), A mode-based sensor fusion approach to robotic stair-climbing, Proceedings of the IEEE/RSJ International Conference on Intelligent Robots and Systems, 2, 1113-1118.

[https://doi.org/10.1109/IROS.2000.893168]

-

Helmick, D. M., Roumeliotis, S. I., McHenry, M. C., Matthies, L., (2002), Multi-sensor, high speed autonomous stair climbing, IEEE/RSJ International Conference on Intelligent Robots and Systems, 1, 733-742.

[https://doi.org/10.1109/IRDS.2002.1041478]

-

Patil, U., Gujarathi, A., Kulkarni, A., Jain, A., Malke, L., Tekade, R., Paigwar, K., Chaturvedi, P., (2019), Deep learning based stair detection and statistical image filtering for autonomous stair climbing, IEEE International Conference on Robotic Computing, 159-166.

[https://doi.org/10.1109/IRC.2019.00031]

-

Zou, Z., Chen, K., Shi, Z., Guo, Y., Ye, J., (2023), Object detection in 20 years: A survey, Proceedings of the IEEE, 111(3), 257-276.

[https://doi.org/10.1109/JPROC.2023.3238524]

-

Redmon, J., Divvala, S., Girshick, R., Farhadi, A., (2016), You only look once: Unified, real-time object detection, Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 779-788.

[https://doi.org/10.1109/CVPR.2016.91]

-

Jin, G.-G., Son, Y.-D., (2019), Design of a nonlinear PID controller and tuning rules for first-order plus time delay models, Studies in Informatics and Control, 28(2), 157-166.

[https://doi.org/10.24846/v28i2y201904]

-

Huang, S- C., Cheng, F.-C., Chiu, Y.-S., (2012), Efficient contrast enhancement using adaptive gamma correction with weighting distribution, IEEE transactions on image processing, 22(3), 1032-1041.

[https://doi.org/10.1109/TIP.2012.2226047]

-

Canny, J., (1986), A computational approach to edge detection, IEEE Transactions on Pattern Analysis and Machine Intelligence, PAMI-8(6), 679-698.

[https://doi.org/10.1109/TPAMI.1986.4767851]

-

Duda, R. O., Hart, P. E., (1972), Use of the Hough transformation to detect lines and curves in pictures, Communications of the ACM, 15(1), 11-15.

[https://doi.org/10.1145/361237.361242]

-

Roberts, S. W., (2000), Control chart tests based on geometric moving averages, Technometrics, 42(1), 97-101.

[https://doi.org/10.1080/00401706.2000.10485986]

- Quigley, M., Conley, K., Gerkey, B., Faust, J., Foote, T., Leibs, J., Berger, E., Wheeler, R., Ng, A. Y., (2009), ROS: an open-source Robot Operating System, IEEE International Conference on Robotics and Automation Workshop on Open Source Software, 3(3.2), 5.

MS candidate in the Department of Intelligent Robot Engineering, Graduate School, Pukyong National University. His research interest is robot control, autonomous system, and mobile robot.

E-mail: speedydragon@naver.com

Postdoctoral researcher in the Major of Intelligent Robot Engineering. His research interest is robot control systems, control engineering, intelligent control, and robust control.

E-mail: bbman7020@gmail.com

Professor in the Major of Mechanical System Engineering, Division of Energy Transport Systems Engineering, College of Engineering, Pukyong National University. His research interest is disaster response robot, underwater robots, and system control & integration in field robotics.

E-mail: suhgang@pknu.ac.kr