자동차용 기계부품의 홀 가공 품질 검사를 위한 비전 시스템

Copyright © The Korean Society for Precision Engineering

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License (http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

Abstract

This paper presents a vision system for machined hole quality inspection of mechanical parts in an automobile. Automobile parts have various shapes and holes created by press punches. However, if the press punch pin is broken, a hole is not created on the mechanical parts. This problem causes serious part quality defects. To solve this problem, we proposed a vision system that could easily and cheaply inspect the quality of holes in automotive machining parts. A software development environment was created to build an economical vision inspection system. Images were gathered using the Near-real-time method to overcome the low frame-per-second of inexpensive Complementary Metal Oxide Semiconductor (CMOS) webcams. Status of the hole was determined using template matching and distance between holes as a feature. The hardware required for vision inspection was designed so that it could be directly applied to the automotive part manufacturing process. When the proposed vision inspection system was tested by installing it in an automobile parts factory for 3 months, the system showed an inspection accuracy of at least 97.9%. This demonstrates the effectiveness of the proposed method with accuracy and speed of hole defect inspection of machined parts.

Keywords:

Vision inspection, Image matching, Hole detection, Automobile part키워드:

비전 검사, 이미지 매칭, 홀 검출, 차량 부품1. 서론

산업현장에서 비전 검사 수요는 갈수록 증가하고 있고 이에 따른 기업의 요구사항은 다양해지고 있다. 자동차의 부품 수를 획기적으로 줄일 수 있는 전기차 시대가 도래해도 부품 수는 여전히 1만 개에 달한다[1]. 또한 자동차 제조업체의 모델 개발 주기에 따라 자동차 부품은 생산 수명을 가지게 된다.

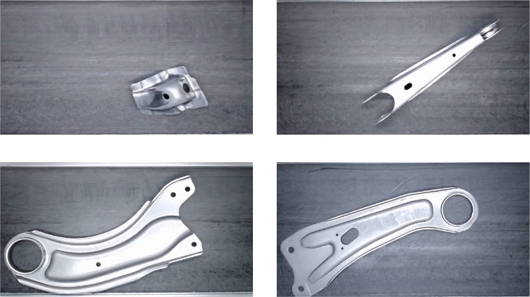

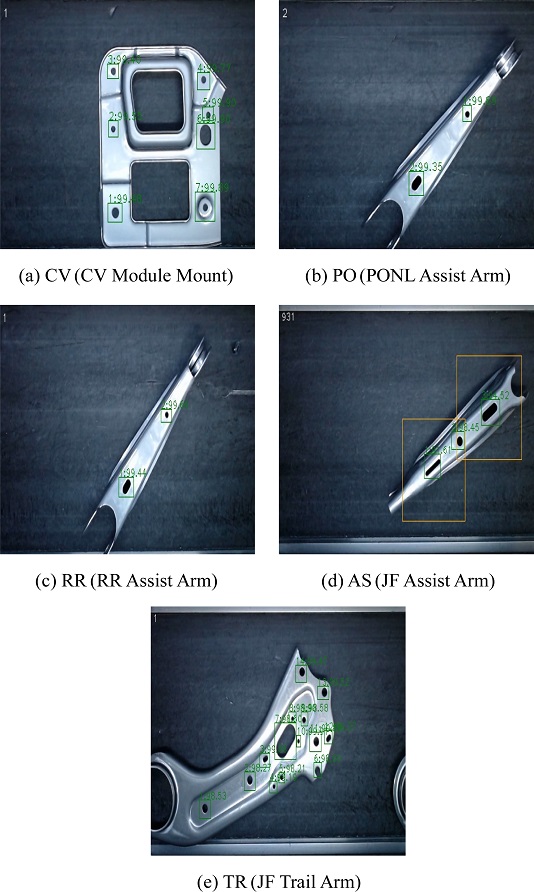

자동차 부품 기계가공 방법 중 하나인 프레스 펀치로 홀을 뚫는 공정에서, 펀치 핀이 금속 피로로 인해 부러졌을 경우 해당 부품에 생성되어야 하는 홀(Hole)이 생기지 않는 문제가 발생한다. 작업자가 육안으로 홀의 상태를 확인하는 작업이 있으나 불량품을 양품으로 오인하거나 검사 과정 자체를 누락할 수 있는 문제가 있다. 이 문제를 해결하기 위한 방법의 하나로 기업에서는 머신 비전 시스템을 도입하여 해결하고 있다. 그러나 머신비전 전문 업체에 의뢰할 경우 초기 제품 개발 비용뿐만 아니라 유지 관리 서비스 등 상당한 비용이 지속적으로 발생하며 이는 기업 입장에서는 운영자금 부담의 원인이 된다. 그리고 Fig. 1에 나타난 바와 같이 기계가공을 거쳐 만들어지는 자동차 부품은 굴곡진 부분, 꺾인 부분, 원형 홀, 강낭콩 모양 홀 등 매우 다양한 형태를 가지고 있다. 산업현장에서 머신비전을 이용하여 이와 같은 기계부품을 검사하기 위한 시스템은 충분하지 않은 상황이다.

비전 검사에 관한 연구는 다양한 산업에서 이루어지고 있다. 국내에는 머신 비전을 이용한 저널 베어링 표면검사[2], GKSVM (Gauss Kernel Support Vector Machine) 분류를 이용한 팔레트 홀 검출 연구가 있었고[3], 해외에는 비전 기반 홀 크랙 검출[4], 컴퓨터 비전을 이용한 기계 부품의 결함 검사[5], 테이프 및 릴 패키지 내의 소자 결함 검사를 위한 비전 시스템 개발[6], CFRP (Carbon Fiber Reinforced Polymer) 패널 내 드릴 홀 자동 검사를 위한 비전 프레임 워크 장치[7], 원 허프 변환을 이용한 비전 기반 볼트 홀 위치 추정[8], 저비용 비전 시스템을 이용한 입구측 구멍의 버(Burr) 검사 방법[9], 비전 기반의 영상 처리를 이용한 결함 검출 접근[10], 템플릿 매칭을 이용한 비전 검사 방법이 있었다[11].

그 중 자동차 부품의 비전 검사 관련 연구로는 자동차 부품 품질 검사를 위한 비전시스템 개발과 머신러닝 모델 비교 연구[12], 자동차 부품 카시트 프레임 검사를 위한 머신비전 개발[13], 레이저를 이용한 3D 계측 방법에 관한 연구[14], 사출성형 자동차부품의 외관 비전검사 방법[15], 컴퓨터 비젼기술을 활용한 자동차 부품 규격검사 시스템 구현[16], 영상처리를 이용한 쇽업서버 너클 브라켓 홀 검사 방법 등이 진행되었다[17]. 그러나 기존 연구들이 대량생산체제에 적합하지 않게 검사대상 부품을 정지된 상태에서 검사하거나, 검사 정확도를 높이기 위해 많은 데이터를 필요로 하거나, 검사 소요 시간이 오래 걸리는 등 실제 현장에서의 문제를 해결하기에 충분하지 않다.

본 논문에서는 이러한 문제를 해결하기 위해 자동차 기계가공 부품의 홀의 품질 상태를 저비용으로 간편하게 검사하는 비전 시스템을 제안한다. 저가의 CMOS (Complementary Metal Oxide Semiconductor) 웹캠 (Webcam)이 갖는 낮은 FPS (Frame Per Second)를 극복하기 위한 이미지 수집 방법으로 위성 데이터의 이미지 처리 등에 사용되는 근실시간(Near-real-time) 처리 방법을 적용하였다[18,19]. 또한, 다양한 형태의 홀 검사를 위해 홀의 형상 자체를 객체로 처리하여 원본과 비교하는 매칭 방법으로 템플릿 매칭을 사용했다. 대부분의 자동차 제조현장에서 산업용 로봇으로 기계 부품을 지정된 방향과 위치로 이송하기 때문에 부품의 이동 시 회전운동이 거의 발생하지 않아, 한 번의 원본 데이터 확보만으로 검사대상 부품에 모두 적용할 수 있으므로 딥러닝 방법보다 템플릿 매칭 방법을 적용하기가 용이하며, 이 방법은 원본 데이터 수집이 간단하며 연산량이 적어 저비용 비전 검사 시스템에 적합하다. 본 논문에서 제안한 비전 시스템의 유효성을 검증하기 위해 국내 자동차 부품 제조 업체인 D사의 생산 라인에 제안된 비전검사 시스템을 설치한 다음, 약 3개월 동안 실제 생산 제품 5개 모델에 적용하여 측정된 검사 시스템의 성능 실험 결과를 제시하였다.

2. 비전검사 알고리즘

2.1 소프트웨어 개발 환경

생산 제조현장에서 작업자가 사용하기 용이한 비전 시스템을 설계하기 위해 소프트웨어 개발 환경을 최우선으로 고려했다. 개발 환경은 Visual Studio 2022를 사용했고, 영상처리 라이브러리인 OpenCvSharp4를 활용하여 홀 가공 품질 검사에 필요한 비전 알고리즘을 개발했다. WPF (Windows Presentation Foundation)로 사용자 인터페이스와 자료화에 필요한 부가 기능들을 구현했다. 향후 작업자가 자동차 부품의 정보를 수정하거나 비전 검사에 필요한 파라미터를 직접 튜닝할 수 있도록 Fig. 2와 같이 통합 GUI (Integrated Graphical User Interface)를 설계하였다. GUI에는 자동차 부품의 리스트를 수정하거나 공통 설정에 필요한 어플리케이션 전체 설정(System)과 개별 자동차 부품의 관심 영역, 각종 임계치 등 비전 파라미터를 튜닝할 수 있는 비전 설정(Vision)으로 구성되어 있다.

2.2 이미지 수집

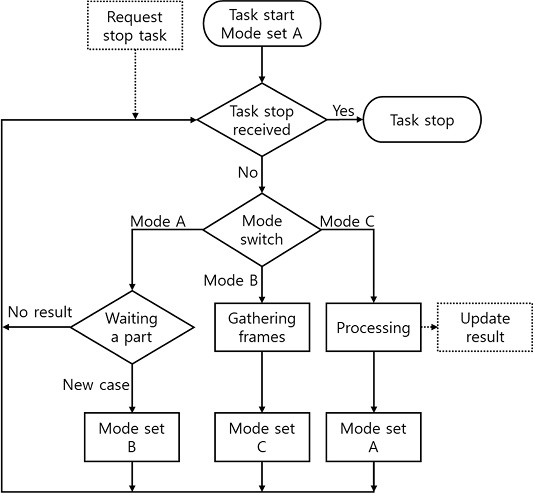

Fig. 3는 근실시간 처리 방법을 이용한 전체 비전검사 알고리즘을 나타낸 그림이다. 일반적으로 많이 적용되는 프레임단위 영상처리 기법인 준실시간(Pseudo-real-time)으로 이미지 매칭을 할 경우 측정 대상 수에 비례하여 처리 시간이 늘어나기 때문에 FPS가 크게 떨어지고, 부품마다 동일한 성능을 내기 어렵다. 따라서 자동차 부품이 비전 검사 영역에 들어왔을 때, 컴퓨터로부터 할당된 프로세스의 가용 리소스를 프레임 수집에 집중하여 단시간 내에 최대한 많은 양의 프레임을 확보해야 한다. 본 논문에서는 이벤트 발생과 데이터 처리 사이에 시간 지연을 도입하는 근실시간 처리방법을 적용했다.

전체 비전검사 알고리즘을 시작하면 먼저 A 모드가 되어(Task Start) 작업중지요청 수신확인(Task Stop Received)와 모드 스위치(Mode Switch)를 지나 자동차 부품 투입 대기(Waiting a Part) 상태가 된다. 새 부품이 투입되면 B 모드가 되어 프레임 수집 상태(Gathering Frames)로 이동한다. 이 상태에서는 매칭을 위한 이미지를 지정된 프레임 수만큼 수집하고, 수집을 마치는 즉시 C 모드가 되어 매칭 과정(Processing)으로 이동한다. 매칭 결과를 통합 GUI에 업데이트(Update Result) 하고, 다시 A 모드가 되어 자동차 부품 투입 대기 상태로 돌아온다.

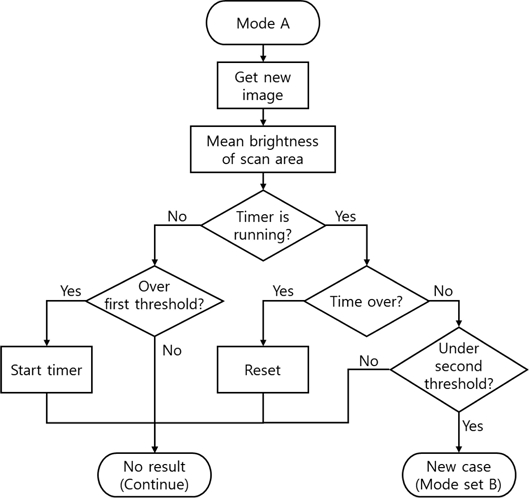

Figs. 4는 3의 자동차 부품 투입 대기(Waiting a Part)의 내부 알고리즘을 나타낸다. 어두운 색의 컨베이어 벨트보다 금속 재질의 부품이 가시광의 반사율이 높다는 특징을 이용하여, 자동차 부품이 일정 시간 이내로 지정된 영역을 지나가면 새 부품이 들어오는 것으로 판정한다. 카메라로 촬영한 이미지에서 사전에 설정한 스캔 영역의 평균 밝기 값을 측정한다(Mean Brightness of Scan Area). 이 값이 첫 번째 임계치 초과(Over First Threshold)하면 타이머를 가동한다. 일단 결과 없음(No Result)로 빠져나와 다시 A 모드로 진입하여 새 이미지를 가져온다. 타이머 이내(Time Over)에 스캔 영역의 평균 밝기 값이 두 번째 임계치 미만(Under Second Threshold)으로 떨어지면 새 부품이 들어온 것으로 판정한다(New Case). 만약 타이머를 초과하면 타이머와 임계치 조건을 초기화(Reset)함으로써, 새 부품이 아닌 것으로 판정되며 다음 부품 투입을 기다린다.

2.3 이미지 매칭

수집된 영상 프레임에 템플릿 매칭으로 홀 위치를 탐색했다. 원본 홀 템플릿들을 입력 영상에서 픽셀 단위로 이동하여 탐색하며 SSD (Sum of Squared Differences)를 정규화한 방법을 적용하여 식(1)의 결과 값을 출력 이미지에 저장한다[20-22]. 출력 이미지의 픽셀 값 중 가장 높은 매칭 결과 값의 위치를 가져온다. 식(1)에서 T(x΄,y΄)는 원본 이미지 T의 픽셀 좌표계에서 x΄,y΄위치에서의 픽셀 밝기 값, I(x+x΄,y+y΄)는 카메라로 수집한 입력 이미지 I의 픽셀 좌표계에서 x+x΄,y+y΄ 위치에서의 픽셀 밝기 값, R(x,y)은 매칭 결과 이미지 R의 픽셀 좌표계에서 x,y 위치에서의 결과 값을 나타낸다.

| (1) |

영상 내에서 원본 홀과 가장 일치율이 높지만 같은 형상의 홀과 중복이 발생할 수 있기 때문에 홀의 위치도 고려해야 한다. 이를 해결하기 위해 해당 홀과 다른 모든 홀 사이의 거리 값을 해당 홀의 고유 특징으로 활용했다.

| (2) |

| (3) |

식 (2)에서 D(J)는 j번째 원본 이미지의 홀의 부분 거리 A(j)와 수집된 이미지의 홀의 부분 거리B(j) 사이의 차이가 임계 거리 Td 이상 멀어지면 불량 신호가 발생함을 나타낸다. 그리고 식(3)에 따라 불량 신호 D(j)가 임계 회수 Tc를 초과하면 해당 홀의 상태 M(i)를 불량으로 판정한다. 이 방법으로 입력 이미지의 홀 거리와 원본 이미지의 홀 거리를 비교하여 중복된 위치의 홀을 배제했다.

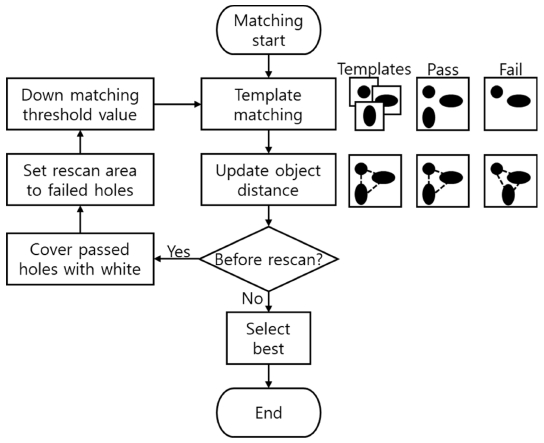

Figs. 5는 3의 매칭 과정(Processing)을 나타내며 순서도의 오른쪽에는 원본 템플릿, 성공 예시, 실패 예시를 표현했다. 만약 매칭 과정에서 배제된 홀이 있으면 다시 탐색해야 하기 때문에 재검색(Before Rescan) 분기점을 두었다. 다시 템플릿 매칭에 진입하기 전에, 정상으로 판정된 홀과 주변 영역을 흰색으로 표현하여 중복이 발생하지 않게 처리하였다. 불량으로 판정된 홀은 원본 템플릿을 활용하여 예상 홀 주변을 추가 탐색 영역으로 지정하고, 템플릿 매칭의 임계 값을 낮추었다. 두 번째 매칭을 마친 후, 최종 선택(Select Best) 처리 과정에서는 수집된 프레임들 중 정상으로 판정된 홀이 가장 많은 프레임을 선정하고, 그 중 R 값의 평균이 가장 높은 프레임으로 이미지 매칭 결과를 출력한다. 정상으로 판정된 홀이 템플릿의 홀 개수와 일치하면 정상, 불일치하면 불량으로 최종 처리된다.

3. 실험 및 고찰

3.1 하드웨어 시스템 구성

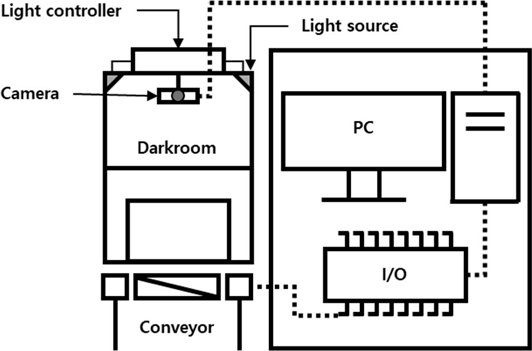

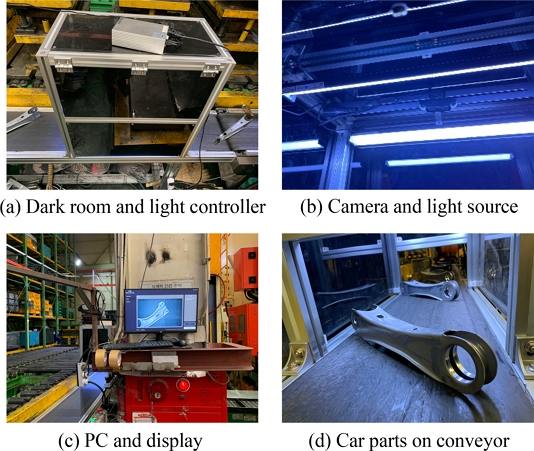

카메라는 비전 시스템의 비용 중 가장 큰 부분을 차지하기 때문에 비용 절감을 위해 시중에 판매되고 있는 CMOS 웹캠을 사용했다. 일반적인 산업용 머신 비전 카메라에 비해 저렴하고 USB PnP (Plug and Play) 방식이기 때문에 간단한 시스템 구성이 가능하였다. 외부 광원으로 인한 비전 검사 영향을 최소화하기 위해 암실 환경 내에 카메라 및 확산판이 장착된 LED 조명, 불량 누적으로 인한 컨베이어 정지 신호를 전달할 목적의 Arduino UNO, 그리고 Intel i5 급 PC 로 전체 비전시스템을 구성하였다. 자세한 비전검사 시스템 사양 및 구성도는 Table 1과 Fig. 6와 같다.

3.2 영상처리 알고리즘 성능 비교

하드웨어를 현장에 설치하기 전에, 2.2절에서 제시한 근실시간 처리방법과 각 이미지 수집마다 즉시 이미지 매칭하는 상황을 가정한 준실시간 처리방법의 이미지 수집속도 성능비교 실험을 진행하여 Table 2에 정리했다.

먼저 Fig. 7의 자동차 부품 샘플 A-E의 홀 개수(Holes), 목표 수집 프레임을 설정하였다. 그 다음 근실시간 처리방법으로 비전 검사 영역에 각 샘플을 5회씩 통과시키며 목표 프레임수를 수집하는 동안 걸린 이미지 수집 시간(Gathering time) 및 제안된 비전 알고리즘을 처리하는 동안 걸린 이미지 매칭 시간(Processing Time)을 기록했다. 근실시간 이미지 수집 속도인 Near-real-time FPS (NFPS)는 식(4)와 같이 계산하였다. Pseudo-real-time FPS (PFPS)는 근실시간 처리방법 계산에 사용된 이미지 수집 시간과 이미지 매칭 시간을 이용하여 준실시간 처리방법을 구현하기 위해 식(5)와 같이 계산하였다. Table 2의 Ratio of NFPS/PFPS는 근실시간 처리방법과 준실시간 처리방법 간의 처리속도 비율을 의미한다. 실험결과 일정한 이미지 수집 시간에 비해 검사대상 홀의 개수가 증가할수록 영상처리 시간이 늘어나므로 근실시간 처리방법이 준실시간 처리방법에 비해 상대적으로 처리속도가 2-3배 빠름을 알 수 있다.

| (4) |

| (5) |

3.3 실험 환경

본 논문에서 제안한 비전시스템의 유효성을 검증하기 위해 국내 자동차 부품 제조 업체인 D사의 생산 라인에 제안된 비전 검사 시스템을 설치하여 실험하였다. 해당 기업의 실제 생산 일정에 맞추어 자동차 부품마다 초기 설정을 진행했다. 초기 설정에는 프레스 공정이 완료된 템플릿 이미지, 템플릿 이미지 내 가공된 홀의 픽셀 좌표 및 크기, 템플릿 매칭에 필요한 임계치 등, 통합 GUI에 표시된 비전 파라미터로 구성되어 있다. 자동차 기계 부품을 성형하기 위해 프레스로 펀칭 후, 산업용 로봇이 성형된 부품을 컨베이어벨트로 이송하고, 컨베이어 벨트를 따라 암실로 부품이 들어오면 홀 검사를 실시한다. 이때, 탬플릿 매칭 방법을 이용하여 대상 제품의 홀 가공 상태에 대한 양불을 판정한다. 판정 검사 결과에 따라 작업자는 양품과 불량품을 분리한다. 프레스 펀치 파손이 항상 일어나는 현상은 아니므로 일부 모델에서 불량 테스트를 위해 프레스 펀치 핀을 부러뜨리는 대신 정상으로 가공된 홀을 임의로 가려서 정상 제품 중간에 투입하는 방식으로 진행했다. 실험 도중에 생산 모델이 변경되면 그에 따라 설정 데이터를 변경하는 방식으로 대응했다. Fig. 8은 국내 자동차 부품 제조 업체인 D사의 생산 라인에 본 논문에서 개발한 머신비전 시스템을 설치한 모습이다.

3.4 실험 결과 및 고찰

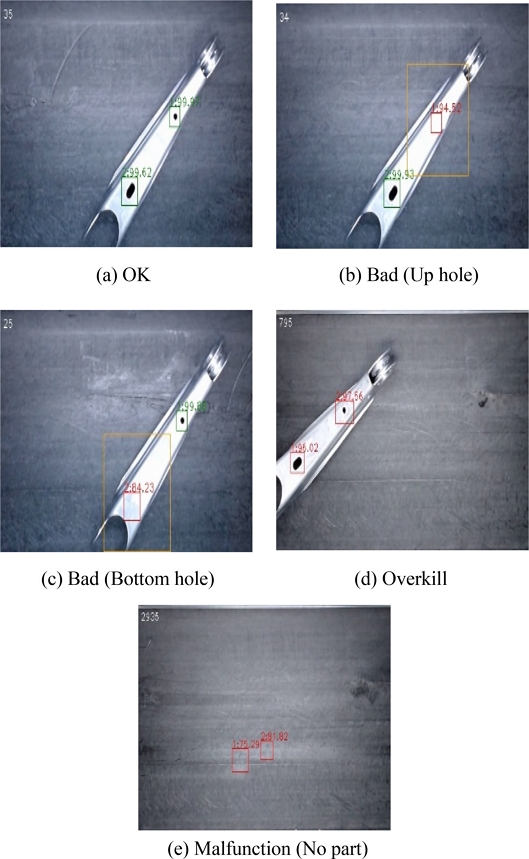

3.3절에서 기술한 바와 같이 국내 자동차부품 제조업체 D사의 생산라인에 설치된 비전시스템에서 약 3개월간 측정한 부품 5개 모델에 대한 검사결과를 Fig. 9와 Table 3에 나타냈다. Figs. 9(a)부터 9(d)까지의 모델은 차량 하부의 구동부에 연결되는 부품이며, (e)는 차체와 결합하는 부품이다. Table 3의 홀 개수(Holes)는 단위 자동차 부품별 측정 대상 홀 개수, 검사 부품 수(Count)는 자동차 부품별 전체 측정 개수, 정상(OK)은 양품으로 판단한 경우의 개수, 불량(Bad)은 프레스 공정에서 홀의 생성이 누락된 것으로 판단한 경우의 개수, 불량 유출(Missing)은 불량품을 양품으로 오인한 경우의 개수, 과검출(Overkill)은 양품을 불량품으로 오인한 경우, 오작동(Malfunction)은 외부 개입에 의해 검사대상 부품이 아닌 잘못된 대상이 검출된 경우의 개수이다. 정확도(Accuracy)는 정상적으로 양불 판정된 정상과 불량을 더하여 오작동을 제외한 검사 부품 수로 나눈 값이며, 식(6)과 같이 계산하였다.

| (6) |

Table 3에서 보는 바와 같이 검사대상 부품 5개 모델에 대한 실험결과 최소 97.9% 이상의 비전 검사 정확도를 보였다. 그러나 1개 모델에서 다소 많은 과검출이 발생하였는데, 이는 영상처리 문제보다는 컨베이어의 동작 불량 및 이물질 발생 등 외부 요인으로 인해 발생하였다. 오작동은 주로 측정 실험 도중 본 검사시스템과 관련이 없는 작업자의 외부 개입으로 인하여 발생하였고, 실험과 무관하므로 각 모델의 정확도 계산에 영향을 끼치지 않도록 식(6)에 제외(Exclusions) 값으로 추가하였다. Fig. 10은 Table 3의 각각의 범례의 예시를 RR 모델을 대상으로 나타냈다. 초록색 사각형은 정상 홀, 빨간색 사각형은 불량 홀, 노란색 사각형은 추가 탐색 영역(Rescan Area)을 표시했다. Figs. 10(b)와 10(c)의 각각 위와 아래의 가려진 홀 부분이 빨간색 사각형으로 표시되며 불량 홀로 인식되었음을 확인할 수 있다. Fig. 10(e)는 외부 개입에 의해 대상 부품이 갑자기 컨베이어 상에서 사라진 경우이다.

4. 결론

본 논문에서는 다양한 자동차 부품의 홀 검사를 생산제조현장에 적합하도록 저가이면서도 효율적으로 성능을 발휘할 수 있는 새로운 비전 검사 시스템을 개발하였다. 개발된 비전검사 시스템의 효과를 측정하기 위해 D사의 자동차 기계부품 양산라인에 제안된 검사 시스템을 적용하고, 5개의 자동차 부품 모델에 대해 약 3개월 동안 진행한 실험 결과, 최소 97.9% 이상의 검사정확도를 나타내었다. 이는 본 논문에서 제안된 비전 시스템이 고가의 산업용 카메라를 사용하는 기존 머신 비전 시스템보다 비교적 저가이면서 간단한 알고리즘을 적용함에도 충분한 검출 성능을 내고 있음을 알 수 있었다.

원본 이미지와 비교하는 템플릿 매칭 방법의 특성상, 제안된 비전 시스템은 자동차 부품의 홀 뿐만 아니라 마커와 같이 뚜렷한 특징을 검사할 경우에도 유용하게 활용할 수 있다. 이는 식품 제조 및 의약 제조 등 다양한 산업에도 고려할 수 있으며, 대량의 결과 이미지 데이터를 데이터 마이닝(Data Mining)에 활용하여 생산물의 품질 향상에 기여할 수 있을 것으로 보인다. 향후 외부 환경의 변화에도 강인한 시스템을 개발하여 오작동이 발생하는 구조적인 문제를 해결할 필요가 있다. 또한 템플릿 매칭의 정확성을 보다 높이기 위한 검사 알고리즘에 대한 연구와, 현재 비전검사를 위한 파라미터 튜닝 수가 많기 때문에 사용자 편의성을 향상시키는 오토 튜닝 기능을 개발하고자 한다.

Acknowledgments

본 연구는 경기도의 지역협력연구센터(GRRC) 사업의 일환으로 수행하였음[(GRRC한국공대2022-B02), 다중소재 가공기술 혁신연구센터].

REFERENCES

- Yim, D. B., Chan, J. Y., Eom., Y. E., (2018), Next automotive revolution, Samjong INSIGHT, 56. https://assets.kpmg.com/content/dam/kpmg/kr/pdf/2018/kr-insight56-next-automotive-revolution.pdf

-

Ko, J. S., Rheem, J. Y., (2017), Surface inspection of a journal bearing using machine vision, Journal of the Korean Society for Precision Engineering, 34(8), 557-561.

[https://doi.org/10.7736/KSPE.2017.34.8.557]

- Choi, K. H., Kim, K. S., Jeon, W. I., Cho, B. H., Woo, S. H., Lee, D. Y., (2021), A study of pallet hole detection using GKSVM classification, Proceedings of the Korean Society for Fluid Power & Construction Equipment Conference, 97-100.

-

Wang, Y., Xiong, W., Cheng, J., Chia, S. C., Chen, W., Huang, W., Zhou, J., (2015), Vision based hole crack detection, Proceedings of the 2015 IEEE 10th Conference on Industrial Electronics and Applications (ICIEA), 1932-1936.

[https://doi.org/10.1109/ICIEA.2015.7334428]

- Hicham, A. E. A., El Houssine, E.-C. M., Hassan, S., Abderrahim, B., (2022), Inspection of machining defects on mechanical parts using a computer vision system, Proceedings of the 2022 2nd International Conference on Innovative Research in Applied Science, Engineering and Technology (IRASET), 1-5.

-

Lee, J. Y., Han, C. H., Ko, K. W., Lee, S., (2016), Development of vision system for defect inspection of electric parts in the tape and reel package, Proceedings of the 2016 16th International Conference on Control, Automation and Systems (ICCAS), 437-439.

[https://doi.org/10.1109/ICCAS.2016.7832357]

-

Hernandez, A., Maghami, A., Khoshdarregi, M., (2020), A machine vision framework for autonomous inspection of drilled holes in CFRP panels, Proceedings of the 2020 6th International Conference on Control, Automation and Robotics (ICCAR), 669-675.

[https://doi.org/10.1109/ICCAR49639.2020.9108000]

- Choe, Y., Lee, H.-C., Kim, Y.-J., Hong, D.-H., Park, S.-S., Lim, M.-T., (2009), Vision-based estimation of bolt-hole location using circular hough transform, Proceedings of the ICROS-SICE International Joint Conference, 4821-4826.

-

Cho, H. S., Chi, S.-Y., (2015), An inspection method for burrs in an inlet side hole using a low cost vision system, Proceedings of the 2015 International Conference on Information and Communication Technology Convergence (ICTC), 783-786.

[https://doi.org/10.1109/ICTC.2015.7354664]

-

Baygin, M., Karakose, M., Sarimaden, A., Erhan, A., (2017), Machine vision based defect detection approach using image processing, Proceedings of the 2017 International Artificial Intelligence and Data Processing Symposium (IDAP), 1-5.

[https://doi.org/10.1109/IDAP.2017.8090292]

-

Bahaghighat, M., Mirfattahi, M., Akbari, L., Babaie, M., (2018), Designing quality control system based on vision inspection in pharmaceutical product lines, Proceedings of the 2018 International Conference on Computing, Mathematics and Engineering Technologies (iCoMET), 1-4.

[https://doi.org/10.1109/ICOMET.2018.8346360]

- Park, Y., Jung, D.-I., (2022), Development of vision system for quality inspection of automotive parts and comparison of machine learning models, The Journal of the Convergence on Culture Technology, 8(1), 409-415.

-

Andres, N. S., Jang, B.-C., (2011), Development of a machine vision system for automotive part car seat frame inspection, Journal of the Korea Academia-Industrial Cooperation Society, 12(4), 1559-1564.

[https://doi.org/10.5762/KAIS.2011.12.4.1559]

-

Sato, R., Kato, K., Harada, K., (2013), Development of the hole position inspection system of pressed car parts by using laser 3-d measurement, The 19th Korea-Japan Joint Workshop on Frontiers of Computer Vision, 317-322.

[https://doi.org/10.1109/FCV.2013.6485513]

- Kim, H., Cho, J.-S., (2019), Exterior vision inspection method of injection molding automotive parts, Journal of the Korea Institute of Information and Communication Engineering, 23(2), 127-132.

- Kim, Y. J., Lee, S., Kim, T. W., Kim, S. J., Cho, J. S., (2011), Implementation of vision-based inspection system for auto parts, Proceedings of the IEEK Fall Conference, 634-637.

- Jeong, K.-W., Ahn, K.-U., (2010), Inspection of the knuckle bracket holes of a shock-absorber using image processing method, Journal of the Korean Society of Manufacturing Technology Engineers, 19(6), 768-775.

- Wikipedia, Real-time computing. https://en.wikipedia.org/wiki/Real-time_computing

-

Oštir, K., Čotar, K., Marsetič, A., Pehani, P., Perše, M., Zakšek, K., Zaletelj, J., Rodič, T., (2015), Automatic near-real-time image processing chain for very high resolution optical satellite data, Proceedings of the 36th International Symposium on Remote Sensing of Environment, 669-676.

[https://doi.org/10.5194/isprsarchives-XL-7-W3-669-2015]

- OpenCV, Template matching. https://docs.opencv.org/

-

Hisham, M., Yaakob, S. N., Raof, R., Nazren, A. A., Wafi, N., (2015), Template matching using sum of squared difference and normalized cross correlation, Proceedings of the 2015 IEEE Student Conference on Research and Development (SCOReD), 100-104.

[https://doi.org/10.1109/SCORED.2015.7449303]

-

Sarvaiya, J. N., Patnaik, S., Bombaywala, S., (2009), Image registration by template matching using normalized cross-correlation, Proceedings of the 2009 International Conference on Advances in Computing, Control, and Telecommunication Technologies, 819-822.

[https://doi.org/10.1109/ACT.2009.207]

M.S. candidate in the Department of Mechatronics Engineering, Tech University of Korea. His research interest is 3D vision on manipulator.

E-mail: gksalsdyd123@tukorea.ac.kr

Professor in the Department of Mechatronics Engineering, Tech University of Korea. His research interests are design and control for high performance mechatronics and new pattering process and systems.

E-mail: khkim12@tukorea.ac.kr

Professor in the Department of Mechatronics Engineering, Tech University of Korea. His research interests are robotic manufacturing system with AI technology and precision control system.

E-mail: kimkh@tukorea.ac.kr

Researcher in the Safety Inspection for Infrastructure Laboratory, Advanced Institute of Convergence Technology. His research interests are robot, AI and metaverse.

E-mail: kwang4372@snu.ac.kr

M.S. candidate in the Department of Mechatronics Engineering, Tech University of Korea. His research interest is 3D vision on bin-picking and semiconductor automation.

E-mail: kkm4368@tukorea.ac.kr

B.Sc. candidate in the Department of Mechatronics Engineering, Tech University of Korea. His research interest is mechatronics.

E-mail: eastpillar0930@tukorea.ac.kr

Professor in the Department of Mechatronics Engineering, Tech University of Korea. His research interests are autonomous mobile robot navigation with visual SLAM and image processing system like as robot hand-eye.

E-mail: jhshim@tukorea.ac.kr